论文题目(Title):Face-Sensitive Image-to-Emotional-Text Cross-modal Translation for Multimodal Aspect-based Sentiment Analysis

研究问题(Question):面向面部敏感的图像-情感-文本翻译的跨模态的多模态情感分析

研究动机(Motivation):现有的模型主要侧重于利用图像中的对象级语义信息,而忽略了明确使用视觉情感线索,特别是面部情感。

主要贡献(Contribution):本文提出了一种人脸敏感图像到情感文本翻译(FITE)方法,该方法侧重于通过面部表情捕捉视觉情感线索,并在文本情态中选择性地与目标方面进行匹配和融合。

研究思路(Idea):主要分为三部分:

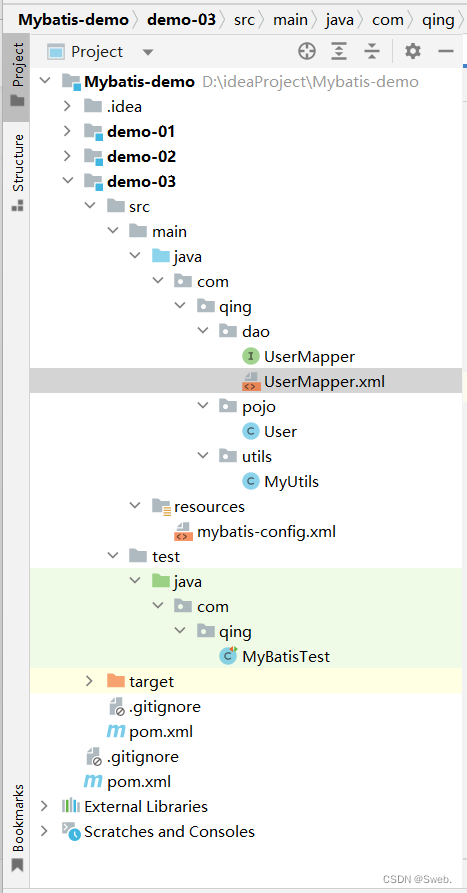

1. 面部敏感图像转换成情感文本:利用现成的面部识别工具(Serengil and Ozpinar, 2020)识别面部,利用四个分类器进行分类,得到面部属性。为了生成流畅的自然语言情感人脸描述,我们手工设计了一个由人脸属性组成的人脸描述生成模式,根据模版生成文本描述。

2. 对敏感方面词的对齐和修改:应用CLIP模型分别对与方面A相连的人脸描述D和与方面V相连的图像进行编码。将输出的特征嵌入投影到相同的特征空间。通过L2归一化,计算这些特征嵌入的余弦相似度L。遵循CapBERT选择并重写与当前图像相似度最高的人脸描述作为当前方面的文本化视觉情感线索。改写后的人脸描述只保留目标方面和预测面部特征的表情。

3. 基于门的多模态融合模块:将感知的人脸描述和图像标题与文本T和目标方面A连接起来,分别组成两个新句子,然后我们把新句子输入两个预训练语言模型并微调语言模型,直流融合的特征表示通过线性分类层得到情感预测结果。

研究方法(Method):

研究过程(Process):

1.数据集(Dataset)

2.评估指标(Evaluation)Acc,Macro-F1

3.实验结果(Result)

总结(Conclusion):结果表明,我们的方法优于一系列基准模型,并证明了我们的方法在捕获视觉情感线索和多模态情感数据的跨模态对齐方面的优势。

总结(Conclusion):结果表明,我们的方法优于一系列基准模型,并证明了我们的方法在捕获视觉情感线索和多模态情感数据的跨模态对齐方面的优势。

![[GYCTF2020]EasyThinking](https://img-blog.csdnimg.cn/19da4de9723c42cf991bd97cad52e353.png)

![[golang gin框架] 33.Gin 商城项目- 集成支付宝微信支付、生成支付二维码、监听处理异步通知跳转到订单页面](https://img-blog.csdnimg.cn/img_convert/a096f06a112c19ae4ae3fbc0eb11ccdf.png)