最初的一个想法,是针对当前的网络电视去的,很多网络电视买回家,还要充很多会员,甚至跌入连环坑。我想给妈妈买一台电视,想把我自己收集的电影电视剧做成一个影视库,通过搭建家庭影院服务器,然后在安卓终端上面点播。最初想得很简单,就是做一个文件服务器就可以了,但是安卓支持的解码器有限,就想着在服务器把各种格式的电影转换成流媒体,推向流媒体服务器。安卓软件直接从流媒体服务器拉流播放就可以了,不考虑解码的问题。

之前写过一个手机直播的模型,使用的rtmp服务器是nginx,这次我使用的是用Docker搭建的SRS服务器。

关于使用Docker搭建SRS服务器可以参照官网的文章:

http://ossrs.net/lts/zh-cn/docs/v4/doc/getting-started

首先我在一个虚拟机上面拉取镜像

docker pull registry.cn-hangzhou.aliyuncs.com/ossrs/srs:4然后运行一个容器

docker run --rm -it -p 1935:1935 -p 1985:1985 -p 8080:8080 \

registry.cn-hangzhou.aliyuncs.com/ossrs/srs:4 ./objs/srs -c conf/docker.conf这是官网的指令,我一个字没改过。

就这样,一个SRS服务器就建好了。我的服务器host映射为srs.chris.com。下来就是推流了。

推流之前,要准备好一两段视频。还要在本地安装ffmpeg。安装方法参照:

https://blog.csdn.net/weixin_45947430/article/details/122509083

我是用的windows11-21h2,安装过后始终是找不到命令,反复确认了多次,也不知道是啥问题。没办法,只好使用绝对路径。

第一种推流,用命令行:

ffmpeg -re -stream_loop -1 -i ./v2.mp4 -c copy -f flv rtmp://srs.chris.com/live/livestream因为视频比较短,所以添加了-stream -1进行循环推流。

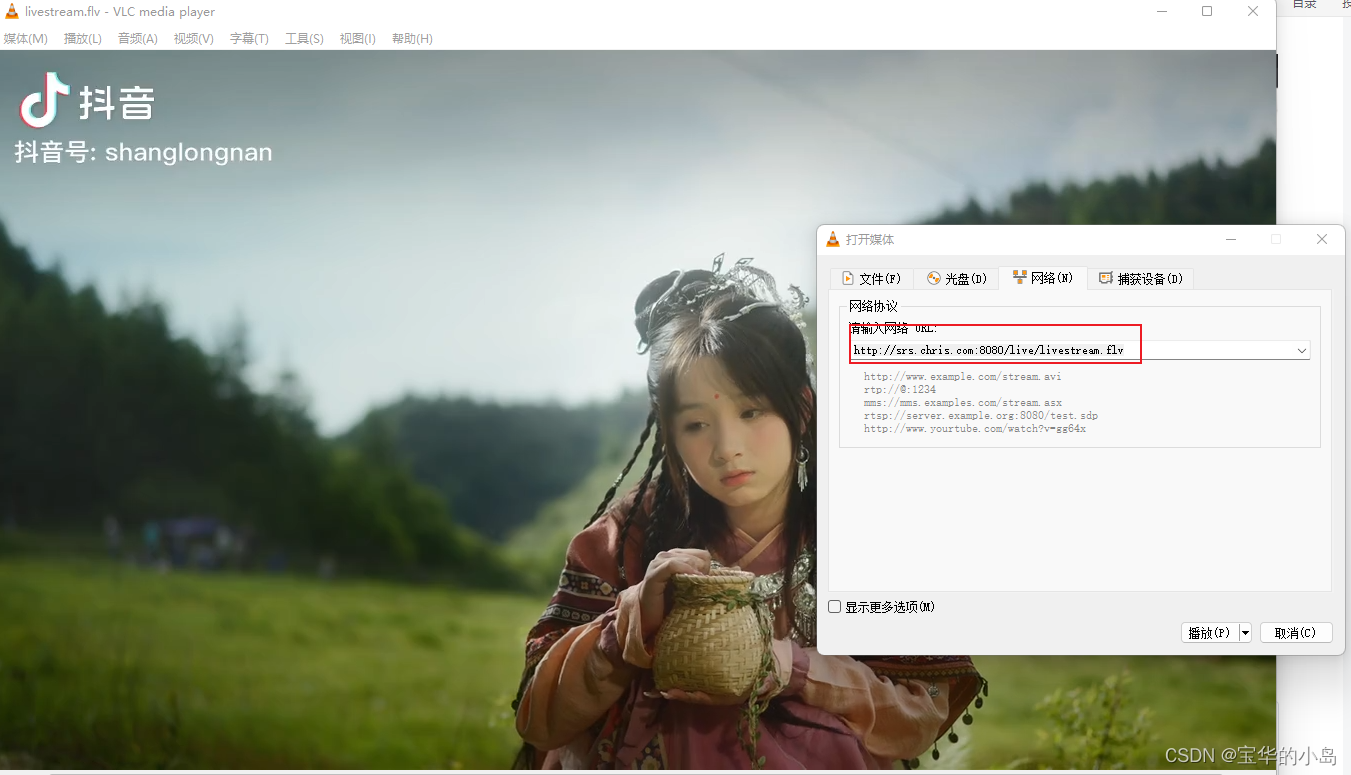

srs提供了一个播放终端,在浏览器打开http://srs.chris.con:8080就可以打开页面,找到srs播放器,就能直接播放了。

不过也可以下载一个vlc播放器,来打开一个串行流。

这样基本推拉流都可以实现了。

我的最终目标是用Java写一个服务,所以最终需要使用Java代码来推流。

Java代码推流有两种方式。

第一种,在在Java代码中执行ffmpeg命令。

@SneakyThrows

public static void srsFile(String streamName,String filePath) {

String command = "G:\\downs\\ffmpeg\\bin\\ffmpeg -re -stream_loop -1 " +

"-i " +

filePath +

" -c copy " +

"-f flv rtmp://srs.chris.com/live/" + streamName;

System.out.println(command);

Process process = Runtime.getRuntime().exec(command);

BufferedReader br = new BufferedReader(new InputStreamReader(process.getErrorStream()));

String line = null;

while ((line = br.readLine()) != null) {

System.out.println("视频推流信息[" + line + "]");

}

}第二种,是使用javacv库,通过抓取视频文件的帧,逐帧推送。

package com.chris.demo;

import lombok.extern.slf4j.Slf4j;

import org.bytedeco.ffmpeg.avcodec.AVCodecParameters;

import org.bytedeco.ffmpeg.avformat.AVFormatContext;

import org.bytedeco.ffmpeg.avformat.AVStream;

import org.bytedeco.ffmpeg.global.avcodec;

import org.bytedeco.ffmpeg.global.avutil;

import org.bytedeco.javacv.FFmpegFrameGrabber;

import org.bytedeco.javacv.FFmpegFrameRecorder;

import org.bytedeco.javacv.FFmpegLogCallback;

import org.bytedeco.javacv.Frame;

/**

* @author willzhao

* @version 1.0

* @description 读取指定的mp4文件,推送到SRS服务器

* @date 2021/11/19 8:49

*/

@Slf4j

public class PushMp4 {

/**

* 本地MP4文件的完整路径(两分零五秒的视频)

*/

private static final String MP4_FILE_PATH = "G:\\downs\\video\\v2.mp4";

/**

* SRS的推流地址

*/

private static final String SRS_PUSH_ADDRESS = "rtmp://192.168.2.61/live/livestream";

/**

* 读取指定的mp4文件,推送到SRS服务器

*

* @param sourceFilePath 视频文件的绝对路径

* @param PUSH_ADDRESS 推流地址

* @throws Exception

*/

public static void grabAndPush(String sourceFilePath, String PUSH_ADDRESS) throws Exception {

// ffmepg日志级别

avutil.av_log_set_level(avutil.AV_LOG_ERROR);

FFmpegLogCallback.set();

// 实例化帧抓取器对象,将文件路径传入

FFmpegFrameGrabber grabber = new FFmpegFrameGrabber(MP4_FILE_PATH);

long startTime = System.currentTimeMillis();

log.info("开始初始化帧抓取器");

// 初始化帧抓取器,例如数据结构(时间戳、编码器上下文、帧对象等),

// 如果入参等于true,还会调用avformat_find_stream_info方法获取流的信息,放入AVFormatContext类型的成员变量oc中

grabber.start(true);

log.info("帧抓取器初始化完成,耗时[{}]毫秒", System.currentTimeMillis() - startTime);

// grabber.start方法中,初始化的解码器信息存在放在grabber的成员变量oc中

AVFormatContext avFormatContext = grabber.getFormatContext();

// 文件内有几个媒体流(一般是视频流+音频流)

int streamNum = avFormatContext.nb_streams();

// 没有媒体流就不用继续了

if (streamNum < 1) {

log.error("文件内不存在媒体流");

return;

}

// 取得视频的帧率

int frameRate = (int) grabber.getVideoFrameRate();

log.info("视频帧率[{}],视频时长[{}]秒,媒体流数量[{}]",

frameRate,

avFormatContext.duration() / 1000000,

avFormatContext.nb_streams());

// 遍历每一个流,检查其类型

for (int i = 0; i < streamNum; i++) {

AVStream avStream = avFormatContext.streams(i);

AVCodecParameters avCodecParameters = avStream.codecpar();

log.info("流的索引[{}],编码器类型[{}],编码器ID[{}]", i, avCodecParameters.codec_type(), avCodecParameters.codec_id());

}

// 视频宽度

int frameWidth = grabber.getImageWidth();

// 视频高度

int frameHeight = grabber.getImageHeight();

// 音频通道数量

int audioChannels = grabber.getAudioChannels();

log.info("视频宽度[{}],视频高度[{}],音频通道数[{}]",

frameWidth,

frameHeight,

audioChannels);

// 实例化FFmpegFrameRecorder,将SRS的推送地址传入

FFmpegFrameRecorder recorder = new FFmpegFrameRecorder(SRS_PUSH_ADDRESS,

320,

(int) (frameHeight / (frameWidth * 1.0) * 320),

audioChannels);

// 设置编码格式

recorder.setVideoCodec(avcodec.AV_CODEC_ID_H264);

// 设置封装格式

recorder.setFormat("flv");

// 一秒内的帧数

recorder.setFrameRate(frameRate);

// 两个关键帧之间的帧数

recorder.setGopSize(frameRate);

// 设置音频通道数,与视频源的通道数相等

recorder.setAudioChannels(grabber.getAudioChannels());

startTime = System.currentTimeMillis();

log.info("开始初始化帧抓取器");

// 初始化帧录制器,例如数据结构(音频流、视频流指针,编码器),

// 调用av_guess_format方法,确定视频输出时的封装方式,

// 媒体上下文对象的内存分配,

// 编码器的各项参数设置

recorder.start();

log.info("帧录制初始化完成,耗时[{}]毫秒", System.currentTimeMillis() - startTime);

Frame frame;

startTime = System.currentTimeMillis();

log.info("开始推流");

long videoTS = 0;

int videoFrameNum = 0;

int audioFrameNum = 0;

int dataFrameNum = 0;

// 假设一秒钟15帧,那么两帧间隔就是(1000/15)毫秒

int interVal = 1000 / frameRate;

// 发送完一帧后sleep的时间,不能完全等于(1000/frameRate),不然会卡顿,

// 要更小一些,这里取八分之一

interVal /= 8;

// 持续从视频源取帧

while (null != (frame = grabber.grab())) {

videoTS = 1000 * (System.currentTimeMillis() - startTime);

// 时间戳

recorder.setTimestamp(videoTS);

// 有图像,就把视频帧加一

if (null != frame.image) {

videoFrameNum++;

}

// 有声音,就把音频帧加一

if (null != frame.samples) {

audioFrameNum++;

}

// 有数据,就把数据帧加一

if (null != frame.data) {

dataFrameNum++;

}

// 取出的每一帧,都推送到SRS

recorder.record(frame);

// 停顿一下再推送

Thread.sleep(interVal);

}

log.info("推送完成,视频帧[{}],音频帧[{}],数据帧[{}],耗时[{}]秒",

videoFrameNum,

audioFrameNum,

dataFrameNum,

(System.currentTimeMillis() - startTime) / 1000);

// 关闭帧录制器

recorder.close();

// 关闭帧抓取器

grabber.close();

}

public static void main(String[] args) throws Exception {

grabAndPush(MP4_FILE_PATH, SRS_PUSH_ADDRESS);

}

}上面这是一段测试成功的代码,也没有优化。看起来要复杂一些,但是可能更灵活。不过目前没有仔细研究,拉流效果感觉有些问题,也没有找到循环推流的尝试。

不过我想如果要实现我最初的想法,第一要多个视频无缝衔接,因为一个视频推流结束之后这个流 就结束了。后面要连续播放就只能重新打开。还有一个问题就是这种模式应该属于直播模式,如果我想快进跳跃式观影不知道有没有办法实现。还得继续研究。

![[附源码]SSM计算机毕业设计疫情防控期间人员档案追寻系统JAVA](https://img-blog.csdnimg.cn/cf7eac07a58e49e88c8eb20086a3bcc0.png)