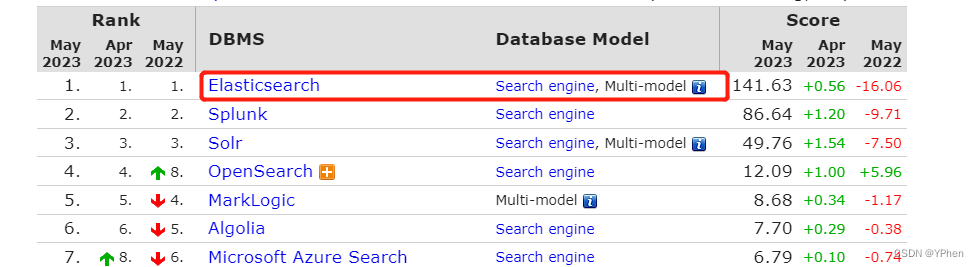

Spark的安装和配置

推荐按照我的博客下载hadoop,spark,pyspark以及scala这样版本搭配更好。

如果觉得自己不会版本搭配可私聊博主。

先安装hadoop再安装spark

scala的安装和配置:https://blog.csdn.net/weixin_41957626/article/details/130548174

1.下载

全部版本:Index of /dist/spark

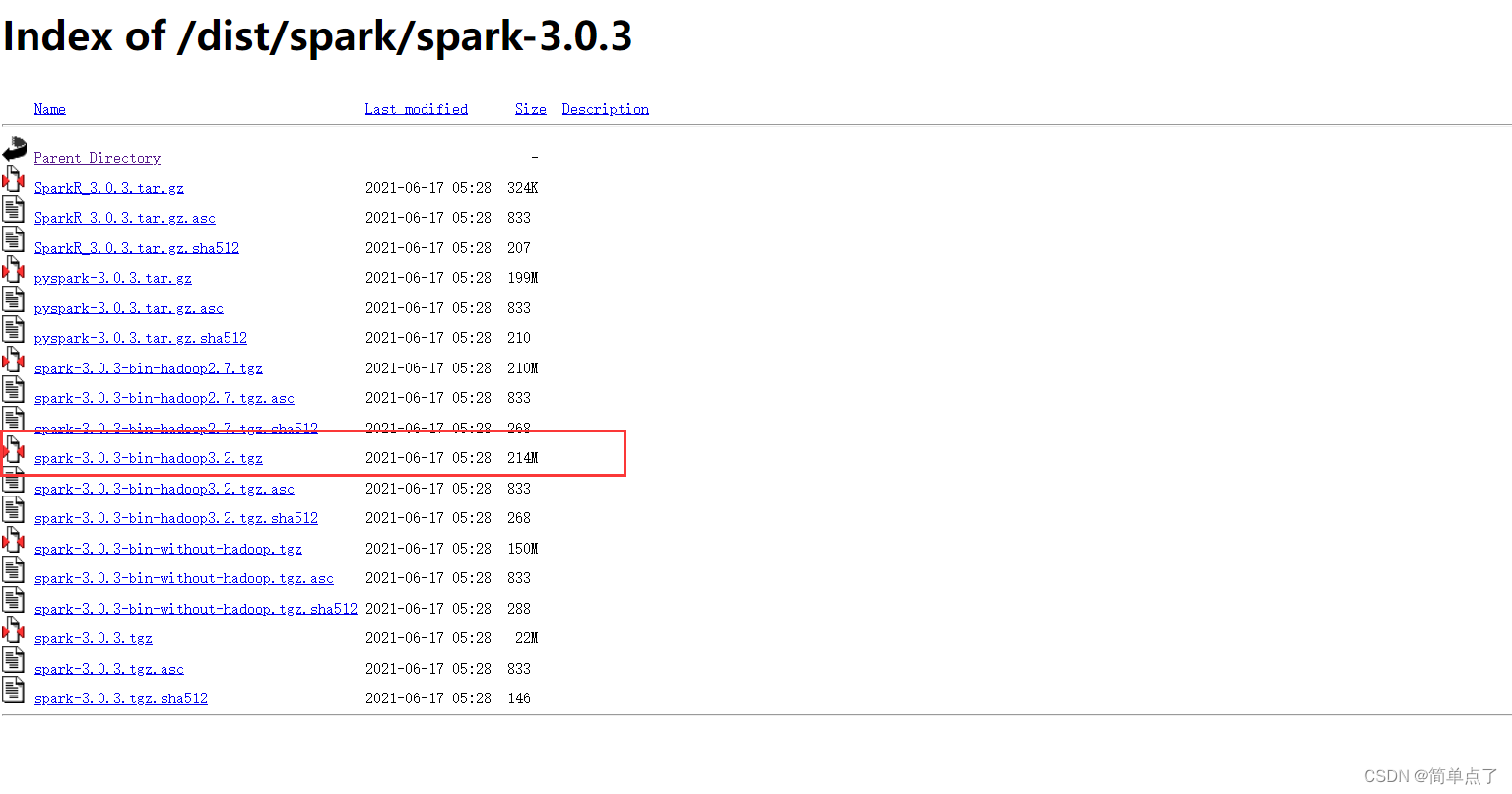

1.下载地址

Index of /dist/spark/spark-3.0.3

2.下载版本如下

3.下载解压

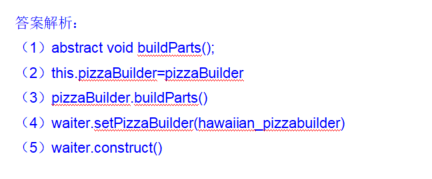

2.安装和配置

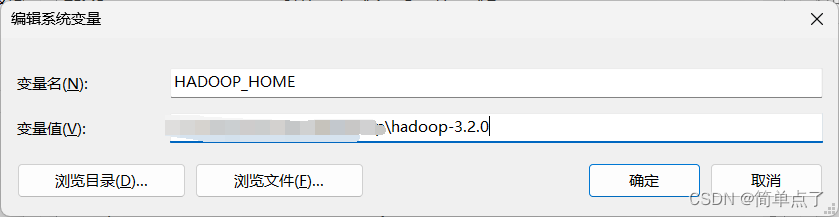

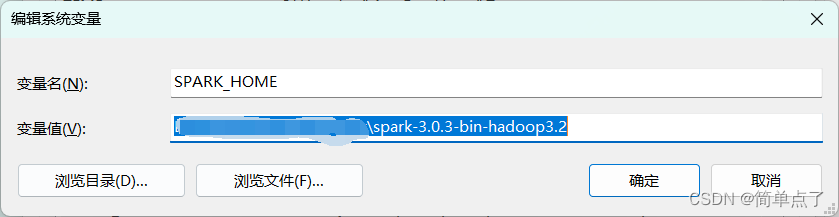

1.新建系统环境变量

SPARK_HOME

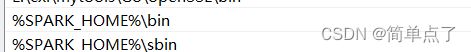

2.新建path环境变量

直接复制即可

%SPARK_HOME%\sbin

%HADOOP_HOME%\bin

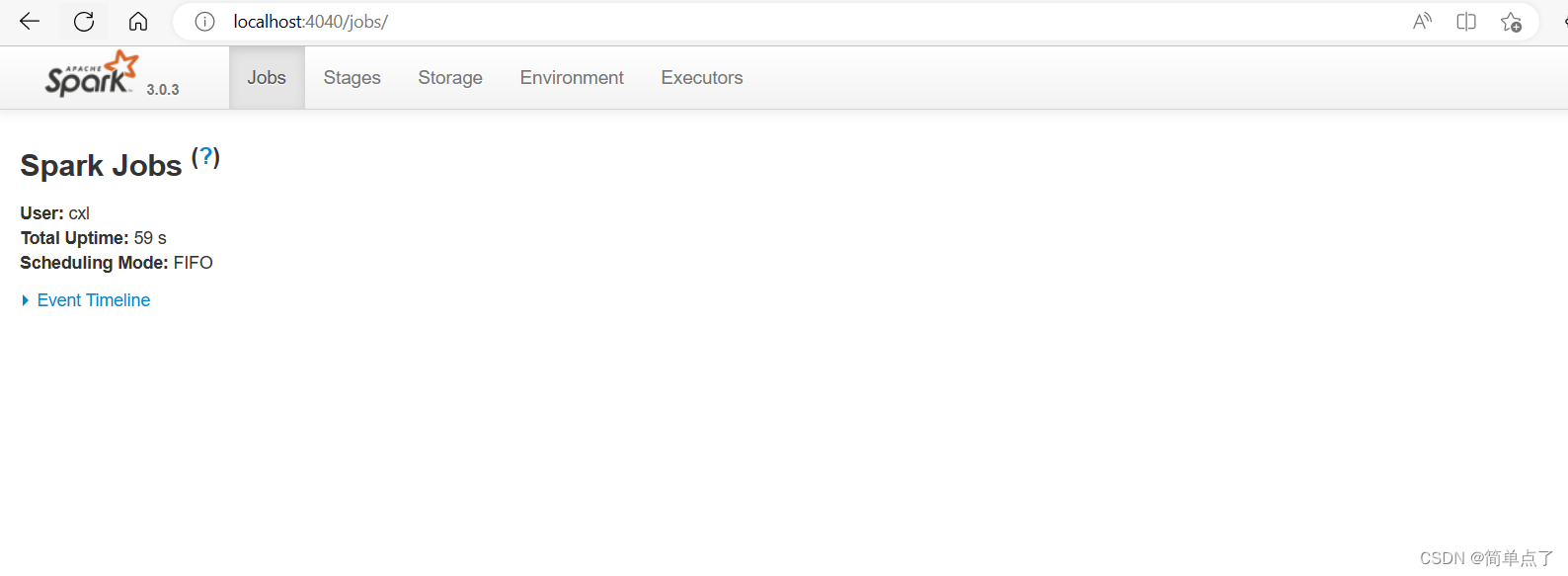

3.测试

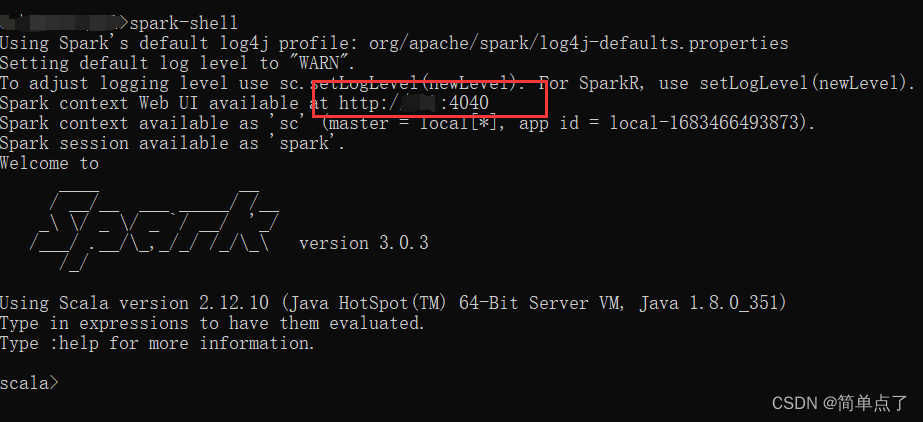

输入spark-shell即可进入测试窗口

进入管理界面

http://localhost:4040