【论文笔记】ASYMMETRIC SELF-PLAY FOR AUTOMATIC GOAL DISCOVERY IN ROBOTIC MANIPULATION

ABSTRACT

【主要工作】用一个单一的、有目标条件的策略来解决许多机器人操作任务,包括对之前未见过的物体的操作。

【主要方法】对于目标发现过程采用非对称自我博弈方法,任务中存在2个智能体,命名为Alice和Bob。Alice任务是提出具有挑战性的目标,而Bob任务是解决这些目标。

- Bob可以在稀疏环境下工作;

- Alice和Bob的交互过程生成了课程学习;

- Alice的轨迹被标签为目标条件下的演示数据时,Bob可以从中学习演示数据;

【实现结果】泛化到许多任务中(甚至非可见物体上)

1 INTRODUCTION

受到1993年一篇论文的启发,实现一个单一策略进行多任务的处理。目前的工作实现到了在桌面上的若干物体操作,将物体从初始配置不断调整到给定的配置。

我们在一个非常大的训练分布(training distribution)上使用深度强化学习来解决这个问题。如何构建一个足够丰富的训练分布,以实现对许多看不见的操作任务的泛化。这涉及到环境的初始状态分布(决定了如何采样初始状态和配置)和目标分布(决定了如何采样目标状态)。

前任工作:学习目标分布的生成模型

非对称自博弈解释

- Alice任务是提出目标,这些目标Bob不一定能实现;

- Bob本质是一个策略,用来解决Alice提出的目标;

- Alice的目标是依据机器人(实际)操作提出的;

- Bob需要与Alice一致的初始状态开始,实现这个目标;

- Alice和Bob嵌入在同一个机器人中,确保Alice自己提出的目标可以实现,即Alice自己执行的轨迹。

选择非对称自博弈模型的原因

-

Alice提出的每个目标都是能实现的,因为每个目标至少存在一个答案(Alice自己的轨迹)。

因此,可以通过行为克隆的方式让Bob至少学习到了Alice的实际操作轨迹。

缓解因奖励塑造(reward shaping)和课程学习带来的复杂的设计。

-

这个方法不需要大量密集数据的收集。

2 PROBLEM FORMULATION

让机器人操作在桌面上的物体重新排列到预期的配置中。

本文的任务是通过给定一个训练分布进行训练,再泛化到其他艰巨(不可见的)的场景中。

Mathematical formulation

Training goal distribution

- 均匀随机放置物体 —— 托举物体任务比较难生成

- 人工采集任务和状态 —— 动作量大

- 本文采用非对称自博弈方法进行

Alice π A l i c e ( a ∣ s ) \pi_{Alice}(a|s) πAlice(a∣s) 的进度永远比Bob π B o b ( a ∣ s , g ) \pi_{Bob}(a|s,g) πBob(a∣s,g) 快

Evaluation on holdout tasks

zero-shot generalization “ 无中生有的泛化 ”

人为设计了一套困难任务,其目标从未直接纳入训练分布中。一些任务也包括以前未见过的物体。

- 测试是否已经学习了一种特定的技能

- 测试是否表示一个语义上有趣的任务

Appendix B.6 —— HOLDOUT TASKS

3 ASYMMETRIC SELF-PLAY

从初始状态分布中采样一个初始状态 s 0 s_{0} s0 ;

Alice 和 Bob 分别接收环境及其初始状态,并按先后顺序执行下面任务;

Alice:与环境交互固定的 T T T 个步骤,在这 T T T 个步骤中的最后一个状态作为目标 g = s T g=s_{T} g=sT 传递给Bob;

如果Alice没有移动任何对象,或者有一个对象从桌子上掉了下来,则任务终止;

Bob:如果Bob在环境中成功达到目标 g g g,就会得到奖励。当Bob成功地实现目标或达到超时时,他的回合就结束了。如果Bob的回合以失败告终,它的剩余回合将被跳过并视为失败,而我们让Alice继续生成目标。

如果Bob没有解决Alice提出的目标,Alice就会得到奖励。重复步骤2-3,直到Alice设定了5个目标,或者Alice提出了一个无效的目标,然后episode结束。

-

促使Alice逐渐提出越来越难的任务,迫使Bob解决越来越难的任务

-

选择多目标设置是为了让Bob充分利用在episode早些时候发现的环境信息来解决其剩余的目标,有利于转移到物理系统。

-

为了提高稳定性和避免遗忘,我们让Alice和Bob在20%的比赛中与他们各自过去版本的对手进行比赛。

3.1 REWARD STRUCTURE

For Bob

sparse goal-conditioned rewards 稀疏目标条件下的奖励

衡量了物体的位姿(空间位置:欧氏距离;空间角度:欧拉角)

-

当两个距离度量都低于一个小误差(成功阈值)时,Bob立即获得1个奖励。

-

如果这个对象移动到远离它在过去步骤中到达的状态,Bob获得-1奖励

这样在给定的回合中,每个对象的奖励总和最多为1。

-

当所有的物体都处于目标状态时,Bob会得到5个额外的奖励,这个回合就结束了。

For Alice

- 如果 Bob 未能解决目标,奖励5

- 如果 Bob 成功解决目标,奖励0

- 如果 Alice 设定了一个有效的目标,我们会增加一个奖励,定义为没有任何物体从桌子上落下,任何物体的移动超过了成功阈值。

- 当 Alice 用放置区域之外的物体设置目标时,会引入−3奖励的额外惩罚,该区域定义为机器人摄像机视图内。

3.2 ALICE BEHAVIORAL CLONING (ABC)

使用非对称自我博弈的主要好处之一是,生成的目标至少有一个解决方案来实现它:Alice的轨迹。

Demonstration trajectory filtering

Alice的轨迹未必是最好的,她的执行存在偶然性。

仅考虑Bob未能实现目标的那段轨迹作为示范数据,避免Bob对子最优策略的关注。当Bob失败时,将Alice的这段轨迹增广成行为克隆的数据结构。

PPO-style BC loss clipping

4 RELATED WORK

Training distribution for RL

- 以前的工作手动设计了任务或目标的分布,以更好地看到策略更好地泛化到新的任务或目标。

- 手动定义模拟环境的分布,但用于推广到现实世界中相同的任务。

- 构建了一个不断增长的训练分布,其中多个智能体通过相互竞争来学习,从而使生成的智能体在单个游戏中表现出强大的性能。

前人训练的是生成模型,而不是目标设定策略

这些方法继承了训练生成模型的困难:建模高维空间的困难和生成不现实的样本。

Asymmetric self-play

混合非对称自游戏训练与标准RL训练的目标任务,并测量在目标任务上的表现。

- Sukhbaatar等人使用非对称自博弈对分层策略进行预训练,并在对目标任务进行微调后对其进行评估。

- Liu等人在一对agent之间的探索竞争中,采用了自博弈来鼓励具有稀疏奖励的有效学习。

- 以前没有任何工作训练过纯粹基于不对称自博弈的目标条件策略,并评估了对看不见的困难任务的泛化。

Curriculum learning

相似之处,即不对称的自博弈减轻了通过内在课程和模仿目标设定者的轨迹来学习目标条件策略的困难,但我们的工作没有假设任何预定义的任务或目标分布。

Hierarchical reinforcement learning (HRL)

在HRL中学习目标设定策略的动机不是挑战目标解决策略,而是合作解决一个可以分解为一系列子目标的任务。

这个目标设定策略被训练来优化目标任务的任务奖励,而不像非对称自我博弈,即目标设定者在另一个agent的失败时获得奖励。

Robot learning for object manipulation

块叠加(blocking stacking),涉及复杂的接触推理和长水平运动规划。需要手工设计的课程、细致的奖励塑造、微调或人类示范。选择这个任务作为泛化任务。

5 EXPERIMENTS

5.1 EXPERIMENTAL SETUP

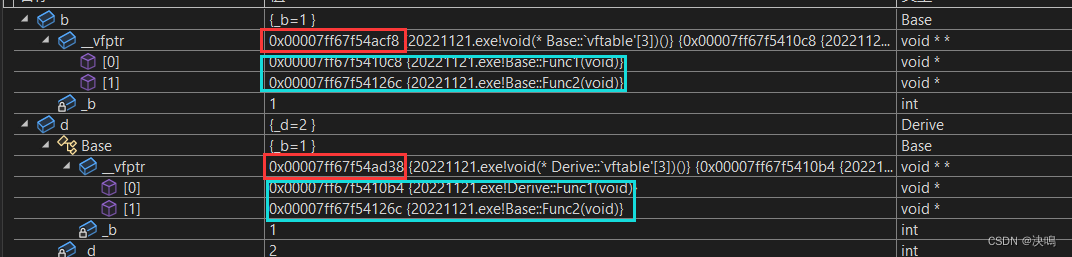

Alice和Bob实现为具有内存的相同网络架构的两个独立策略,Alice对目标状态没有观察

这些策略采用状态观察(“状态策略”)来进行带有块的实验。

同时采用视觉和状态观察(“混合策略”)。这两种策略都经过了近端策略优化(PPO)的训练。

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-QKjTigCN-1669720632182)(C:\Users\aw\Desktop\阅读论文截图图片\name非对称自博弈_fig4.png)]

5.2 GENERALIZATION TO UNSEEN GOALS WITHOUT MANUAL CURRICULA

为了衡量由自博弈引入的内在课程的影响,我们精心设计了一套非自博弈基线(baseline),使用由自动领域随机化(Automation Domain Randomization)控制的显式课程

我们通过跟踪每个坚持任务的成功率来衡量训练设置的有效性

5.3 DISCOVERY OF NOVEL GOALS AND SOLUTIONS

虽然对Bob来说自己学习是一个棘手的策略,但在ABC过程中,Bob最终获得了解决Alice提出的复杂任务的技能。

随着训练的进行,Alice倾向于产生更具挑战性的目标,而Bob则表现出较低的成功率。

通过过去的抽样,Bob继续在早期优化步骤的Alices版本中取得进展。

这种可视化暗示了一种理想的非对称自博弈的动态,这可能会导致无限的复杂性:Alice不断地生成目标来挑战Bob,而Bob在学习解决新目标方面不断取得进展。

5.4 GENERALIZATION TO UNSEEN OBJECTS AND GOALS

该混合策略使用视觉观察来提取有关对象的几何形状和大小的信息。

我们在一组更多样化的操作任务上评估Bob策略,包括语义上有趣的操作任务。

5.5 ABLATION STUDIES

我们提出了一系列的消融研究,旨在测量我们的非对称自我游戏框架中每个组件的重要性,包括Alice行为克隆(ABC)、BC损失裁剪、演示过滤和多目标游戏设置。

-

ABC:a critical mechanism

-

BC loss clipping:略微提升学习率和稳定性

-

demonstration filter:从行为克隆中排除次优演示的重要性

-

single-goal:Generalization of this baseline to holdout tasks turns out to be much slower and less

stable.

6 CONCLUSION

我们的非对称自游戏方法的一个限制是,它依赖于一个可重置的模拟环境,因为Bob需要从与Alice相同的初始状态开始。因此,非对称的自我游戏训练必须在一个模拟器中进行,它可以很容易地更新到一个期望的状态。

sim-to-real

One potential approach is to pre-train two agents via asymmetric self-play in simulation, and then

fine-tune the Bob policy with domain randomization or data collected on physical robots.

伪代码

![[附源码]Python计算机毕业设计Django的残障人士社交平台](https://img-blog.csdnimg.cn/f32b5fab162d494abf0948a3811f1118.png)

![[msyql]实战:关于回表的一次查询优化实战](https://img-blog.csdnimg.cn/25199d77629b46618e9b1fa03dec6990.png)