论文信息

题目:

FlowFusion:Dynamic Dense RGB-D SLAM Based on Optical Flow

流融合:基于光流的动态稠密RGB-D SLAM

论文地址:

https://arxiv.org/pdf/2003.05102.pdf

发表期刊:

2020 IEEE International Conference on Robotics and Automation (ICRA)

标签

xxxx

摘要

动态环境下的运动目标遮挡了静态环境特征,导致错误的相机运动估计,是视觉SLAM的一大挑战。本文提出一种新的稠密RGB-D SLAM解决方案,同时完成动/静态分割、相机自运动估计以及静态背景重建。新颖之处是使用光流残差来突出RGB D点云中的动态语义,并为相机跟踪和背景重建提供更准确和高效的动态/静态分割。

内容简介

本文通过基于流的动/静态分割来解决动态SLAM问题,从而摆脱预先知道动态目标的假设。与已有方法不同,提出了一种新的基于光流残差的动态分割密集融合RGB-D SLAM方案。通过改进动态因子的影响,该方法能够有效地提取当前RGB-D帧中的动态片段,进而准确地重建出静态环境。此外,在具有挑战性的真实类人机器人SLAM场景上的演示表明,所提出的方法优于其他最新的动态SLAM解决方案

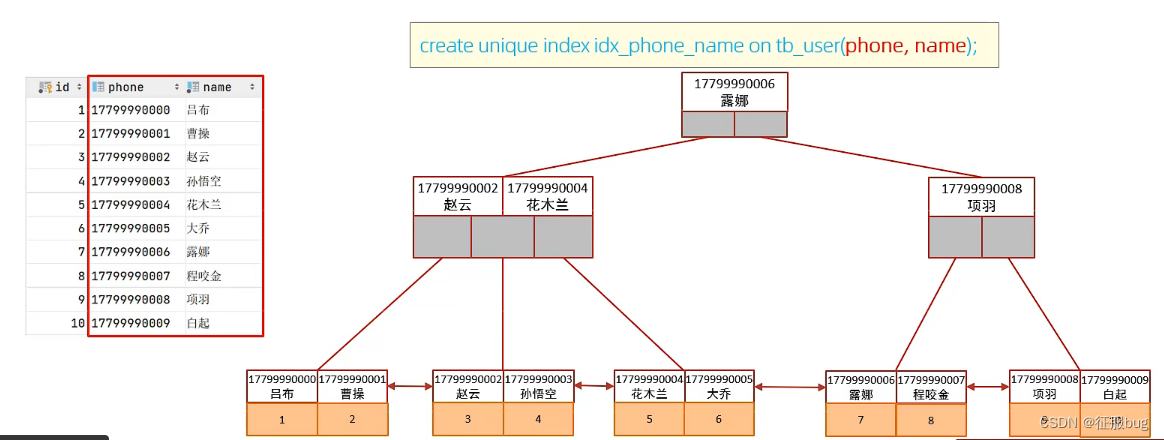

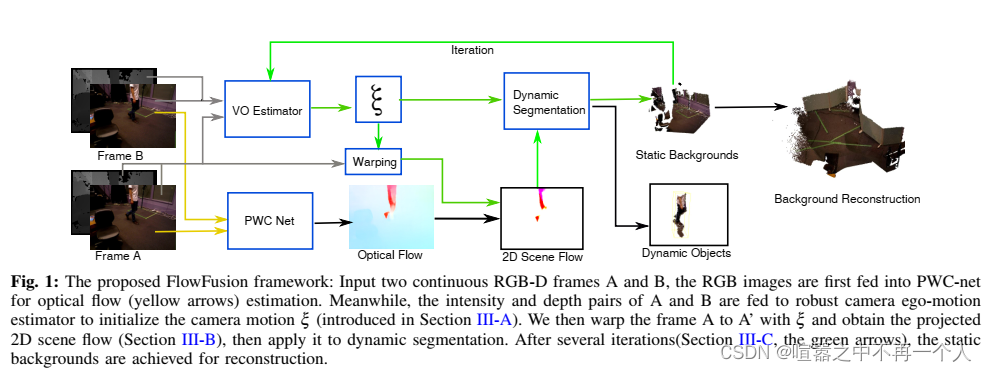

所提方法的流程图如图1所示。该方法将两个RGB- d帧A和B作为输入,将RGB图像输入PWC以估计光流(黄色箭头)。同时,将A和B的强度和深度对输入到鲁棒相机自运动估计器,以估计初始相机运动x(在第III-A节中介绍)。然后,我们用x将帧A扭曲到A ',并获得投影的2D场景流(在第III-B节),以进行动态分割。经过多次迭代(Section III-C,绿色箭头),得到静态背景,用于后续的环境重建。由于该方法利用光流残差进行动态分割,因此称为流融合(flow fusion, FF)。

评价

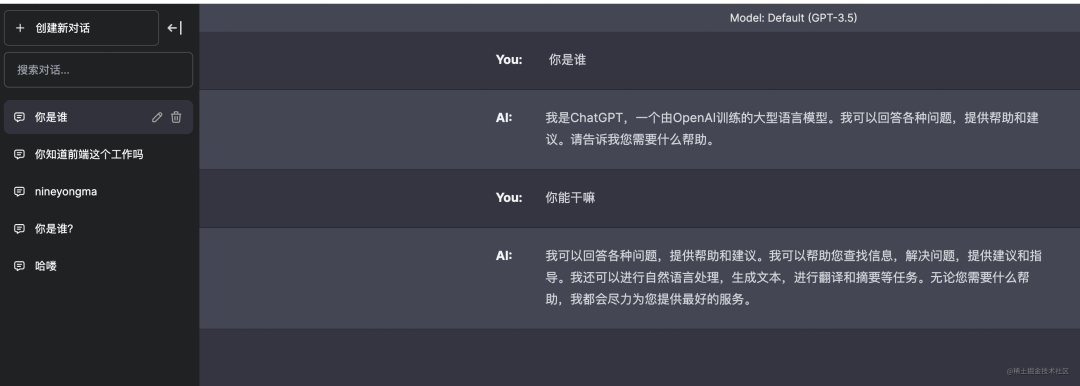

该评价来自于CHATGPT4解读:

1)方法:

该论文提出了一种新颖的密集RGB-D SLAM方法,可以同时实现动态/静态场景分割、相机自运动估计以及静态背景重建。该方法的创新之处在于使用光流残差突出RGB-D点云中的动态语义信息,从而为相机跟踪和背景重建提供更准确、高效的动态/静态分割。

2)创新点:

使用光流残差进行动态/静态场景分割,提高了SLAM系统在动态环境下的性能。

同时实现动态/静态场景分割、相机自运动估计以及静态背景重建。

通过改进动态因素影响,有效地在当前RGB-D帧中提取动态分割,准确地重建静态环境。

在真实的挑战性人形机器人SLAM场景中,所提出的方法优于其他现有的动态SLAM解决方案。

3)精炼总结:

本文提出了一种基于光流残差的密集RGB-D SLAM方法,可以在动态和静态环境下实现高效准确的性能。通过使用光流残差进行动态/静态场景分割,该方法在动态环境下具有较强的鲁棒性。

结合您的研究方向,可能的创新方向如下:

1、将深度学习技术(如卷积神经网络和循环神经网络)与光流残差相结合,进一步提高动态/静态场景分割的准确性和效率。

2、探索多传感器融合的方法,将激光雷达、摄像头和IMU等传感器的信息集成到所提出的SLAM方法中,以提高系统在动态环境下的性能。

3、研究在不同光照条件和遮挡情况下,如何提高基于光流残差的动态/静态场景分割方法的鲁棒性。

4、尝试将所提出的方法应用于不同类型的机器人,例如自动驾驶汽车、无人机和服务机器人,以评估其在各种应用场景中的适用性。

阅读总结

没看懂,光流这块不太懂