论文信息

题目:

DynaSLAM:Tracking,Mapping and Inpainting in Dynamic Scenes

DynaSLAM:动态场景中的跟踪、映射和修复

论文地址:

https://arxiv.org/pdf/1806.05620.pdf

发表期刊:

IEEE Robotics and Automation Letters ( Volume: 3, Issue: 4, October 2018)

开源代码:

https://github.com/BertaBescos/DynaSLAM

标签

经典动态SLAM、语义分割+几何约束、背景修复

摘要

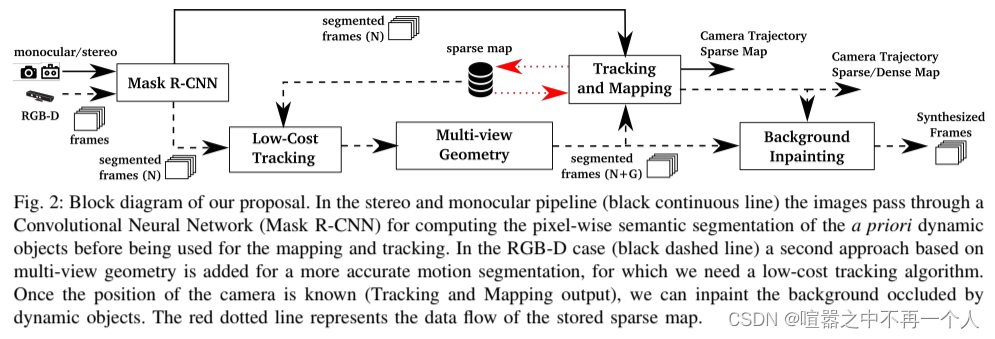

本文提出了DynaSLAM视觉SLAM系统,该系统建立在ORB-SLAM2[1]之上,增加了动态目标检测和背景修复的功能。DynaSLAM在单目、立体和RGB-D配置的动态场景中具有鲁棒性。我们能够通过多视图几何,深度学习或两者同时检测运动目标。拥有场景的静态地图可以修复被动态物体遮挡的框架背景。

内容简介

首先,RGB通道通过一个CNN,该CNN按像素分割出所有先验的动态内容,例如:,人或车辆。在RGB-D情况下,利用多视角几何从两方面改进动态内容分割。首先,对之前由CNN获得的动态对象进行细化分割;其次,将大多数时候是静态的动态新对象实例标记为静态的(即在CNN阶段检测未设置为可移动的移动对象)。为此,有必要知道相机的姿态,为此实现了一个低成本的跟踪模块,以在已经创建的场景地图中定位相机。这些分割后的帧用于获取摄像机轨迹和场景地图。注意,如果场景中的运动物体不在CNN类内,多视图几何阶段仍然会检测到动态内容,但精度可能会降低。完成相机的全动态目标检测和定位后,旨在用之前视图的静态信息重建当前帧的被遮挡背景。这些合成框架与增强和虚拟现实等应用程序相关,以及终身地图中的位置识别。在单目和立体场景下,利用卷积神经网络对图像进行分割,使得属于先验动态目标的关键点既不被跟踪也不被映射。

评价

本文提出了一种视觉SLAM系统,在ORB-SLAM的基础上,添加了一种运动分割方法,使其在单目、立体和RGB-D相机的动态环境中具有鲁棒性。该系统准确地跟踪了摄像机,并创建了静态的,因此可重复使用的场景地图。在RGB- d情况下,DynaSLAM能够获得合成的RGB帧,没有动态对象表示场景的重要部分的情况。然而,估计的map只包含结构性对象,因此可以在长期应用中重复使用。这项工作的未来扩展可能包括,实时性能、基于RGB的运动检测器,或通过使用更精细的修复技术,例如,合成的RGB帧的更真实的外观。其中,Pathak等人使用的方法;[24]使用GANs。动态内容和遮挡背景的修复,以及它们对应的合成深度帧,这可能对虚拟现实应用非常有用。我们包括一段视频,展示了DynaSLAM 2的潜力。与最新技术的比较表明,DynaSLAM在大多数情况下达到了最高的精度。在TUM动态对象数据集中,DynaSLAM是目前最好的RGB-D SLAM解决方案。在单目情况下,精度类似于ORB-SLAM,但通过早期初始化获得了场景的静态地图。在KITTI数据集上,DynaSLAM的精度略低于单目和立体ORB-SLAM

阅读启发

大致浏览了一下,该经典动态SLAM技术包含以下两个内容:

1、基于深度学习和几何约束的动态目标剔除

2、遮挡部分的背景修复技术(利用之前静态帧修复当前帧)

我认为该系统可以有以下几个改进的地方:

1、实时性改进,对每一帧进行分割肯定会大大降低SLAM系统的实时性

1:使用轻量级神经网络(知识蒸馏法)

2:只对关键帧进行分割

2、前端剔除过多的动态(潜在动态)特征是否会导致定位失败的问题。

还没看到有论文这样做。我感觉可以利用多视图几何先一步进行初步位姿估计,在与分割后的结果进行融合。