如果说HDFS是存储,则Yarn就是cpu和内存,mapreduce就是程序。

1.HDFS文件块大小

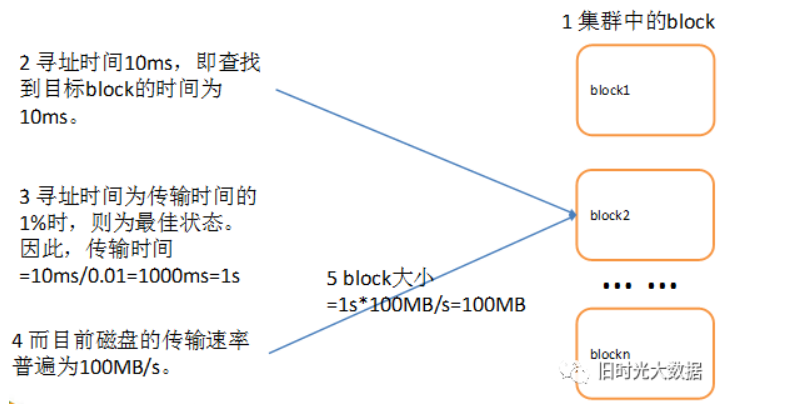

HDFS中的文件在物理.上是分块存储(Block) ,block默认保存3份块的大小可以通过配置参数(dfs blocksize)来规定,默认大小在Hadoop2 .x版本中是128M,老版本中是64M。

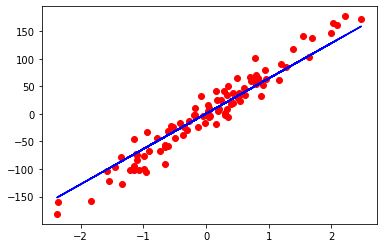

解释:块的大小:10ms*100*100M/s = 100M,约等于128M,如图

ps.为什么块的大小不能设置的太小,也不能设置的太大

(1) HDFS的块设置太小,会增加寻址时间,程序一直在找块的开始位置

(2)如果块设置的太大,从磁盘传输数据的时间会明显大于定位这个块开始位置所需的时间。导致程序在处理这块数据时,会非常慢。

总结: HDFS块的大小设置主要取决于磁盘传输速率

2.HDFS的常用指令

定位到 /opt/module/hadoop-3.1.3文件夹下

1.上传操作

1)-moveFromLocal:从本地剪切粘贴到HDFS

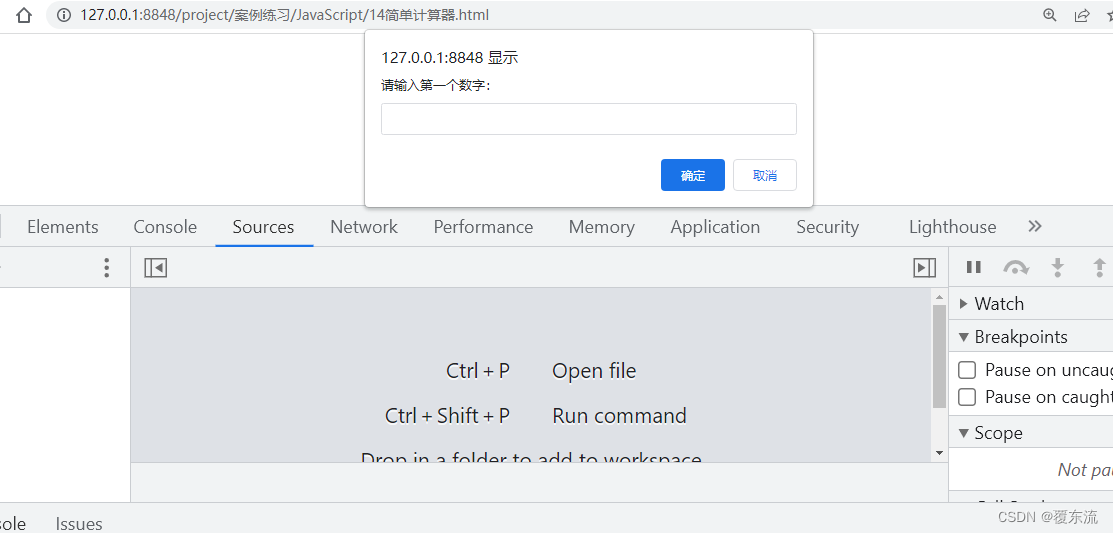

vim shuguo.txt

输入:

shuguo

hadoop fs -moveFromLocal ./shuguo.txt /sanguo 2)