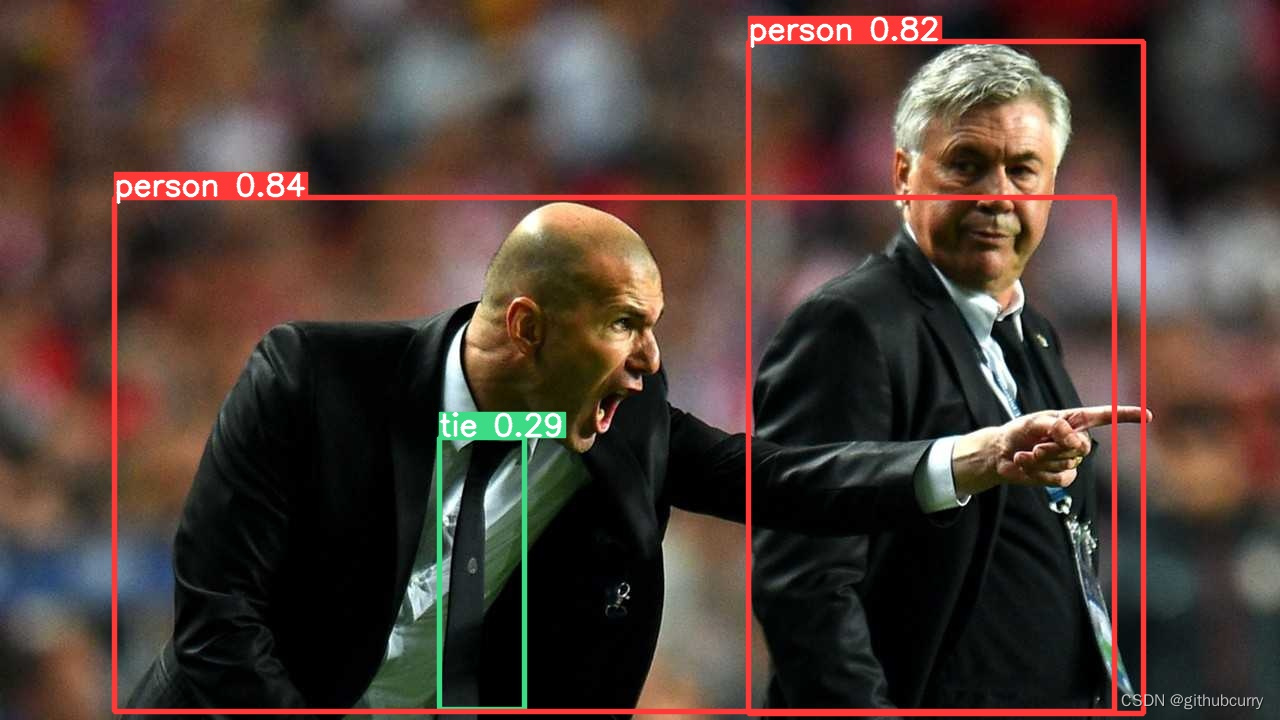

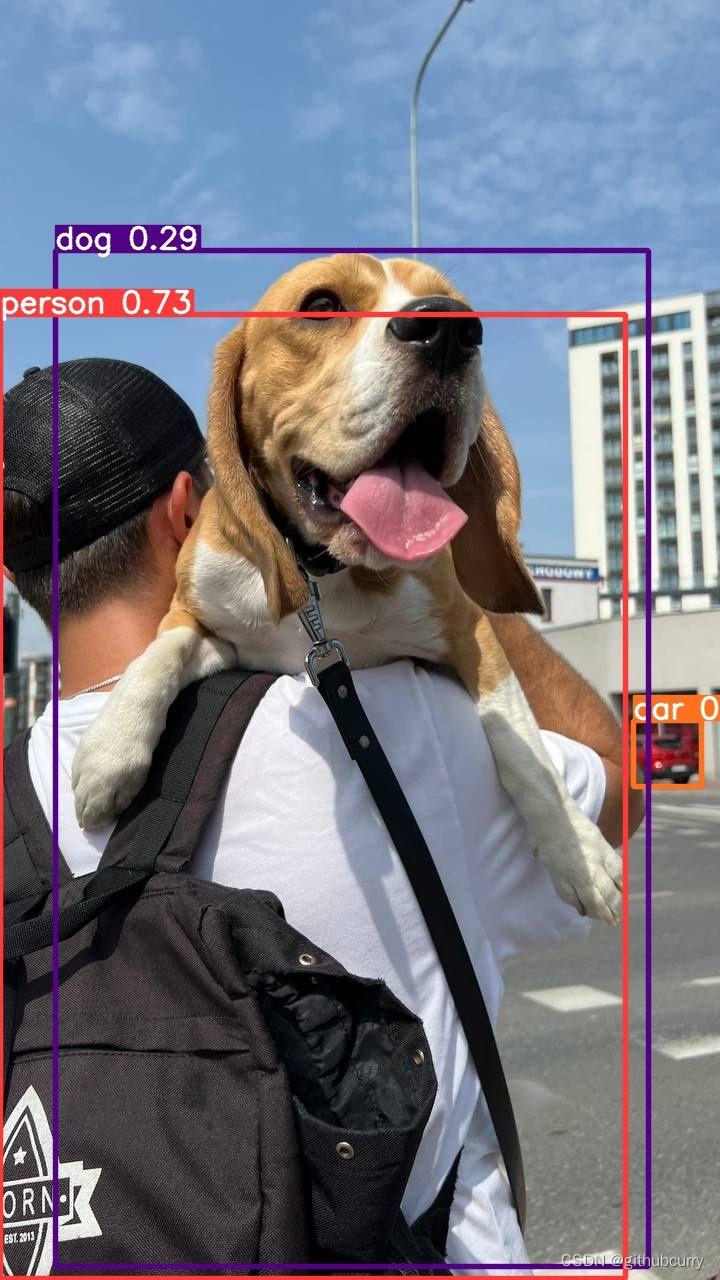

YOLOv8效果图(可以应用到图片和视频):

四个模式命令

yolo task=detect mode=predict model='model/yolov8n.pt' source='input/test.mp4' show=True

yolo task=segment mode=predict model='model/yolov8x-seg.pt' source='input/zidane.jpg' show=True

yolo task=classify mode=predict model='model/yolov8n-cls.pt' source='input/test.mp4' show=True

yolo task=pose mode=predict model='model/yolov8n-pose.pt' source='input/test.mp4' show=True

#调用摄像头进行检测

yolo task=detect mode=predict model='model/yolov8n.pt' source=0 show=True

将model=yolov8n.pt替换为自己的权重,如果本地没有,就会自动去下载预训练权重,source替换为自己的图片或者视频,task可以修改为其他三种模式。

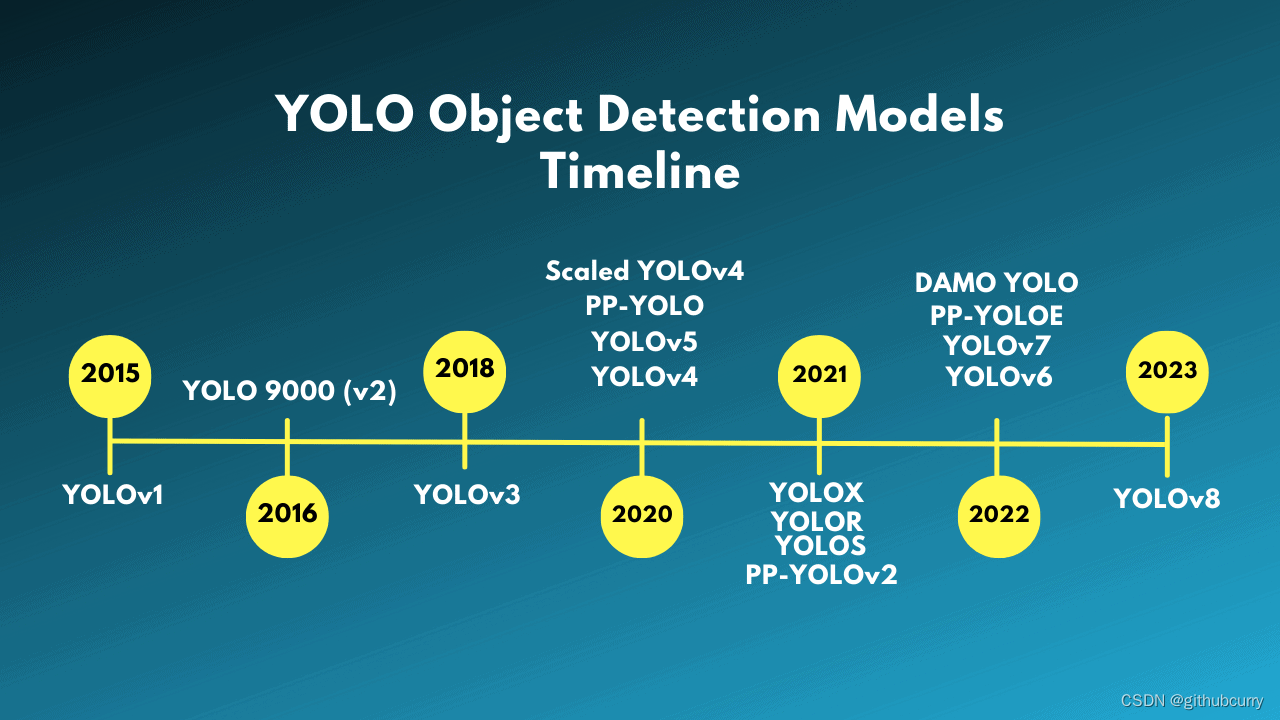

yolo发展历程:

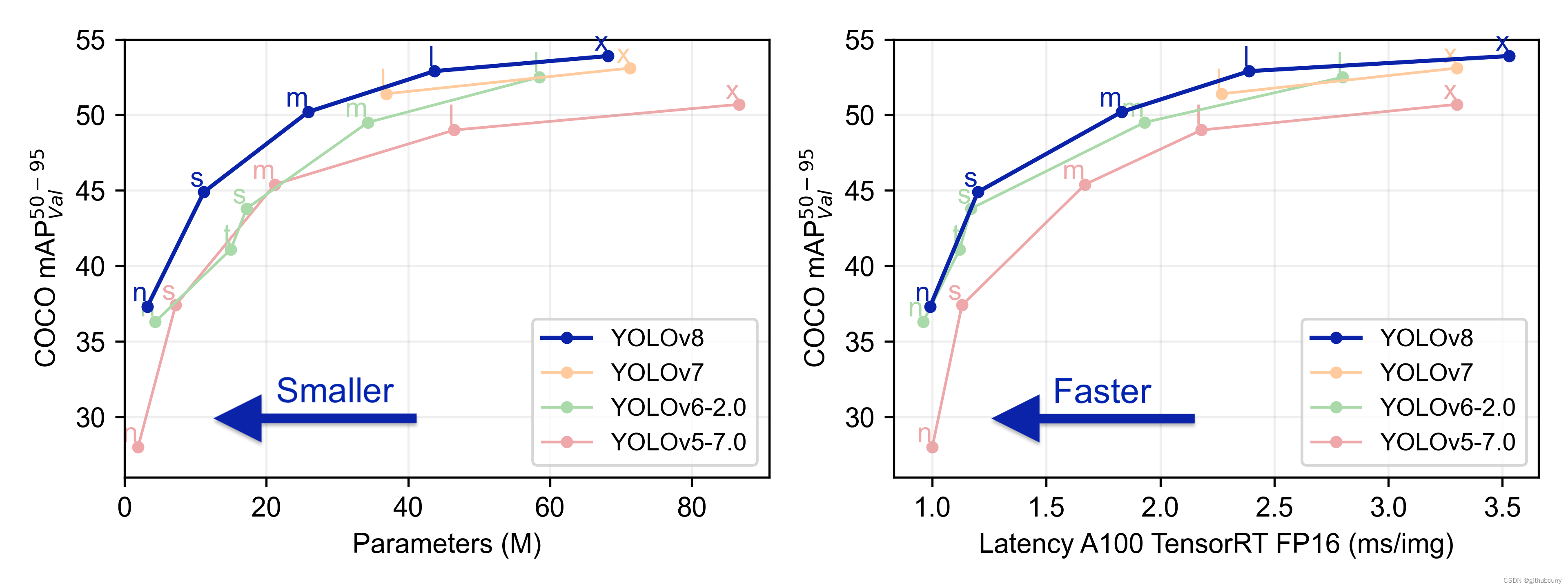

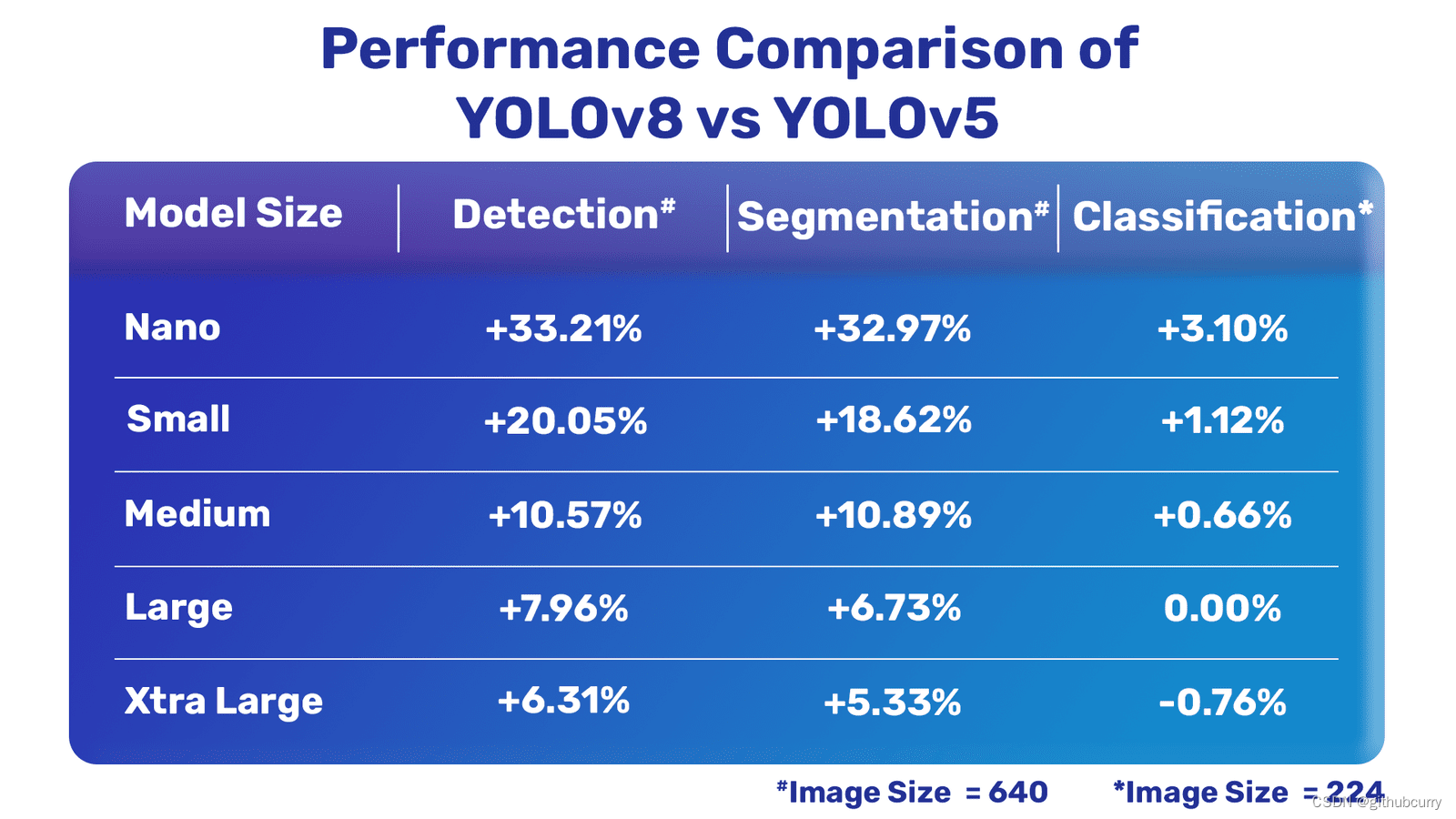

YOLOv8 vs YOLOv7 vs YOLOv6 vs YOLOv5

YOLOv8的出品公司还是Ultralytics,也就是发布YOLOv5和YOLOv3的那家。

本次的升级主要包括:

- 用户友好的API(命令行+Python)

- 更快更准确(由于正式的论文还没发表,它和SOTA模型的具体对比数据现在还没有)

- 同时支持目标检测、实例分割和图像分类三种任务

- 可扩展到以前所有的版本

- 新的backbone网络(CSP结构不变,但C2f模块替换了C3模块,每个stage的blocks数改为[3,6,6,3]等)

- 新的Anchor-Freehead

- 新的损失函数

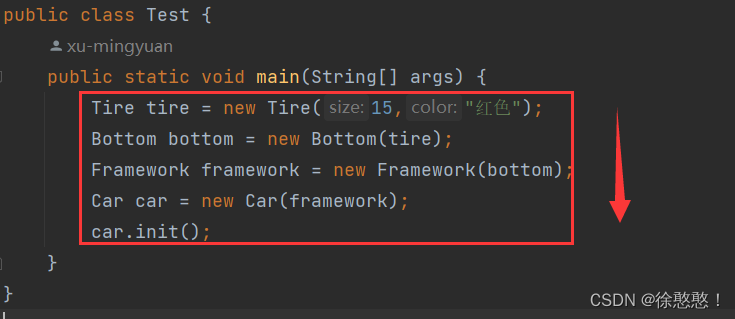

首先,YOLOv8的开发者脱离了标准YOLO项目的设计,将train.py、detect.py、val.py、export.py这四个脚本进行了分离。

短期来看,这种改变可能会引起混乱,因为它从YOLOv3就一直没有变过;但原来这种看起来就好理解的模式在实时处理和跟踪场景中进行部署实在是比较麻烦。所以还是改用了更加灵活的新设计,让YOLOv8可以通过终端独立使用。

其次,这次新增的CLI可以让你在各种任务和版本上进行更加方便的模型训练、验证或推理。在终端的操作方式与我们熟悉的脚本非常相似,比如利用CLI检测给定图像中的对象,这样就行:

yolo task=detect \

mode=predict \

model=yolov8n.pt \

conf=0.25 \

source='https://media.roboflow.com/notebooks/examples/dog.jpeg'

最后,Ultralytics YOLO这次配备的Pythonic模型和训练接口,让我们用6行代码就能在自定义Python脚本中用上YOLO模型,操作方式就像这样:

from ultralytics import YOLO

model = YOLO('yolov8n.pt')

model.predict( source='https://media.roboflow.com/notebooks/examples/dog.jpeg', conf=0.25)

在自定义数据集上训练YOLOv8

1、首先,安装YOLOv8

pip install ultralytics(推荐)

或者

git clone https://github.com/ultralytics/ultralytics>cd ultralytics>pip install -e ultralytics

2、然后开始构建自定义数据集。

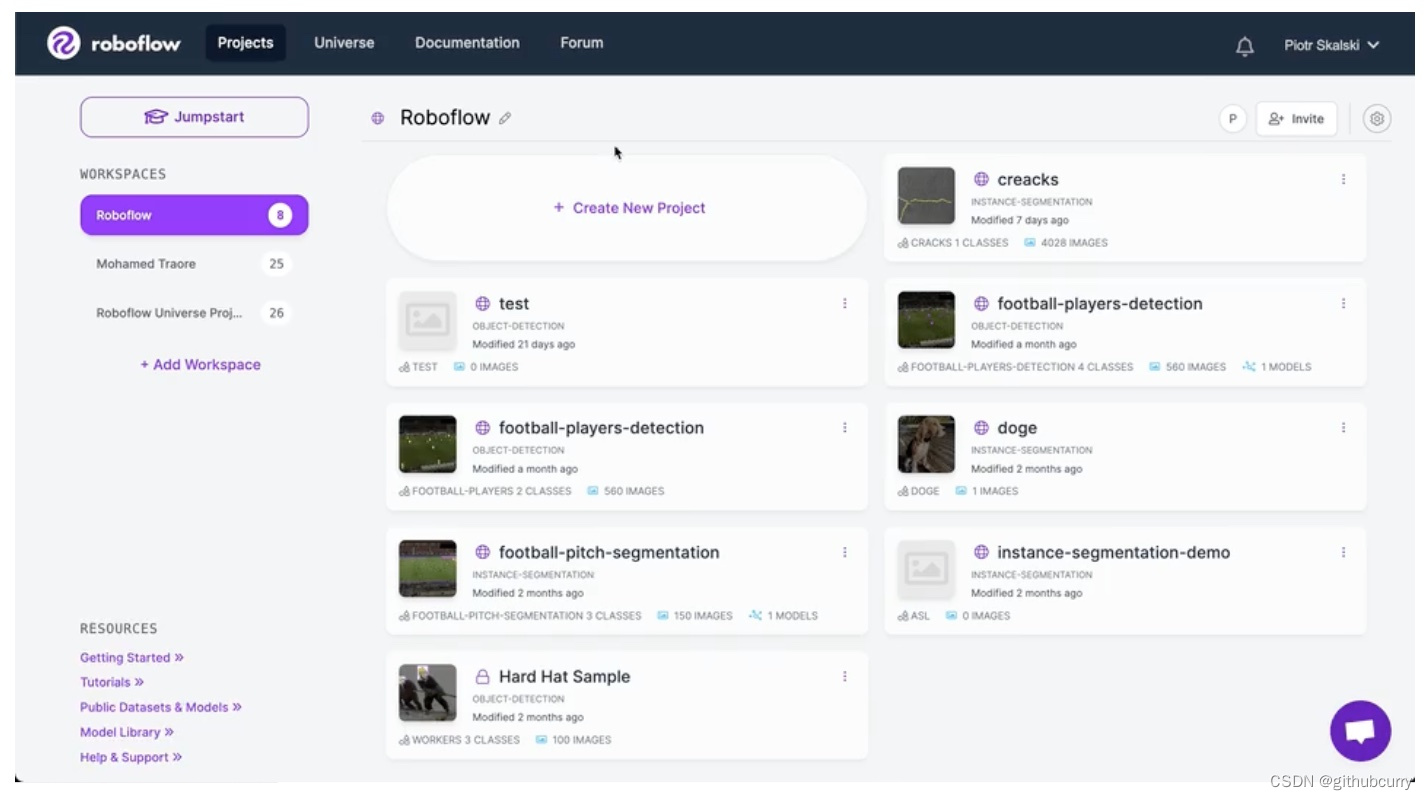

为了不让这个过程那么痛苦和耗时,我们可以用上Roboflow这个工具,操作步骤如下:

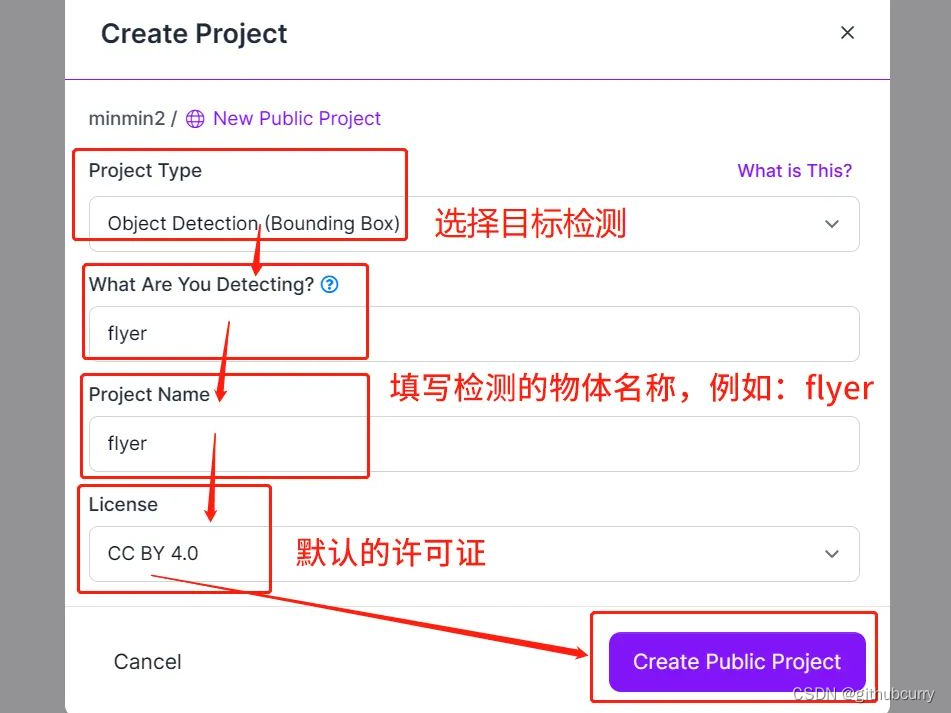

(1)创建账户,新建项目,项目类型选择“目标检测(Object Detection)”。

(2)上传图片将数据集导入到项目之中。如果你没有准备数据集,可以用它们官方提供的(从Roboflow Universe中下载)。

如果你的图片已经带标注,系统可以自动读取;如果没有,可以用它提供的这个非常快捷的标注工具现标。

(3)然后就能生成数据集了。“预处理”和“数据增强”两个选项可以勾上,让你的模型鲁棒性更强。

(4)现在我们就拥有了自己的一个托管数据集,将它导出就能直接加载到电脑中进行训练了。

记住从Roboflow Universe中下载数据集时选择“YOLO v5 PyTorch”格式,然后在弹出的窗口中看到一段代码,简单修改各个参数即可。

from roboflow import Roboflow

rf = Roboflow(api_key='YOUR_API_KEY')

project = rf.workspace('WORKSPACE').project('PROJECT')

dataset = project.version(1).download('yolov8')

3、开始训练

使用下面的命令将数据集下载片段(snippet)粘贴到你的YOLOv8 Colab notebook中,开始训练。

yolo task=detect \

mode=train \

model=yolov8s.pt \

data={dataset.location}/data.yaml \

epochs=100 \

imgsz=640

取决于数据集大小和训练方法,过程将持续几分钟或几小时。

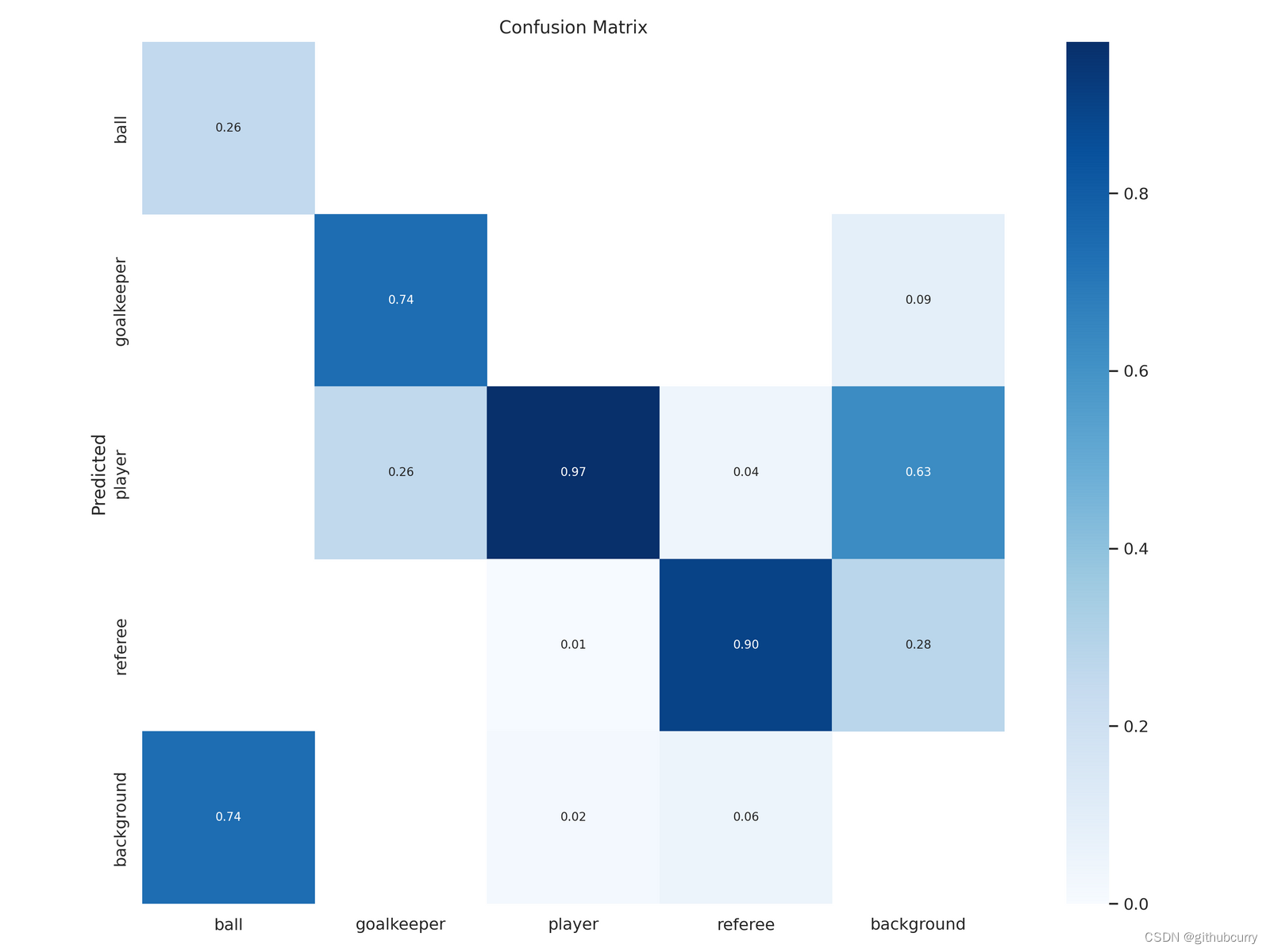

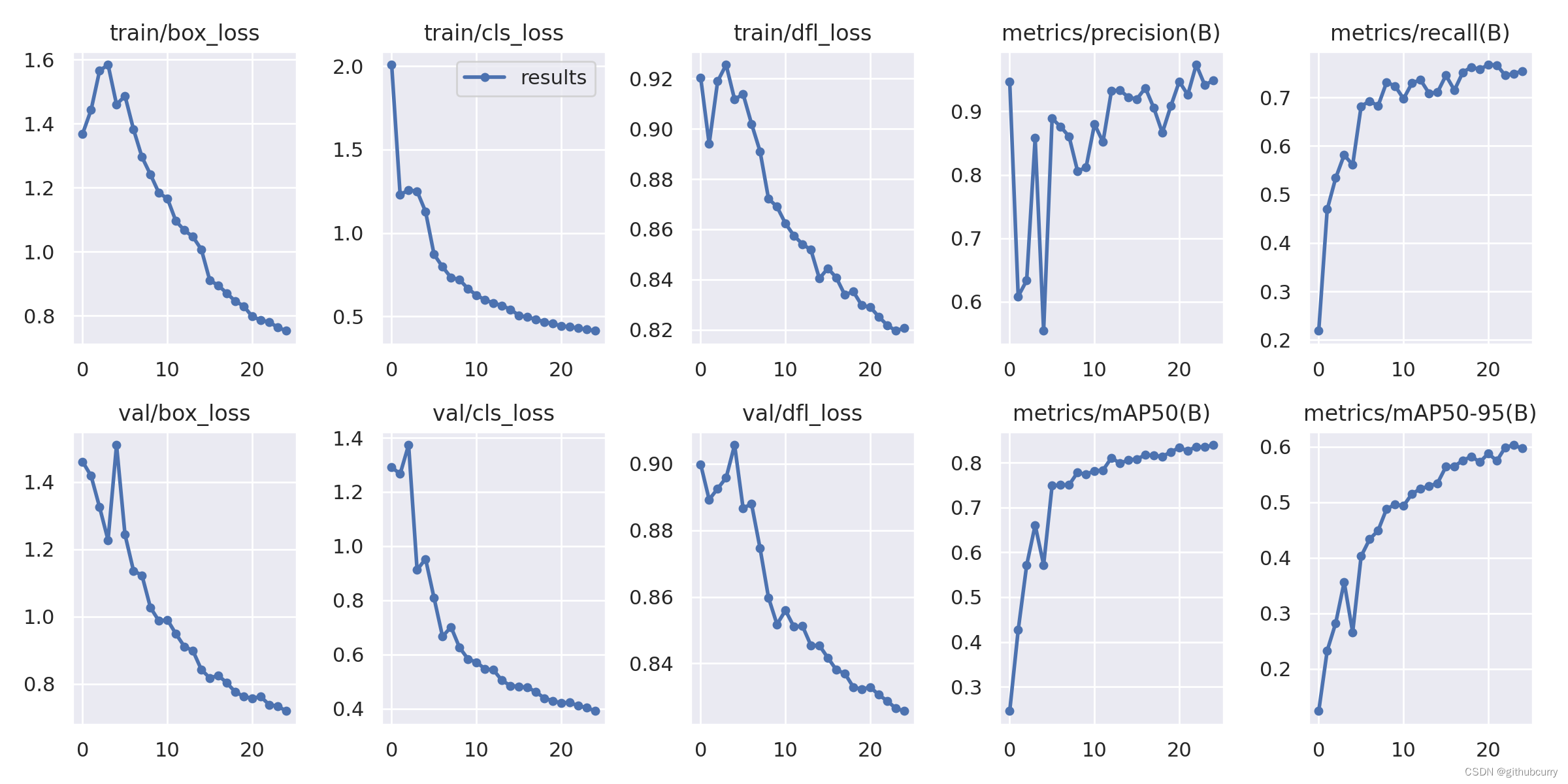

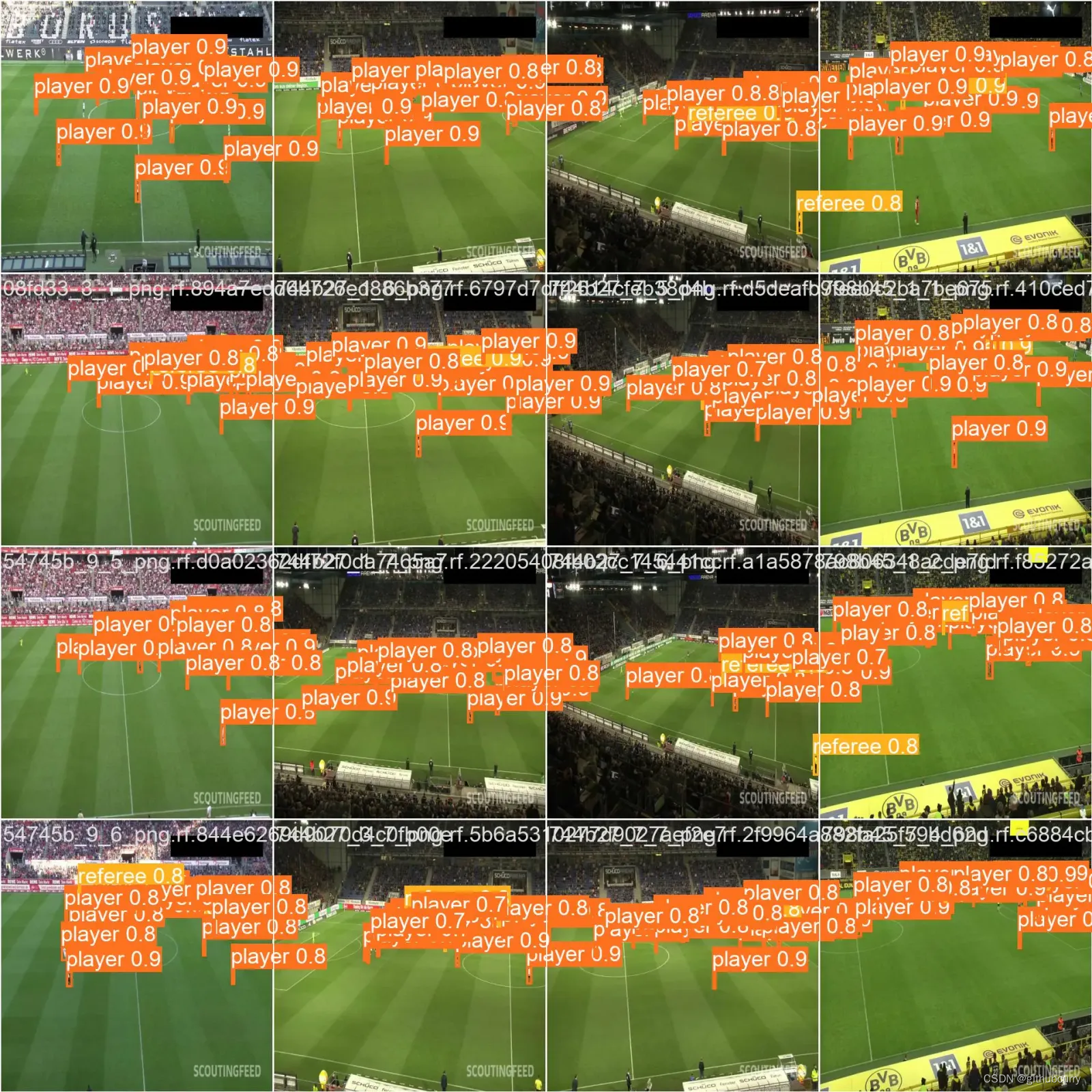

以下是上述足球数据集的训练结果:

(1)返回的混淆矩阵;

(2)跟踪的关键指标;

(3)验证batch上的推理示例。

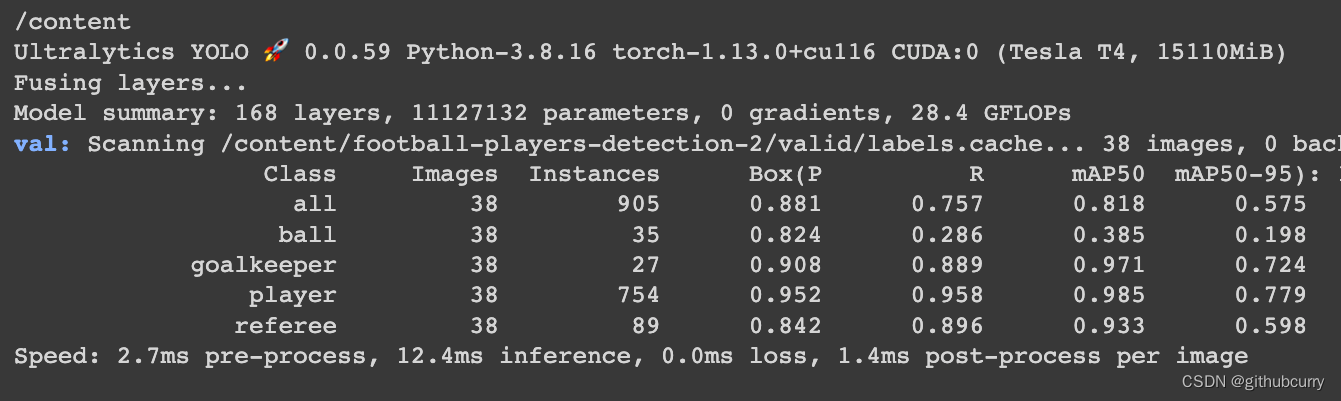

4、用测试集验证模型

训练好后开始验证。创建数据集时分成三部分,其中一部分用来当测试集:

yolo task=detect \

mode=val \

model={HOME}/runs/detect/train/weights/best.pt \

data={dataset.location}/data.yaml

评估结果如下:

5、使用自定义模型进行预测

命令如下:

yolo task=detect \

mode=predict \

model={HOME}/runs/detect/train/weights/best.pt \

conf=0.25 \

source={dataset.location}/test/images

结果示例:

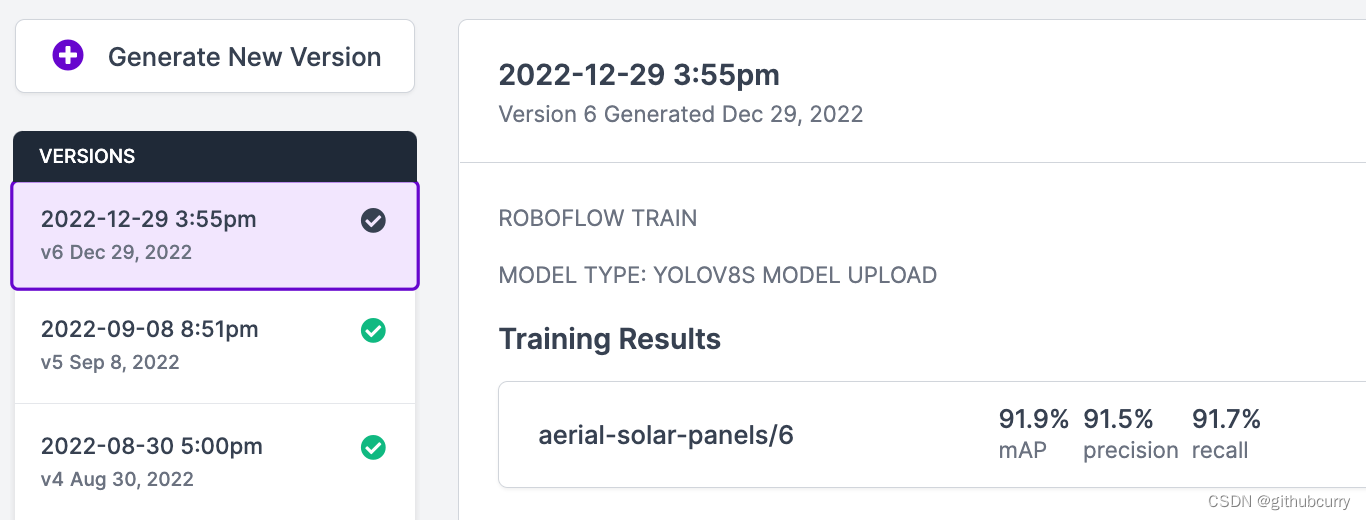

6、最后一步:导出和上传权重

现在我们拥有了一组训练好的权重,可用于托管API端点,就在项目的/runs/detect/train/weights/best.pt文件夹中。

当然,也可以使用Roboflow pip包中的Deploy()函数将它上传到Roboflow Deploy中,方便自己和他人共享。

单击Roboflow仪表板侧栏中的“部署(Deploy)”,查看可用的选项,然后就能直接在浏览器中测试你的模型了。要共享给他人,发送一个URL就行。

测试素材可以直接用你测试集里的图片,也可以上传新的图片或视频,或者粘贴YouTube链接、直接用摄像头。