【复现论文】Looking here or there? Gaze Following in 360-Degree Images

论文:Looking here or there? Gaze Following in 360-Degree Images

论文链接:Looking here or there? Gaze Following in 360-Degree Images

复现github链接:Rao2000/gazefollow360: The paper “Looking here or there? Gaze Following in 360-Degree Images” implementing with Pytorch (github.com)

知乎链接: link

掘金链接:link

1.论文主要内容

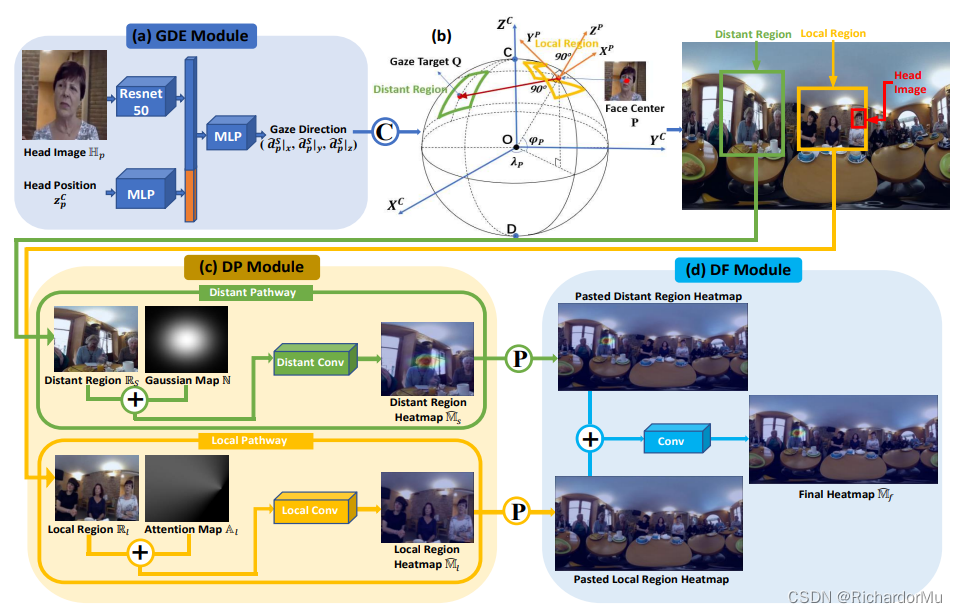

在本文中,研究了一项新任务,即 360 度图像中的视线方向,并为这项新任务收集了一个新的大规模数据集“GazeFollow360”。论文指出这项新任务的主要挑战是由于 360 度图像中球体到平面投影引起的失真,人类受试者的注视目标和他/她的视线之间的不匹配。为了解决这个问题,我们提出了一个双路径框架,该框架由在 3D 球体空间中建模的视线引导,而不是简单地在 2D 图像平面坐标中,以检测局部区域(此处)和远处区域(那里)内的注视目标平行。论文的框架在GazeFollow360上的强大性能验证了它在理解真实3D世界中视线行为方面的潜力。

主要贡献可以分为三个部分:

(1)第一份在360展开图上研究gaze following的工作

(2) 建立了一个10058张图片的数据集

(3)提出了一个双支路的框架解决360场景下的gaze following

2.复现工作

在发邮箱给论文一作,询问其是否开源代码无果后,尝试根据论文的信息去复现代码。

我简单的复现了一下论文,得到双支路模型在test dataset的实验结果

论文中的实验结果:

| AUC | sphere dist | |

|---|---|---|

| test dataset | 0.9350 | 0.6067 |

我复现的实验结果:

| pixel dist | norm dist | AUC | sphere dist | |

|---|---|---|---|---|

| test dataset | 443.5346 | 0.1584 | 0.8673 | 0.6157 |

容易看出,我复现的实验结果是比论文实验结果更差的,但是在同一个量级上。同时,在其他公开模型方法上,比如论文Detecting Attended Visual Targets in Video,也很难复现出论文的实验结果。

3.期望

最后欢迎大家指正我的复现结果,也期待官方早点开源吧。