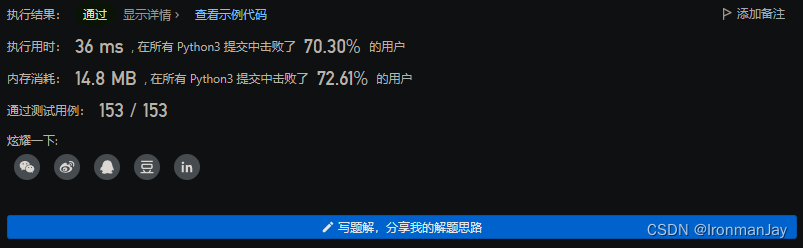

测试6.6. 卷积神经网络(LeNet) — 动手学深度学习 2.0.0 documentation

import torch

from torch import nn

from d2l import torch as d2l

net = nn.Sequential(

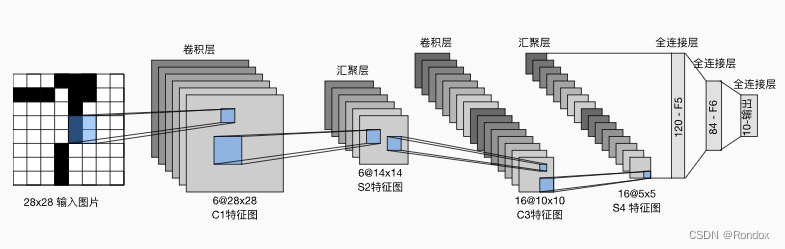

#输入通道1表示黑白 输出通道6表示6组取不同特征的卷积核 因为卷积核是5*5,原始图片单通道黑白28*28,看图 目的是输出6组28*28的特征图,故需要四条边都padding补上2条边 左右补4 上下补4,故卷积后可以达成28*28,之后用Sigmoid使结果非线性防止最终模型可以简化成一个线性模型

#用Sigmoid是因为relu当时还没有发明出来

nn.Conv2d(1, 6, kernel_size=5, padding=2), nn.Sigmoid(),

#池化平均.使28*28按kernel_size=2 -> 2*2的特征做平均为14*14大小的特征图,步长stride=2使得汇聚窗口不会互相重叠

nn.AvgPool2d(kernel_size=2, stride=2),

#以输入通道为6 输出通道为16模式,卷积核有16组的5*5做卷积运算,之后激活函数Sigmoid使之非线性

nn.Conv2d(6, 16, kernel_size=5), nn.Sigmoid(),

#继续/2平均后

nn.AvgPool2d(kernel_size=2, stride=2),

#此时是16组5*5的特征图, Flatten拉成一条的向量16*5*5

nn.Flatten(),

#做以16*5*5做输入,120输出做一次线性 变成隐藏层1再nn.Sigmoid()非线性

nn.Linear(16 * 5 * 5, 120), nn.Sigmoid(),

#做以120做输入,84输出再做一次线性 变成隐藏层2再nn.Sigmoid()非线性

nn.Linear(120, 84), nn.Sigmoid(),

#最后以84输入,10输出做一次线性得到结果Y, 此时Y是10组不同分类中的特征值

nn.Linear(84, 10))

总体来说就是

1.一张单通道28*28的图片,通过第一次卷积增大特征量->变成6组不同特征量的28*28的C1特征图(6@28*28),之后浓缩特征,进行池化平均->变成6组14*14的S2特征图(6@14*14)->以6组不同特征的图当做6个输入通道,以16组输出通道和5*5的特征和输出成16组10*10的C3特征图(16@10*10)->池化平均16@5*5的S4特征图

2.16@5*5的S4特征图开始做拉成一组大向量做线性的梯度下降,先拉成长度120做一次(120,84)的线性->再做(84,10)的线性->最后输出10种类别的特征值开始测试 网络结构

X = torch.rand(size=(1, 1, 28, 28), dtype=torch.float32)

for layer in net:

X = layer(X)

print(layer.__class__.__name__,'output shape: \t',X.shape)

#测试每一层是否有错误

#

Conv2d output shape: torch.Size([1, 6, 28, 28])

Sigmoid output shape: torch.Size([1, 6, 28, 28])

AvgPool2d output shape: torch.Size([1, 6, 14, 14])

Conv2d output shape: torch.Size([1, 16, 10, 10])

Sigmoid output shape: torch.Size([1, 16, 10, 10])

AvgPool2d output shape: torch.Size([1, 16, 5, 5])

Flatten output shape: torch.Size([1, 400])

Linear output shape: torch.Size([1, 120])

Sigmoid output shape: torch.Size([1, 120])

Linear output shape: torch.Size([1, 84])

Sigmoid output shape: torch.Size([1, 84])

Linear output shape: torch.Size([1, 10])读数据

batch_size = 256

train_iter, test_iter = d2l.load_data_fashion_mnist(batch_size=batch_size)评估方法test

def evaluate_accuracy_gpu(net, data_iter, device=None): #@save 评估方法test

"""使用GPU计算模型在数据集上的精度"""

if isinstance(net, nn.Module):

net.eval() # 设置为评估模式

if not device:#调用gpu跑

device = next(iter(net.parameters())).device

# 正确预测的数量,总预测的数量

metric = d2l.Accumulator(2)#累加器用来放置数据 累加

with torch.no_grad():

for X, y in data_iter:

if isinstance(X, list):

# BERT微调所需的(之后将介绍)

X = [x.to(device) for x in X]#X放gpu

else:

X = X.to(device)

y = y.to(device)#y放gpu

metric.add(d2l.accuracy(net(X), y), y.numel())#[0]放每次跑的预测准确的数,[1]放每次跑的总数

return metric[0] / metric[1] #返回准确的数/总数 即准确率训练函数 train

#@save

def train_ch6(net, train_iter, test_iter, num_epochs, lr, device):

"""用GPU训练模型(在第六章定义)"""

def init_weights(m):#定义init_weights函数用于初始化数据

if type(m) == nn.Linear or type(m) == nn.Conv2d:

nn.init.xavier_uniform_(m.weight)#可以初始化我们的权重 使之符合均值0,方差1,否则会出现梯度爆炸或者消失等严重问题 跑不出结果

net.apply(init_weights)#选定自定义的参数初始化函数

print('training on', device)

net.to(device)

optimizer = torch.optim.SGD(net.parameters(), lr=lr)#优化函数用sgd,对net.parameters()进行梯度下降

loss = nn.CrossEntropyLoss()#分类问题 采用softmax的交叉熵函数

animator = d2l.Animator(xlabel='epoch', xlim=[1, num_epochs],

legend=['train loss', 'train acc', 'test acc'])#画图内容

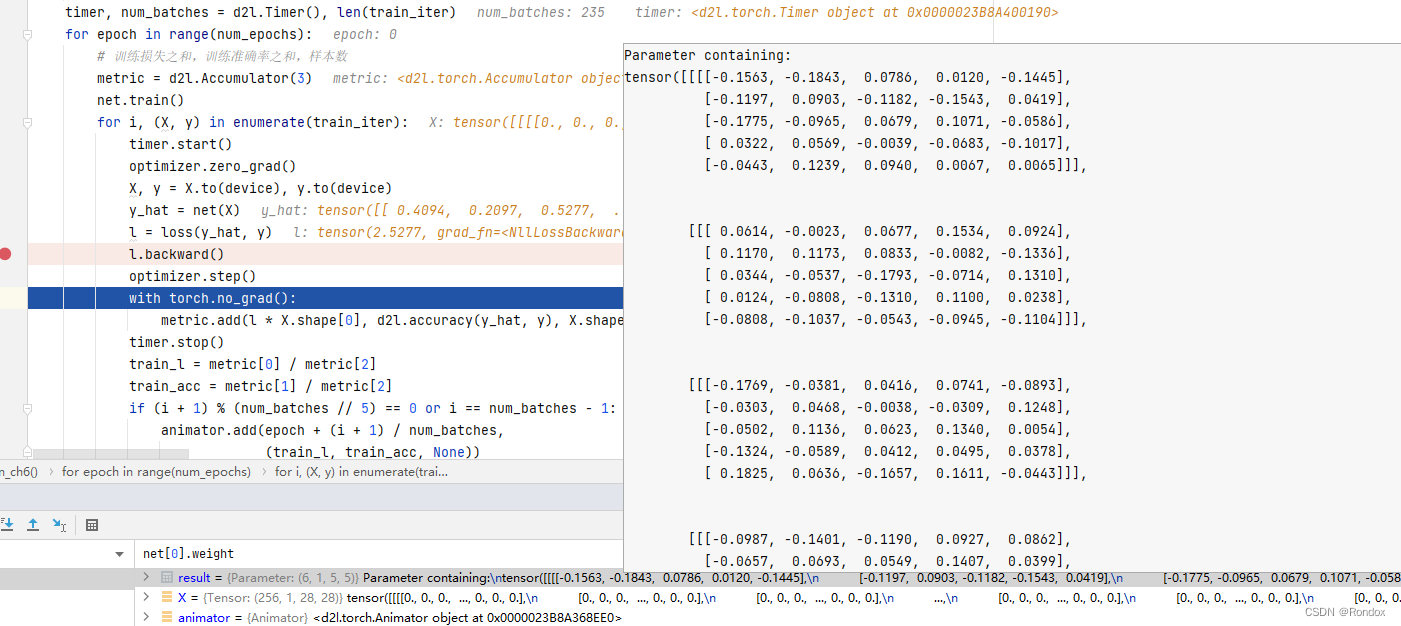

timer, num_batches = d2l.Timer(), len(train_iter)

for epoch in range(num_epochs):

# 训练损失之和,训练准确率之和,样本数

metric = d2l.Accumulator(3)#3位置的累加器

net.train()#将模型设置为训练模式:默认参数是Train。model.train()会启动drop 和 BN,但是model.train(False)不会

for i, (X, y) in enumerate(train_iter): #enumerate() 函数用于将一个可遍历的数据对象(如列表、元组或字符串)组合为一个索引序列,同时列出数据和数据下标,一般用在 for 循环当中。

timer.start()

optimizer.zero_grad()#对不同的train_iter中出来的X,y 每次清除梯度

X, y = X.to(device), y.to(device)

y_hat = net(X)

l = loss(y_hat, y)

l.backward()#反向传播计算各参数当前梯度比如y对w求梯度

optimizer.step()#step()之后才会更新参数值 比如x=x−lr∗x.grad

with torch.no_grad():#累加器加入数据的时候不算入梯度计算范围

#加入的分别是 损失*批量大小, *这个看下面解析* ,批量大小

metric.add(l * X.shape[0], d2l.accuracy(y_hat, y), X.shape[0])

timer.stop()

train_l = metric[0] / metric[2]#损失率

train_acc = metric[1] / metric[2]#准确率

if (i + 1) % (num_batches // 5) == 0 or i == num_batches - 1:#画图

animator.add(epoch + (i + 1) / num_batches,

(train_l, train_acc, None))

test_acc = evaluate_accuracy_gpu(net, test_iter)#训练完每一个train_iter的数据后再拿完整的训练好的参数的net验证准确率

animator.add(epoch + 1, (None, None, test_acc))

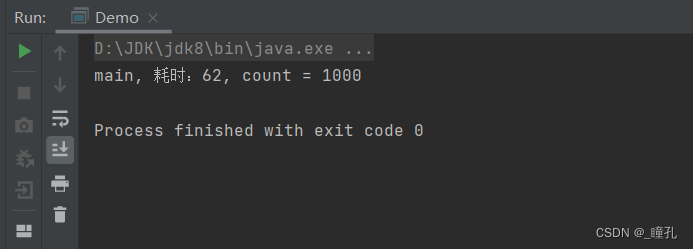

print(f'loss {train_l:.3f}, train acc {train_acc:.3f}, '

f'test acc {test_acc:.3f}')

print(f'{metric[2] * num_epochs / timer.sum():.1f} examples/sec '

f'on {str(device)}')设置学习率开跑

lr, num_epochs = 0.9, 10

train_ch6(net, train_iter, test_iter, num_epochs, lr, d2l.try_gpu())附录

交叉熵有点忘了看:

交叉熵损失函数(Cross Entropy Loss)_SongGu1996的博客-CSDN博客

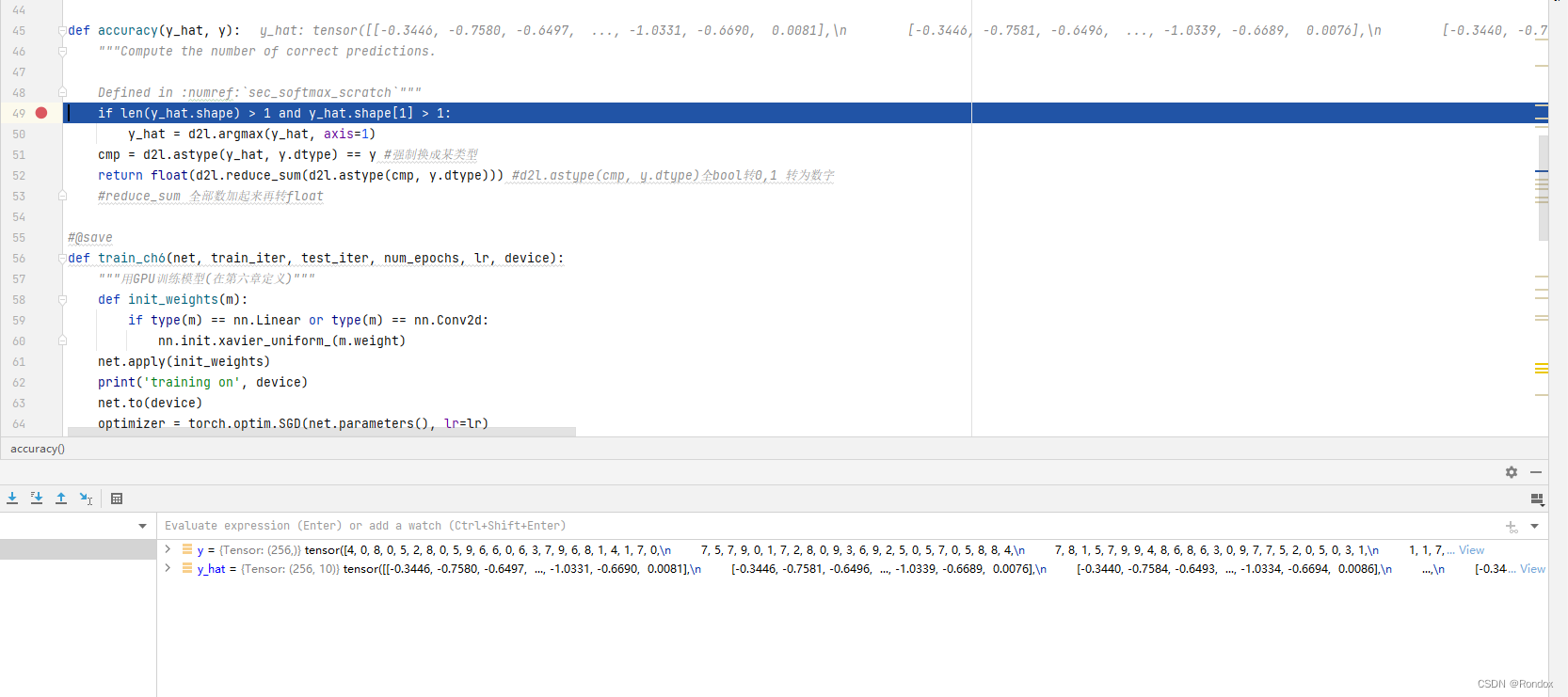

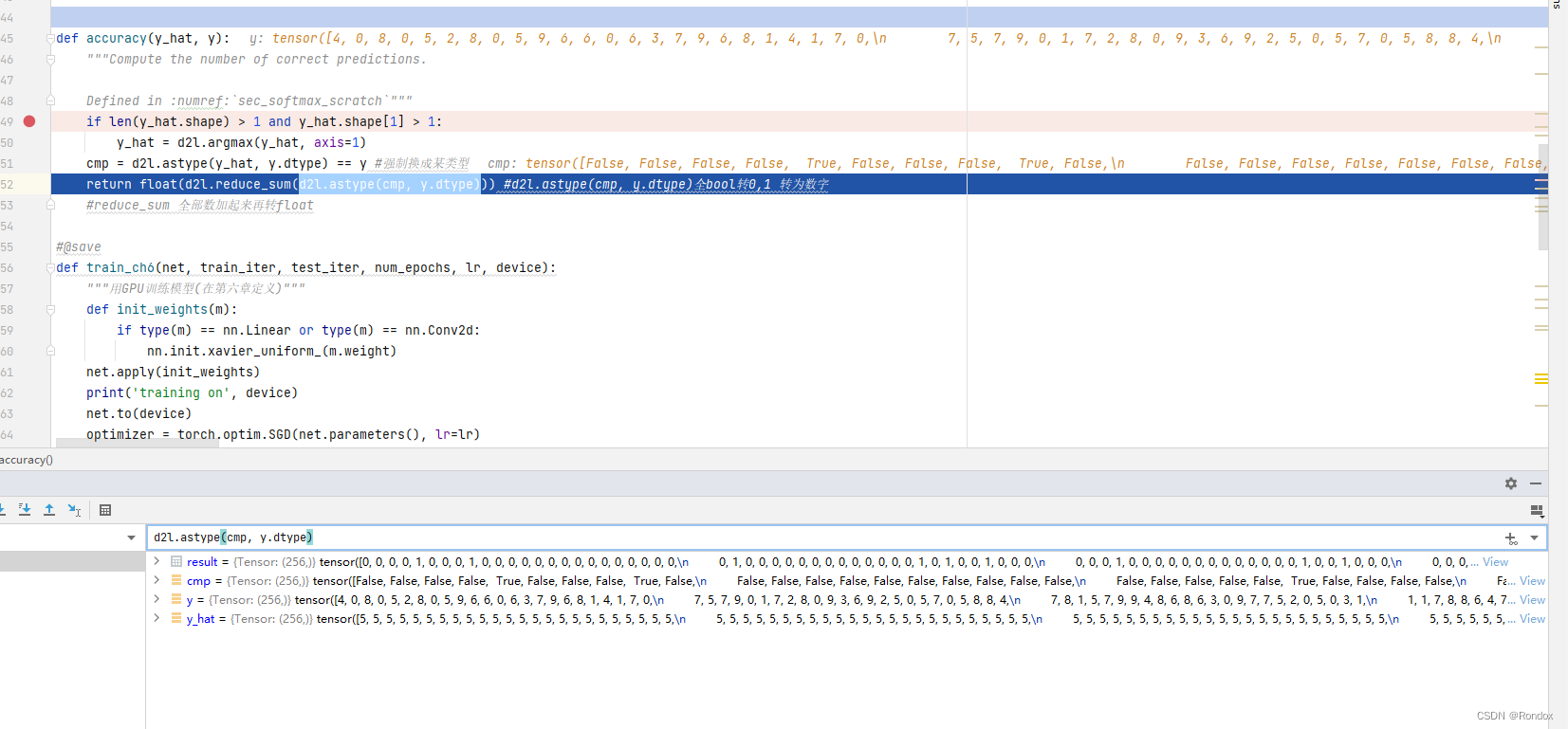

1.解析该accuracy函数:

看不懂的时候 把函数从源文件复制出来调试 方法d2l.那里删了

def accuracy(y_hat, y):

"""Compute the number of correct predictions.

Defined in :numref:`sec_softmax_scratch`"""

if len(y_hat.shape) > 1 and y_hat.shape[1] > 1:

y_hat = d2l.argmax(y_hat, axis=1)

cmp = d2l.astype(y_hat, y.dtype) == y #强制换成某类型

return float(d2l.reduce_sum(d2l.astype(cmp, y.dtype))) #d2l.astype(cmp, y.dtype)全bool转0,1 转为数字

#reduce_sum 全部数加起来再转float感觉有图能看懂了

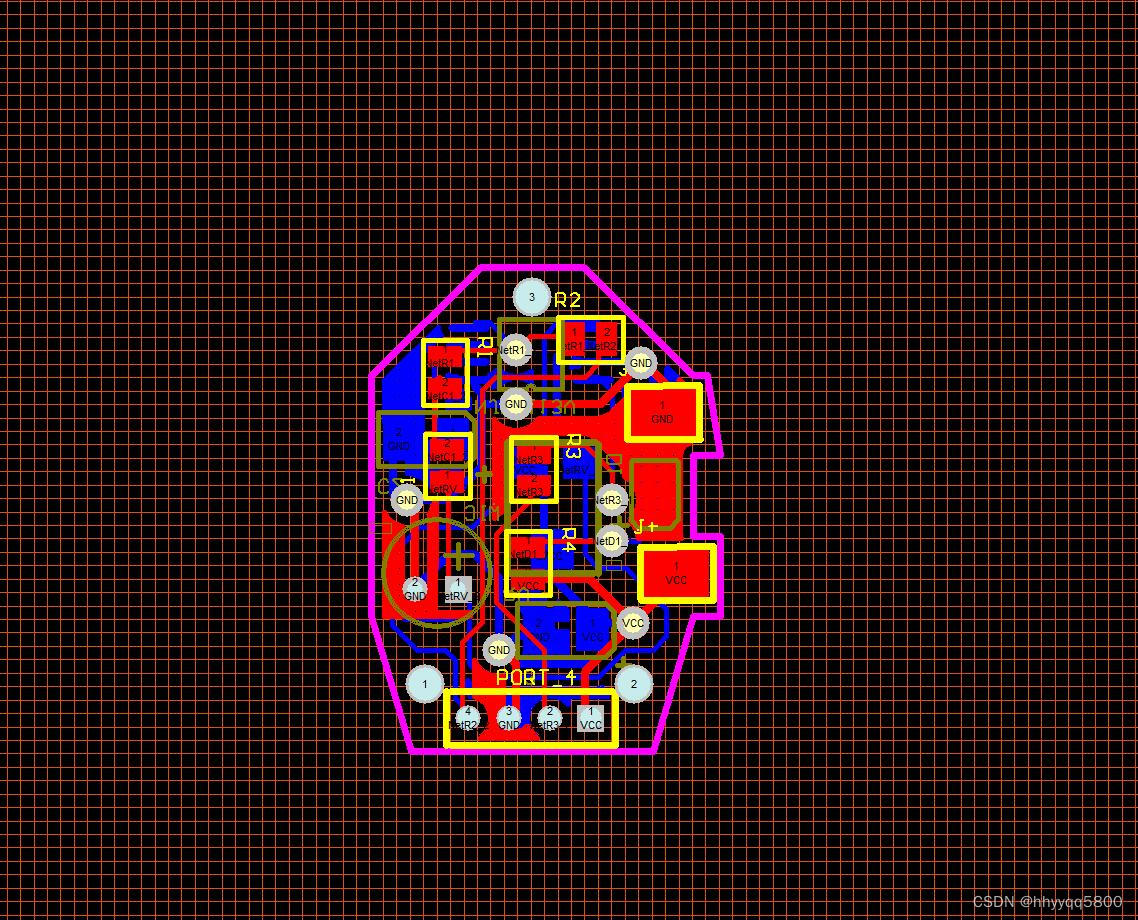

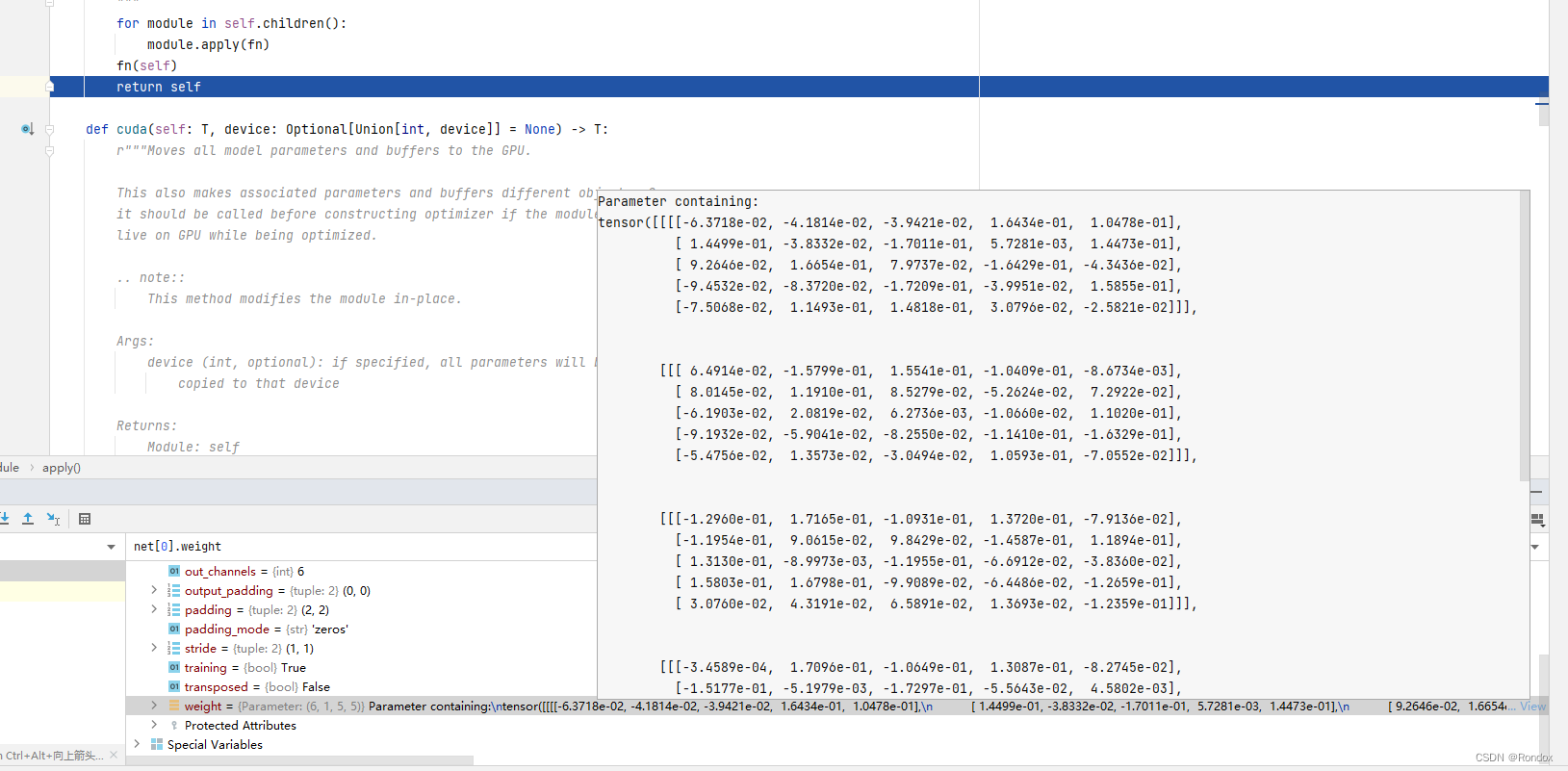

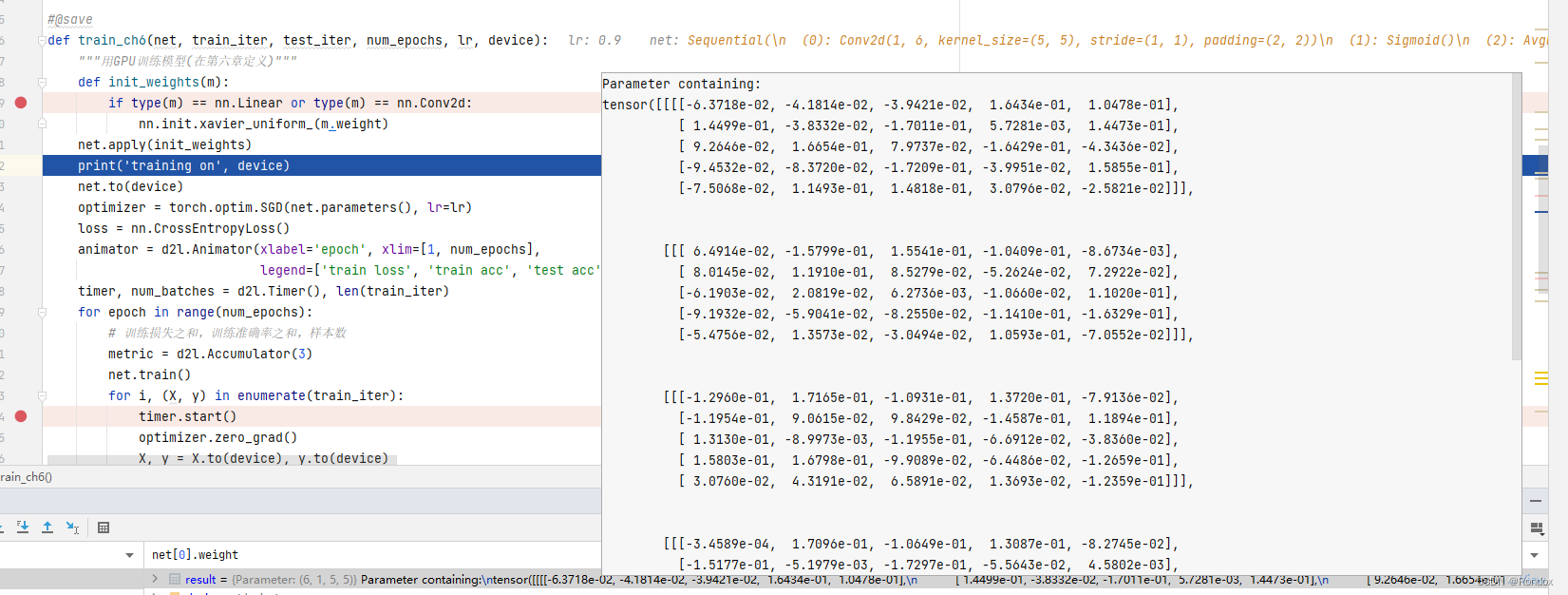

2.打点调试 查看卷积核的值学习过程 #net[0].weight net[3].weight

初始值:初始创建net的时候自动生成全部数据

初始化的时候init再打点

跳入初始化

跳入初始化

初始化跳回去之后发现

成功初始化为均值0 方差1的卷积核了

成功初始化为均值0 方差1的卷积核了

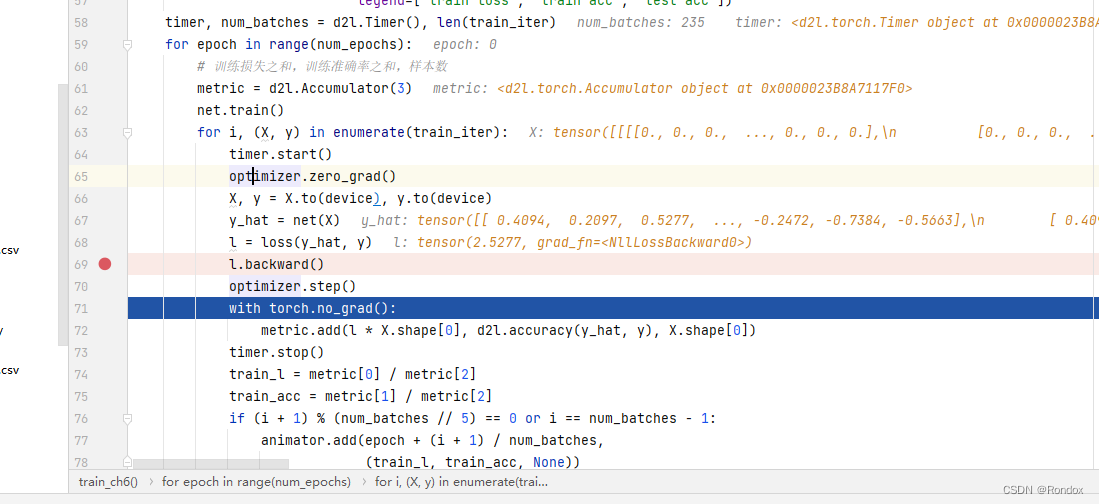

再接着跑epoch的时候调试爆了 不知道是因为cpu还是内存不够爆的 重新取消了其他断点,只点了一个

重新的一个数据 与上面的不一样

可以看出梯度更新卷积核的参数第一行第一个一看好像没变,看看第二行1198->1197 是变了