google提出的Wide&deep模型,将线性模型与DNN很好的结合起来,在提高模型泛化能力的同时,兼顾模型的记忆性。wide&deep这种将线性模型与DNN的并行连接模式,后来称为推荐领域的经典模式,奠定了后面深度学习模型的基础。这个是一个里程碑的改变。

单层的wide层善于处理大量的稀疏的id类特征,deep部分利用深层的特征交叉,挖掘在特征背后的数据模式。

目录

1.wide部分

2.Deep部分

3.Wide&Deep

编辑

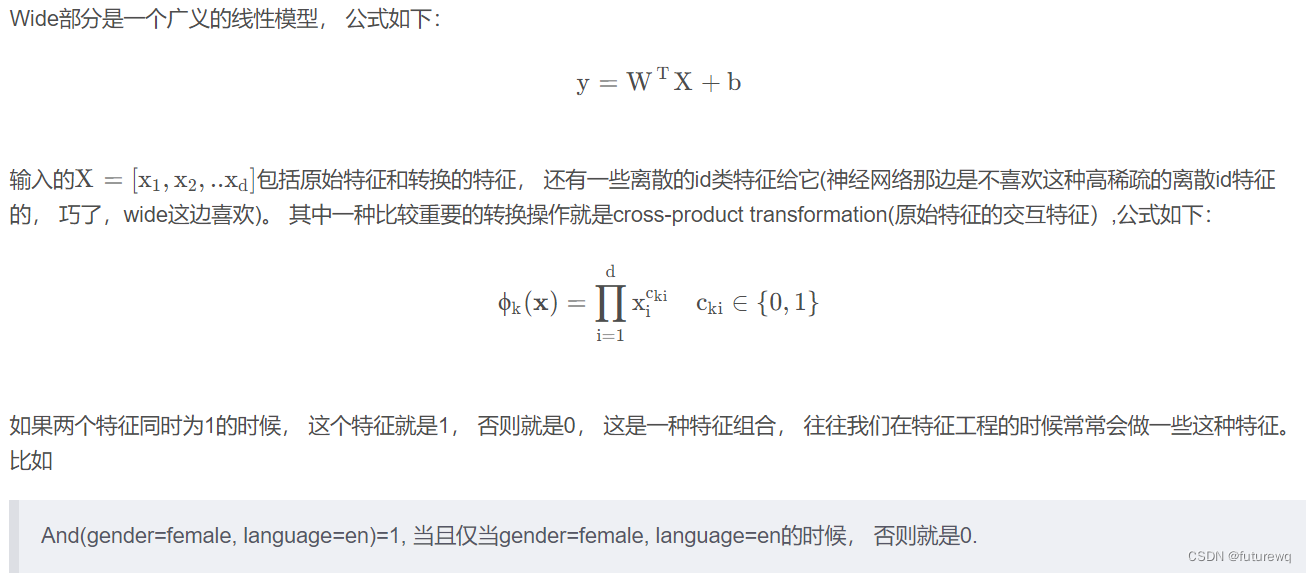

1.wide部分

wide部分训练的时候使用的优化器是带正则的FTRL算法(Follow-the-regularized-leader),FTRL可以理解为一个稀疏性很好,精度又不错的随机梯度下降方法,该算法是非常注重模型稀疏性质的,因为Wide部分的大部分参数都为0,这就大大压缩了模型权重及特征向量的维度。 Wide部分模型训练完之后留下来的特征都是非常重要的,那么模型的"记忆能力"就可以理解为发现"直接的",”暴力的“,”显然的“关联规则的能力。

因此wide部分使用FTRL算法原因是:

1.压缩模型权重,减少服务的时候存储要

2.来自工业上的经验,对模型的实时更新更加有利,能够在实时更新的时候,尽量的加大实时的那部分数据对于参数更新的相应速度,不至于用实时数据更新好久也没有更新动原来的大模型。

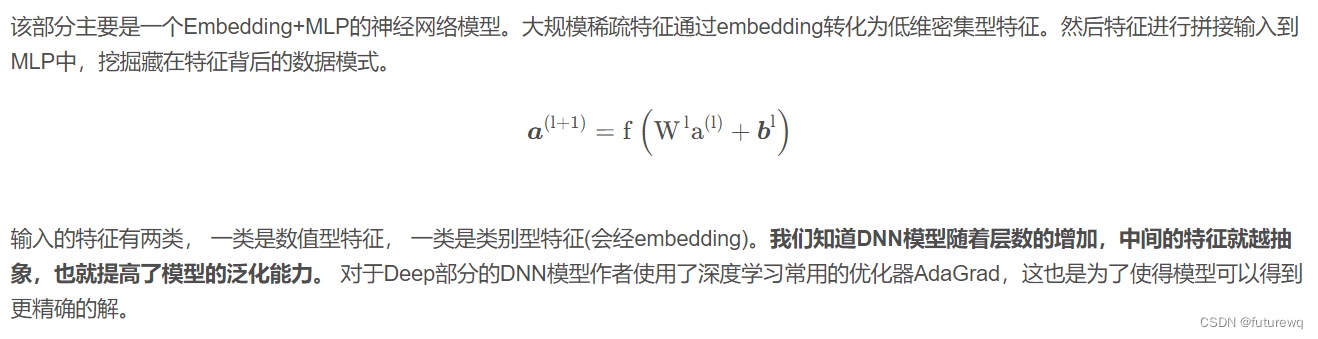

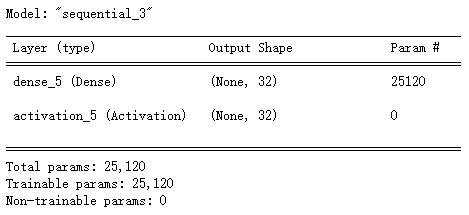

2.Deep部分

3.Wide&Deep

![[2]MyBatis+Spring+SpringMVC+SSM整合一套通关](https://img-blog.csdnimg.cn/8292acd91dab45c39860de2a3ceaddf6.png#pic_center)