1.TODO方向

(1)数据增强:finetuning阶段需要大量人工标注样本,消耗时间和成本。用户点击数据作为弱监督学习,可以尝试图网络构建节点和边(query聚合); 使用展现未点击生成对抗网络进行学习;

-

特定类型样本挖掘:通过设计一种基于Query和POI的特征和两者的匹配情况来刻画BadCase类型的方法,自动化从候选数据集中筛选出特定BadCase类型的样本进行送标。

-

用户点击过但线上旧版模型判定为不相关的:该方法可以挖掘出当前线上模型预测错误及语义接近的用户难以区分的难例。

-

边缘采样:通过边缘采样的方式挖掘具有较高不确定性的样本,如抽取模型预测得分在阈值附近的样本。

-

模型或人工识别困难的样本:用当前模型预测训练集,将模型预测结果与标注标签不一致的样本,及人工标注标签有冲突的样本类型重新送标。

-

对比学习:借鉴对比学习的思想,为一些高度匹配的样本生成对比样本进行数据增强,并进行人工标注确保样本标签的准确率。通过对比样本之间的差异,模型可以关注到真正有用的信息,同时提升对同义词的泛化能力,从而得到更好的效果。

(2)样本去噪:如,无意义的单词Q

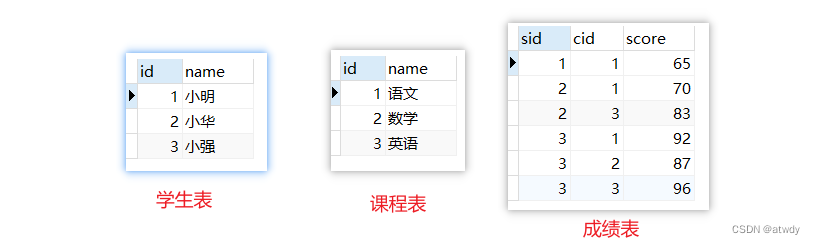

(3)负样本过滤:如果搜索词是品牌词,在选取负样本的时候只在其他品牌的样本中选取。如 POI 为“香格里拉实力希尔顿花园酒店”、“桔子香格里拉古城酒店”时,同 Query “香格里拉酒店”虽然字面很相似,但其明显不是用户想要的品牌。

(4)POI地域优化:如比亚迪 北京、比亚迪;这类有明确POI地域的不做映射,无地域标记的统一将比亚迪 山东、比亚迪 北京映射到比亚迪;

(5)自动摘要:OCR、TITLE、内容字符比较多的,通过自动摘要技术缩小数量

(6)知识融合:将品牌、商圈、团购、QRQ、RQR(评论区内容)信息引入到预训练模型;

(7)融合知识图谱信息对长尾流量相关性进行优化 :长尾流量的相关性优化需要依赖更多的高质量数据。我们将利用知识图谱信息,将一些结构化先验知识融入到 BERT 预训练中,对长尾 Query 的信息进行增强,使其可以更好地进行语义建模。

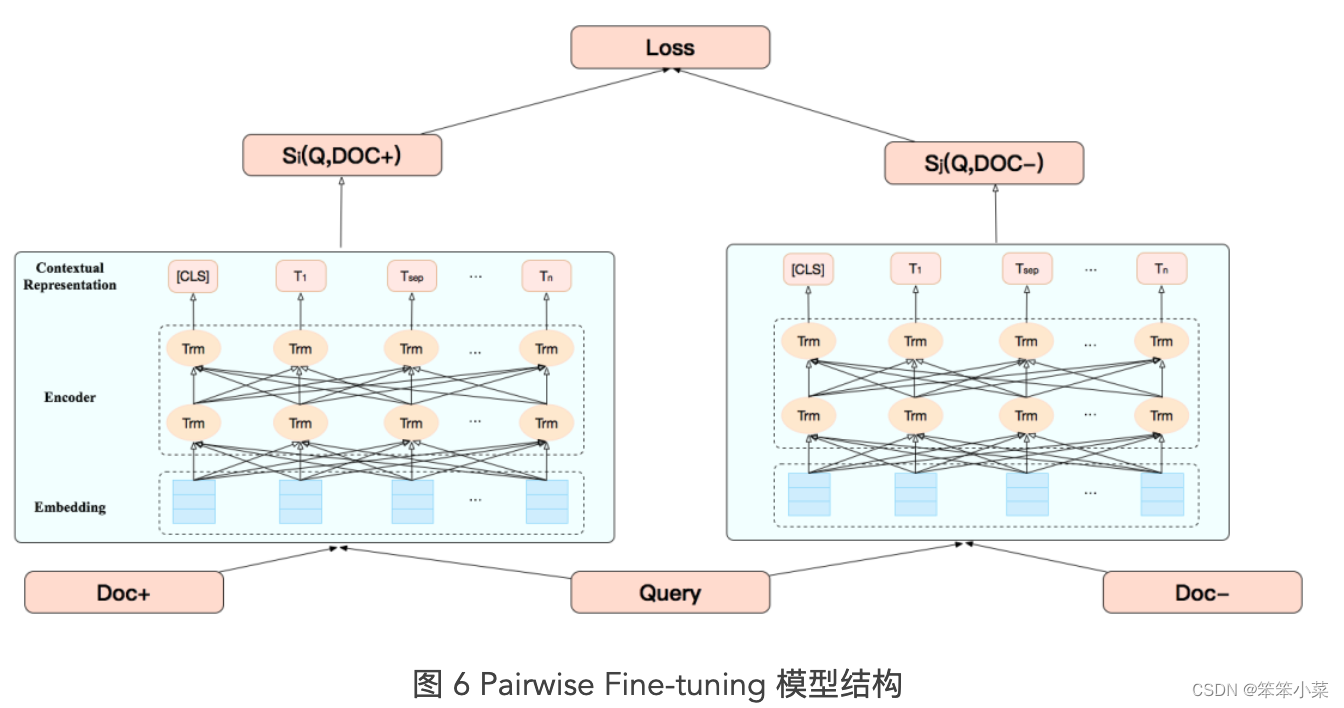

(8)pointwise、pairwise finetuning:将序关系引入到大规模模型中

(9)层次时序模型:STARDOM:语义感知深度层次时序预估模型

(10)相关性与其他任务联合优化 :美团搜索场景下 Query 和候选 Doc 都更结构化,除文本语义匹配外,Query/Doc 文本中蕴含的实体成分、意图、类目也可以用于辅助相关性判断。目前,我们将相关性任务和成分识别任务结合进行联合优化已经取得一定效果。后续我们考虑将意图识别、类目预测等任务加入相关性判断中,多视角、更全面地评估 Query-Doc 的相关性。

(11)BERT 相关性模型和排序模型的深入融合 :当前两个模型属于两阶段训练方式,将 BERT 语义相关性作为特征加入排序模型来提升点击率。语义相关性是影响搜索体验的重要因素之一,我们将 BERT 相关性和排序模型进行端到端联合训练,将相关性和点击率目标进行多目标联合优化,提升美团搜索排序的综合体验。

参考文献:

前沿重器[2] | 美团搜索理解和召回 - 知乎

KDD2022 | MUVCOG:多模态搜索会话下的用户意图刻画