【论文速递】Arxiv2018 - 加州伯克利大学借助引导网络实现快速、准确的小样本分割

【论文原文】:Few-Shot Segmentation Propagation with Guided Networks

【作者信息】:Kate Rakelly∗ Evan Shelhamer∗ Trevor Darrell Alexei Efros Sergey Levine

获取地址:https://arxiv.org/pdf/1806.07373

博主关键词: 小样本学习,语义分割,引导网络

推荐相关论文:

【论文精选】TPAMI2020 - PFENet_先验引导的特征富集网络_小样本语义分割

- https://phoenixash.blog.csdn.net/article/details/128720119

摘要:

基于学习的视觉分割方法已经在特定类型的分割任务上取得了进展,但受到必要的监督、固定任务的狭隘定义以及在纠正错误的推理过程中缺乏控制的限制。为了弥补标准方法的刚性和注释负担,我们解决了小样本分割的问题:给定少量图像和少量像素监督,相应地分割任何图像。我们提出了引导网络,它从任意数量的监督中提取潜在的任务表示,并优化我们的端到端架构,以实现快速、准确的小样本分割。 我们的方法可以在没有进一步优化的情况下切换任务,并在得到更多指导时快速更新。我们报告了从每个概念一个像素分割的第一个结果,并展示了实时交互式视频分割。我们的统一方法跨空间传播像素注释以进行交互式分割,跨时间传播像素注释以进行视频分割,跨场景传播像素注释以进行语义分割。我们的引导分割器在注释量和时间的准确性方面是最先进的。有关代码、模型和更多细节,请参阅http://github.com/shelhamer/revolver。

简介:

学习特定类型的分割,甚至将现有模型扩展到新任务(如新的语义类),通常需要收集和注释大量数据,并(重新)训练模型进行多次迭代。目前的方法是由数千或数万个完全注释的图像来监督的,这样即使是一个“小”数据集也包含数十亿个像素级注释。收集这些密集的注释非常耗时、乏味且容易出错。有许多具有实际和科学意义的任务,在这种规模上的注释是不切实际的,甚至是不可行的,例如平面设计、医学成像等等。

半监督和弱监督分割方法可以跨任务中的输入传播注释(整个视频中的实例分割)或跨不同类型的注释(标签、框和掩码),但目前的方法是特定于任务或监督形式的,并且通常在计算或数据方面效率低下。一旦学会,这些方法很难指导或纠正,并且对少量的进一步注释不敏感。另一方面,交互式分割方法调整到给定的任务很少注释,并可以校正。然而,注释只控制对同一图像的推断,不能通知分割新的输入。

相反,我们解决了小样本分割的问题:只给出一些带有稀疏像素级注释的图像来指示任务,相应地分割没有注释的图像。我们统一的框架是“像素输入,像素输出”,用于从图像内部和跨图像传播任何像素注释集合到未注释的像素进行推断。我们直接优化引导网络来推断由稀疏注释定义的潜在任务,并分割以该任务为条件的新输入。 我们的小样本分段器从每个概念的一个像素中分割出新的概念,并在几乎瞬间结合进一步的注释来更新和改进推理。现有的方法是为特定的分割任务而设计的,在极其稀疏的区域失败,而我们的方法可以在光谱上从一个注释的像素传播到完整、密集的掩模。我们的小样本分割器在根据注释进行切换时是任务不可知的,在从少数像素级注释中学习数据时是高效的,并且在逐步纳入更多监督时是可纠正的。

小样本设置将输入分为一个带注释的支持(监督要完成的任务)和一个应相应地进行分段的无注释查询。在这项工作中,我们解决了小样本分割问题的这些关键部分:(1)如何将稀疏的、结构化的支持总结为任务表示,(2)如何在给定的任务表示上调整像素推理,以及(3)如何综合分割任务的准确性和一般性。结构化输出由于其高维、统计依赖和倾斜的输入和输出分布,对这些方面都提出了挑战。 我们在图像分类设置中连接小样本方法,因为我们使它们适应于分割,以便与我们的方法进行比较。

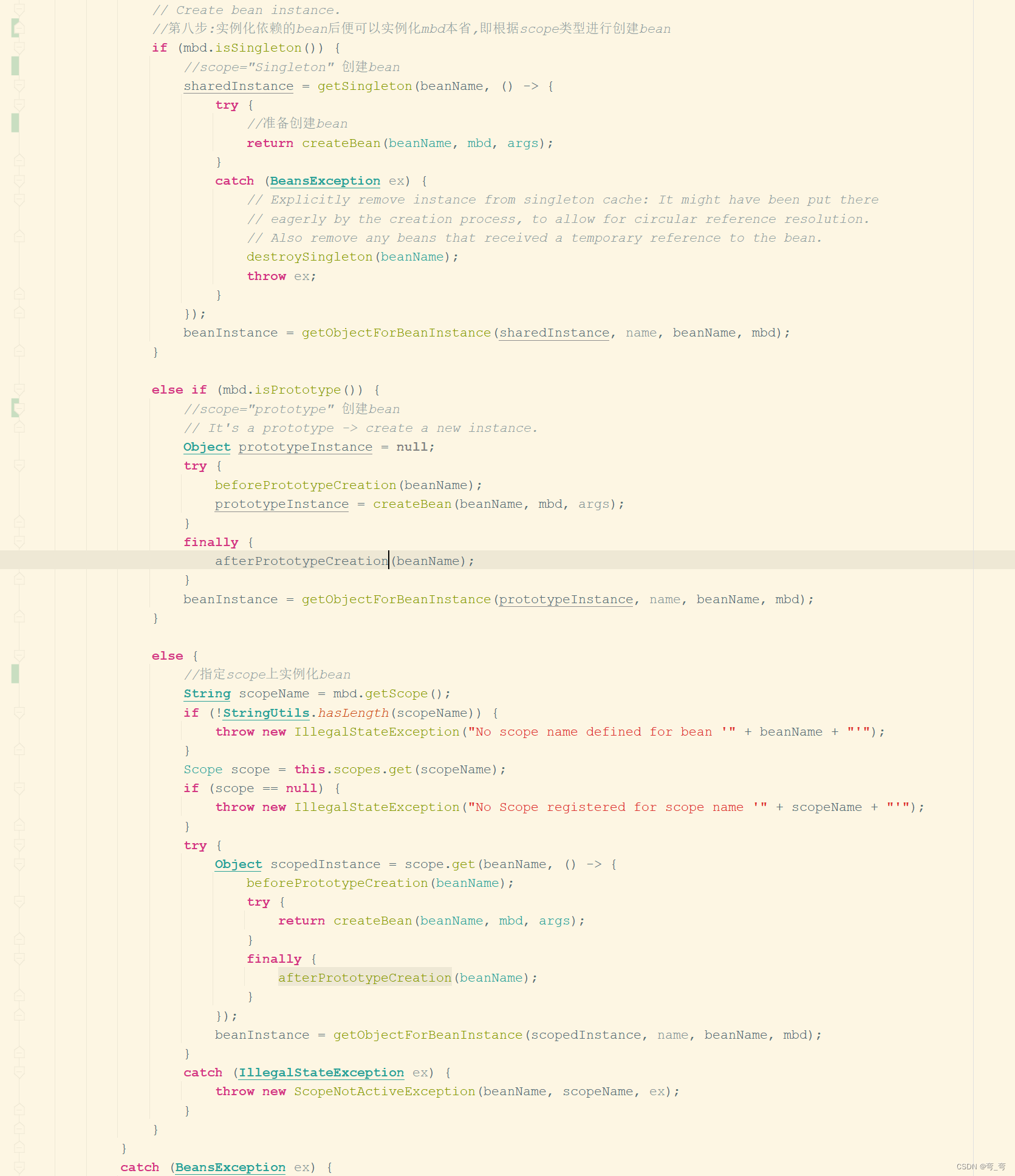

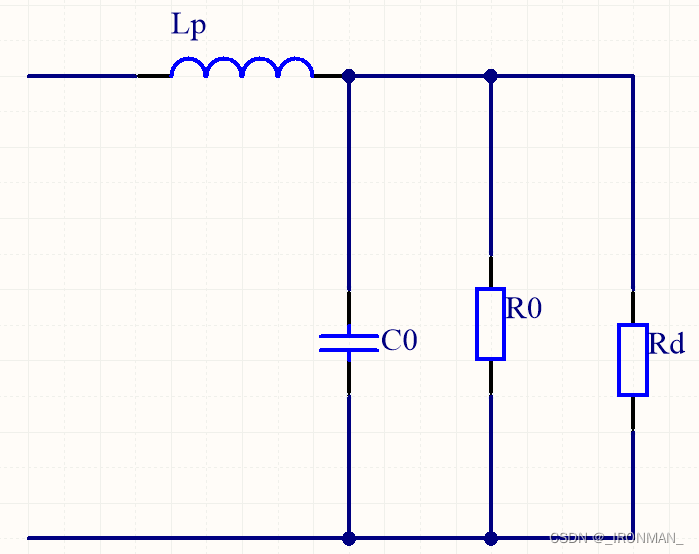

我们提出了一类新的引导网络,它扩展了小样本和全卷积架构;参见图1。给定一个标注的支持集和查询图像,引导g提取任务的潜在表示z,它通过fθ指导查询的分割。 我们对如何编码支持进行了全面的比较(第4.1节),并引入了一种用于融合图像和注释的新机制,该机制提高了学习时间和推理精度。我们研究了不同的引导推理选择(第4.2节),以确定哪个最适合结构化输出。一旦经过训练,我们的模型就不需要进一步的优化来处理新的少量任务,并且可以快速增量地合并额外的注释来改变任务或纠正错误。

我们在各种具有挑战性的分割问题上评估了我们的方法:5.1中的交互式图像分割,5.2中的语义分割,5.3中的视频对象分割和5.4中的实时交互式视频分割。图2说明了我们所考虑的问题。我们的结果的重点是在稀疏区域,对于这种情况,收集注释是实用的。在所有情况下,我们的准确性都是最先进的注释量和所需的时间。我们的方法合并新注释的速度使它适合实时交互使用。