#论文笔记#

1. 论文信息

| 论文名称 | Clean-Label Backdoor Attacks |

|---|---|

| 作者 | Alexander Turner(MIT) |

| 会议/出版社 | ICLR 2019 |

| 本地pdf 在线pdf | |

| 代码 | trojanzoo-clean-label**** Label-Consistent |

| 其他 | 这篇文章和 Label-Consistent Backdoor Attacks 基本相同 |

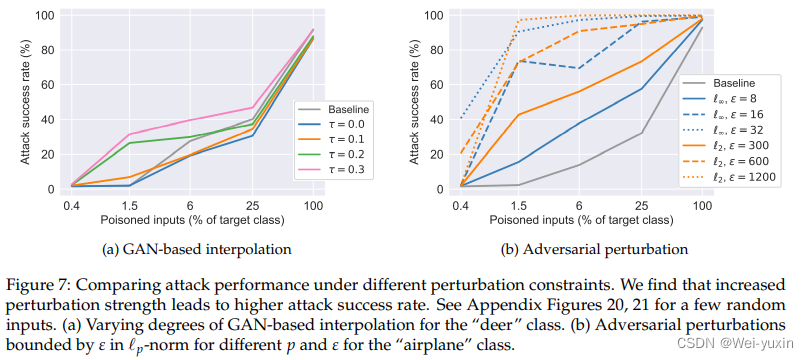

简介:这篇文章是最早做干净标签下的后门攻击的文章。作者在 BadNets 上进行了一系列的实验证明在以往的方法中直接使用 clean-label 会导致攻击的失败。为了实现在 clean-label 下的攻击,作者使用了 GAN-based interpolation 和 adversarial p-bounded perturbations 来增加分类器的训练难度,让分类器学习到更多 backdoor 的信息。

2. introduction

以往的后门攻击方法是在数据上加入 backdoor trigger,并且更改该数据的标签。这种做法存在的问题是,通过人工检查可以轻易识别出异常的标签。所以本文提出了一种无需改变加毒数据集即可实现后门攻击的方法,称之为 clean-label attack。

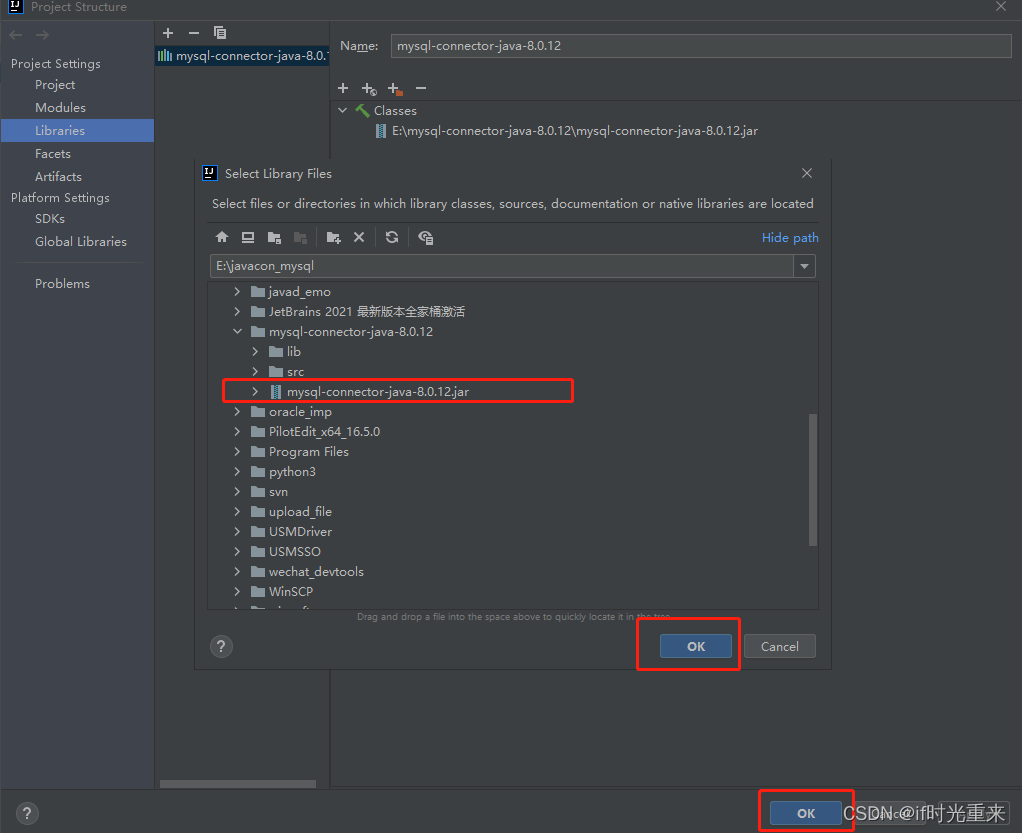

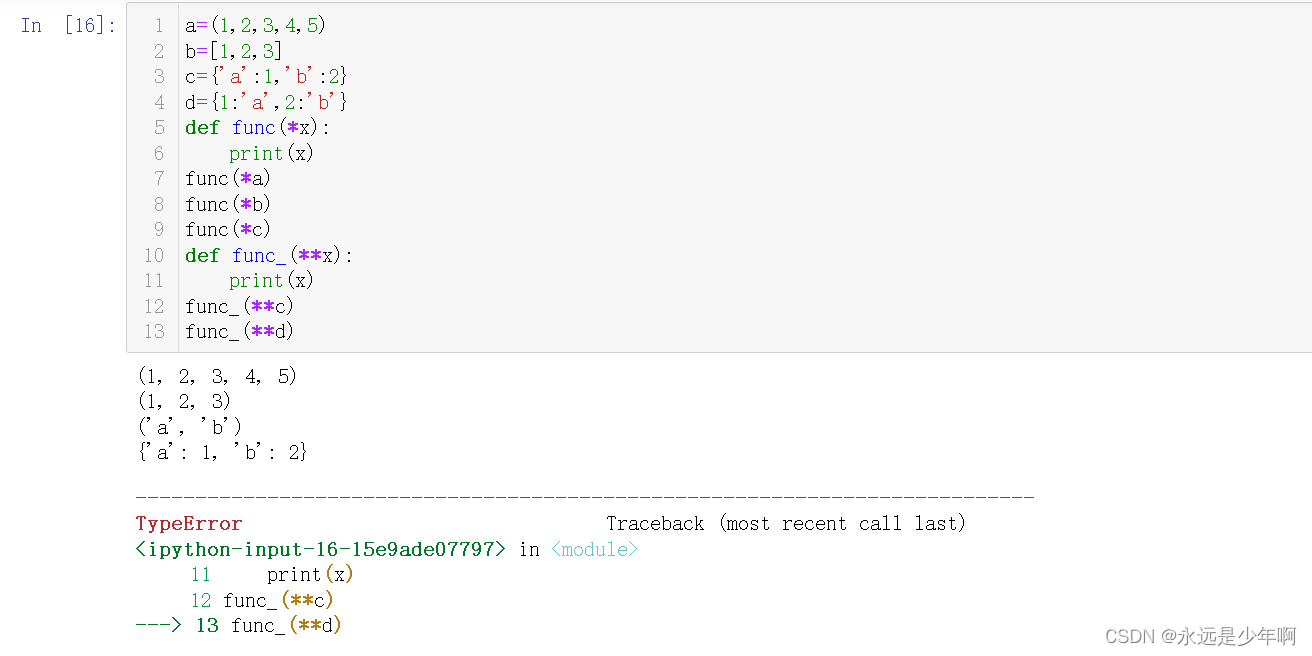

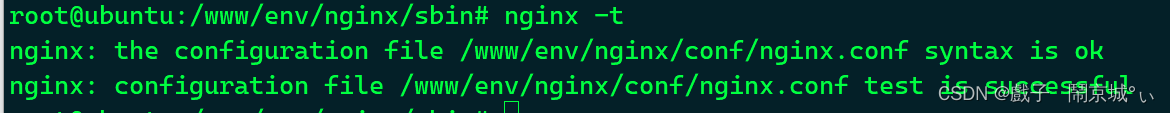

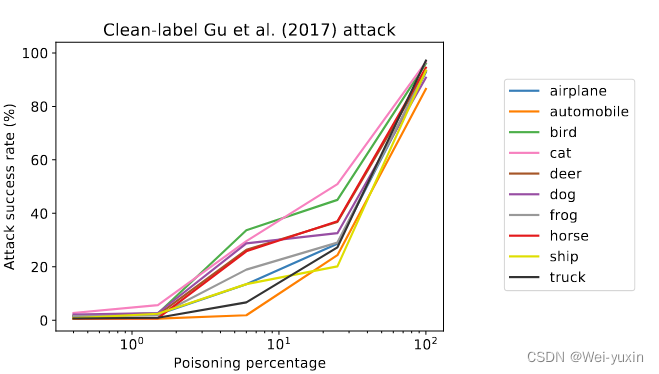

因为是进行 target attack,最简单的想法就是在 target 类中加入 backdoor trigger。但是作者目标类中加入 badnet 的 backdoor trigger 进行实验。发现这种进攻是无效的。

- 由上图可以看出,当 Posion rate 达到 25% 时也只有 50% 的攻击成功率

- 本文选择的 trigger 是来源于 badnet 的攻击方法

这是因为模型在学习时,只有一小部分图像存在 trigger ,并且模型更倾向于学习图片中的自然特征,所以 trigger 很容易被忽略。无法与 target label 建立起强的关联。

这篇文章为了解决这个问题,提了要让模型学习目标类的特征更加困难,使得模型学习目标类时更加依赖于 trigger,使得 trigger 更容易与 target label 关联。

文章提出了两种方法,第一种是基于 GAN 的方法,一种是基于 Adversarial examples 的方法

3. method

方法一:Latent space interpolation using GANs

通过生成模型去生成一些带有噪声目标类的样本,增大目标类的学习难度。

首先在训练集上训练一个生成器,生成模型可以学习到样本分布的 latent space

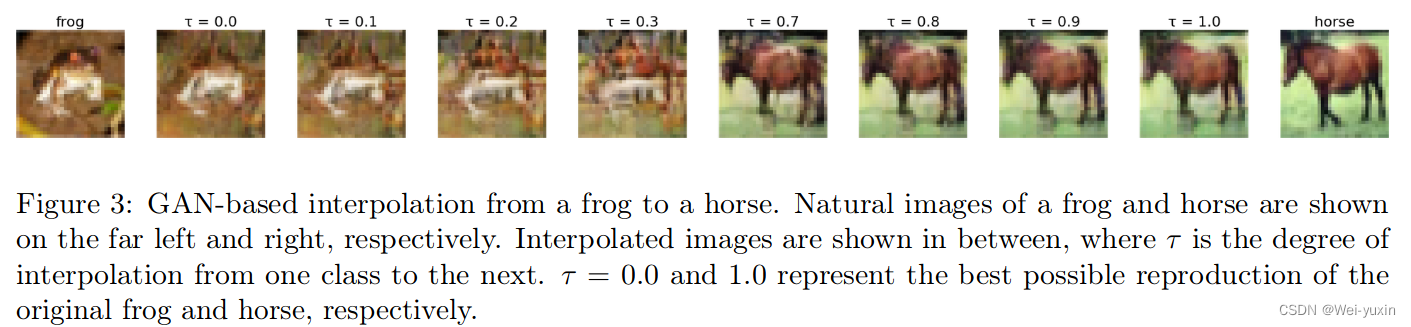

选取目标类 x 1 x_1 x1 , 非目标类 x 2 x_2 x2,通过插值的方法生成带有噪声的目标类图片

I G ( x 1 , x 2 , τ ) = G ( τ z 1 + ( 1 − τ ) z 2 ) , I_{G}\left(x_{1}, x_{2}, \tau\right)=G\left(\tau z_{1}+(1-\tau) z_{2}\right), \quad IG(x1,x2,τ)=G(τz1+(1−τ)z2), where z 1 = E G ( x 1 ) , z 2 = E G ( x 2 ) z_{1}=E_{G}\left(x_{1}\right), z_{2}=E_{G}\left(x_{2}\right) z1=EG(x1),z2=EG(x2).

通过实验得出 τ \tau τ 的最佳值,既能让目标类难以学习,又能让人眼难以察觉

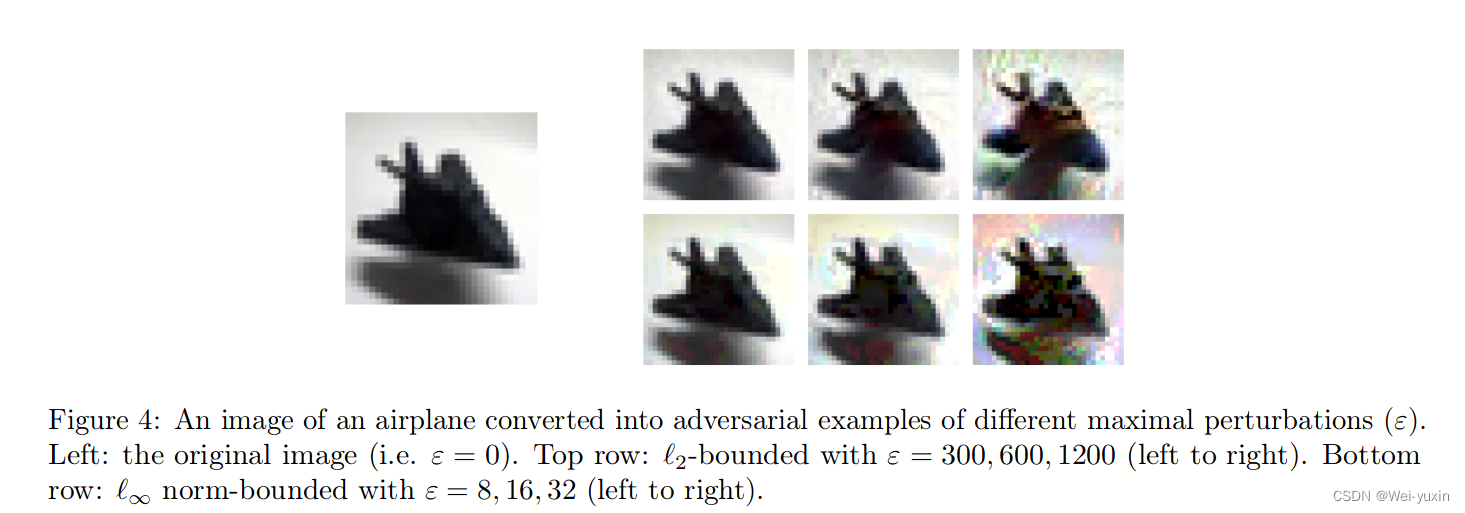

方法二:Adversarial examples bounded in lp-norm

最大化目标类样本和目标类标签,优化对抗扰动。使得目标类更难学习

x a d v = argmax ∥ x ′ − x ∥ p ≤ ϵ ( x ′ , y , θ ) x_{a d v}=\underset{\left\|x^{\prime}-x\right\|_{p} \leq \epsilon}{\operatorname{argmax}}\left(x^{\prime}, y, \theta\right) xadv=∥x′−x∥p≤ϵargmax(x′,y,θ)

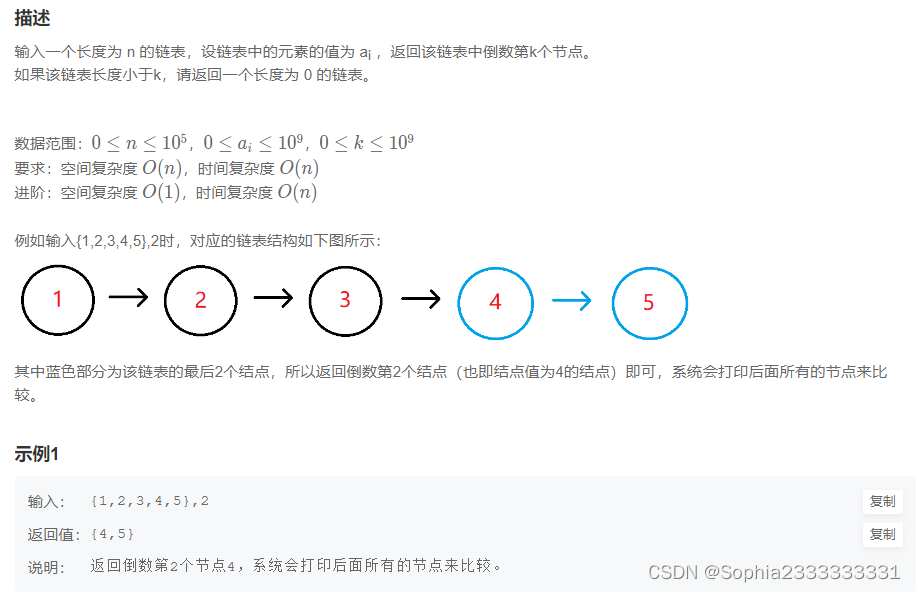

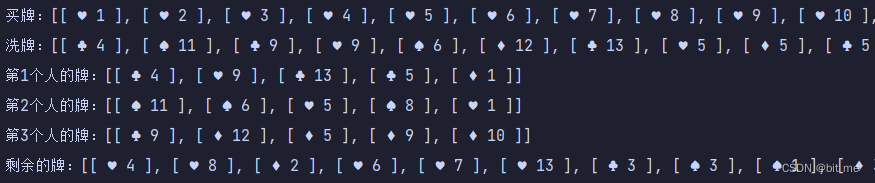

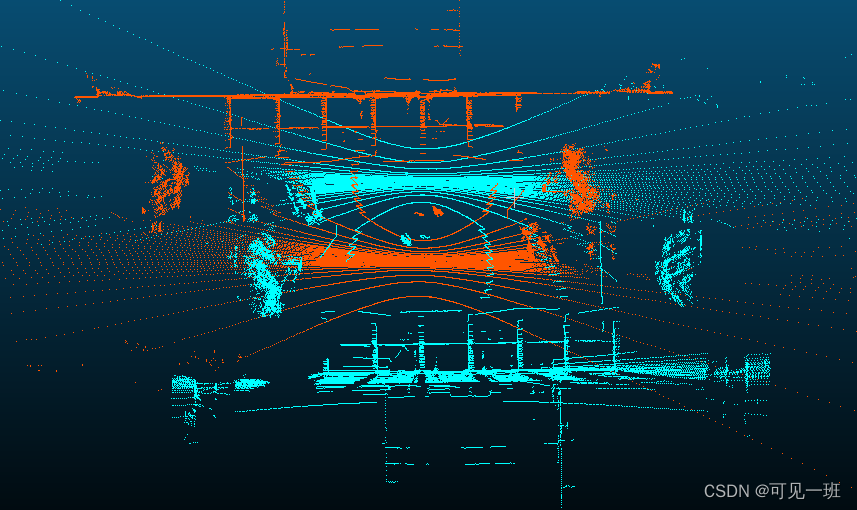

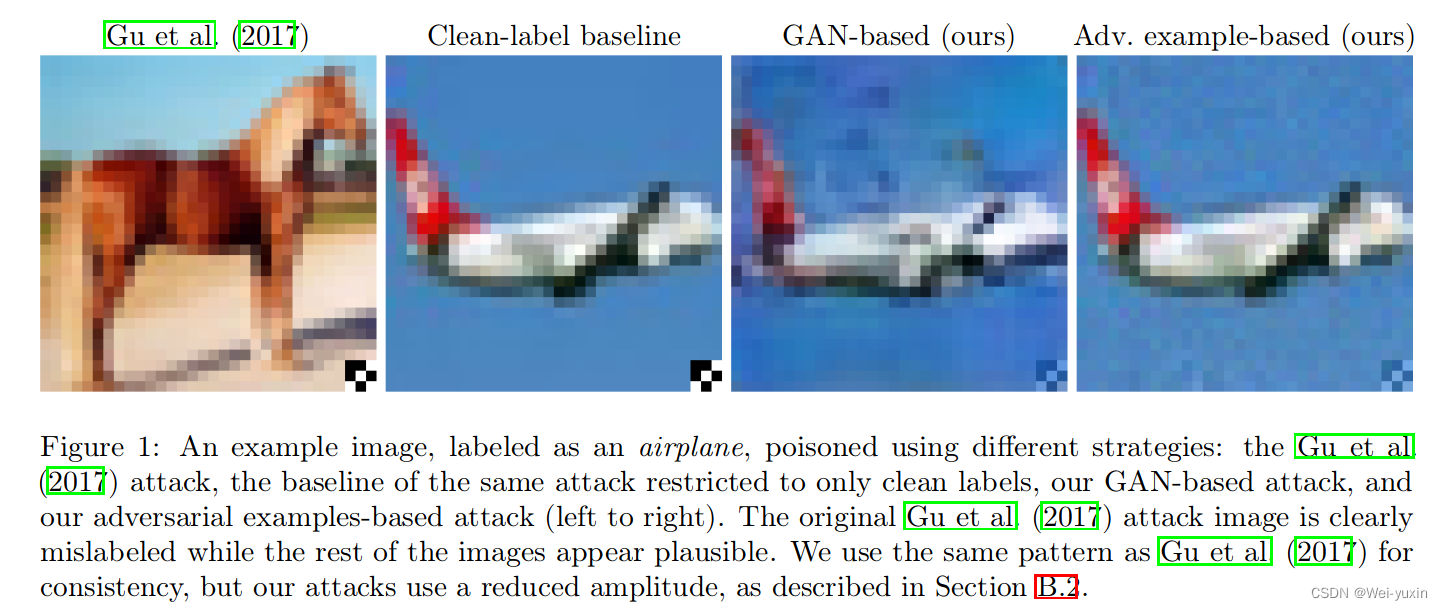

不同情况下的 backdoor image 的视觉效果对比

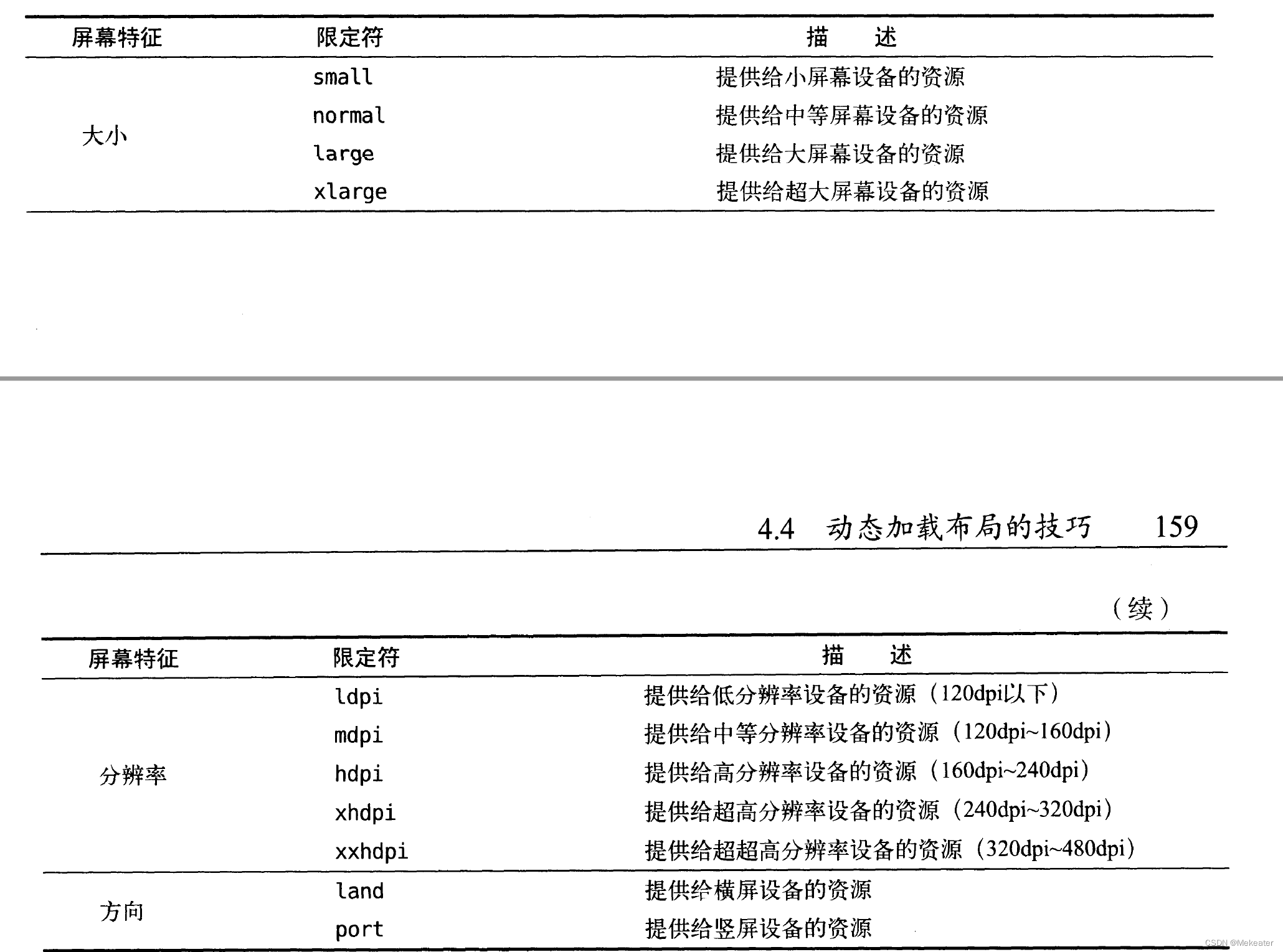

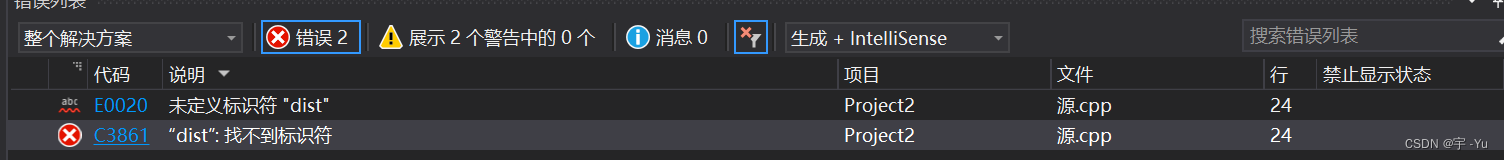

4. experiments

- 数据集:cifar-10

- 实验结果: