一、引言:当 AI 遇到工具孤岛

在企业数字化转型的浪潮中,AI 工具的应用早已从单一的对话交互进阶到复杂的业务流程自动化。但开发者常常面临这样的困境:本地开发的 MCP 工具(如 ERP 数据清洗脚本、CRM 工单系统 API)如同信息孤岛,难以与主流 SaaS 应用协同工作。例如,订单系统需要将数据同步至库存管理平台、客服对话记录需要自动录入数据分析工具,这些跨系统数据流转往往需要编写大量适配代码,耗时耗力。

Zapier 作为全球最大的自动化平台,集成了 7000 + 应用(如 Salesforce、HubSpot、MySQL 等),提供超过 30 万种数据操作 (Action),但传统接入方式需要复杂的 API 对接。Dify 最新推出的 MCP SSE 插件,通过 Server-Sent Events 技术实现了与 Zapier 的无缝连接,让 AI 模型无需复杂开发即可构建企业级数据自动化枢纽。本文将通过两个企业级实战案例(ERP-CRM 数据同步、数据库自动化分析),手把手教你搭建跨系统数据流转管道。

二、技术准备:核心概念与工具链

1. 关键技术解析

MCP 协议(Model Context Protocol):定义 AI 与工具的交互规范,支持工具发现、参数校验、结果解析,尤其适合企业自有系统的标准化封装。

SSE(Server-Sent Events):长连接技术实现服务器主动推送数据,适用于实时数据流处理(如订单实时同步、日志实时监控)。

Zapier MCP Server:将 Zapier 生态封装为统一端点,支持 OAuth2.0 认证和企业级安全策略,可无缝接入 Salesforce、MySQL 等系统。

2. 企业级工具链准备

Dify 平台:注册企业版账号,开通自定义插件管理和工作流编排功能。

Zapier 账号:升级至 Team Plan,支持创建多个 MCP Server 和高级权限控制。

企业系统:准备 ERP(如 SAP)、CRM(如 Salesforce)、数据库(MySQL/PostgreSQL)的管理员账号。

辅助工具:Postman(调试 API)、DataGrip(数据库管理)、JSON Validator(参数校验)。

三、实战案例一:ERP 到 CRM 数据自动化同步(SAP+Salesforce)

场景描述

当 ERP 系统生成新订单时,AI 助手自动提取关键信息(订单号、客户 ID、金额),同步至 CRM 创建客户跟进记录,并触发数据分析工具生成销售日报。

步骤 1:封装 ERP 数据提取工具(MCP Server 配置)

1.1 生成 Zapier MCP Server URL

登录 Zapier 企业后台,进入「MCP Settings」:https://actions.zapier.com/settings/mcp/

点击「Generate URL」创建专属端点,启用企业级加密(TLS 1.3)和 IP 白名单(添加 Dify 服务器 IP)。

1.2 添加 SAP 订单读取 Action

在 Zapier 中搜索「SAP: Read Order」(需先安装 SAP 连接器),授权连接企业 SAP 系统。

配置参数:

Order Number Pattern:设置正则表达式^SO-\d{6}$(匹配销售订单)

Fields to Extract:勾选OrderID, CustomerID, OrderAmount, CreationDate

测试连接:输入测试订单号,验证返回 JSON 结构是否正确:

{

"OrderID": "SO-202504001",

"CustomerID": "CUST-12345",

"OrderAmount": 1500.99,

"CreationDate": "2025-04-23T14:30:00+08:00"

}

步骤 2:配置 CRM 数据写入工具(Salesforce Create Lead)

返回 Zapier MCP Actions,添加「Salesforce: Create Lead」Action。

授权连接企业 Salesforce 账号,映射 ERP 字段到 CRM 字段:

CustomerID → Company(客户编号)

OrderAmount → AnnualRevenue(年度营收)

自动生成LeadSource为「ERP Auto-Sync」

启用字段校验:确保CustomerID不为空,OrderAmount>0,否则触发错误回调。

步骤 3:Dify 工作流编排

创建「ERP-CRM 同步 Agent」,在插件市场安装「MCP_SSE」并配置 Server:

{

"erp\_crm\_server": {

"url": "https://actions.zapier.com/mcp/sk-enterprise-xxx/sse",

"headers": {"X-Enterprise-Token": "内部认证令牌"},

"timeout": 120, # 长耗时操作增加超时时间

"sse\_read\_timeout": 600

}

}

配置提示词(触发数据同步逻辑):

当检测到ERP订单创建事件时,优先调用SAP: Read Order工具获取原始数据,再使用Salesforce: Create Lead工具写入CRM。数据映射规则:客户编号=Company,订单金额=AnnualRevenue。

添加「数据清洗」预处理步骤:

使用 Dify 内置「JSON 处理工具」转换 ERP 时间格式(从 SAP 的YYYYMMDDHHMMSS转为 ISO 8601)

对金额字段进行四舍五入(保留 2 位小数)

步骤 4:自动化测试与监控

在 SAP 中创建测试订单,触发 Dify Agent 监听:

Agent 自动调用mcp_sse_list_tools发现可用工具

解析订单数据后调用Salesforce: Create Lead,返回 Lead ID: 00Q123456789

验证 Salesforce 记录:

检查「Company」字段是否为CUST-12345

「AnnualRevenue」是否正确显示1500.99

「Created Date」是否与 ERP 订单时间一致

配置 Zapier Webhook 监控:接收 Dify 返回的同步状态,异常时发送 Slack 警报。

四、实战案例二:数据库自动化分析流水线(MySQL+Tableau)

场景描述

当用户要求分析上周销售额 Top10 的产品时,AI 助手自动从 MySQL 提取数据,清洗后同步至 Tableau 生成可视化报表,并通过企业微信通知负责人。

步骤 1:搭建数据库查询工具(MySQL Query)

在 Zapier 中添加「MySQL: Run Query」Action,配置企业数据库连接:

主机:db.internal.com,端口:3306,数据库:sales_db

认证:使用 SSL 证书 + 用户名密码双重验证

定义动态查询模板:

SELECT product\_id, product\_name, SUM(amount) AS total\_sales

FROM order\_records

WHERE create\_time >= '{{start\_date}}' AND create\_time < '{{end\_date}}'

GROUP BY product\_id

ORDER BY total\_sales DESC

LIMIT 10;

start_date和end_date由 AI 根据用户输入解析(如「上周」转换为2025-04-16至2025-04-22)

步骤 2:配置 Tableau 报表生成

添加「Tableau: Create Datasource」Action,授权连接企业 Tableau 账号。

定义数据映射规则:

MySQL 查询结果中的product_id → Tableau 维度「产品 ID」

total_sales → 度量「总销售额」

启用自动刷新:设置报表每 15 分钟从 Dify 获取最新数据。

步骤 3:Dify Agent 深度配置

集成「时间解析工具」和「SQL 注入防护」:

使用rookie_text2data工具将自然语言时间(如「最近 30 天」)转换为 ISO 日期格式

在提示词中添加安全规则:禁止查询user_password等敏感字段,输入参数需通过正则校验

构建多步工作流:

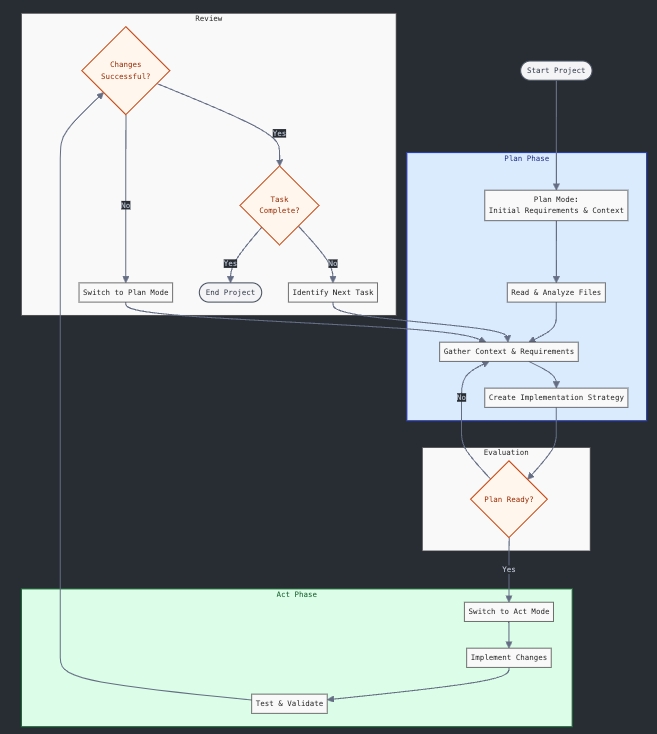

graph TD

A[用户输入分析请求] --> B[时间解析工具提取时间范围]

B --> C[调用MySQL: Run Query获取数据]

C --> D[JSON处理工具清洗数据(去除NULL值)]

D --> E[调用Tableau: Create Datasource生成报表]

E --> F[企业微信工具发送通知]

配置提示词(包含复杂参数拼接):

当用户需要分析销售数据时,首先使用时间解析工具确定时间范围,然后拼接MySQL查询语句。查询结果需经过清洗(删除缺失值行),再用于创建Tableau报表。最终通过企业微信发送报表链接给指定负责人。

步骤 4:压力测试与优化

模拟 1000 条订单数据,测试查询性能:

单次查询耗时控制在 80 秒内(通过 Zapier Connection Optimizer 优化数据库连接池)

数据清洗效率提升 30%(使用并行处理插件langgenius/json_process)

验证 Tableau 报表:

确认图表横轴为「产品名称」,纵轴为「总销售额」

检查 Top10 产品是否与 MySQL 查询结果一致

企业微信通知包含报表链接和生成时间戳

五、进阶技巧:构建企业级数据中枢

1. 跨系统数据映射引擎

在 Dify 中创建「数据映射知识库」,存储各系统字段对应关系(如 ERP→CRM→数据分析工具):

{

"ERP\_CRM\_MAPPING": {

"OrderID": "CRM\_Order\_Number",

"CustomerID": "CRM\_Account\_ID",

"OrderAmount": {

"target\_field": "CRM\_Sales\_Amount",

"conversion": "乘以汇率(1USD=6.8CNY)"

}

}

}

AI 可根据知识库自动完成跨系统数据转换,避免手动编写映射代码。

2. 批量数据处理优化

针对百万级数据同步需求,启用 Zapier 的 Batched Actions 和 Dify 的分页处理:

\# 伪代码:分页查询MySQL数据

page\_size = 1000

for page in 1 to total\_pages:

params = {

"query": f"SELECT \* FROM large\_table LIMIT {page\_size} OFFSET {(page-1)\*page\_size}",

"server\_name": "db\_server"

}

data\_chunk = call\_mcp\_tool("MySQL: Run Query", params)

process\_chunk(data\_chunk)

3. 数据质量监控体系

在 Dify 中添加「数据校验工具链」:

格式校验:使用shanjijian/json_extractor检查必填字段是否存在

逻辑校验:通过提示词规则确保数值字段 > 0,邮箱字段包含 @符号

异常回调:当连续 3 次校验失败时,自动触发人工审核流程(调用企业 OA 系统创建工单)

4. 多环境隔离配置

针对开发、测试、生产环境,使用不同的 MCP Server 配置:

{

"dev\_server": {

"url": "开发环境Zapier URL",

"headers": {"Environment": "DEV"},

"timeout": 60

},

"prod\_server": {

"url": "生产环境Zapier URL",

"headers": {"Environment": "PROD", "Auth-Token": "xxx"},

"timeout": 180,

"sse\_read\_timeout": 900

}

}

六、常见问题与解决方案(企业级场景)

| 问题现象 | 可能原因 | 解决方法 |

|---|---|---|

| 跨系统时间格式不一致 | 各系统时间戳标准不同 | 使用 Dify「时间标准化工具」统一转换为 ISO 8601 格式 |

| 大数据量同步超时 | Zapier 默认超时时间不足 | 在 MCP 配置中增加sse_read_timeout至 900 秒,启用数据分片传输 |

| 敏感数据泄露风险 | 未启用传输加密或权限控制 | 强制使用 TLS 1.3 加密,在 Zapier 中配置 IP 白名单和角色权限(RBAC) |

| 工具返回非结构化数据 | MCP 协议解析错误 | 添加「JSON 修复工具」预处理返回结果,使用ivan97/repair_json修复损坏的 JSON |

| 跨数据库事务不一致 | 缺乏分布式事务支持 | 在 Dify 工作流中添加补偿机制(如数据同步失败时自动回滚前序操作) |

七、总结:重构企业数据自动化架构

通过 Dify 与 Zapier 的深度整合,企业无需依赖传统 ETL 工具或定制开发,即可快速构建跨系统数据流转管道。本文通过 ERP-CRM 同步、数据库分析两个企业级案例,演示了从系统接入、数据映射到流程编排的全流程,覆盖工具配置、安全策略、性能优化等核心环节。

这种「AI 中台 + 自动化连接器 + 万维应用」的架构,正在重塑企业数据治理模式:无论是供应链数据闭环、客户生命周期管理,还是财务报表自动化,都能通过标准化的 MCP 协议实现即插即用。对于企业 IT 部门而言,这意味着更低的集成成本、更高的灵活性和更强的业务响应能力。

八、未来展望:构建企业级 AI 数据生态

当企业积累了丰富的 MCP 工具库后,可进一步搭建:

数据自动化市场:内部团队共享封装好的系统连接器(如 SAP、Oracle、Redis),附带详细的参数文档和最佳实践

智能数据中台:基于 Dify 的知识库和工作流引擎,实现数据采集、清洗、分析、应用的全链路自动化

异常处理中心:通过 AI 模型实时监控数据流转异常,自动触发熔断、重试或人工介入流程

随着生成式 AI 与自动化工具的深度融合,企业数据架构将从「被动响应」转向「主动智能」。Dify+Zapier 的组合,正是这一转型的关键基础设施,帮助企业在数字化浪潮中构建敏捷、高效、安全的数据自动化体系。立即动手实践,让你的企业数据真正「流动」起来!

![Linux环境MySQL出现无法启动的问题解决 [InnoDB] InnoDB initialization has started.](https://i-blog.csdnimg.cn/img_convert/c3124956236c01302e64bd018d1cd407.png)