冰雪奇缘!中科院一区算法+双向深度学习+注意力机制!SAO-BiTCN-BiGRU-Attention雪消融算法优化回归预测(Matlab)

目录

- 冰雪奇缘!中科院一区算法+双向深度学习+注意力机制!SAO-BiTCN-BiGRU-Attention雪消融算法优化回归预测(Matlab)

- 预测效果

- 基本介绍

- 程序设计

- 参考资料

预测效果

基本介绍

1.Matlab实现SAO-BiTCN-BiGRU-Attention雪消融算法优化双向时间卷积双向门控循环单元融合注意力机制多变量回归预测(完整源码和数据),优化学习率,BiGRU的神经元个数,滤波器个数, 正则化参数;SAO模拟了雪的升华和融化行为,在融化过程中,雪转化为液态水,而雪可以通过升华直接转化为蒸汽。同时,融雪转化的液态水也可以通过蒸发转化为蒸汽。

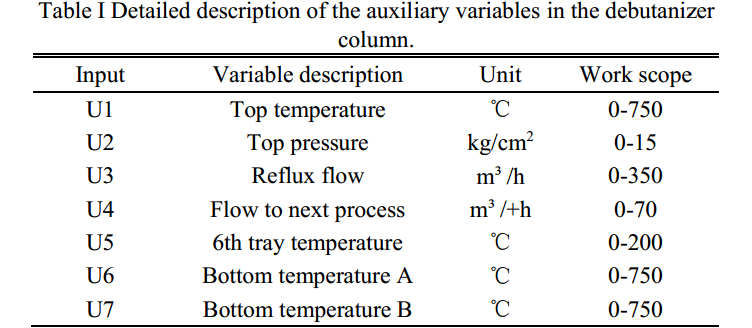

2.输入多个特征,输出单个变量,回归预测,自注意力机制层,运行环境matlab2023及以上;

3.命令窗口输出R2、MAE、MAPE、 RMSE多指标评价;

4.代码特点:参数化编程、参数可方便更改、代码编程思路清晰、注释明细;

5.适用对象:大学生课程设计、期末大作业和毕业设计。

程序设计

- 完整源码和数据获取方式私信回复中科院一区算法+双向深度学习+注意力机制!SAO-BiTCN-BiGRU-Attention雪消融算法优化回归预测。

%% 清空环境变量

warning off % 关闭报警信息

close all % 关闭开启的图窗

clear % 清空变量

clc % 清空命令行

%% 划分训练集和测试集

P_train = res(1: num_train_s, 1: f_)';

T_train = res(1: num_train_s, f_ + 1: end)';

M = size(P_train, 2);

P_test = res(num_train_s + 1: end, 1: f_)';

T_test = res(num_train_s + 1: end, f_ + 1: end)';

N = size(P_test, 2);

%% 数据归一化

[P_train, ps_input] = mapminmax(P_train, 0, 1);

P_test = mapminmax('apply', P_test, ps_input);

[t_train, ps_output] = mapminmax(T_train, 0, 1);

t_test = mapminmax('apply', T_test, ps_output);

% To run SAO: [Best_pos,Best_score,Convergence_curve]=SAO(SearchAgents_no,Max_iteration,lb,ub,dim,fobj)

%______________________________________________________________________________________________

function [Best_pos,Best_score,Convergence_curve]=SAO(N,Max_iter,lb,ub,dim,fobj)

if(max(size(ub)) == 1)

ub = ub.*ones(1,dim);

lb = lb.*ones(1,dim);

end

%Initialize the set of random solutions

X=initialization(N,dim,ub,lb);

Best_pos=zeros(1,dim);

Best_score=inf;

Objective_values = zeros(1,size(X,1));

Convergence_curve=[];

N1=floor(N*0.5);

Elite_pool=[];

% Calculate the fitness of the first set and find the best one

for i=1:size(X,1)

Objective_values(1,i)=fobj(X(i,:));

if i==1

Best_pos=X(i,:);

Best_score=Objective_values(1,i);

elseif Objective_values(1,i)<Best_score

Best_pos=X(i,:);

Best_score=Objective_values(1,i);

end

All_objective_values(1,i)=Objective_values(1,i);

end

参考资料

[1] https://blog.csdn.net/kjm13182345320/article/details/128577926?spm=1001.2014.3001.5501

[2] https://blog.csdn.net/kjm13182345320/article/details/128573597?spm=1001.2014.3001.5501