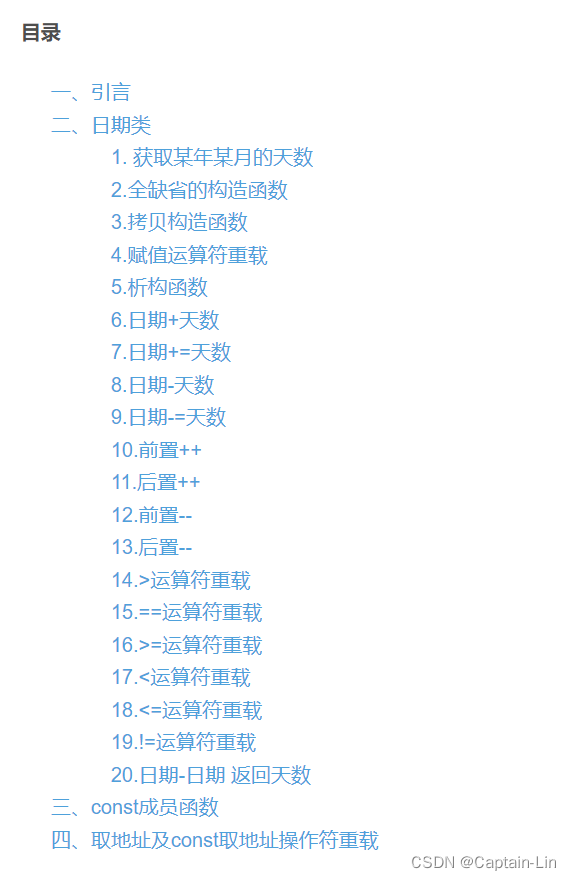

文章目录

- 前言

- Abs

- 1.Intro

- 2.Background

- 2.1.A Hierarchical View of IR

- 2.1.1.The Core Problem View of IR

- 2.1.2.The Framework View of IR

- 2.1.3.The System View of IR

- 2.2.A Brief Overview of PTMs in IR

前言

- 因为文章篇幅较长,因此还在持续阅读中

- 原文(FnTIR 2022)链接:[2111.13853] Pre-training Methods in Information Retrieval (arxiv.org)

Abs

- 本文致力于提供一个IR领域的预训练方法的系统回顾

- 介绍了引用于IR系统不同组成的 PTMs,包括检索,重排序,和其他组成

1.Intro

很多不同的排序模型被提出,包括:vector space model,probabilistic ranking model,learning to rank(LTR)model。

PTMs加剧了NLP范式的迁移:先用自监督语言建模进行预训练,然后将预训练模型通过引入小部分额外参数与特定任务目标的 fine-tune 来用于子任务。我们对应用在 IR 上的 PTMs 进行全面回顾,包括预训练 word embdding的用法,还有预训练 transformer 的应用。

2.Background

本节以分层的方式描述IR的基本概念和定义,并简要回顾IR中的PTMs。

2.1.A Hierarchical View of IR

从核心问题->框架->系统。使用 Q , D , F Q,D,F Q,D,F 来表示查询集合,文档集合,检索函数, q , d , f q,d,f q,d,f 来代表里面的个例。 r e l rel rel 代表相似度评估模型, R q R_q Rq 代表对查询 q q q 返回的搜索结果。

2.1.1.The Core Problem View of IR

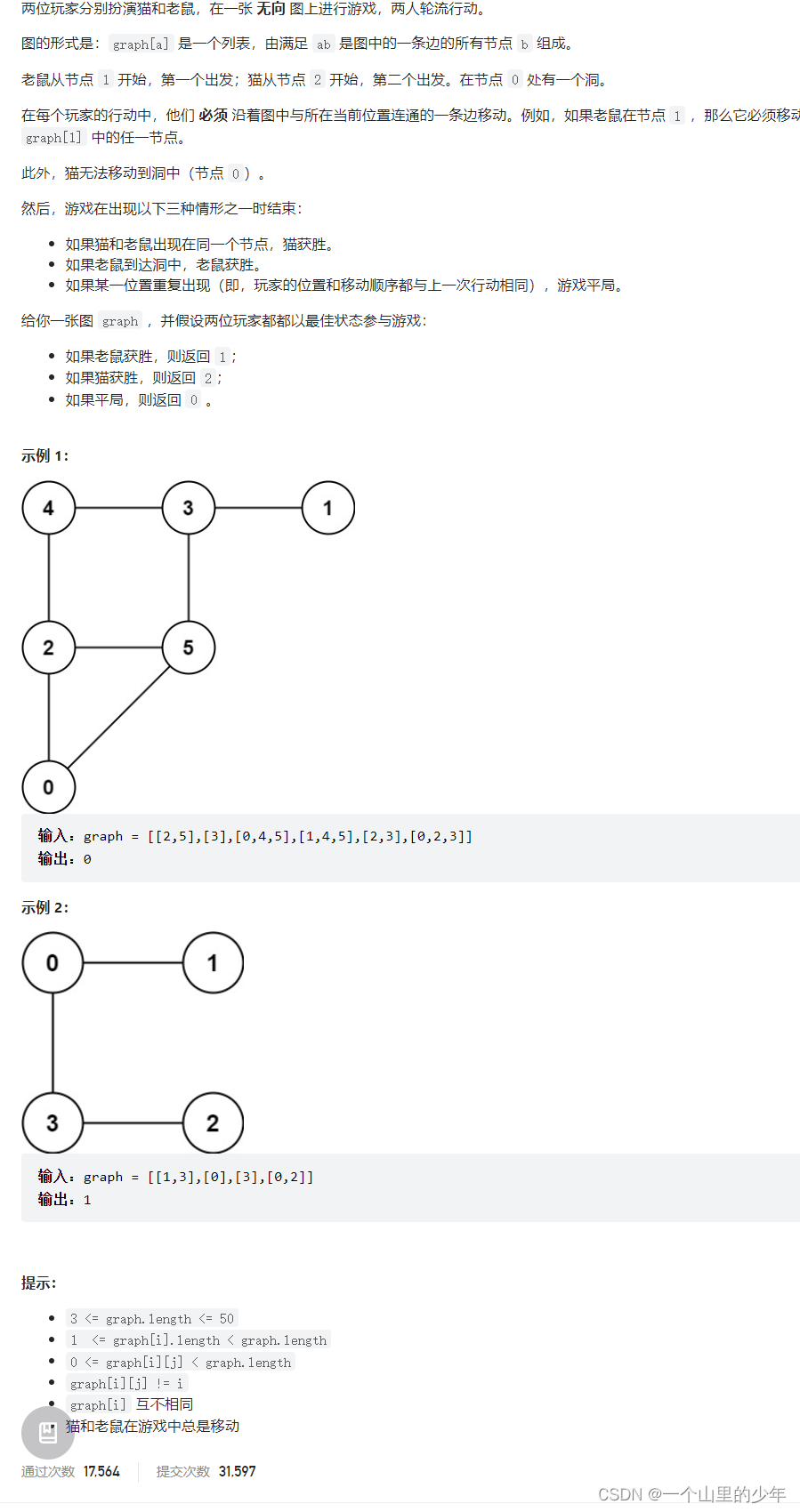

IR的基本目标就是给用户提供他们信息需求相关的信息,因此,最基础的问题就是 q q q 和 d d d 相似程度的估计。三类典型的模型:

- Classical retrieval models:核心思想是利用精确匹配信号来设计相似评分函数,使用一些容易计算的数据(term frenquency,document length等)。这些模型可能会遭遇词汇不匹配问题,由于硬匹配和精确匹配需求

- Learning to Rank(LTR)Models:核心思想是使用有监督的机器学习方法,使用手工制作的特征来解决排序问题。有效特征包括:基于查询的特征(类型,长度等),基于文档的特征(PageRank,点击量等),查询-文档匹配特征(共同出现次数,BM25,修正距离等)。基于 loss function 中考虑的文档的数目,LTR模型可以分成三类:

- Pointwise:只考虑单个文档,将检索为题当做分类/回归问题

- Pairwise:考虑成对文档

- Listwise:考虑整个文档列表

- Neural Retrieval Models:核心思想是利用神经网络来抽象相似度信号来进行相似度估计。可以分成三类:

- Representation-focused models:希望独立学习到查询和文档的密集向量表示,使用 cos,内积的方式计算相似度

- Interaction-focused models:捕捉查询和文档之间的交互。使用一个相似矩阵 A A A, A i j A_{ij} Aij 代表第 i i i 个查询 term embedding和第 j j j 个文档 term embedding之间的相似性。在此矩阵的基础上使用不同的方法来提取特征,用于产生 query-document 相关分数

- Mixed models:将上面两种方式结合起来

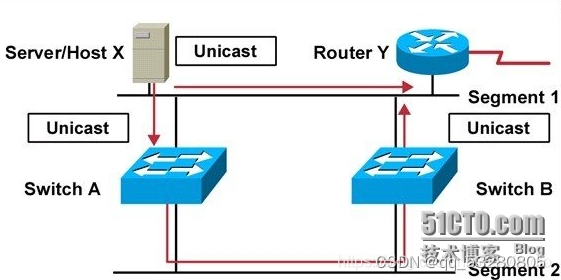

2.1.2.The Framework View of IR

Document retriever更关注效率,因为要从一大堆文档中进行检索。Re-ranker分为 early- stage re-ranker 和 later-stage re-ranker。二者相比,前者更关注效率,但是相对于 retriever 来说更关注效果。后面一个需要考虑的文档更少,因此更关注效果。根据 re-ranker 的个数,检索过程可以被分成以下方式:

- Single-stage Retrieval(n=0):由初始检索收回的排序列表不经过任何重排序器而呈现给用户。用于早起的检索框架(boolean retrieval),和精确匹配就足够用的场景

- Two-stage Retrieval(n=1):相对上面,加了一个 re-ranker。在一阶段检索没有考虑到的特征,比如多模态特征,用户行为和知识图收集,也会在重排序阶段考虑

- Multi-stage Retrieval(n >= 2):不同的重排序器可能采用不同的结构,并利用不同的信息源。

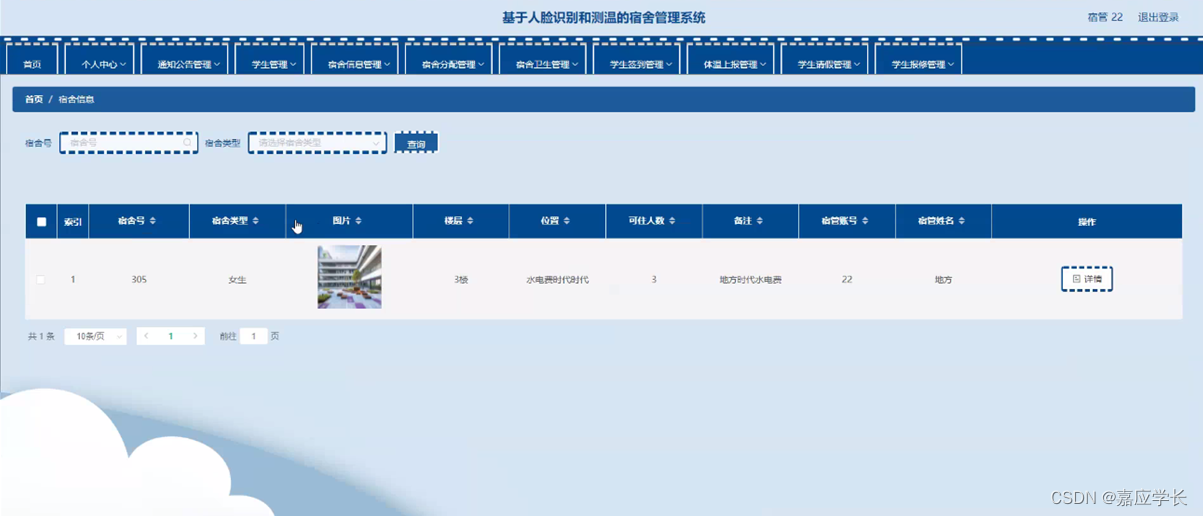

2.1.3.The System View of IR

- Symbolic search system:需要规则来构建文档解析器,该解析器根据各种标准对文档进行索引、筛选和排序,然后将这些数据转换为系统可以理解的符号。因此得名“symbolic search”。symbolic search系统对文档进行索引,建立倒排索引,倒排索引由两部分组成:a dictionary,postings。优点是检索速度快,提供的结果可解释。缺点是只能使用一种语言,需要很高的存储花费

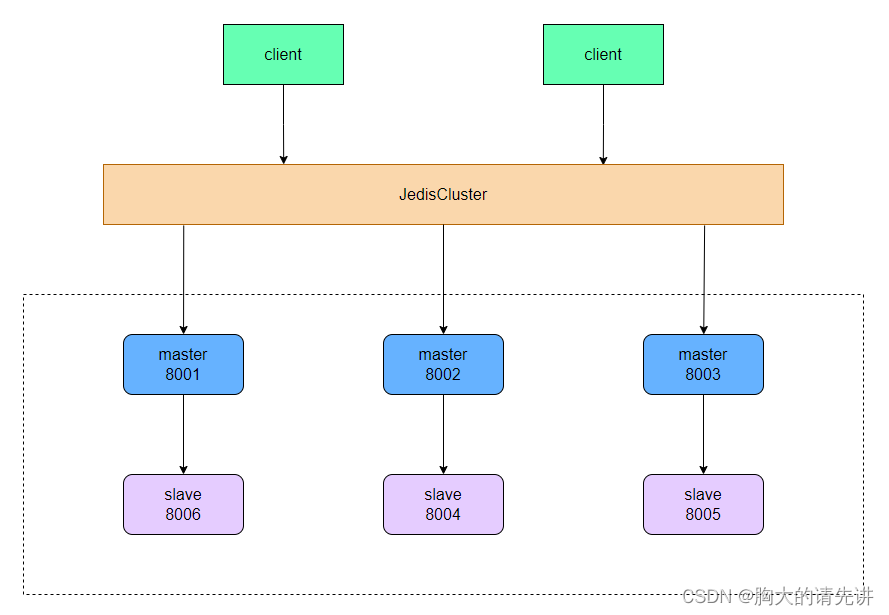

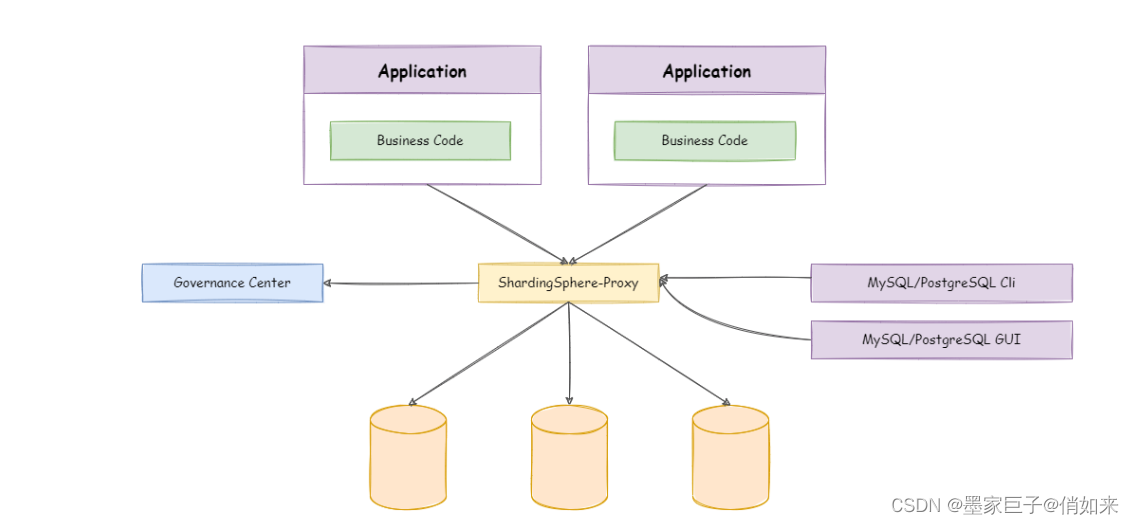

- Neural search system:symbolic search更关注精确匹配,neural search更关注语义匹配。不用构造各种规则,而是使用预训练模型来获得文档的低维密集表示。文档索引被称作 verctor index。优点是对噪音更鲁棒,且容易扩展。缺点是不好解释,且需要很多训练数据。

2.2.A Brief Overview of PTMs in IR

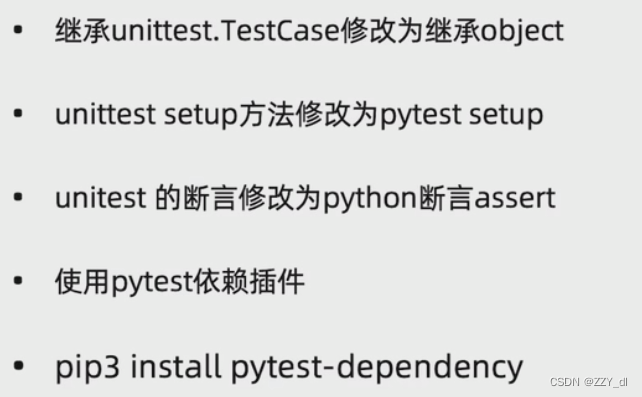

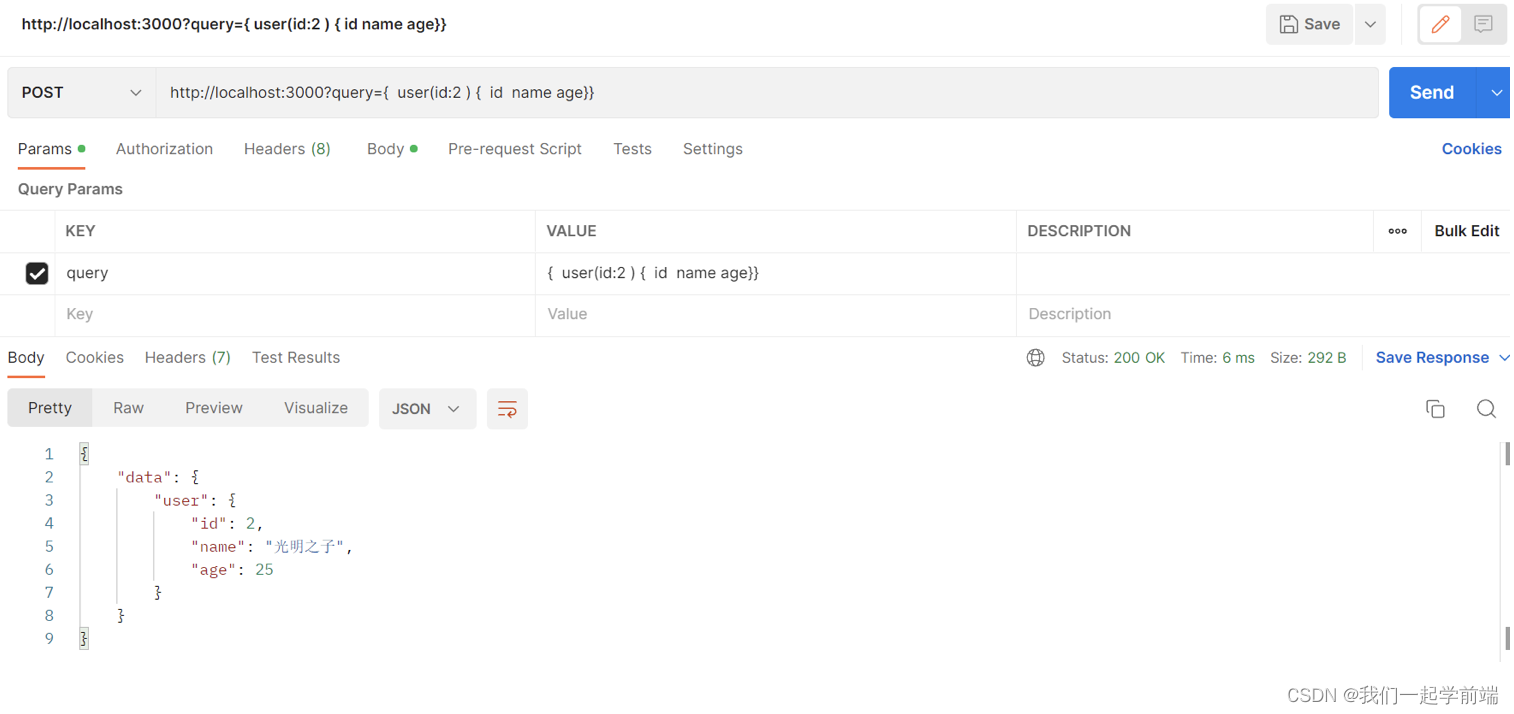

因为创建大规模的带标记数据集是费时费力的,但是创建大规模不带标记的数据集更容易,因此PTMs很受欢迎。工作流程为:1)在未标记数据集上使用 PTMs 学习文本好的表示或者文本对之间更好的交互。2)学习到的表示/交互被 fine-tune 并且用于下游任务。根据下游任务目标,有不同的 fine-tune 方式:Full fine-tuning,Partial fine-tuning,Freezing the weights。