Day 35 : Python 爬虫简介

1.1 什么是爬虫?

网页爬虫(Web Crawler)是自动访问互联网并提取所需信息的程序。爬虫的主要功能是模拟用户通过浏览器访问网页的操作,从而实现对网页内容的批量访问与信息提取。它们广泛应用于数据收集、市场研究、搜索引擎、社交媒体分析等多个领域。

爬虫的定义与应用

网页爬虫是一种程序,其功能是自动抓取和检索互联网信息。它的工作过程通常分为以下几个步骤:

| 步骤 | 描述 |

|---|---|

| 发送请求 | 通过网络请求(HTTP/HTTPS协议)访问网页 |

| 获取响应 | 服务器返回网页的HTML文档 |

| 解析数据 | 提取需要的信息(如文本、图片链接等) |

| 存储数据 | 将提取的信息保存到本地或数据库中 |

常见的爬虫应用场景包括:

- 搜索引擎:Google、Bing等通过爬虫获取网页信息以建立索引。

- 数据分析:通过抓取社交媒体数据,分析用户行为和趋势。

- 价格监控:电商网站的商品价格跟踪与比较。

- 新闻聚合:从多个新闻网站抓取并汇总新闻信息。

爬虫的工作原理

一个标准的爬虫系统工作流程如下所示:

- 发送请求:用户指定的目标URL,爬虫通过HTTP协议发送请求以获取网页内容。

- 获取响应:目标服务器处理请求并返回响应,通常包括HTML文档。

- 解析数据:爬虫使用诸如BeautifulSoup、lxml等工具解析网页,提取所需的数据。

- 存储数据:将解析后的数据存储到本地文件或数据库中,供后续使用。

- 重复操作:根据需求,爬虫可以遍历多个页面,继续提取数据。

下面是一个爬虫工作流程的简化示意图:

+------------------+

| 发送请求 |

| (requests.get()) |

+--------+---------+

|

v

+------------------+

| 获取响应 |

| (response.text) |

+--------+---------+

|

v

+------------------+

| 解析网页内容 |

| (BeautifulSoup) |

+--------+---------+

|

v

+------------------+

| 提取数据 |

| (soup.find()) |

+--------+---------+

|

v

+------------------+

| 存储数据 |

| (保存到文件/数据库)|

+------------------+

1.2 Python 爬虫的优势

Python被广泛认为是编写爬虫的理想语言,其优势主要包括:

- 简单易学:Python的语法简洁,适合初学者学习和使用。

- 丰富的第三方库:Python拥有众多强大的爬虫库,如:

requests:用于发送HTTP请求并处理响应。BeautifulSoup:用于解析HTML/XML文档,提取数据。Scrapy:一个强大的爬虫框架,支持调度、数据存储等功能。Selenium:用于模拟浏览器操作,抓取动态内容。

示例代码

以下是一个简单的Python爬虫示例,展示如何使用requests库发送GET请求,并用BeautifulSoup解析获取的网页内容:

import requests

from bs4 import BeautifulSoup

# 目标网站URL

url = 'http://example.com'

# 发送 GET 请求

response = requests.get(url)

# 检查响应状态

if response.status_code == 200:

# 解析 HTML 内容

soup = BeautifulSoup(response.text, 'html.parser')

# 提取网页标题

title = soup.title.string

print(f"网页标题: {title}")

# 提取所有链接

links = soup.find_all('a')

for link in links:

print(f"链接地址: {link.get('href')}, 链接文本: {link.string}")

else:

print("请求失败,状态码:", response.status_code)

代码解析

- 导入库:使用

requests和BeautifulSoup进行请求和解析。 - 发送请求:使用

requests.get()方法获取网页响应。 - 状态检查:如果状态码为200,表示请求成功。

- 解析网页:使用

BeautifulSoup解析响应文本,并提取网页标题和所有链接。

代码运行流程图

下面的流程图进一步描述了爬虫的工作流程,帮助理解各个步骤:

+------------------+

| 发送请求 |

| (requests.get()) |

+--------+---------+

|

v

+------------------+

| 获取响应 |

| (response.text) |

+--------+---------+

|

v

+------------------+

| 解析网页内容 |

| (BeautifulSoup) |

+--------+---------+

|

v

+------------------+

| 提取数据 |

| (soup.find()) |

+--------+---------+

|

v

+------------------+

| 存储数据 |

| (存入文件/数据库)|

+------------------+

1.3 爬虫的法律与伦理

爬虫的法律法规

在开发和使用爬虫过程中,需要遵循一些法律法规,以确保合规和道德。以下是一些重要的法律考量:

- robots.txt文件:大多数网站会在其根目录下提供

robots.txt文件,指示爬虫哪些页面可以访问,哪些不可以。遵循该文件的规范是非常重要的。 - 版权问题:未经允许抓取和使用他人网站的内容可能涉及版权侵权,使用时应谨慎。

- 数据隐私:收集用户数据时,考虑数据隐私法规(如GDPR)至关重要。

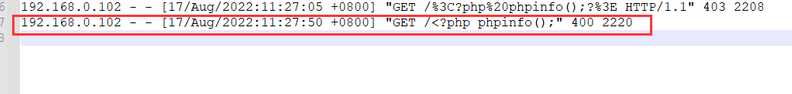

反爬虫机制

为了保护网站资源,许多网站会实施反爬虫策略,包括:

- IP限制:对频繁请求的IP实现封禁。

- CAPTCHA:通过验证码防止自动访问。

- 动态内容:通过JavaScript动态加载内容,普通的爬虫无法获取。

应对策略

- 合理控制请求频率:使用

time.sleep()控制爬虫请求的频率,防止高并发对服务器造成压力。 - 使用代理:通过VPN或代理服务器更换IP以避免被屏蔽。

- 解析动态内容:使用

Selenium等工具模拟浏览器操作,以获取动态加载的数据。

1.4 学习小结

通过本节内容,我们初步了解了爬虫的基本概念、工作原理及Python语言的优势。学习Python爬虫不仅能帮助我们获取大量有用数据,同时也需要关注法律与伦理问题,以确保爬虫的合法性。

怎么样今天的内容还满意吗?再次感谢观众老爷的观看。

最后,祝您早日实现财务自由,还请给个赞,谢谢!