🌈个人主页: 鑫宝Code

🔥热门专栏: 闲话杂谈| 炫酷HTML | JavaScript基础

💫个人格言: "如无必要,勿增实体"

文章目录

- 目标分类算法概述

- 传统机器学习方法

- 支持向量机(SVM)

- 决策树和随机森林

- 特征提取

- 基于深度学习的方法

- 卷积神经网络(CNN)

- 区域卷积神经网络(R-CNN)

- 其他深度学习模型

- 算法性能比较

目标分类算法概述

在计算机视觉和图像处理领域,目标分类是一项重要的任务,旨在自动识别和分类图像或视频中的目标对象。目标分类算法通过学习大量标注数据,建立一个能够将输入图像映射到预定义类别的模型。这些算法在许多实际应用中发挥着关键作用,如自动驾驶、机器人视觉、人脸识别、医学图像分析等。

本文将介绍几种常用的目标分类算法,包括传统的机器学习方法和基于深度学习的方法,并对它们的原理、优缺点及适用场景进行分析和比较。

传统机器学习方法

在深度学习技术兴起之前,目标分类任务主要依赖于传统的机器学习算法,如支持向量机(SVM)、决策树、随机森林等。这些算法通常需要手动设计特征提取器,从原始图像数据中提取有区分度的特征向量,然后将其输入到分类器进行训练和预测。

支持向量机(SVM)

支持向量机是一种有监督的机器学习算法,它通过寻找最优超平面将不同类别的数据点分开,从而实现分类。对于线性可分的情况,SVM试图找到一个能够最大化两类数据点间距离的超平面。对于线性不可分的情况,SVM引入了核技巧(Kernel Trick),将数据映射到更高维的特征空间,使其在新空间中变为线性可分。

SVM的优点是理论基础扎实,可以有效处理高维数据,并且在较小的训练集上表现良好。然而,SVM在处理大规模数据集时会遇到计算和内存瓶颈,并且对于非线性决策边界的问题,需要手动设计合适的核函数。

决策树和随机森林

决策树是一种基于树形结构的监督学习算法,它通过递归地对特征空间进行划分,将数据划分到不同的叶节点,每个叶节点对应一个类别。决策树易于理解和解释,并且能够自动处理特征选择。然而,单一决策树容易过拟合,并且对数据的微小变化敏感。

随机森林是一种集成学习方法,它通过构建多个决策树,并将它们的预测结果进行组合,从而提高模型的泛化能力和鲁棒性。随机森林在目标分类任务中表现出色,但它也存在一些缺点,如对异常值敏感,难以解释单个树的决策过程。

特征提取

无论使用何种传统机器学习算法,都需要从原始图像数据中提取有区分度的特征向量。常用的特征提取方法包括:

-

手工设计特征:例如,基于颜色、纹理、形状等低级特征,以及基于SIFT、HOG等高级特征。这种方法需要专业知识和大量人工劳动。

-

特征编码:将低级特征(如SIFT特征点)编码为固定长度的向量,常用的编码方法有向量量化(Vector Quantization)、稀疏编码(Sparse Coding)等。

-

特征学习:使用无监督或半监督的方法从数据中自动学习特征表示,如主成分分析(PCA)、字典学习等。

虽然传统机器学习方法在特定场景下表现良好,但它们存在一些固有的缺陷,如需要手动设计特征提取器,无法很好地捕捉图像的高级语义信息,并且在大规模数据集上的性能往往不尽如人意。随着深度学习技术的兴起,基于深度神经网络的目标分类算法逐渐占据主导地位。

基于深度学习的方法

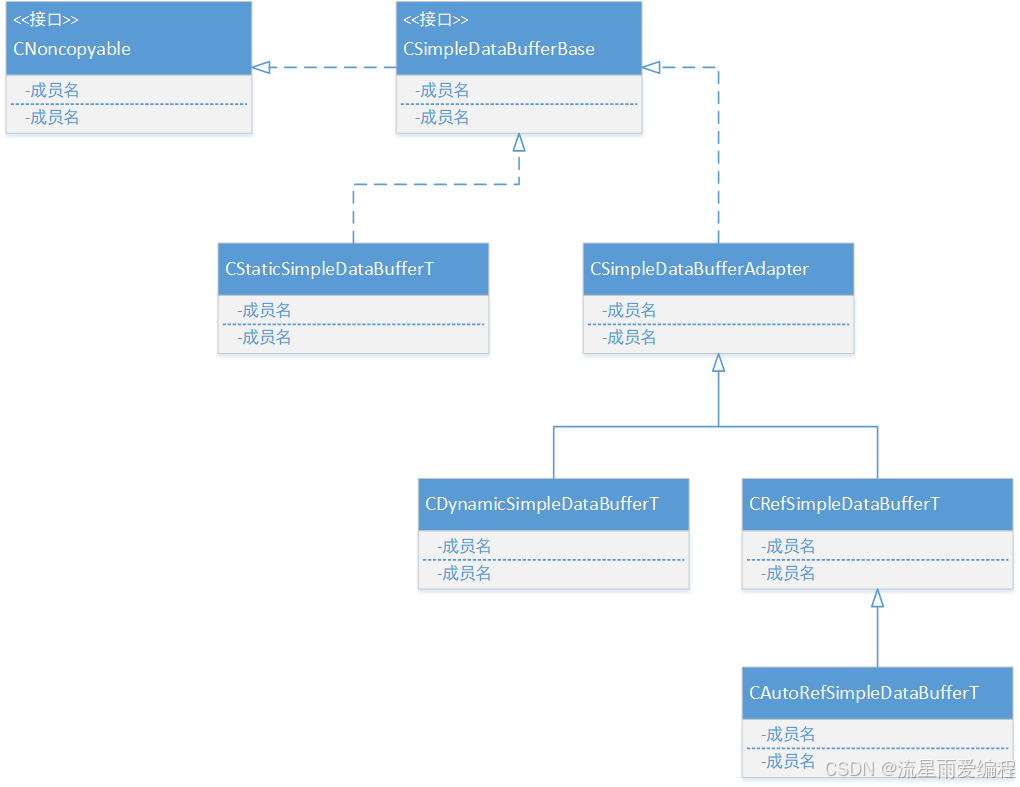

深度学习是机器学习的一个新的研究热点,它通过构建深层次的神经网络模型,能够自动从原始数据中学习多层次的特征表示,并在许多领域取得了卓越的性能。在目标分类任务中,基于深度学习的方法主要包括卷积神经网络(CNN)和其变体。

卷积神经网络(CNN)

卷积神经网络是一种专门用于处理网格结构数据(如图像)的深度神经网络,它通过交替使用卷积层和池化层来提取图像的局部特征,并通过全连接层对这些特征进行组合和分类。CNN的核心思想是局部连接和权值共享,这使得它能够有效地捕捉图像的空间和层次结构信息。

CNN在图像分类任务上取得了巨大的成功,代表性的工作包括AlexNet、VGGNet、GoogLeNet、ResNet等。这些模型不断刷新着ImageNet数据集的分类精度记录,并在许多其他视觉任务中也取得了优异的表现。

CNN的优点是能够自动学习多层次的特征表示,避免了手动设计特征提取器的繁琐过程。它还具有一定的平移不变性和尺度不变性,能够有效地捕捉图像的局部特征。然而,CNN也存在一些缺陷,如对旋转和变形不够鲁棒,对小目标和密集目标的检测能力有限。

区域卷积神经网络(R-CNN)

对于目标检测和实例分割等任务,需要同时定位目标的位置和识别目标的类别。区域卷积神经网络(R-CNN)系列算法就是针对这一问题而提出的。

R-CNN算法的基本思路是:首先使用选择性搜索(Selective Search)等算法在图像中生成一组候选区域,然后将这些候选区域输入到CNN中提取特征,最后使用分类器和边界框回归器对目标进行分类和定位。

R-CNN算法的主要变体包括Fast R-CNN、Faster R-CNN和Mask R-CNN等。这些算法不断优化了候选区域的生成方式和网络结构,显著提高了目标检测和实例分割的精度和效率。

其他深度学习模型

除了CNN及其变体,还有一些其他的深度学习模型被应用于目标分类任务,如:

- 递归神经网络(RNN):适用于处理序列数据,可以用于视频目标分类。

- 生成对抗网络(GAN):通过对抗训练的方式,可以生成逼真的图像样本,用于数据增强。

- 注意力机制(Attention):引导模型关注图像的重要区域,提高分类性能。

- 元学习(Meta-Learning):通过学习如何快速适应新任务,提高模型的泛化能力。

深度学习模型在目标分类任务上取得了卓越的成绩,但它们也面临一些挑战,如需要大量的标注数据、模型复杂度高、可解释性差等。未来的研究方向包括提高模型的鲁棒性和可解释性、减少对大规模标注数据的依赖、设计更高效的网络结构等。

算法性能比较

不同的目标分类算法在准确性、速度、可解释性等方面存在差异,适用于不同的场景和需求。下表对几种常见算法进行了简单比较:

| 算法 | 准确性 | 速度 | 可解释性 | 数据需求 | 适用场景 |

|---|---|---|---|---|---|

| SVM | 中等 | 快 | 较好 | 中等 | 小数据集,线性可分问题 |

| 决策树/随机森林 | 较高 | 中等 | 较好 | 中等 | 非线性决策边界,异常值敏感 |

| 传统特征+分类器 | 较低 | 快 | 一般 | 大 | 特定场景,需要领域知识 |

| CNN | 很高 | 慢 | 较差 | 大 | 大规模数据集,端到端学习 |

| R-CNN系列 | 很高 | 慢 | 较差 | 大 | 目标检测和实例分割 |

在实际应用中,需要根据具体的任务需求、数据特征、计算资源等因素,选择合适的目标分类算法。传统机器学习方法在小数据集和特定场景下仍然有一定的应用价值,而深度学习方法则更适合于大规模数据集和端到端的学习任务。

未来,随着算力的不断提升和新算法的涌现,目标分类技术将继续向着更高的准确性、更快的速度和更好的可解释性发展。同时,如何减少对大规模标注数据的依赖,提高模型的鲁棒性和泛化能力,也将是重要的研究方向。

![[深度学习]循环神经网络](https://i-blog.csdnimg.cn/direct/5feeb608abbb490f80abeeff3c3a9ebb.png)