1、ROC(Receiver Operating Characteristic)

ROC(Receiver Operating Characteristic)曲线是一种用于评估分类模型性能的工具。它通过绘制真阳性率(True Positive Rate, TPR)与假阳性率(False Positive Rate, FPR)之间的关系来展示模型的分类能力。ROC 曲线下的面积(AUC, Area Under the Curve)通常用于量化模型的性能。

如何绘制 ROC 曲线

在 Python 中,你可以使用 scikit-learn 库来绘制 ROC 曲线。以下是一个简单的示例:

import numpy as np

import matplotlib.pyplot as plt

from sklearn.metrics import roc_curve, auc

from sklearn.model_selection import train_test_split

from sklearn.ensemble import RandomForestClassifier

from sklearn.datasets import make_classification

# 生成一个示例数据集

X, y = make_classification(n_samples=1000, n_features=20, n_classes=2, random_state=42)

# 将数据集分为训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42)

# 使用随机森林分类器

model = RandomForestClassifier(random_state=42)

model.fit(X_train, y_train)

# 获取测试集的预测概率

y_pred_proba = model.predict_proba(X_test)[:, 1]

# 计算 FPR, TPR 和阈值

fpr, tpr, thresholds = roc_curve(y_test, y_pred_proba)

# 计算 AUC

roc_auc = auc(fpr, tpr)

# 绘制 ROC 曲线

plt.figure()

plt.plot(fpr, tpr, color='darkorange', lw=2, label='ROC curve (area = %0.2f)' % roc_auc)

plt.plot([0, 1], [0, 1], color='navy', lw=2, linestyle='--')

plt.xlim([0.0, 1.0])

plt.ylim([0.0, 1.05])

plt.xlabel('False Positive Rate')

plt.ylabel('True Positive Rate')

plt.title('Receiver Operating Characteristic')

plt.legend(loc="lower right")

plt.show()

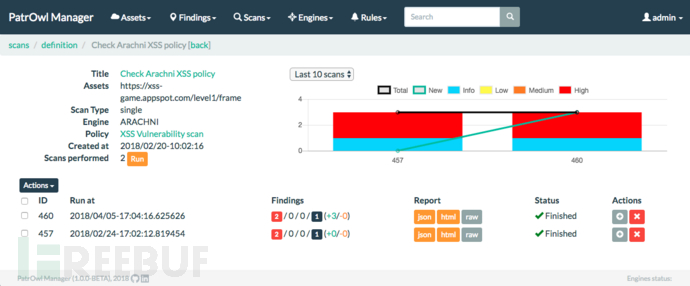

(注:本图来自无监督异常检测算法patchcore,不是上面给的代码例子产生的)

ROC 曲线下的面积(AUC, Area Under the Curve)是评估分类模型性能的一个重要指标。AUC 的值范围在 0 到 1 之间,具体含义如下:

-

AUC = 1: 表示模型完美地将所有正样本排在所有负样本之前,即模型具有完美的分类能力。

-

AUC = 0.5: 表示模型的分类能力等同于随机猜测,即模型没有分类能力。

-

AUC < 0.5: 表示模型的分类能力比随机猜测还差,通常这种情况很少见,可能是因为模型预测结果完全相反。

-

0.5 < AUC < 1: 表示模型具有一定的分类能力,AUC 值越接近 1,模型的分类能力越强。

ROC 曲线是通过在不同的分类阈值下计算 TPR 和 FPR,然后绘制 TPR 与 FPR 之间的关系得到的。ROC 曲线的横轴是 FPR,纵轴是 TPR。

-

理想情况: 当 TPR 接近 1 且 FPR 接近 0 时,模型的性能最好。

-

随机猜测: 当 TPR 和 FPR 相等时,模型的性能等同于随机猜测。

总结

-

AUC: 衡量模型分类能力的综合指标,值越大,模型的分类能力越强。

-

TPR: 衡量模型对正样本的识别能力,值越大,模型对正样本的识别能力越强。

-

FPR: 衡量模型对负样本的误判能力,值越小,模型对负样本的误判能力越弱。

通过 ROC 曲线和 AUC 值,你可以全面评估分类模型的性能,并选择合适的模型进行应用。

2、真阳性率(True Positive Rate, TPR)与假阳性率(False Positive Rate, FPR)的定义

真阳性率(True Positive Rate, TPR)也称为灵敏度(Sensitivity)或召回率(Recall),表示实际为正的样本中被正确预测为正的比例。其计算公式为:

其中:

-

TP (True Positive): 实际为正且被正确预测为正的样本数。

-

FN (False Negative): 实际为正但被错误预测为负的样本数。

假阳性率(FPR)

假阳性率(False Positive Rate, FPR)表示实际为负的样本中被错误预测为正的比例。其计算公式为:

其中:

-

FP (False Positive): 实际为负但被错误预测为正的样本数。

-

TN (True Negative): 实际为负且被正确预测为负的样本数。