算法原理引入

- 样本点通常应该在模型的2侧,原因:在实际中,因为某种不可控的因素,测出来的样本点肯定是有误差的。如果样本数据点都在模型上,则说明在建立模型时,把误差也考虑进去了,这就是我们说的过拟合。

- 好的模型:样本点离模型距离最近;

- 正交回归:以样本点距模型的距离为评判标准的算法叫做正交回归。

- 线性回归:样本点做平行于y轴的线同模型交于一点,样本点同这一交点所构成的线段的长短是评判标准。(即误差)(误差最小的模型就是我们所要求的模型),(线性回归的)所有的误差的和叫做均方误差。也叫作:最小二乘法。

算法原理正篇

线性模型

基本形式

文字描述:试图学得一个通过属性的线性组合来进行预测的函数

数学描述:

- 许多非线性模型可以通过在线性模型的基础上引入层级结构或高维映射而得

- w直观地呈现了各属性在预测中重要性,故线性模型的可解释性。

线性模型之线性回归

- 数据集形式:

- 特征工程如下:

1.对离散属性,若属性值之间存在”序“关系,可通过连续化将其转化为连续值:

eg:二值属性“身高”的取值“高”“矮”可转化为{1.0,0.0};

三值属性“高度”的取值“高”“中”“低”可转化为{1.0,0.5,0.0};

2.若属性值间不存在序关系,假定有k个属性值,则通常转化为k维向量:

eg:属性“瓜类”的取值“西瓜”“南瓜”“黄瓜”可转化为(0,0,1),(0,1,0),(1,0,0).

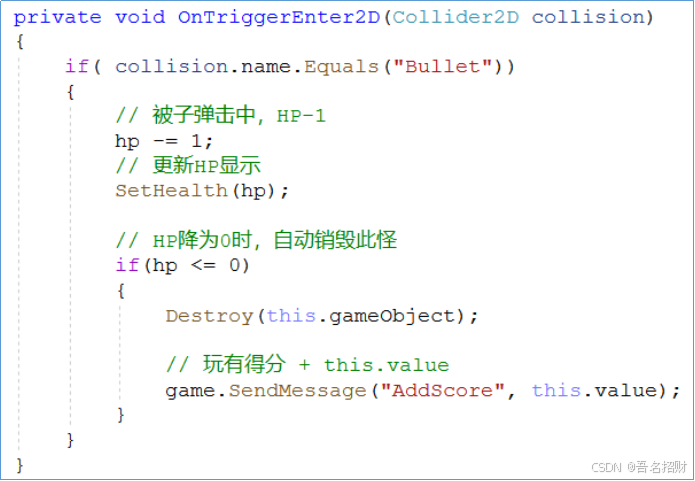

线性回归的损失函数

下图中的二值离散特征中x1的含义是:好看,数值为1; x2的含义是:不好看,数值为0

有序的多值离散特征中x1的含义是:饭量小;x2的含义是:饭量中;x3的含义是:饭量大。

无序的多值离散特征中x4的含义是:=1表示是黄;x5的含义是:=1表示是黑;x6的含义是:=1表示是白;

线性回归的损失函数之最小二乘法

- 目的:试图找到一条直线,使所有样本到直线上的欧氏距离之和最小。

下图中的yi是预测值,f(xi)是实际值

3.4的式子旨在求出使这个式子最小的w和b

求解3.4的式子的过程如下:

将E(w,b)分别对w和b求导,得到

多元线性回归模型推理如下:

总结:多元线性回归就是把一元线性回归的x变成了有样例集的特征向量集(矩阵格式),其他都一样 。

线性回归之对数线性回归

- 引入场景:示例所对应的输出标记是在指数尺度(指数的大小)上变化。

- 文字描述:将输出标记的对数作为线性模型逼近的目标。

- 数学描述:

- 实质:求输入空间到输出空间的非线性函数映射

- 取对的目的:将线性回归模型的预测值与真实值(值感觉比标记好理解)联系起来。

- 对数线性回归的示意图:

广义线性模型:

其中函数g(.)称为”联系函数“

对数线性回归模型是g(.)=ln(.)的特例