论文地址:https://arxiv.org/pdf/1507.05717

这篇文章的标题是《An End-to-End Trainable Neural Network for Image-based Sequence Recognition and Its Application to Scene Text Recognition》,作者是Baoguang Shi, Xiang Bai和Cong Yao,来自中国武汉的华中科技大学电子信息与通信学院。文章主要研究了基于图像的序列识别问题,特别是场景文本识别,这是基于图像的序列识别中最重要和最具挑战性的任务之一。以下是对论文内容的解读:

研究背景与动机

该论文主要集中在解决基于图像的序列识别问题,尤其是场景文本识别。以下是研究背景和动机的几个关键点:

-

深度学习在视觉任务中的成功:近年来,深度学习,特别是深度卷积神经网络(DCNN)在各种视觉任务中取得了巨大成功。然而,大多数相关工作集中在对象类别的检测或分类上,而不是序列识别。

-

序列识别的独特挑战:与一般的对象识别不同,序列识别(例如场景文本、手写文本和乐谱)要求系统预测一系列对象标签,而不是单个标签。这些序列对象的长度可能会有显著变化,这使得直接应用DCNN模型变得困难,因为它们通常处理固定尺寸的输入和输出。

-

现有方法的局限性:现有的基于DCNN的场景文本识别方法通常需要先检测单个字符,然后使用DCNN模型进行识别,这要求训练一个强大的字符检测器来准确检测和裁剪原始单词图像中的每个字符。此外,将场景文本识别视为图像分类问题的方法需要一个大型的、包含数百万类别的模型,这难以泛化到其他类型的序列对象。

-

序列建模的需求:序列识别问题需要能够捕捉序列内部的上下文信息,这是传统的DCNN模型所不具备的。递归神经网络(RNN)是为处理序列而设计的,但它们通常需要将输入对象图像转换为图像特征序列的预处理步骤,这限制了现有基于RNN的系统无法以端到端的方式进行训练和优化。

-

端到端训练的需求:为了克服现有方法的局限性,需要一个能够端到端训练的系统,即从输入图像直接到输出序列标签,无需进行复杂的预处理或多个分离的步骤。

-

实际应用的可行性:在现实世界的应用场景中,需要一个既有效又紧凑的模型,以便能够部署在资源受限的设备上。

基于这些背景和动机,论文提出了一种新的神经网络架构——卷积递归神经网络(CRNN),它结合了DCNN和RNN的优势,能够处理任意长度的序列,无需字符分割或水平尺度归一化,并且可以端到端地训练,从而在场景文本识别和其他图像序列识别任务中取得了显著的性能提升。

网络结构

CRNN

文章的主要贡献是提出了一种新的神经网络模型,名为卷积递归神经网络(CRNN),它是深度卷积神经网络(DCNN)和递归神经网络(RNN)的结合。CRNN具有以下几个显著优势:

-

可以直接从序列标签(例如单词)中学习,不需要详细的注释(例如字符)。

-

与DCNN一样,能够直接从图像数据中学习信息丰富的表示,不需要手工特征或预处理步骤。

-

与RNN一样,能够产生标签序列。

-

不受序列对象长度的限制,只需要在训练和测试阶段进行高度归一化。

-

在场景文本(单词识别)上的性能优于或与现有技术相当。

-

包含的参数比标准DCNN模型少得多,占用的存储空间更少。

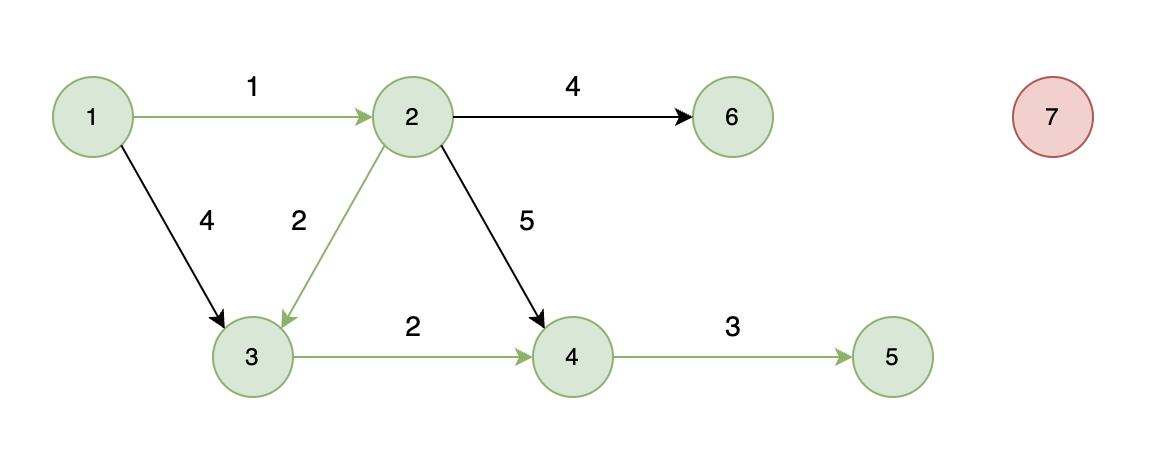

网络架构

网络架构由卷积层、循环层和转录层三部分组成,卷积层自动从每个输入图像中提取特征序列,循环层对卷积层输出的特征序列的每一帧进行预测,转录层将循环层的逐帧预测转换为标签序列。CRNN可以与一个损失函数一起联合训练。

-

卷积层:使用标准的CNN模型中的卷积和最大池化层(去除全连接层)来从输入图像中提取序列化的特征表示。

-

循环层:构建在卷积层之上,使用深度双向循环神经网络,对特征序列的每一帧进行预测,输出标签分布。

-

转录层:采用Connectionist Temporal Classification (CTC) 层定义的条件概率,将逐帧预测转换为最终的标签序列。

实验结果

该论文使用了包括IIIT-5K、Street View Text和ICDAR数据集在内的标准基准测试,证明了所提出算法相对于先前技术的优势。此外,所提出的算法在基于图像的音乐乐谱识别任务中表现良好,明显验证了其通用性。

-

IIIT-5K:包含3000张从互联网收集的裁剪过的单词图像,每个图像与一个50词的词汇表关联。

-

Street View Text (SVT):包含249张来自Google街景的图像,从中裁剪出647个单词图像,每个图像与一个50词的词汇表关联。

-

ICDAR:有两个数据集,ICDAR 2003 (IC03) 包含251张场景图像和标记的文本边框,ICDAR 2013 (IC13) 继承了IC03的大部分数据,包含1015个地面真实裁剪过的单词图像。

在实验部分,作者使用了合成数据集进行训练,并在多个真实世界的测试数据集上进行了测试,没有在它们的训练数据上进行微调。尽管CRNN模型仅使用合成文本数据进行训练,但它在标准文本识别基准的真实图像上表现良好。

为了进一步了解与其它文本识别方法相比,我们所提出算法的优点,我们提供了在一些特性上的综合比较,这些特性名称为E2E Train,Conv Ftrs,CharGT-Free,Unconstrained和Model Size,如下表所示。

-

E2E Train:这一列是为了显示某种文字阅读模型是否可以进行端到端的训练,无需任何预处理或经过几个分离的步骤,这表明这种方法对于训练是优雅且干净的。

-

Conv Ftrs:这一列表明一个方法是否使用从训练图像直接学习到的卷积特征或手动特征作为基本的表示。

-

CharGT-Free:这一列用来表明字符级标注对于训练模型是否是必要的。由于CRNN的输入和输出标签是序列,因此字符级标注是不必要的。

-

Unconstrained:这一列用来表明训练模型是否受限于一个特定的字典,是否不能处理字典之外的单词或随机序列。注意尽管最近通过标签嵌入和增强学习学习到的模型取得了非常有竞争力的性能,但它们受限于一个特定的字典。

-

Model Size:这一列报告了学习模型的存储空间。在CRNN中,所有的层有权重共享连接,不需要全连接层。因此,CRNN的参数数量远小于CNN变体所得到的模型。我们的模型有830万个参数,只有33MB RAM(每个参数使用4字节单精度浮点数),因此可以轻松地移植到移动设备上。

评估指标

准确率:在不同数据集上,CRNN模型识别正确的单词或字符的比率。

编辑距离:在音乐符号识别任务中,预测的音高序列与真实标签序列之间的平均编辑距离。

应用案例

论文探讨了CRNN在光学音乐识别(OMR)问题上的应用,展示了CRNN在不同类型数据集(Clean, Synthesized, Real-World)上的性能。

结论与贡献

文章的结论部分强调了CRNN作为一种新型神经网络架构的优势,它结合了CNN和RNN的优点,能够处理不同尺寸的输入图像,并产生不同长度的预测。CRNN不需要详细的个体元素注释,且由于放弃了传统神经网络中使用的全连接层,因此模型更紧凑、效率更高。这些特性使得CRNN成为基于图像的序列识别问题的优秀方法。作者还指出,提高CRNN的速度并使其在实际应用中更加实用是未来值得探索的方向。