说话人脸生成是一种技术,它通过音频信号来驱动和合成视频中的人脸图像,使得人脸的口型和表情与音频中的声音同步。这种技术主要应用于视频制作、虚拟现实、动画电影等领域,能够提升视听媒体的自然性和沉浸感。

使用的技术

说话人脸生成通常使用深度学习和计算机视觉技术实现。具体到您提到的内容中,使用了一种名为SegTalker的框架。这种方法包括几个关键步骤:

- 解析网络生成图像掩码:首先利用解析网络对输入图像生成分割掩码,这一步骤帮助后续过程中的区域特定处理。

- 音频驱动的掩码生成:通过音频信号驱动掩码生成,确保生成的人脸部分(如嘴唇和脸部其他动态区域)与音频中的声音保持同步。

- 掩码引导编码器:通过掩码引导的方式对图像的语义区域(如皮肤、眉毛、嘴唇等)进行风格编码,从而解耦图像的口型运动和纹理。

- 掩码引导的StyleGAN:最后使用StyleGAN(一种生成对抗网络)结合前述生成的风格代码和说话分割信息来合成最终的视频帧,保留细致的纹理并实现高质量的视觉输出。

意义

这种技术的意义主要体现在以下几个方面:

- 提高视觉和听觉的一致性:确保视频中的视觉内容(如口型)与音频内容(如对话)完美同步。

- 增强媒体的真实感:在电影制作、动画或视频会议中,通过真实同步的面部表情和口型,提高了整体的真实感和观看体验。

- 支持复杂的面部编辑和个性化:如在SegTalker中提到的,该技术还支持通过掩码和风格代码进行复杂的面部局部编辑和纹理交换,这为个性化和创意表达提供了更多可能性。

这些技术的进步使得说话人脸生成不仅在娱乐和媒体产业中有广泛应用,也在教育、远程工作及其他多个领域展现出其潜在价值。

论文作者:Lingyu Xiong,Xize Cheng,Jintao Tan,Xianjia Wu,Xiandong Li,Lei Zhu,Fei Ma,Minglei Li,Huang Xu,Zhihu Hu

作者单位:South China University of Technology; Zhejiang University; Huawei Cloud Computing Technologies Co., Ltd; Peking University; Guangdong Laboratory of Artificial Intelligence and Digital Economy

论文链接:http://arxiv.org/abs/2409.03605v1

内容简介:

1)方向:音频驱动的说话人脸生成

2)应用:音频驱动的说话人脸生成

3)背景:音频驱动的说话人脸生成旨在合成与输入音频同步的口型视频。然而,现有生成技术在保持面部复杂区域纹理(如皮肤、牙齿)方面面临挑战,导致合成视频的视觉质量下降。

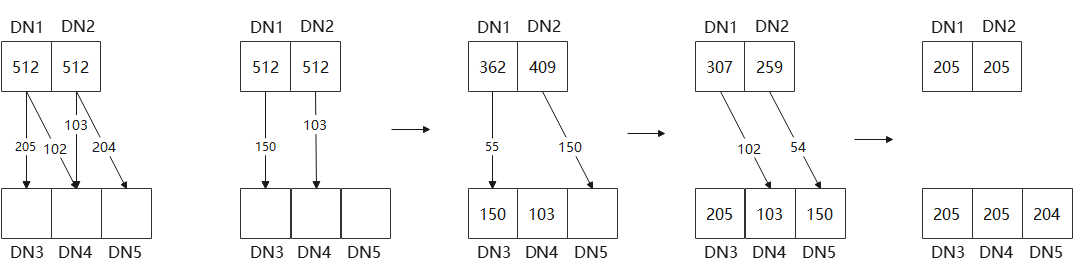

4)方法:为了解决这些问题,提出一种新的框架SegTalker,通过引入分割作为中间表示来解耦口型运动和图像纹理。具体来说,首先通过一个解析网络生成图像的掩码,然后利用音频驱动掩码生成说话分割。接着,通过掩码引导编码器将图像的语义区域解耦为风格代码。最后,将生成的说话分割和风格代码注入到一个掩码引导的StyleGAN中,合成视频帧,从而最大程度上保留了纹理。此外,该方法还能自然实现背景分离,并促进基于掩码的面部局部编辑,如通过编辑掩码和从参考图像中交换区域纹理(如头发、嘴唇、眉毛)来实现无缝的面部编辑。

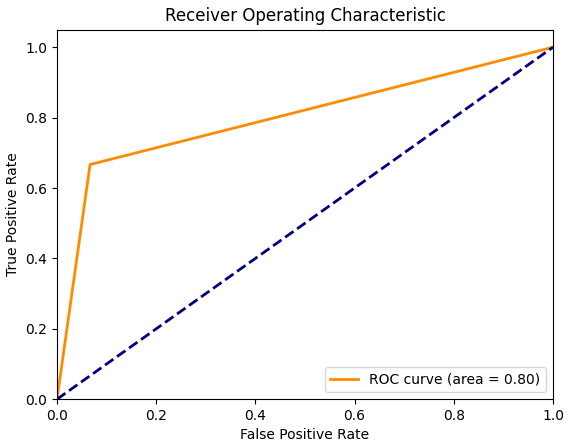

5)结果:实验表明,SegTalker方法能够有效保留纹理细节,并生成时间一致性较好的视频,同时在口型同步方面保持竞争力。在HDTF和MEAD数据集上的定量和定性结果显示,SegTalker的性能优于现有方法。