OpenAI发布Sora模型后,掀起了AI视频生成热潮,一段60秒的视频不仅让ai领域的从业者兴奋不已,也让全世界的资本聚集在了这个领域上。

国内玩家在这个赛道也是卷了又卷。字节跳动的即梦AI,快手的可灵AI,智谱AI的CogVideoX一一走上了牌桌。9月11日,由生数科技和清华大学联合研发的国产自研原创视频大模型Vidu也迎来升级更新,上线了“主体参照”(Subject Consistency)功能,在其官网中名为“参考生视频”。

据生数科技的相关负责人说,该功能能够实现对任意主体的一致性生成,目的是让视频生成更加稳定、可控。

“主体参照”的主要功能包括:

单一主体一致性:确保单一角色或物体在生成的图像中保持一致;

角色控制:支持真人、动物等各种类型角色的一致性;

同时支持不同的艺术风格(如写实、2D、3D等)的控制;

身体控制:该功能还提供角色面容、半身和全身图像的一致性控制;

支持商业广告场景的应用。

Bulu测试了用真人、动画人物、二次元人物都测试了一下这个功能,展示下部分的生成视频:

用上图“关羽”作为主体,提示词:关羽在成都春熙路跳舞。生成的视频以下⬇️

用上图“林黛玉”作主体,提示词:林黛玉穿职业装,在咖啡馆喝咖啡。生成的视频以下⬇️

用二次元人物作为主体,提示词:樱花树下,银发紫眸的二次元帅哥突然出现,对我轻轻弹唱。生成的视频以下⬇️

整体使用感受还不错:

生成速度比较快,生成4秒视频时间不超过30秒;

摒弃了传统的分镜头画面生成步骤,通过“上传主体图片+输入场景描述词”的方式,直接生成视频素材;

对提示词理解能力还不错,生成结果比较精准;

另外,对动漫风格优化的会好一些,能保持风格的一致性,写实的效果相对差一点。

话说回来,目前市场上大部分视频模型在生成视频时不稳定。比如:有时候主体、场景或者风格不能保持一致,特别是在需要进行复杂互动的时候这个问题更突出。另外,这些模型生成的结果往往带有很大的随机性,这意味着用户可能需要多次尝试才能得到满意的结果,并且对于像镜头运动、光影效果这样的细节,还不能做到精确控制。

不得不说,Vidu针对上述提到的这个痛点上做了优化。在“主体参照”功能下,用户只需上传一张任意主体的图片,就可以锁定该主体的形象,并通过输入不同的描述词来变换场景,从而生成主体形象一致的视频。

据官方说,此功能不仅限于单一人物,还可以应用于动物、商品、动漫角色以及虚构对象等各种不同的主体。感兴趣的朋友,可以去尝试下。

使用步骤

1

登陆Vidu官网:https://www.vidu.studio

2

用邮箱或手机号注册

新用户注册有80个积分,生成1个视频消耗4积分,也就是可以免费生成20个4秒的视频邮箱

3

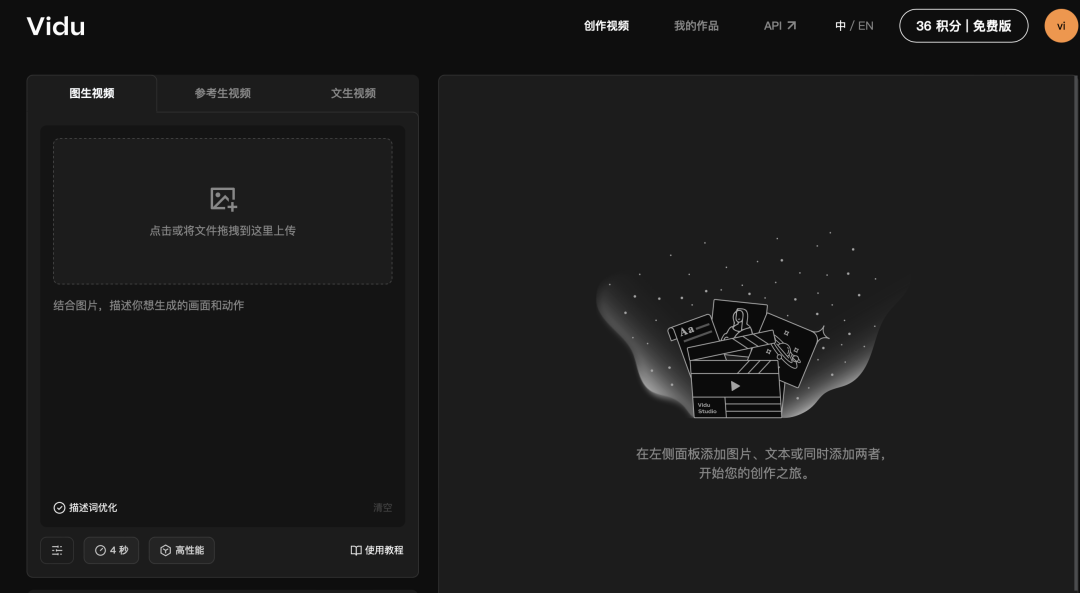

点击“创作视频”,进入创作页面

如上图所示,Vidu目前有三个功能:图生视频、参考生视频、文生视频。

操作界面比较简单,输入提示词点击创作,等待一会,就可以得到生成的视频。