1 问题

卷积层的输入输出的shape的计算公式

探究多个卷积层加上多个全连接层的输出方法

2 方法

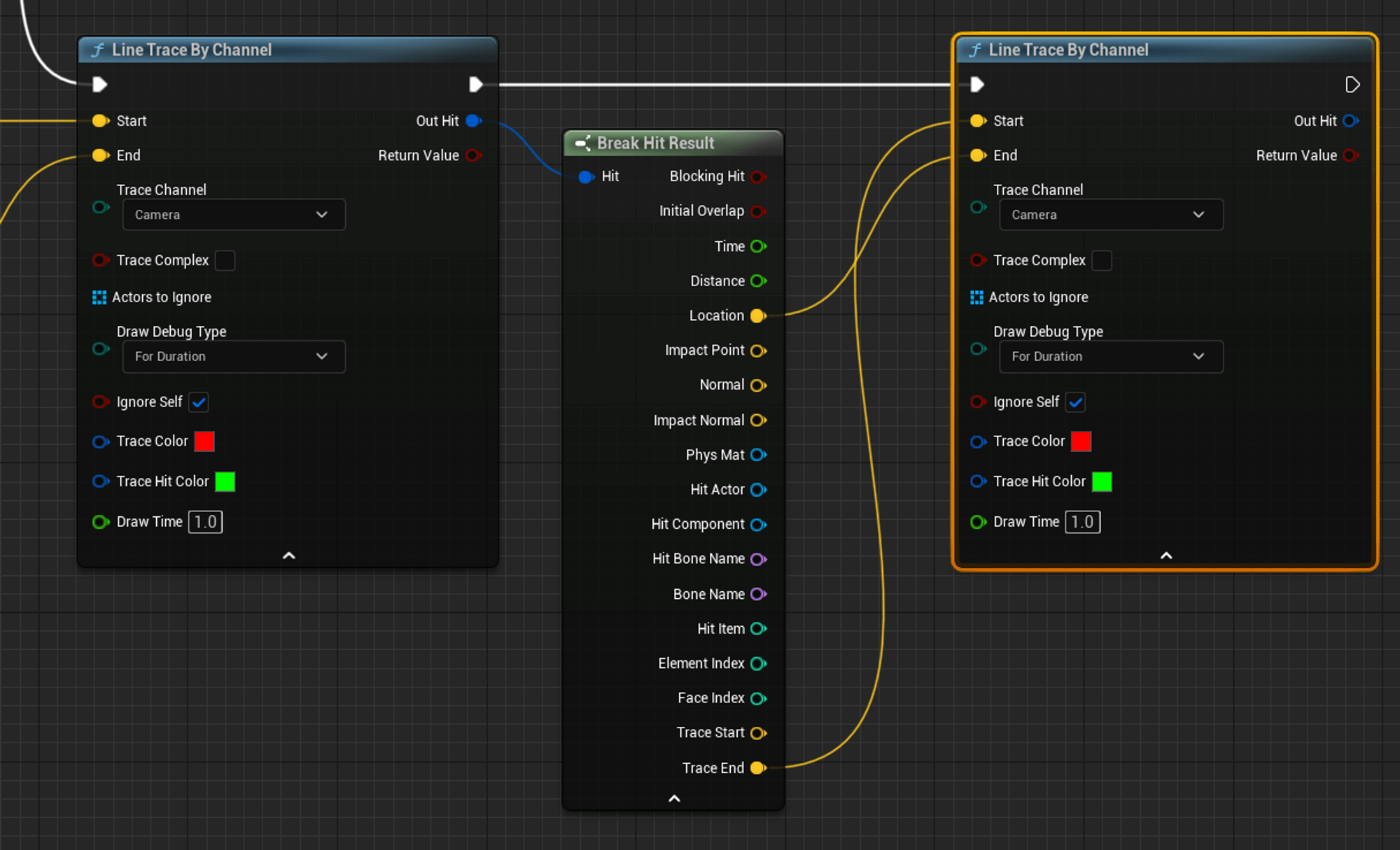

| 卷积层的输入输出的shape的计算公式: 输出形状的计算公式: 输出高度 = (输入高度 - 卷积核高度 + 2 * 填充) / 步长 + 1 输出宽度 = (输入宽度 - 卷积核宽度 + 2 * 填充) / 步长 + 1 输出通道数 = 卷积核数量 输入形状的计算公式: 输入高度 = (输出高度 - 1) * 步长 - 2 * 填充 + 卷积核高度 输入宽度 = (输出宽度 - 1) * 步长 - 2 * 填充 + 卷积核宽度 输入通道数 = 卷积核数量 其中,输入高度和宽度为输入张量的高度和宽度,卷积核高度和宽度为卷积核的高度和宽度,填充是指在输入的周围填充0的行数或列数,步长是卷积核在输入上滑动的步幅。 探究多个卷积层加上多个全连接层的输出方法: 在PyTorch中,可以使用nn.Conv2d定义卷积层,使用nn.Linear定义全连接层。例如,假设我们有两个卷积层conv1和conv2,以及三个全连接层fc1、fc2和fc3。  接下来,我们可以通过将输入数据传递到这些层中来获得输出。在PyTorch中,可以使用层的前向方法(使用层的前向方法指的是通过将输入数据传递给神经网络模型的不同层,从而获得模型的输出。在神经网络中,每一层都会对输入数据进行一些特定的数学计算(如线性变换和激活函数的应用),并生成一个新的表示或特征。这个过程从输入层开始,逐层向前传递,直到达到输出层,最终获得模型的预测结果。使用层的前向方法的目的是通过引入非线性变换和特征提取,从而实现对输入数据的抽象和表示学习。通过层与层之间的连接,神经网络可以逐渐捕捉到数据中的复杂模式和关系,从而提高模型的性能。)来实现这一点。例如,我们可以按照以下方式处理输入数据x:  在这个例子中,首先将输入数据传递到conv1,然后将其输出传递到conv2。接下来,使用view方法将输出的张量展平为一维向量,以便传递给全连接层。最后,将数据传递到fc1、fc2和fc3中,获得最终的输出。 |

3 结语

针对多个卷积层加上多个全连接层的输出方法,提出向前传播的方法,通过本次实验,证明该方法是有效的,本文的代码的模型参数没有初始化,不利于优化的训练模型。这种结构可以应用于各种图像分类和目标检测等任务中,通过增加更多的卷积层和全连接层,可以构建更深层次的网络模型,从而获得更准确的预测结果。