目录

- 一、引言

- 二、ViLaln框架介绍

- 总体框架概述

- 对象估计器

- 初始状态估计器

- 目标估计器

- 纠错重提示机制(CR)

- 参考文献

一、引言

随着机器人技术的不断发展,如何通过自然语言指令引导机器人执行任务成为了一个重要的研究方向。自然语言作为人与机器人互动的一种直观方式,能够帮助非技术用户轻松下达任务。然而,传统的机器人任务规划方法,尤其是符号规划方法,尽管具有较好的解释性,但在处理复杂环境时显得不够灵活。而现代语言指导的机器人规划系统,尽管可以直接从语言指令中生成任务计划,却往往难以保证逻辑的正确性和系统的可解释性。

本文将介绍ViLaIn框架,它结合了视觉-语言模型与符号规划器,旨在通过语言指令和视觉信息生成可执行的任务描述文件(Problem Description, PD)。这一框架为机器人任务规划提供了新的解决方案,能够有效地提高任务规划的解释性和执行的准确性。

二、ViLaln框架介绍

总体框架概述

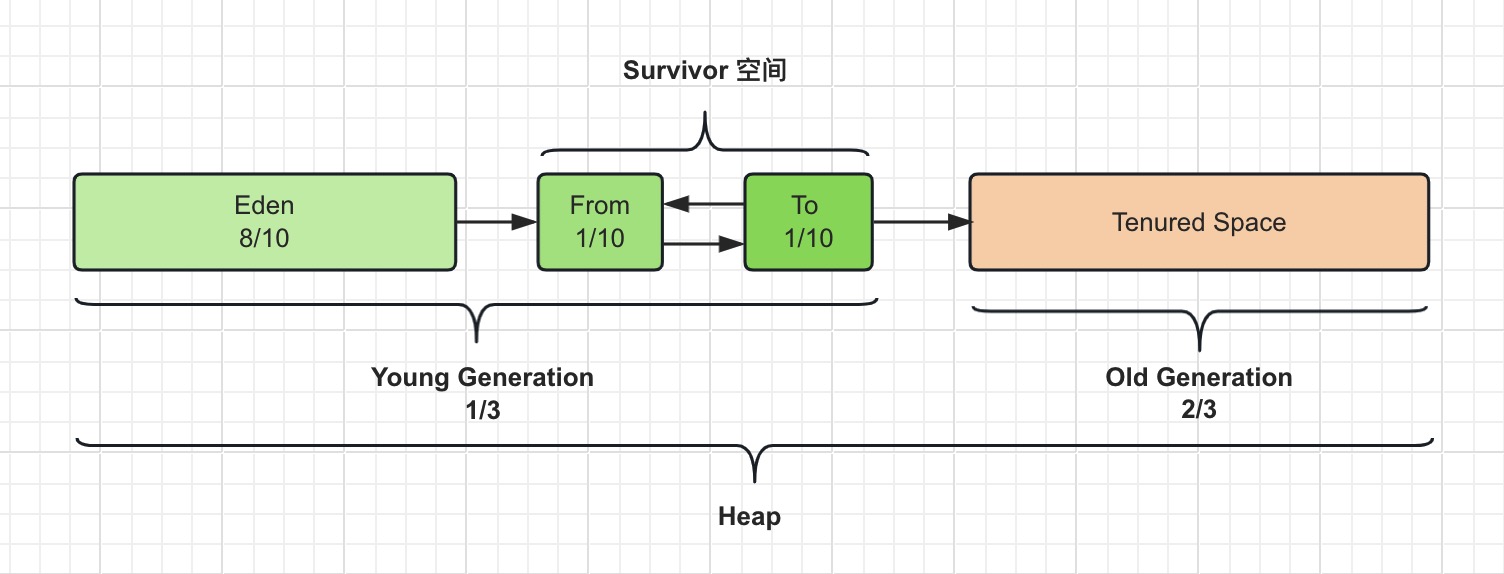

ViLaIn框架是一个将自然语言指令与场景观测结合,并最终生成任务描述文件的系统。其核心思想是通过视觉-语言模型生成符号化的任务描述,并通过符号规划器生成机器人执行任务的计划。ViLaIn框架主要由三大模块组成:对象估计器、初始状态估计器和目标估计器。此外,ViLaIn还具备一种纠错重提示机制,通过符号规划器的反馈不断优化任务描述的生成。

对象估计器

对象估计器的任务是从场景图像中检测并识别出任务相关的物体。ViLaIn采用了开放词汇的对象检测器——Grounding-DINO,它能够识别出场景中几乎所有任务相关的物体。识别出的物体将被转换为PDDL(Planning Domain Definition Language)格式的符号对象,以便用于后续的任务描述生成。

这种对象估计的过程至关重要,因为它能够帮助系统自动化地生成初始环境的物体信息,而这一信息通常是自然语言指令中未明确描述的。例如,对于“将胡萝卜切好放进碗里”这样的指令,系统需要识别出“胡萝卜”、“碗”和“刀”等物体,以生成有效的任务描述。

初始状态估计器

初始状态估计器通过视觉和语言模型生成任务的初始状态。ViLaIn采用BLIP-2模型生成每个物体的描述,然后结合GPT-4从这些描述和场景中提取初始状态,并使用PDDL格式对这些状态进行符号化表示。

例如,场景中看到胡萝卜放在砧板上,初始状态可以用PDDL表示为(at carrot cutting_board),即“胡萝卜位于砧板上”。这个模块确保生成的任务描述能够准确反映当前的环境状态,为后续规划提供基础。

目标估计器

目标估计器负责从自然语言指令中生成任务的目标状态。GPT-4通过少量提示学习技术,从指令中提取任务的具体目标,并转换为PDDL格式的目标状态描述。例如,对于“将胡萝卜切好放进碗里”这条指令,目标状态可以表示为(and (at carrot bowl) (is-sliced carrot)),即“胡萝卜被切好并且放在碗里”。

这个过程不仅需要从指令中提取出任务的核心目标,还需要考虑之前生成的对象和初始状态之间的关系,确保目标与现实的物体信息一致。

纠错重提示机制(CR)

ViLaIn的纠错重提示机制(Corrective Re-prompting, CR)是系统中一个重要的反馈循环。当生成的任务描述存在错误或逻辑冲突时,符号规划器会返回错误信息,ViLaIn通过这些反馈重新生成任务描述或对其进行修改。这种迭代机制确保了最终生成的任务描述能够被符号规划器正确解析并执行。

为了提高纠错效率,ViLaIn引入了“思维链提示”(Chain-of-Thought, CoT)技术,该技术帮助GPT-4通过解释错误原因来改进任务描述。通过这种纠错机制,ViLaIn能够反复优化生成的任务描述,直到其符合符号规划器的要求并能够生成有效的计划。

参考文献

[1] Shirai K, Beltran-Hernandez C C, Hamaya M, et al. Vision-language interpreter for robot task planning[C]//2024 IEEE International Conference on Robotics and Automation (ICRA). IEEE, 2024: 2051-2058.