主成分分析是⼀种常⽤的降维技术,⽤于将⾼维数据集投影到低维空间中,同时保留数据集的主要特征。PCA通过寻找数据中最重要的⽅向(主成分),并将数据投影到这些⽅向上来实现降维。

1.基本原理

1、数据中心化:⾸先,对原始数据进⾏中⼼化处理,即将每个特征的均值减去每个数据点的对应特征值,以确保数据的均值为零。

2、协方差矩阵:然后,计算数据的协⽅差矩阵,该矩阵表示了不同特征之间的关联性。

3、特征值分解:对协⽅差矩阵进⾏特征值分解,找到其特征值和特征向量。

4、选择主成分:选择具有最⼤特征值的特征向量,这些特征向量构成了数据在低维⼦空间上的新坐标轴,被称为主成分。

5、投影:将原始数据投影到所选的主成分上,从⽽实现数据的降维。

2.公式模型

1、数据中⼼化:对于⼀个包含m个样本和n个特征的数据矩阵 ,⾸先计算每个特征的均值 ,然后进⾏中⼼化处理,得到中⼼化的数据矩阵 :

2、协方差矩阵:计算中⼼化数据的协⽅差矩阵C ,m其中 是样本数:

3、特征值分解:对协⽅差矩阵C进⾏特征值分解,得到特征值y1,y2,...,yn和对应的特征向量v1,v2,...,vn。特征向量vi代表数据在新的主成分⽅向上的投影。

4、选择主成分:通常,选择前k个特征值对应的特征向量,它们构成了数据的主成分。这些特征向量通常按照特征值的大小降序排列。

5、投影:将原始数据矩阵X投影到所选的主成分上,得到降维后的数据矩阵Y:

Y=VX

其中,V 是包含选定主成分特征向量的矩阵。

通过PCA,可以将⾼维数据映射到低维空间,从⽽减少了数据的维度。这有助于数据可视化、去除冗余特征、加速机器学习模型的训练,并提⾼模型的泛化性能。选择合适的降维维度(主成分数量)是PCA的⼀个关键参数,通常需要根据问题和性能需求进⾏调整。

3.优缺点

优点:

1. 降低数据维度:PCA能够将⾼维数据降维到较低维度,减少数据存储和计算成本。

2. 保留数据主要特征:PCA通过保留数据集中⽅差最⼤的⽅向,尽可能地保留了数据的主要特征。

3. 减少数据噪⾳:PCA可以将数据投影到主成分上,减少数据中的噪⾳和冗余信息。

缺点:

1. 对线性关系敏感:PCA假设数据是线性相关的,对⾮线性关系的数据降维效果可能不佳。

6. 可解释性差:PCA得到的主成分通常难以解释其含义,因为它是数据的线性组合。

7. 对异常值敏感:PCA对异常值较为敏感,可能会影响主成分的计算结果。

4.适用场景

主成分分析适⽤于以下场景:

- 数据维度较⾼:当数据维度较⾼时,可以使⽤PCA将数据降维到较低维度。

- 数据存在多重共线性:当数据中存在多重共线性(即特征之间存在线性相关性)时,PCA可以减少特征之间

的冗余信息。 - 数据可视化:PCA可以将⾼维数据可视化到⼆维或三维空间中,帮助⼈们理解数据的结构和特征。

主成分分析可以帮助我们减少数据的维度并保留数据的主要特征。然⽽,在使⽤PCA时需要注意数据的线性关系和异常值的影响

5.手写数字识别数据集主成分分析

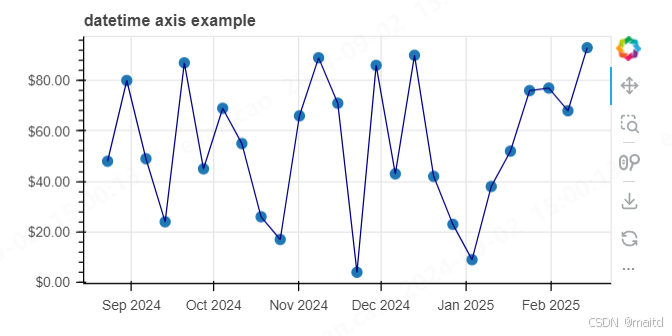

使⽤⼿写数字识别数据集(MNIST dataset)进⾏主成分分析,并展示降维后的数据可视化结果:

import numpy as np

import matplotlib.pyplot as plt

from sklearn.datasets import load_digits

from sklearn.decomposition import PCA

# 加载⼿写数字识别数据集

digits = load_digits()

X = digits.data

y = digits.target

# 构建PCA模型并拟合数据

pca = PCA(n_components=2)

X_pca = pca.fit_transform(X)

# 可视化降维后的数据

plt.figure(figsize=(10, 8))

scatter = plt.scatter(X_pca[:, 0], X_pca[:, 1], c=y, cmap='viridis', s=20, alpha=0.7)

plt.colorbar(scatter)

plt.title('2D PCA Visualization of MNIST Dataset')

plt.xlabel('Principal Component 1')

plt.ylabel('Principal Component 2')

plt.show()

⾸先加载了⼿写数字识别数据集,并使⽤PCA将数据降维到2维空间。然后绘制降维后的数据的散点图,其中每个点代表⼀个⼿写数字样本,不同颜⾊代表不同的数字类别。