一、介绍

模型GitHub网址:MVSEP-MDX23-music-separation-model/README.md 在 main ·ZFTurbo/MVSEP-MDX23-音乐分离模型 ·GitHub 上

在音视频领域,把已经发布的混音歌曲或者音频文件逆向分离一直是世界性的课题。音波混合的物理特性导致在没有原始工程文件的情况下,将其还原和分离是一件很有难度的事情。

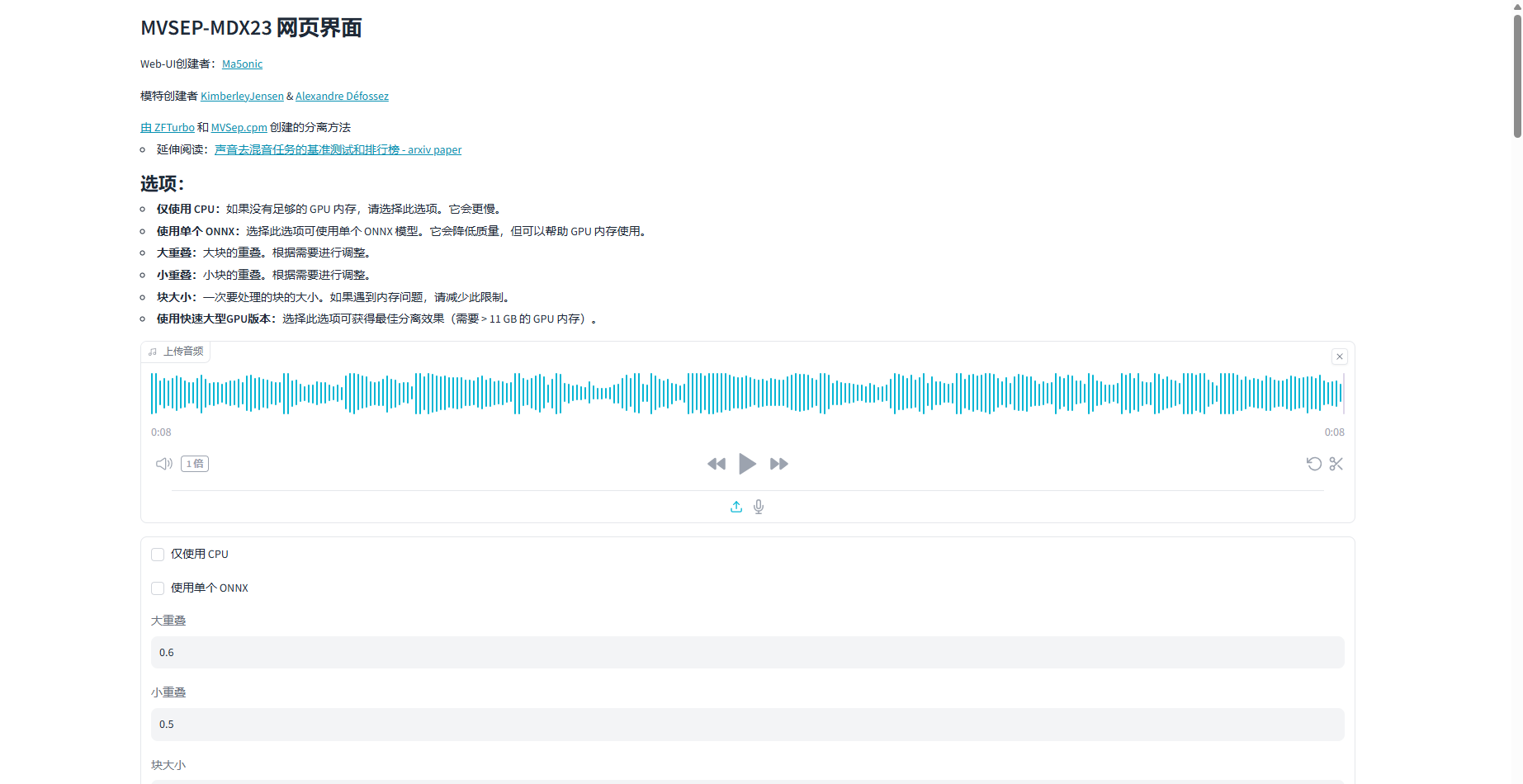

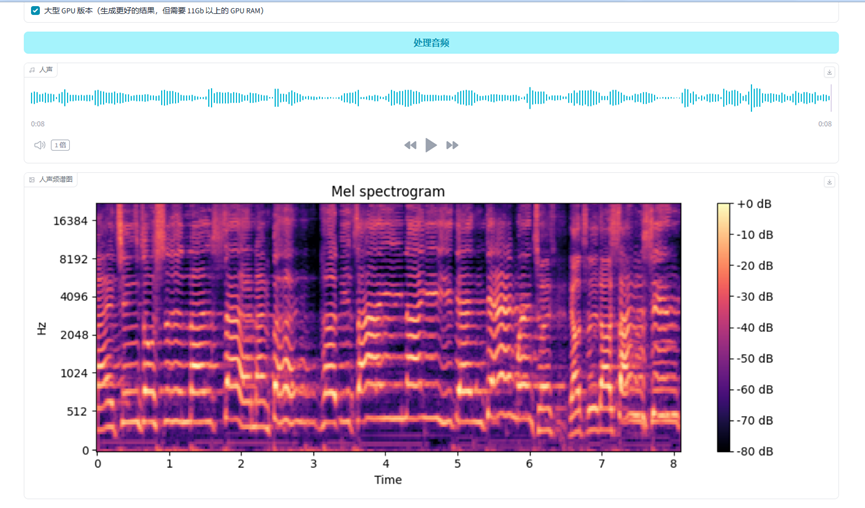

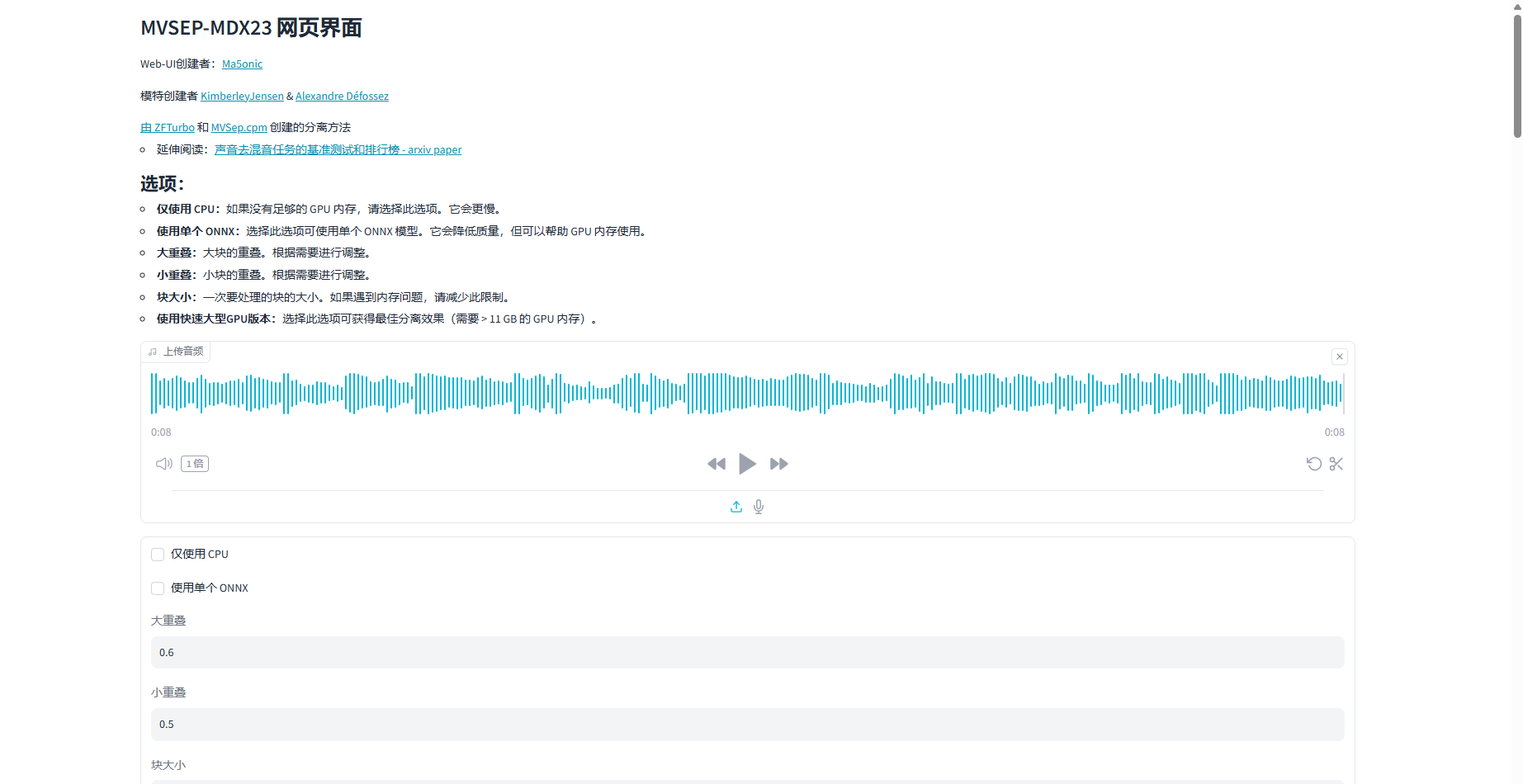

MVSEP-MDX23在音频分离的性能和精度上表现出色,尤其适合需要高质量音频分离的专业用户。MVSEP-MDX23音乐分离模型是基于 Demucs4、MDX 神经网络架构和 Ultimate Vocal Remover 项目中的一些 MDX 权重。该模型在MultiSong 数据集上执行的最佳分离模型进行质量比较,发现该模型在SDR(信噪比)中比Demucs HT 4、Demucs 3、MDX B模型效果好。该模型有图形用户界面,web界面,本容器主要运用web界面,如下图所示。

将对上传的音频文件进行声音分离及显示频谱信息,分为人声、仪器、器乐、低音、鼓、其他六部分,以及相应的频谱图:

二、容器构建说明

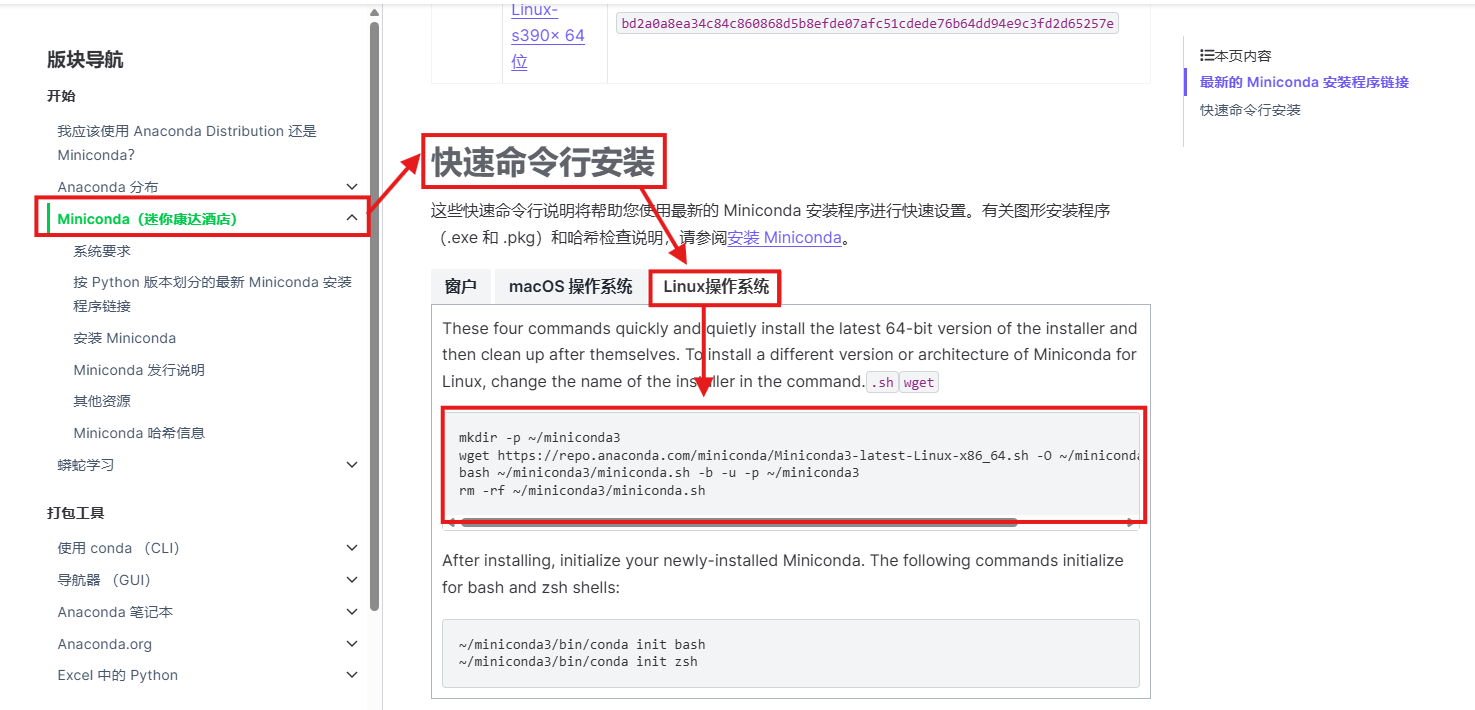

1. 安装miniconda

进入Anaconda官网:

Miniconda — Anaconda 文档

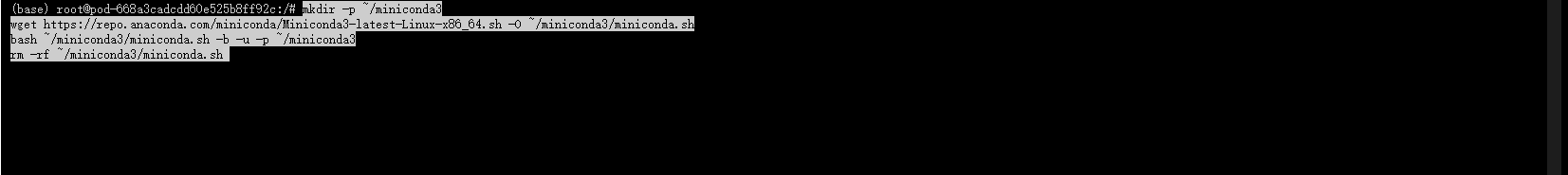

找到快速命令行安装,选择Linux系统,复制代码进入Web SSH中粘贴进行安装

等待安装完成

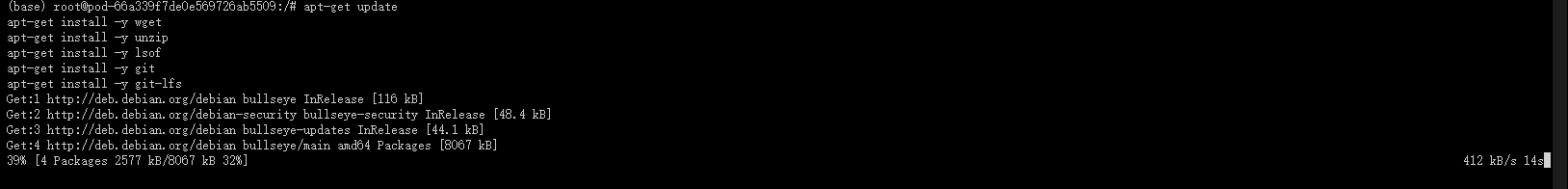

2. 安装并更新基础命令,供后续使用更快捷: wget、unzip、lsof、git、git-lfs

apt-get update

apt-get install -y wget

apt-get install -y unzip

apt-get install -y lsof

apt-get install -y git

apt-get install -y ffmpeg

3. 首先将仓库(GitHub)代码下载:直接输入

git clone https://github.com/ZFTurbo/MVSEP-MDX23-music-separation-model.git

MVSEP-MDX23-music-separation-model/README.md 在 main ·ZFTurbo/MVSEP-MDX23-音乐分离模型 ·GitHub 上

4. 安装项目运行所需的环境:(安装pytorch使用的清华源,可以将pip改为永久源)

pip config set global.index-url https://pypi.tuna.tsinghua.edu.cn/simple

(1)打开项目文件所在位置

cd MVSEP-MDX23-music-separation-model

(2)创建名为ck的虚拟环境python版本为3.10

conda create -n ck python=3.10

遇到下列代码行时输入y回车后将继续创建

(3)激活ck虚拟环境

conda activate ck

(4)安装所需的pytorch12.1版本,用了清华源镜像

pip install torch torchvision --index-url https://download.pytorch.org/whl/cu121 -i https://pypi.tuna.tsinghua.edu.cn/simple

(5)安装依赖环境

pip install -r requirements.txt

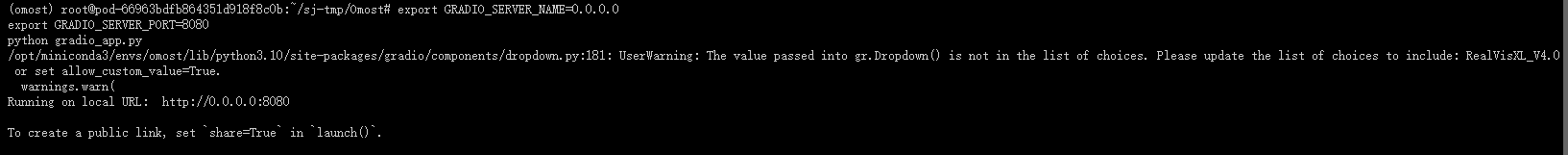

(6)安装完成,指定端口即可启动项目,启动命令如下:

export GRADIO_SERVER_NAME=0.0.0.0

export GRADIO_SERVER_PORT=8080

python web-ui.py

出现以下页面代表运行成功:

三、网页演示

运行成功后获取访问链接,进入 webUI 界面后即可操作:

![BaseCTF [Week2] 最简单的编码](https://i-blog.csdnimg.cn/direct/b35a3fdda5ac4e9794db823a57aaf230.png)