本来想将近期另一篇DeepSeek的“DeepSeek-Prover-V1.5: Harnessing Proof Assistant Feedback for Reinforcement Learning and Monte-Carlo Tree Search”与这篇同样基于强化学习思想的小型清爽型推理模型放在一个笔记中相互对比借鉴一下,考虑虽然两者有着一些共通之处,但仔细想了一下两者间其实在奖励模型、探索与利用策略、环境反馈机制及领域任务上有着各自特色与思想差异,因此还是决定分别提炼分享下~

我的一些简单观点和想法:

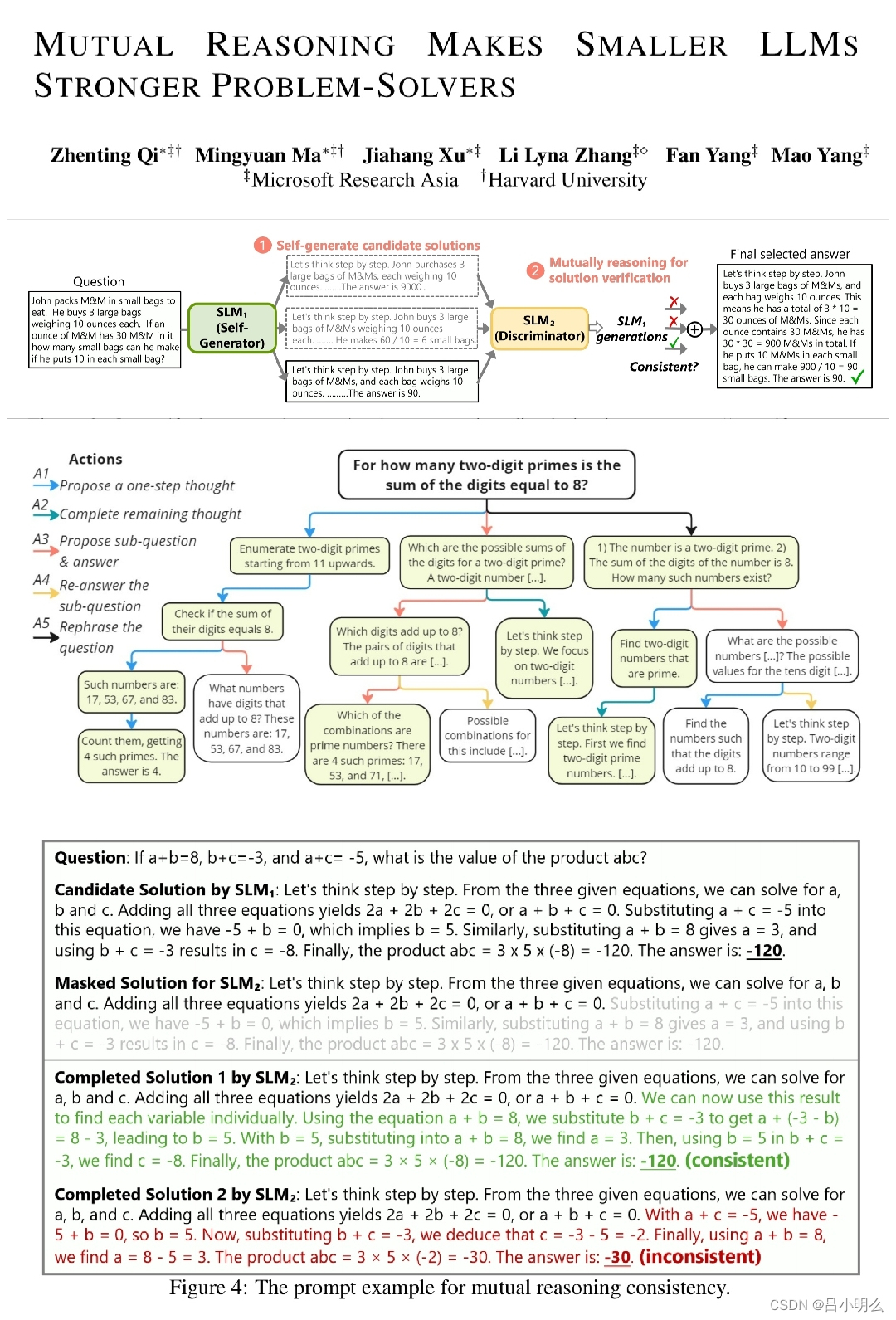

Ⅰ. 采用类似人类同行评议的思想来进行相互一致性推理验证:

这点不用多说,也是这篇论文作者们的核心观点,其中在这种相互一致性方法中,作者也采取了一些诸如基于历史步骤提示方法来进行某种增强的验证技巧,我想这里也许还有更多潜在的增强性tricks可挖;)。

Ⅱ. 对于空间探索与利用方面:

rStar在推理空间的探索上创新性的尝试采用某种先验拟人式推理模式,如引入了一组更丰富的5个动作..以提升推理空间潜力。

Ⅲ. 对于奖励方面:

为了确保在不同的推理任务之间的泛化,没有额外采用例如外部形式化验证工具或经过训练的其它价值监督模型。同时借鉴了alphago的最终答案奖励传递思想(这一点我认为也是基于本文这种多样化行动策略下对应的探索空间的复杂性之上领域泛化性考虑)

ps:有想进一步了解其中方法内涵的小伙伴建议直接读原论文,篇幅不长分分钟搞定。