每周跟踪AI热点新闻动向和震撼发展 想要探索生成式人工智能的前沿进展吗?订阅我们的简报,深入解析最新的技术突破、实际应用案例和未来的趋势。与全球数同行一同,从行业内部的深度分析和实用指南中受益。不要错过这个机会,成为AI领域的领跑者。点击订阅,与未来同行! 订阅:https://rengongzhineng.io/

点击下面视频观看在B站本周AI更新:

B 站 链接 观看:

本周AI新闻: 谷歌老施讲,微软Phi 3.5和Search GPT_哔哩哔哩_bilibili想要探索生成式人工智能的前沿进展吗?订阅我们的简报,深入解析最新的技术突破、实际应用案例和未来的趋势。与全球数同行一同,从行业内部的深度分析和实用指南中受益。不要错过这个机会,成为AI领域的领跑者。点击订阅,与未来同行! 订阅: https://rengongzhineng.io/1) Phi 3.5 https://huggingface.co/microsoft.2) https://www., 视频播放量 1、弹幕量 0、点赞数 0、投硬币枚数 0、收藏人数 0、转发人数 0, 视频作者 内哥谈技术, 作者简介 N哥,新加坡。订阅中文简报,成为AI领域的领跑者。https://rengongzhineng.io/,相关视频:谷歌商店安装教程,20240806美股日股崩盘前后村长Taylor个人的操作记录和未来展望和风险提醒,MHC Talker AI智能口型方案,支持MetaHuman角色,一键三连私信领取测试,本周AI新闻:一封前OpenAI研发人员关于AGI的公开信,本周AI新闻:Google 推出gemma 2, Kyutai 开源 Moshi 和 Runway Gen-3挑战 Sora,本周AI新闻: 熟悉的铛铛铛铛音乐响起的时候,Intel还Inside吗?,前谷歌CEO斯密特的斯坦福猛料,本周AI新闻: X推出的惊人逼真的但不受约束的图像生成器和 GooglePixel 9,本周AI新闻:阿尔茨海默病和艾滋病进展和AI制药巨大前景,本周AI新闻: 开源AI王者归来的一周![]() https://www.bilibili.com/video/BV1ADWdeSEfR/

https://www.bilibili.com/video/BV1ADWdeSEfR/

想要探索生成式人工智能的前沿进展吗?订阅我们的简报,深入解析最新的技术突破、实际应用案例和未来的趋势。与全球数同行一同,从行业内部的深度分析和实用指南中受益。不要错过这个机会,成为AI领域的领跑者。点击订阅,与未来同行! 订阅: https://rengongzhineng.io/

1) Phi 3.5 https://huggingface.co/microsoft.

2) https://www.midjourney.com/home

Phi-3 模型系列简介

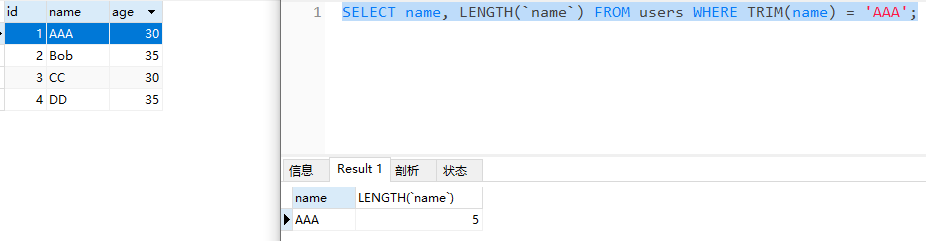

Phi-3 模型系列是微软小型语言模型(SLM)家族的最新成员。它们的设计目标是提供高性能且经济实惠的解决方案,在语言、推理、编程和数学等多个基准测试中,表现优于同类甚至更大型的模型。Phi-3 模型的推出,为 Azure 用户提供了更多高质量的模型选择,帮助他们更好地构建生成式 AI 应用程序。

自 2024 年 4 月发布以来,微软从客户和社区成员那里收到了大量关于 Phi-3 模型改进建议的宝贵反馈。今天,微软自豪地宣布推出 Phi-3.5-mini、Phi-3.5-vision 以及 Phi 家族的新成员 Phi-3.5-MoE,这是一种专家混合(MoE)模型。

- Phi-3.5-mini 增强了多语言支持,支持 128K 上下文长度。

- Phi-3.5-vision 改进了多帧图像理解和推理,提升了单帧图像基准测试的表现。

- Phi-3.5-MoE 拥有 16 个专家模块和 6.6 亿个活跃参数,提供高性能、低延迟、多语言支持和强大的安全措施,同时保持 Phi 模型的效能,超越了更大型的模型。

Phi-3.5-MoE: 专家混合模型

Phi-3.5-MoE 是 Phi 模型家族的最新成员。它由 16 个专家组成,每个专家包含 38 亿个参数。整个模型的总参数量达到 420 亿,在使用两个专家时会激活 66 亿个参数。相比于同等规模的密集模型,这种 MoE 模型在质量和性能方面表现更好。

主要特点:

- 支持语言:超过 20 种。

- 安全策略:MoE 模型采用了健全的安全后训练策略,结合了开源和专有的合成指令和偏好数据集。这一过程整合了监督微调(SFT)和直接偏好优化(DPO),使用包括人工标注和合成数据集在内的数据,涵盖了帮助性、无害性以及多种安全类别。

- 上下文长度:支持最高 128K 上下文长度,适合处理长上下文任务。

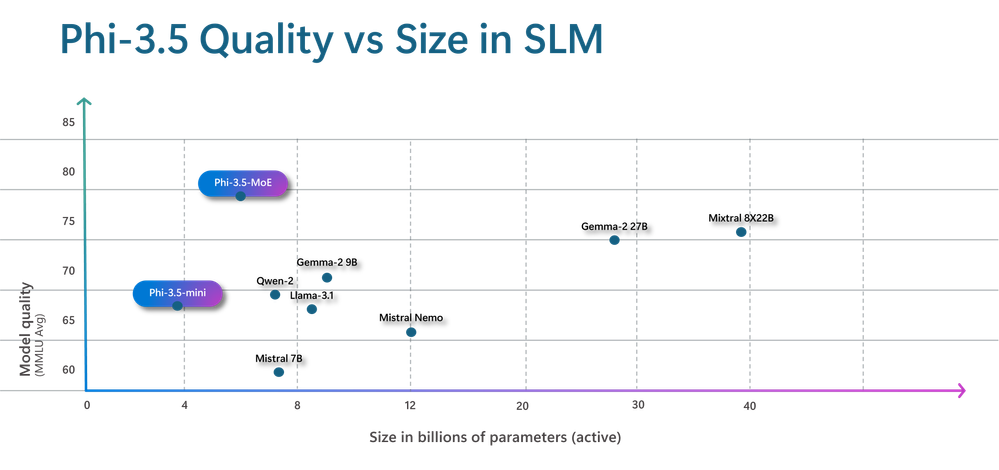

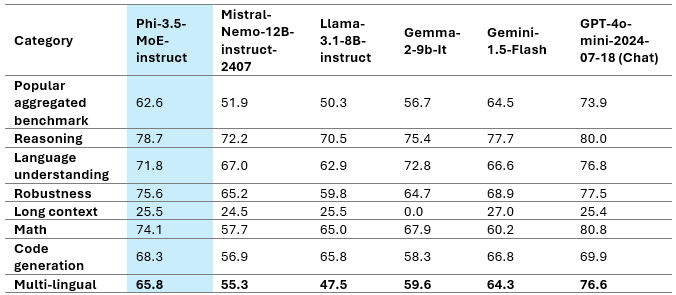

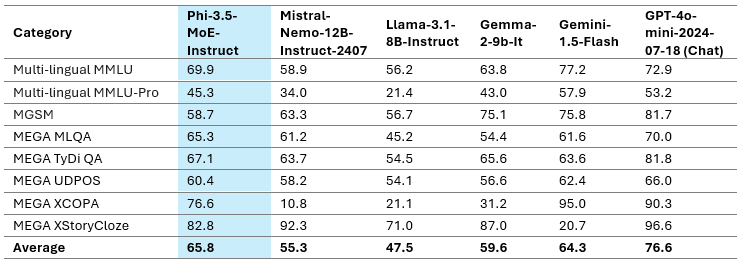

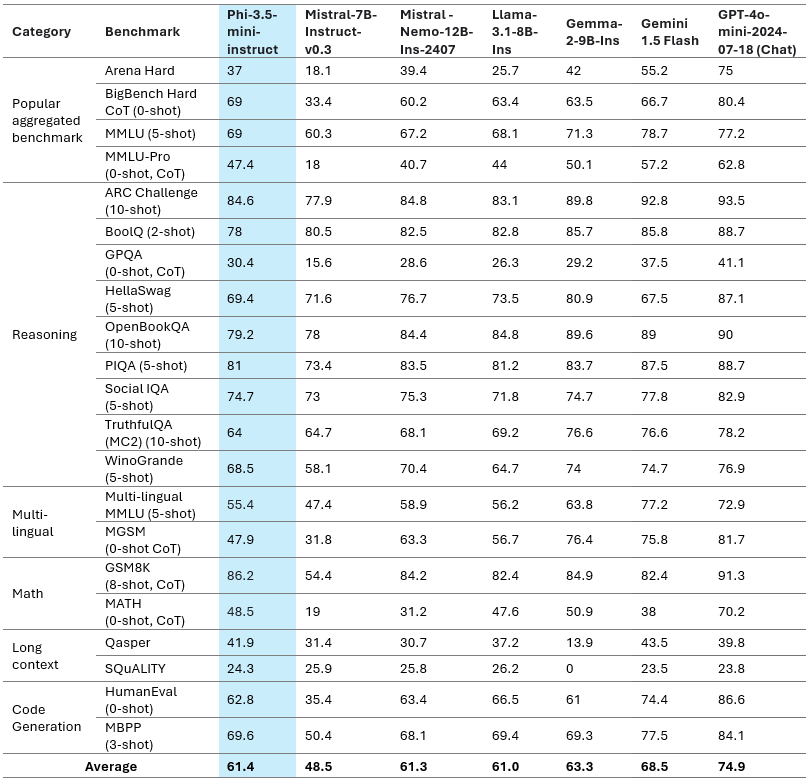

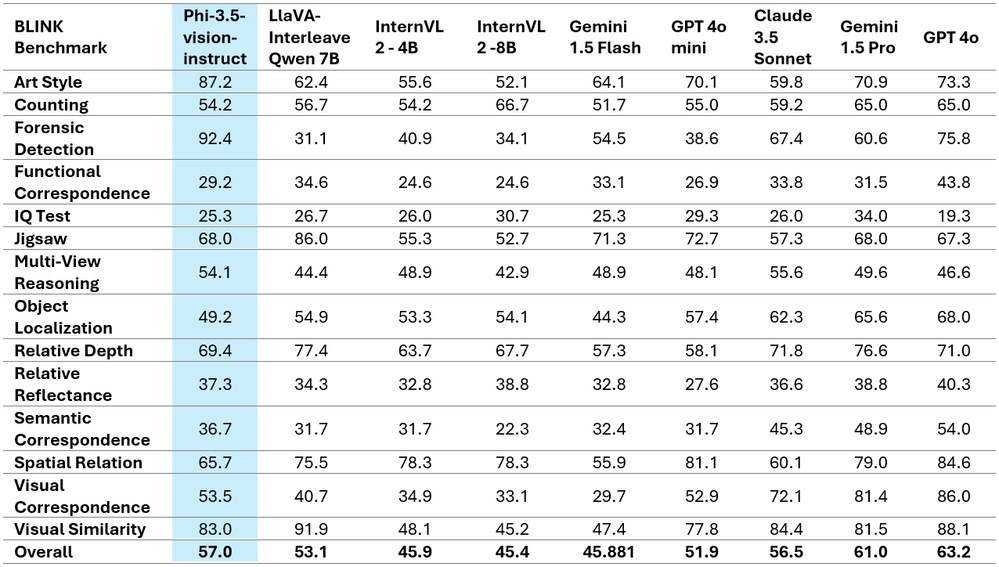

性能评估

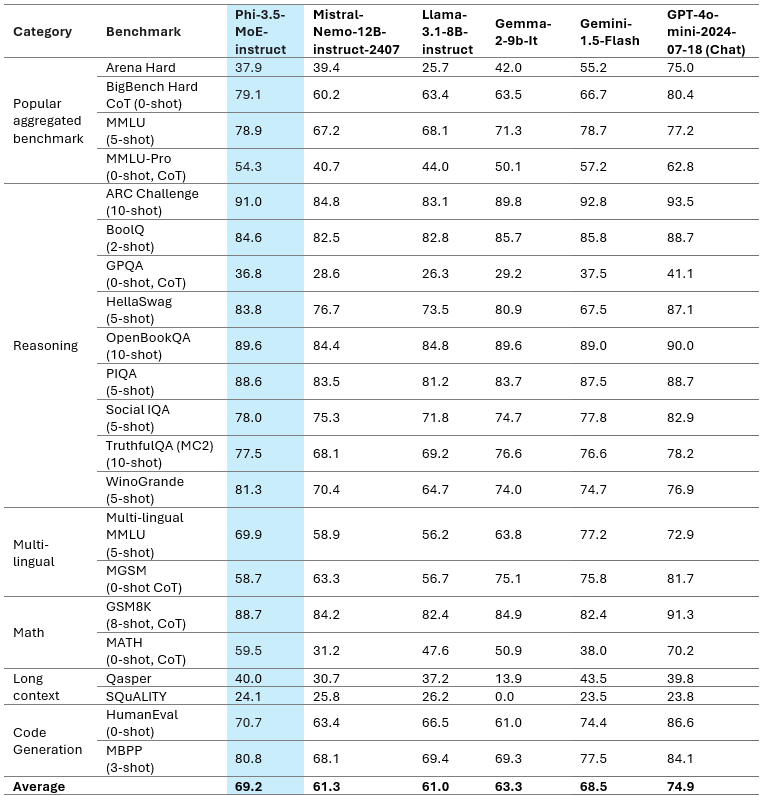

通过多个基准测试,微软比较了 Phi-3.5-MoE 与其他模型的表现。尽管仅有 66 亿活跃参数,Phi-3.5-MoE 在语言理解、数学能力和推理能力方面达到了与更大模型相当甚至超越的水平。此外,该模型在多语言任务中也表现出色,能够与参数量更大的模型竞争。

Phi-3.5-mini 模型

Phi-3.5-mini 模型在多语言合成和高质量筛选数据上进行了进一步的预训练,随后经过了监督微调(SFT)、近端策略优化(PPO)和直接偏好优化(DPO)。这些步骤使用了人工标注、合成和翻译数据集。

主要特点:

- 参数量:38 亿。

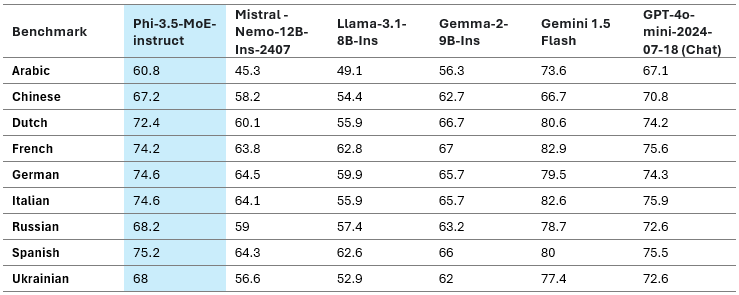

- 多语言支持:该模型对多语言、多轮对话质量和推理能力进行了大幅提升,支持包括阿拉伯语、中文、英语等在内的多种语言。

- 性能提升:Phi-3.5-mini 相较于 Phi-3-mini 在多语言支持方面有显著改进,尤其在阿拉伯语、荷兰语、芬兰语、波兰语、泰语和乌克兰语上提升了 25%-50%。

长上下文任务

Phi-3.5-mini 支持 128K 上下文长度,在总结长文档、基于长文档的问答以及信息检索等任务中表现优异。相比之下,Gemma-2 系列模型仅支持 8K 上下文长度,而 Phi-3.5-mini 在与更大型的开源权重模型如 Llama-3.1-8B-instruct、Mistral-7B-instruct-v0.3 和 Mistral-Nemo-12B-instruct-2407 的竞争中也表现出色。

Phi-3.5-vision 模型

Phi-3.5-vision 在多帧图像理解和推理方面引入了尖端技术,能够实现详细的图像比较、多图像摘要以及视频摘要。这一创新基于客户反馈开发,为各种场景提供了广泛的应用。

性能提升:Phi-3.5-vision 在多个单帧图像基准测试中表现显著提升,例如 MMMU 的表现从 40.4 提升到 43.0,而 MMBench 的表现则从 80.5 提升到 81.9。

安全性

Phi-3 系列模型 的开发遵循了微软的负责任 AI 标准,该标准是一套基于公司内部要求的规定,涵盖了责任、透明、公平、可靠性和安全、隐私和包容性等六项原则。Phi-3.5 系列模型采用了多层次的安全评估和后训练方法,并针对本次发布的多语言能力进行了额外的安全措施。

微软的安全训练和评估方法,涉及对多种语言和风险类别的测试,具体详见 Phi-3 安全后训练报告。

优化变体

ONNX Runtime 提供了 Phi 系列模型的优化推理性能,用户可以将 Phi-3.5-mini 优化到各种硬件目标上。最新的 Phi-3.5 模型的 ONNX 变体将在未来几周发布。

更可预测的输出

微软正在将 Guidance 引入 Azure AI Studio 中的 Phi-3.5-mini 无服务器端点,通过定义适合应用程序的结构,使输出更加可预测。通过 Guidance,用户可以消除昂贵的重试操作,并限制模型从预定义列表中选择,或者将输出限制为提供上下文中的直接引用,从而减少 30%-50% 的成本和延迟。

结语

Phi-3.5-mini 在 LLM 领域中脱颖而出,以 38 亿参数、128K 上下文长度和多语言支持为特点。它在广泛的语言支持和英语性能之间达到了微妙的平衡。对于处理多语言知识密集型任务,建议在 RAG(检索增强生成) 设置中使用 Phi-3.5-mini,通过利用外部数据源来显著提升模型在不同语言中的表现。

Phi-3.5-MoE 配备 16 个小专家模块,提供高质量表现和低延迟,支持 128K 上下文长度和多种语言,并具有强大的安全措施,超越了更大型的模型。

Phi-3.5-vision 在多帧图像理解和推理方面取得了突破,提升了单帧图像基准测试的表现。

Phi-3.5 模型系列 为开源社区和 Azure 客户提供了高性价比、高性能的选择,推动了小型语言模型和生成式 AI 的发展。