Euclidean - L2 norm L2范数

D ( A , B ) = ( a 1 − b 1 ) 2 + ( a 2 − b 2 ) 2 + . . . D(A,B) = \sqrt{(a_1-b_1)^2+(a_2-b_2)^2 + ...} D(A,B)=(a1−b1)2+(a2−b2)2+...

Manhattan

D ( A , B ) = ∣ a 1 − b 1 ∣ + ∣ a 2 − b 2 ∣ + . . . D(A,B) = \sqrt{|a_1-b_1|+|a_2-b_2| + ...} D(A,B)=∣a1−b1∣+∣a2−b2∣+...

Euclidean欧式距离 是直接距离, Manhattan不能走斜线,只能走直线,所以是绝对值的和。

由于 Manhattan distance可以看成是直角三角形的直角边,Euclidean distance可以看成是斜边,所以Manhattan distance >= Eculidean distance.

Minkowski distance

D

(

A

,

B

)

=

(

(

a

1

−

b

1

)

q

+

(

a

2

−

b

2

)

q

+

.

.

.

)

1

/

q

D(A,B) = ((a_1-b_1)^q+(a_2-b_2)^q + ...)^{1/q}

D(A,B)=((a1−b1)q+(a2−b2)q+...)1/q

Minkowski distance 是上面两种距离的变型。

Weighted Euclidean

D ( A , B ) = w 1 ( a 1 − b 1 ) 2 + w 2 ( a 2 − b 2 ) 2 + . . . D(A,B) = \sqrt {w_1(a_1-b_1)^2+w_2(a_2-b_2)^2 + ...} D(A,B)=w1(a1−b1)2+w2(a2−b2)2+...

Weighted Distance

权重对比,比如权重取:

1

d

2

\frac{1}{d^2}

d21

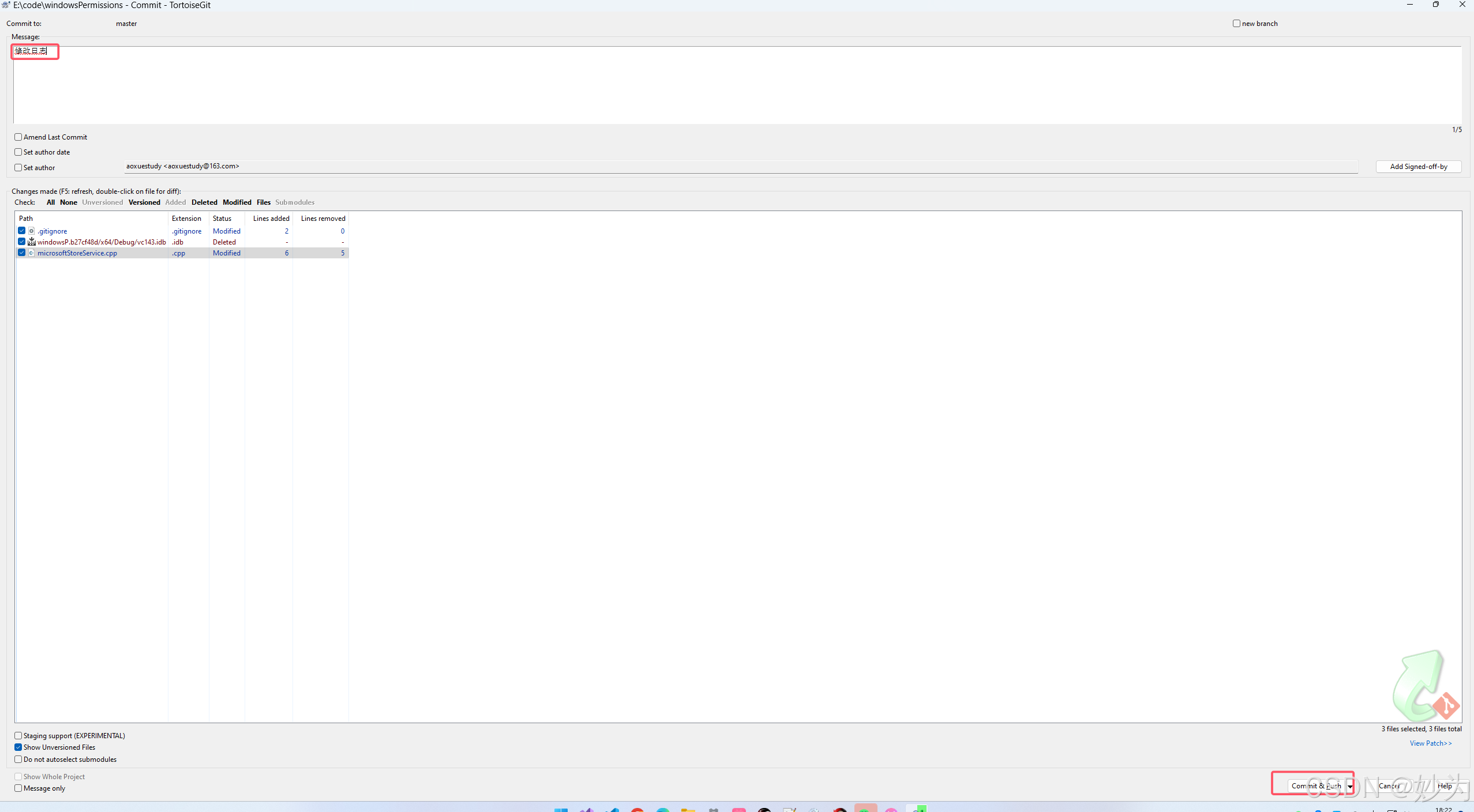

为什么需要权重呢?这里举一个KNN的例子,在KNN中,我们将距离最近的几个数据中的众数作为最终结果。如果直接使用欧氏距离,会有一个弊端,如下图。

假设我们求黑点的预测值,K是3,1,2,3代表了最近的三个点。 根据我们肉眼判断,黑点应该属于蓝色更加合理,但是传统KNN判断最近的是2个红色,一个蓝色,会将这个黑点划分到红点中。

而权重很好的解决了这个问题,距离更近的权重越大。

例如,黑点到蓝点的距离是1,到两个红点的距离是3。

1/ 1^2 > 1/3^2 + 1/3^2

最后结果是这样的,由于1 > 2/9, 结果判断为蓝色。