在AI时代很多行业都被颠覆了,建议大家在业余时间也尽量多学习一些AI工具的使用,提高效率的同时也去探索更多好玩的应用。

今天给大家介绍一个非常好用的图像编辑方法-AnyDesign,适合时尚设计师以及普通用户使用的,可以让你能够更简单、方便地编辑时尚图像。

AnyDesign构建了一个智能的模型,可以直接在你提供的人物图像上进行编辑,而无需额外的掩膜或复杂的步骤。它引入了一种叫做Fashion-Guidance Attention的技术,使得模型能够更好地理解服装的类型和样式,从而做出更自然的修改。这意味着你可以只用一张照片和简单的描述,就可以让你的衣服的样式或颜色发生改变。

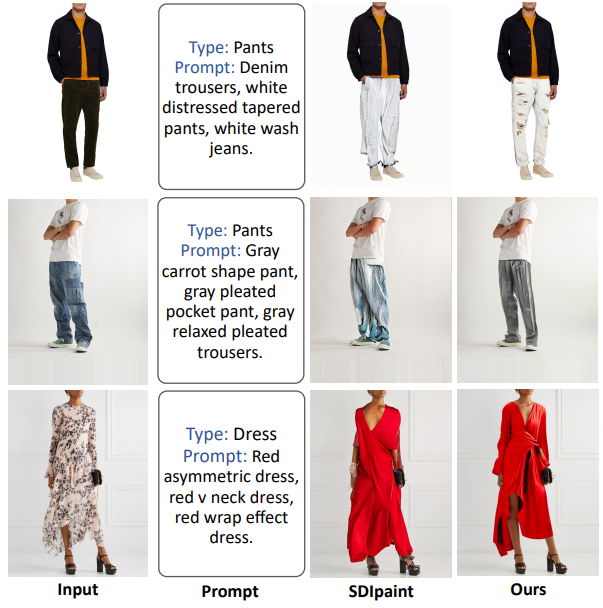

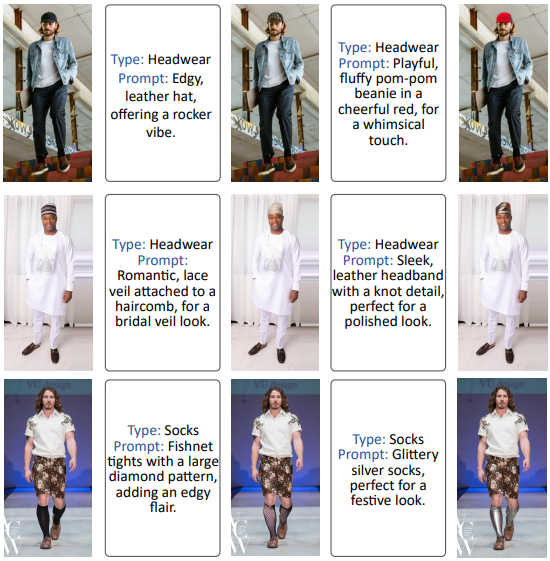

下图为AnyDesign进行时尚编辑的效果

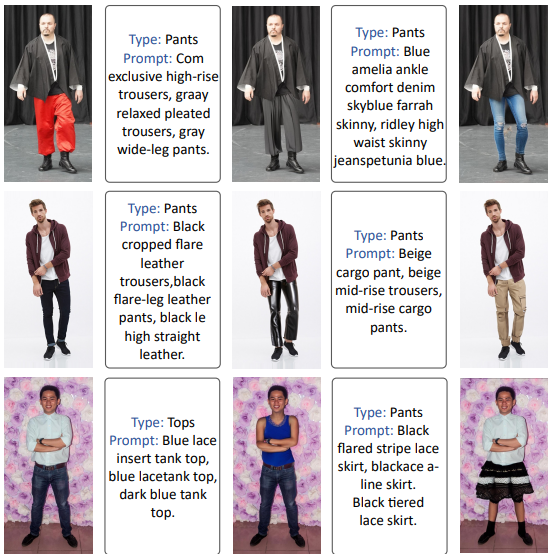

AnyDesign可以适应各种设置,并使用灵活的提示编辑各种服装类别。

相关链接

论文地址:http://arxiv.org/abs/2408.11553v1

代码地址:https://github.com/nyf8/AnyDesign

论文阅读

AnyDesign:通过无遮罩扩散的多功能区域时尚编辑

摘要

时尚图像编辑旨在根据给定的指令修改人物的外观。现有的方法需要辅助工具,如分割器和关键点提取器,缺乏灵活统一的框架。此外,这些方法处理的服装类型有限,因为大多数数据集都集中在干净背景中的人,只包括上衣、裤子和连衣裙等普通服装。这些限制限制了它们在现实场景中的适用性。

在本文中,我们首先扩展了现有的人类生成数据集,以包括更广泛的服装和更复杂的背景。这个扩展的数据集包含穿着各种物品的人,如上衣、裤子、连衣裙、裙子、头饰、围巾、鞋子、袜子和包包。此外,我们提出了一种基于扩散的方法 AnyDesign,可在多种区域进行无遮罩编辑。用户只需输入人体图像以及相应的提示(文本或图像格式)。

我们的方法结合了时尚 DiT,配备了时尚指导注意 (FGA) 模块,旨在融合明确的服装类型和 CLIP 编码的服装特征。定性和定量实验都表明,我们的方法可以提供高质量的时尚编辑,并且优于当代文本引导的时尚编辑方法

方法

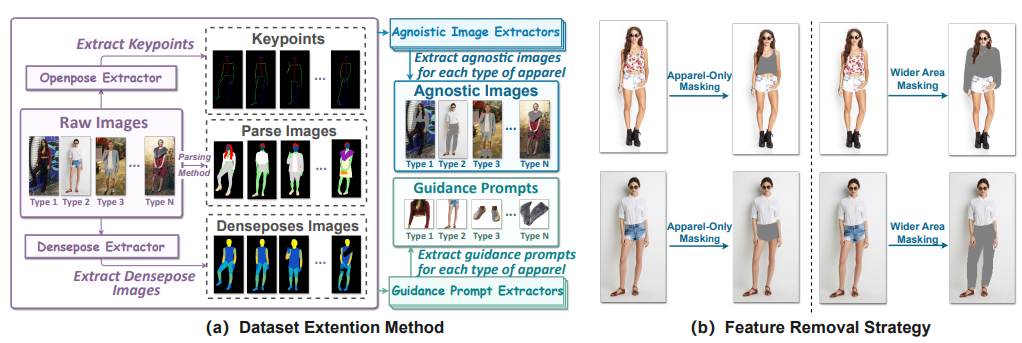

(a)数据集扩展方法。我们使用现有方法提取关键点和密集信息。然后,设计特定于服装的提取器来创建不可知论图像和引导提示。(b)不同的特征去除策略。

时尚编辑框架的整体架构。(a)两阶段图像训练框架。在第一阶段,我们训练了一个基于掩码的模型,使用未配对的文本提示或图像提示来生成伪样本。在第二阶段,我们使用配对提示和服装类型作为输入,利用生成的伪样本训练最终的无口罩。这个阶段的训练目标是生成逼真的图像。(b)时尚资讯科技的架构。

时尚引导注意(FGA)模块。

本研究的核心在于一种创新的无掩膜扩散框架,分为两个阶段。第一阶段使用掩膜基础的扩散模型生成伪样本,利用未配对的文本或图像提示。此后,在第二阶段,构建最终的无掩膜模型,利用从第一阶段生成的伪样本进行训练。这个方法能够依据给定的服装类型和叶状文本或图像提示,自动识别目标区域并完成合成。使用OpenFashion CLIP模型提取的跨模态特征,使得文本和图像的语义信息能够有效融合,从而实现精确的区域编辑。特别是在推理阶段,只需要输入图像和提示,而无需任何额外的人工标定或者掩膜,从而简化了使用过程,提高了效率。

效果

VITON-HD和Dresscode图像的视觉比较。从左到右:给定的人,文本驱动的编辑结果通过一系列的方法。

SHHQe的可视化结果。在文本驱动的编辑中,指示颜色的单词以红色突出显示,而指示样式的单词以绿色突出显示。在图像驱动的编辑中,样式可以转移。

人的评价结果主要体现在意象平等和语义一致性方面。

更多结果

结论

本文引入了一种数据扩展方法并提出了AnyDesign,一个基于扩散的人类时尚编辑的无面具框架。该模型可以在文本或样式图像的指导下编辑野外人类图像。在这个框架中,进一步引入了一个具有时尚指导注意力模块的创新时尚DiT,以增强编辑多类型服装的灵活性。实验表明,我们的方法在流行的数据集上表现出色,实现了最先进的时尚编辑性能。我们相信,我们的工作将推动时尚编辑技术在现实世界中的应用。

感谢你看到这里,也欢迎点击关注下方公众号并添加公众号小助手加入官方读者交流群,一个有趣有AI的AIGC公众号:关注AI、深度学习、计算机视觉、AIGC、Stable Diffusion、Sora等相关技术,欢迎一起交流学习💗~