写在前面

注意:第一部分是踩坑记录,第二部分才是正确的导出步骤!!!!

踩坑方法记录

这一部分的方法看样子好像没啥问题,但是一步步繁琐的操作下来你会发现,你已经入坑了!!!

提醒大家,如果你正在按照这个方法导出模型,劝你尽快放弃,行不通【原因在于后续的python导出代码会个各种报错,而且因环境冲突无法解决】!!!!

正确的步骤是:正确方法记录(下文的后面部分)。

前言

目前,MMDeploy在Windows平台下提供cpu以及cuda两种Device的预编译包,其中cpu版支持使用onnxruntime cpu进行推理,cuda版支持使用onnxruntime-gpu以及tensorrt进行推理,可以从Releases获取。

注意:本篇教程以mmdeploy-1.3.1-windows-amd64.zip为例,展示预编译包cpu的预测方法。

为了方便使用者快速上手,本教程以分割模型(mmdetection)为例,展示预编译包的使用方法。

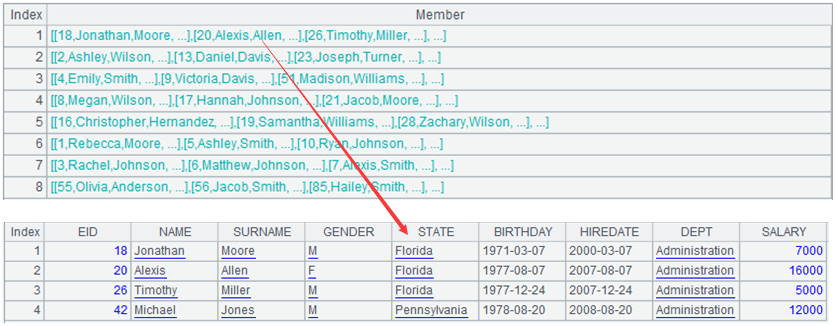

预编译包的目录结构

如下:

.

├── build_sdk.ps1

├── example

├── include

├── install_opencv.ps1

├── lib

├── README.md

├── set_env.ps1

└── thirdparty

准备工作

使用预编译包,来进行模型转换以及模型推理,除了预编译包的中的内容外,还需要安装一些第三方依赖库。

下面以ONNXRuntime为推理后端,说明所要进行的准备工作。

首先新建一个工作目录。

请按照get_started文档,准备虚拟环境,安装pytorch、torchvision、mmcv。

conda create --name mmdeploy python=3.8 -y

conda activate mmdeploy

pip3 install torch torchvision torchaudio

pip install -U openmim

mim install