强!小目标检测全新突破,提出Mamba-in-Mamba结构,通过内外两层Mamba模块,同时提取全局和局部特征,实现了检测速度快10倍,GPU使用减少73.4%的显著效果!

【小目标检测】是近年来在深度学习领域中备受关注的一项技术,它通过提高模型在检测图像或视频中小尺寸目标的能力,显著提升了检测精度和鲁棒性。小目标检测技术已经在遥感图像分析、视频监控和自动驾驶等多个领域取得了显著成果,其独特的方法和有效的表现使其成为研究热点之一。

为了帮助大家全面掌握小目标检测的方法并寻找创新点,本文总结了最近两年【小目标检测】相关的13篇顶会顶刊的研究成果,这些论文的文章、来源以及论文的代码都整理好了,希望能为各位的研究工作提供有价值的参考。

三篇论文详述

1、Towards Automatic Power Battery Detection: NewChallenge, Benchmark Dataset and Baseline

IMG_256

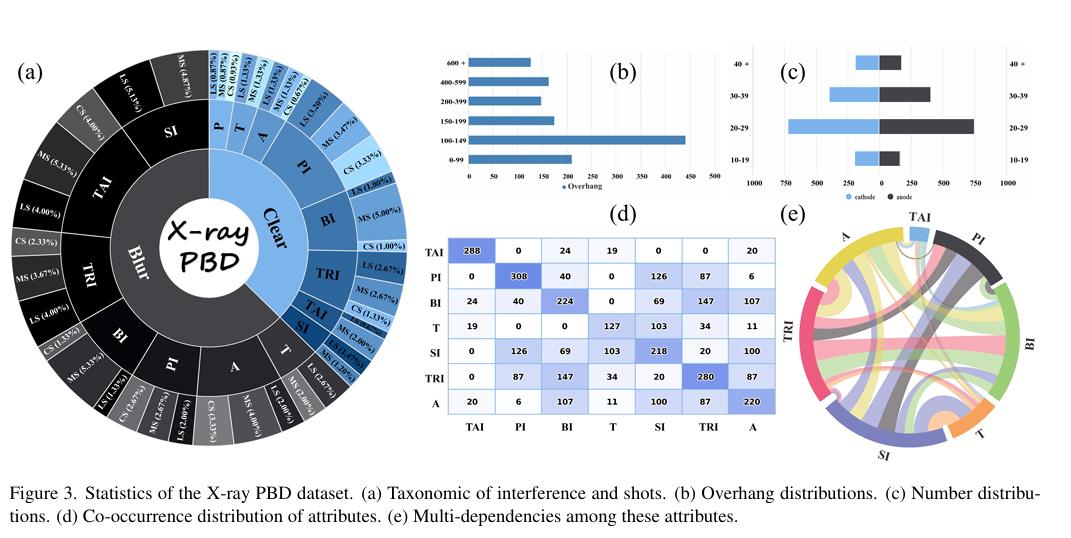

-这篇文章提出了一个新的挑战性任务——动力电池检测(Power Battery Detection, PBD),旨在通过X射线图像检测动力电池内部密集的正负极板端点,以评估电池的质量。目前,制造商通常依赖人工观察来完成PBD,这不仅效率低下,而且难以保证检测的准确性。为了解决这一问题,文章首先精心收集了一个名为X-ray PBD的数据集,包含来自5家制造商的1500张多样化X射线图像,这些图像具有7种不同的视觉干扰。

-接着,文章提出了一种新颖的基于分割的解决方案——多维协同网络(Multi-Dimensional Collaborative Network, MDCNet)。MDCNet利用线和计数预测器辅助点分割分支,在语义和细节层面上改进表示。此外,作者设计了一种有效的距离自适应掩模生成策略,以减轻由于板分布密度不一致造成的视觉挑战,为MDCNet提供稳定的监督信号。

-文章通过广泛的实验比较了MDCNet与其他基于角点检测、人群计数和通用/微小目标检测的解决方案,证明了MDCNet在八个评估指标下均优于现有方法,确立了其作为PBD领域强基准的地位。最后,文章分享了未来研究可能遇到的困难和工作方向,并承诺将源代码和数据集公开,以促进PBD研究的进一步发展。

-文章的主要贡献包括:提出了PBD这一新挑战任务,构建了一个复杂的PBD数据集,设计了一个有效的基线模型,制定了全面的评价指标,并探索了标签生成策略。MDCNet通过多尺度特征融合和提示滤波技术,利用点、线和数量线索,在复杂多样的背景干扰下实现了准确的PBD。此外,文章还进行了消融研究,分析了MDCNet中每个组件的贡献,并探讨了不同的标签生成策略。

-尽管MDCNet在常规样本上取得了超过95%的检测准确率,但在处理困难和棘手样本上的性能还有待提高。文章指出,未来的工作将更多地致力于处理这些困难样本,并计划利用CT设备扩展PBD数据集到3D形式,以提供更丰富的内部切片信息。

2、Dynamic Coarse-to-Fine Learning for Oriented Tiny Object Detection

IMG_257

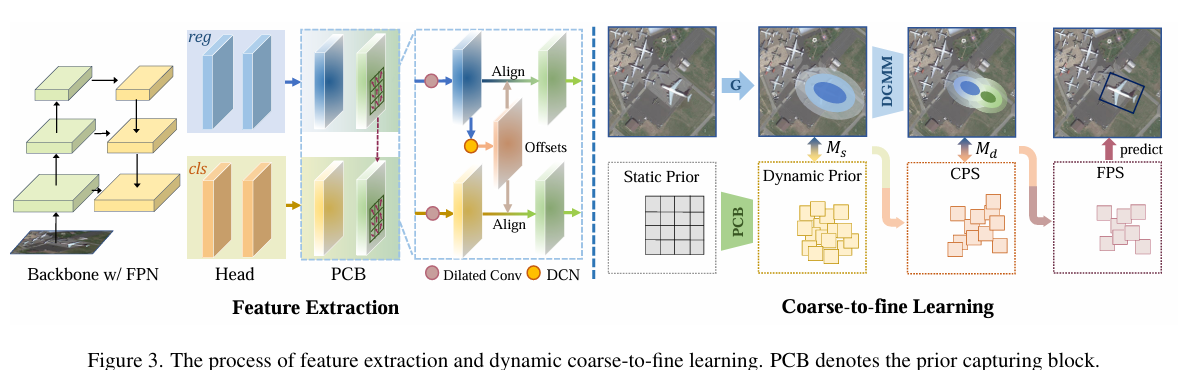

-这篇文章介绍了一种面向微小目标检测的动态粗到细学习框架(Dynamic Coarse-to-Fine Learning, 简称DCFL)。文章首先指出,在航空图像中检测任意方向的微小物体对于现有检测器来说是一个巨大的挑战,尤其是标签分配问题。传统的目标检测方法依赖于静态规则来分配标签,但这种方法不能适应目标形状的变化,导致正负样本的不均衡分配,从而影响检测性能。

-为了解决这些问题,文章提出了一种动态先验和粗到细的分配器,即DCFL。DCFL通过动态建模先验、标签分配和目标表示来缓解不匹配问题。具体来说,文章设计了一个动态先验捕获块(Prior Capturing Block, PCB),它可以自适应地调整先验位置,同时保留了先验的物理意义。基于动态先验,文章进一步选择跨FPN层的粗正样本(Coarse Positive Sample, CPS)候选,并通过广义Jensen-Shannon散度(Generalized Jensen-Shannon Divergence, GJSD)来实现CPS,这可以扩大CPS到目标附近的空间位置和相邻的FPN层,确保为极端形状的物体提供更多的候选样本。

-在获得CPS之后,文章提出了一种基于预测的重排策略和动态高斯混合模型(Dynamic Gaussian Mixture Model, DGMM)来过滤低质量样本。DGMM由两个分量组成:一个位于目标的几何中心,另一个位于目标的语义中心。这种设计允许更细致地表示目标实例,从而提高检测质量。

-文章在六个数据集上进行了广泛的实验,包括DOTA-v1.5、DOTA-v2.0和DIORR等,并在单尺度训练和测试下取得了显著的性能提升。特别是,在DOTA-v1.5、DOTA-v2.0和DIORR数据集上,DCFL达到了最先进的性能。此外,文章还提供了代码,以便于其他研究人员复现和利用该方法。

-文章的主要贡献包括:(1) 识别了面向微小目标检测中存在的严重不匹配和不平衡问题;(2) 设计了一种面向微小目标检测的动态粗到细学习方案,首次以动态方式建模先验、标签分配和目标表示;(3) 在六个数据集上的广泛实验表明,DCFL能够显著提高检测性能。

-文章还进行了消融研究,验证了所提出的策略的有效性,并分析了不同组件对整体性能的影响。此外,文章还探讨了DCFL在处理不同角度和尺度的微小物体时的不平衡问题,并展示了DCFL如何通过动态采样策略更好地捕获目标形状。最后,文章还评估了DCFL的推理速度,并与其他方法进行了参数和计算复杂度的比较。

3、Making Vision Transformers Efficient from A Token Sparsification View

IMG_258

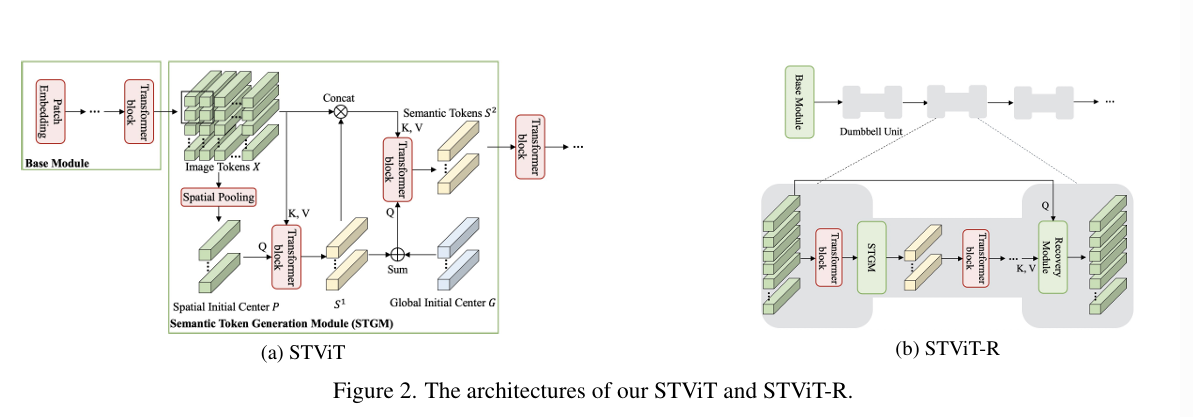

-这篇文章提出了一种新的高效视觉Transformer模型,称为Semantic Token Vision Transformer(STViT),旨在解决传统Vision Transformer(ViT)在计算复杂度上的局限性。ViT通过将图像分割成多个tokens进行处理,虽然在多种视觉识别任务中表现出色,但其计算量随着tokens数量呈二次方增长,限制了其在实际应用中的广泛部署。

-文章的核心思想是通过token稀疏化技术减少冗余tokens,同时保持或提升模型性能。STViT通过引入少量的语义tokens来代表图像中的聚类中心,这些tokens在数量上远少于原始图像tokens,从而显著降低了计算成本。这些语义tokens通过自注意力机制动态聚合图像tokens,以恢复聚类中心,并能够适应性地表示全局或局部的语义信息。

-STViT的提出基于几个关键观察:首先,与局部CNN学习图像的空间结构不同,ViT将特征图离散化为tokens进行全局特征探索,这减轻了维持整个图像结构和信息的要求;其次,离散tokens更有利于优化;最后,在深层transformer中,只有少数具有全局语义信息的tokens才是重要的。

-在STViT中,作者设计了一个语义token生成模块(STGM),它由至少两层transformer层组成,用于从图像tokens中生成语义tokens。这些语义tokens在空间上通过内部和跨窗口的空间池化初始化,以确保它们在空间上分布均匀,并能够代表局部语义信息。随后,这些语义tokens通过自注意力层进一步聚合,以获得全局聚类中心。

-文章还提出了STViT-R网络,这是一个基于STViT的改进模型,它通过恢复模块和哑铃单元来恢复详细的空间信息,使得STViT能够适用于下游任务,如目标检测和实例分割。这在以前的token稀疏化方法中是无法实现的。

-通过广泛的实验,作者证明了STViT在图像分类和视频识别任务上的有效性。在DeiT和Swin Transformer模型上应用STViT,使用16个语义tokens就能实现与原始模型相当的准确率,同时显著提高了推理速度并减少了计算量。特别是在Swin Transformer模型上,通过在每个窗口中使用16个语义tokens,推理吞吐量提高了约20%,准确率略有提升。

-此外,STViT-R在目标检测和实例分割任务上也展现出了竞争力,与原始网络相比,在超过30%的FLOPs减少的情况下,仍然取得了可比的结果。这些发现表明,维持全尺寸特征图并不是必要的,少数具有高级语义表示的tokens就能实现高性能和高效率。

-文章的代码已经在GitHub上公开,为进一步的研究提供了基础。总的来说,这篇文章为如何提高ViT的效率提供了一种新颖的视角,并通过实验验证了其有效性,为未来ViT在实际应用中的部署提供了新的可能性。

![[星瞳科技]OpenMV是否属于单片机?](https://img-blog.csdnimg.cn/img_convert/960856f3b2d564ef0608e5e12317b303.png)

![[PHP]-Laravel中Group By引发的问题思考](https://i-blog.csdnimg.cn/direct/d8107743337647cc921a47e61a59f07d.jpeg#pic_center)