在当今复杂的数字生态系统中,组织的数据通常分散在多个平台和来源中。有效整合这些数据不仅可以提供全面的业务洞察,还能支持更准确的决策制定。本文将探讨如何实现跨平台和多源数据的有效整合。

目录

- 1. 数据整合的重要性

- 2. 数据整合的挑战

- 3. 数据整合策略

- 3.1 ETL (Extract, Transform, Load)

- 3.2 数据虚拟化

- 3.3 数据湖

- 4. 确保数据质量和一致性

- 5. 工具和技术

- 6. 案例研究:全渠道零售商的数据整合

- 7. 最佳实践

- 结语

1. 数据整合的重要性

整合来自不同平台和来源的数据可以带来多方面的好处:

class DataIntegrationBenefits:

def __init__(self):

self.benefits = [

"全面的客户视图",

"improved_decision_making",

"operational_efficiency",

"enhanced_analytics",

"competitive_advantage"

]

def explain_benefits(self):

print("数据整合的主要优势:")

for benefit in self.benefits:

print(f"- {benefit.replace('_', ' ').title()}")

def quantify_benefit(self, benefit, metric, value):

if benefit in self.benefits:

print(f"{benefit.replace('_', ' ').title()}的量化效果:")

print(f" {metric}: {value}")

# 使用示例

benefits = DataIntegrationBenefits()

benefits.explain_benefits()

print()

benefits.quantify_benefit("improved_decision_making", "决策时间减少", "30%")

benefits.quantify_benefit("operational_efficiency", "运营成本降低", "15%")

2. 数据整合的挑战

跨平台和多源数据整合面临多个挑战:

- 数据格式不一致

- 数据质量问题

- 实时性要求

- 隐私和安全考虑

- 技术兼容性

class DataIntegrationChallenges:

def __init__(self):

self.challenges = {

"数据格式不一致": "不同系统可能使用不同的数据格式和结构",

"数据质量问题": "来自不同源的数据可能存在质量差异",

"实时性要求": "某些应用可能需要实时或近实时的数据整合",

"隐私和安全考虑": "整合过程中需要确保数据的隐私和安全",

"技术兼容性": "不同系统之间的技术差异可能导致整合困难"

}

def describe_challenge(self, challenge):

if challenge in self.challenges:

print(f"{challenge}:{self.challenges[challenge]}")

else:

print(f"未找到关于'{challenge}'的描述")

def list_all_challenges(self):

print("数据整合面临的主要挑战:")

for challenge in self.challenges:

print(f"- {challenge}")

# 使用示例

challenges = DataIntegrationChallenges()

challenges.list_all_challenges()

print()

challenges.describe_challenge("数据质量问题")

3. 数据整合策略

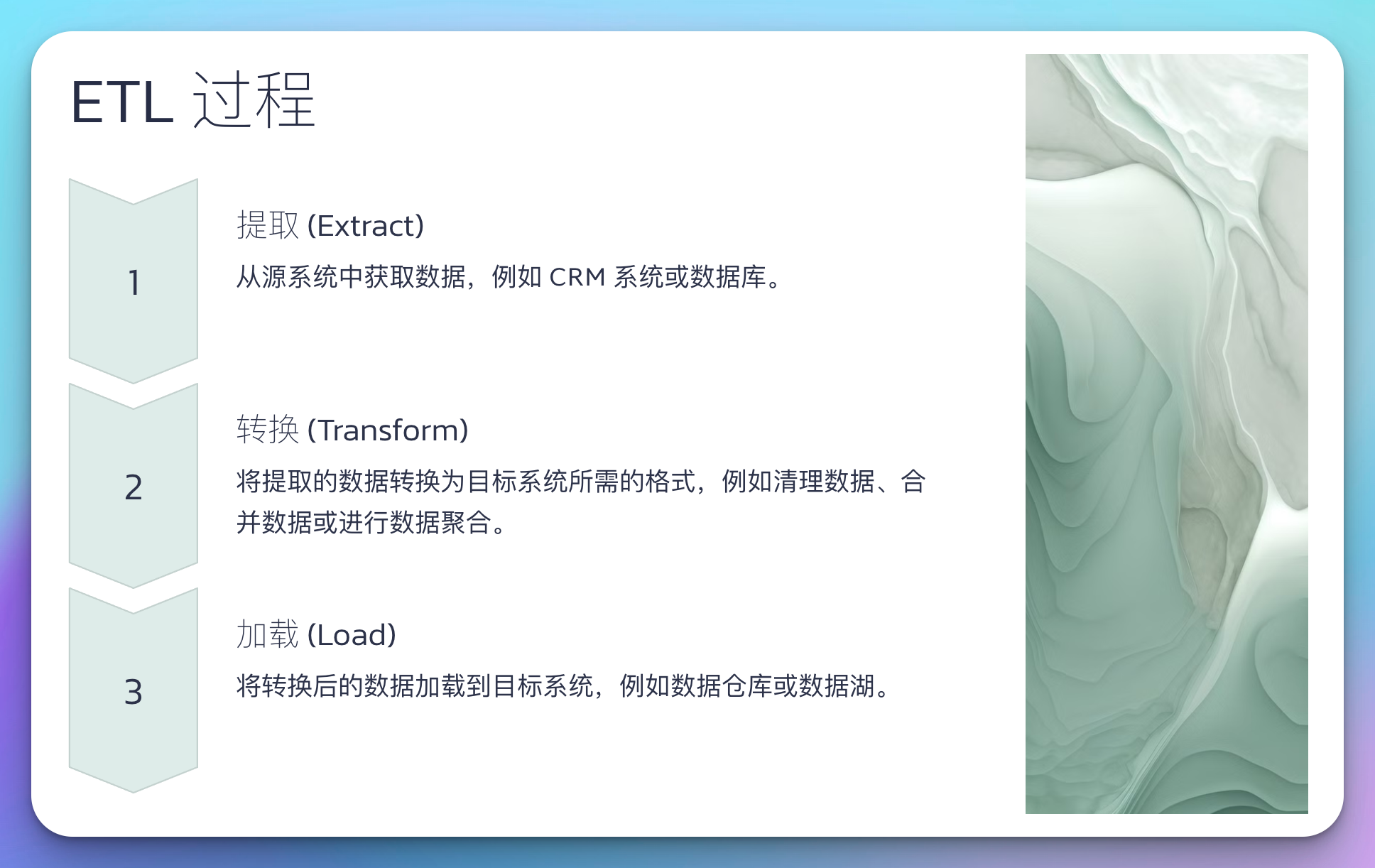

3.1 ETL (Extract, Transform, Load)

ETL是一种传统的数据整合方法,适用于批处理场景。

import pandas as pd

class ETLProcess:

def extract(self, source):

print(f"从{source}提取数据")

# 模拟数据提取

return pd.DataFrame({'id': range(1, 6), 'value': [10, 20, 30, 40, 50]})

def transform(self, data):

print("转换数据")

# 简单的数据转换

data['value_squared'] = data['value'] ** 2

return data

def load(self, data, destination):

print(f"将数据加载到{destination}")

# 模拟数据加载

print(data.head())

# 使用示例

etl = ETLProcess()

source_data = etl.extract("CRM系统")

transformed_data = etl.transform(source_data)

etl.load(transformed_data, "数据仓库")

3.2 数据虚拟化

数据虚拟化允许在不移动数据的情况下进行整合,适用于实时查询场景。

class DataVirtualization:

def __init__(self):

self.data_sources = {}

def add_data_source(self, name, connection_string):

self.data_sources[name] = connection_string

print(f"添加数据源:{name}")

def query(self, sql):

print("执行跨源查询:")

print(sql)

# 在实际应用中,这里会解析SQL并在相应的数据源上执行查询

print("返回整合后的结果")

# 使用示例

virtualization = DataVirtualization()

virtualization.add_data_source("MySQL", "mysql://username:password@host/database")

virtualization.add_data_source("PostgreSQL", "postgresql://username:password@host/database")

virtualization.query("SELECT * FROM mysql_table JOIN postgres_table ON id")

3.3 数据湖

数据湖是一个集中式存储库,可以存储所有类型的数据。

class DataLake:

def __init__(self):

self.data = {}

def ingest(self, source, data):

if source not in self.data:

self.data[source] = []

self.data[source].append(data)

print(f"将数据从{source}摄入数据湖")

def process(self, query):

print(f"在数据湖中执行查询:{query}")

# 在实际应用中,这里会执行复杂的数据处理逻辑

return "处理结果"

# 使用示例

lake = DataLake()

lake.ingest("IoT设备", {"device_id": 1, "temperature": 25.5, "timestamp": "2023-05-01T12:00:00"})

lake.ingest("社交媒体", {"user_id": 1001, "post": "Hello, world!", "timestamp": "2023-05-01T12:05:00"})

result = lake.process("分析IoT数据和社交媒体数据的相关性")

print(result)

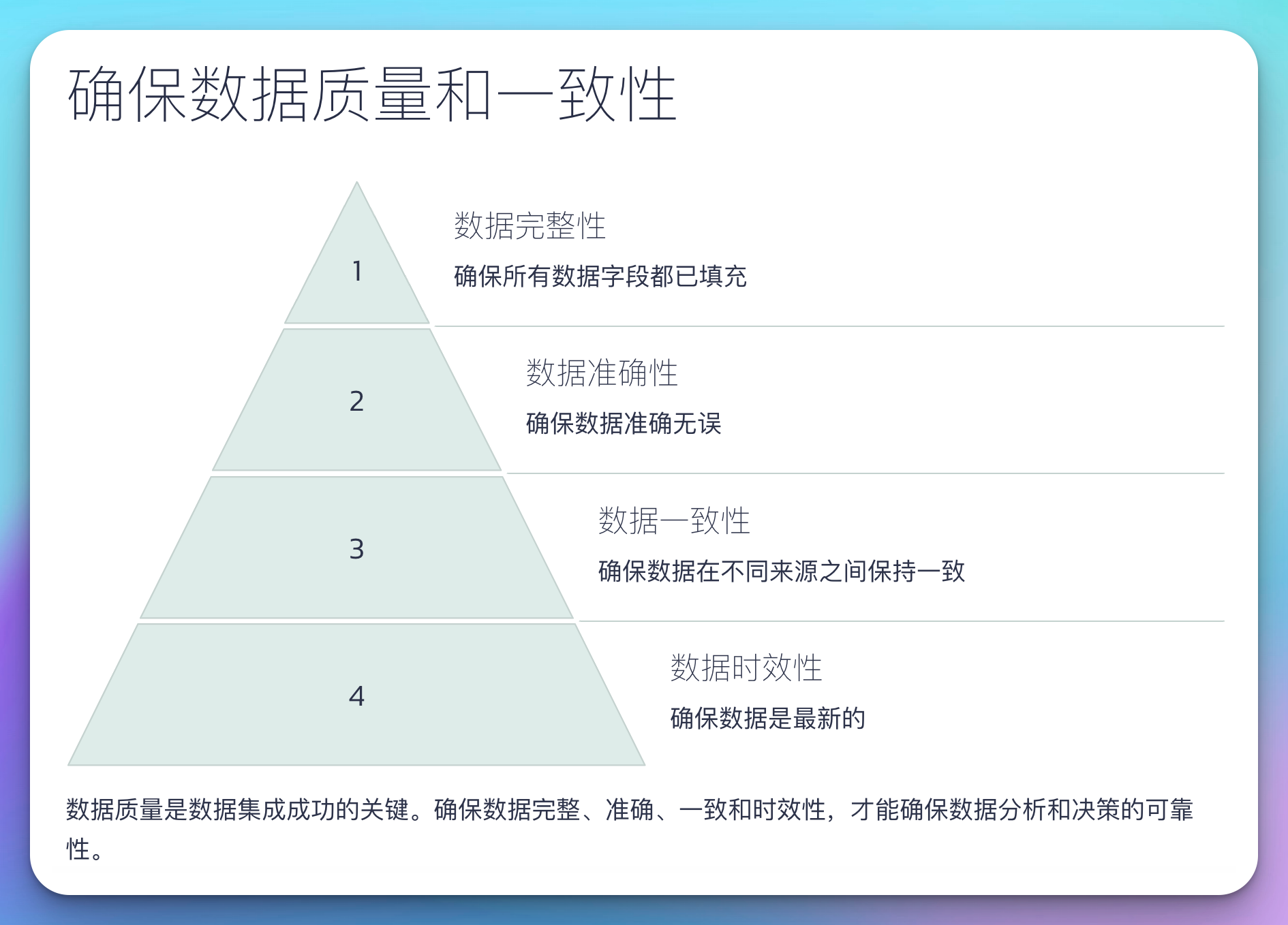

4. 确保数据质量和一致性

在整合过程中,确保数据质量和一致性至关重要。

import re

class DataQualityChecker:

def __init__(self):

self.rules = {}

def add_rule(self, field, rule):

self.rules[field] = rule

def check_quality(self, data):

issues = []

for field, rule in self.rules.items():

if field in data:

if not rule(data[field]):

issues.append(f"{field}不符合质量规则")

return issues

# 使用示例

checker = DataQualityChecker()

checker.add_rule("email", lambda x: re.match(r"[^@]+@[^@]+\.[^@]+", x))

checker.add_rule("age", lambda x: 0 <= x <= 120)

data = {"email": "user@example.com", "age": 30}

issues = checker.check_quality(data)

if issues:

print("发现数据质量问题:")

for issue in issues:

print(f"- {issue}")

else:

print("数据质量检查通过")

5. 工具和技术

有多种工具和技术可用于跨平台和多源数据整合:

- Apache Nifi:用于数据流自动化

- Talend:提供开源和企业版数据集成解决方案

- Informatica PowerCenter:企业级数据集成平台

- Apache Kafka:用于构建实时数据管道

- Databricks:统一的数据分析平台

class DataIntegrationTool:

def __init__(self, name, features):

self.name = name

self.features = features

def describe(self):

print(f"{self.name}的主要特性:")

for feature in self.features:

print(f"- {feature}")

# 使用示例

tools = [

DataIntegrationTool("Apache Nifi", ["可视化数据流设计", "实时数据处理", "可扩展性强"]),

DataIntegrationTool("Talend", ["图形化界面", "广泛的连接器支持", "开源和企业版选择"]),

DataIntegrationTool("Apache Kafka", ["高吞吐量", "分布式架构", "实时流处理"])

]

for tool in tools:

tool.describe()

print()

6. 案例研究:全渠道零售商的数据整合

让我们通过一个案例研究来看看如何在实践中应用这些概念。

class RetailDataIntegration:

def __init__(self):

self.data_sources = {

"电商平台": ["订单", "浏览记录", "购物车数据"],

"实体店": ["销售数据", "库存信息"],

"客户服务": ["客户反馈", "服务记录"],

"社交媒体": ["用户评论", "品牌提及"]

}

def integrate_data(self):

print("整合全渠道零售数据:")

for source, data_types in self.data_sources.items():

print(f"从{source}整合数据:")

for data_type in data_types:

print(f" - {data_type}")

def generate_insights(self):

print("\n生成业务洞察:")

insights = [

"跨渠道客户行为分析",

"个性化推荐引擎优化",

"库存管理效率提升",

"全渠道营销活动效果评估"

]

for insight in insights:

print(f"- {insight}")

# 使用示例

retail_integration = RetailDataIntegration()

retail_integration.integrate_data()

retail_integration.generate_insights()

7. 最佳实践

以下是一些跨平台和多源数据整合的最佳实践:

- 制定清晰的数据治理策略

- 建立统一的数据模型

- 实施强大的数据质量控制

- 考虑实时和批处理需求

- 确保数据隐私和安全

- 建立元数据管理

- 持续监控和优化

class DataIntegrationBestPractices:

def __init__(self):

self.practices = [

"制定清晰的数据治理策略",

"建立统一的数据模型",

"实施强大的数据质量控制",

"考虑实时和批处理需求",

"确保数据隐私和安全",

"建立元数据管理",

"持续监控和优化"

]

def implement_practice(self, practice):

if practice in self.practices:

print(f"实施最佳实践:{practice}")

# 这里可以添加具体的实施步骤

else:

print(f"未找到'{practice}'的最佳实践")

def assess_implementation(self):

scores = {}

for practice in self.practices:

score = float(input(f"请为'{practice}'的实施情况打分(0-10): "))

scores[practice] = score

average_score = sum(scores.values()) / len(scores)

print(f"\n最佳实践实施平均得分:{average_score:.2f}/10")

if average_score < 6:

print("建议:需要在多个方面改进数据整合实践")

elif average_score < 8:

print("建议:数据整合实践良好,但仍有提升空间")

else:

print("建议:excellent数据整合实践,继续保持并寻求创新")

# 使用示例

best_practices = DataIntegrationBestPractices()

best_practices.implement_practice("建立统一的数据模型")

best_practices.assess_implementation()

结语

跨平台和多源数据整合是一个复杂但必要的过程,它可以为组织提供全面的数据视图,支持更好的决策制定。关键是要:

- 理解不同数据源的特性和局限性

- 选择适当的整合策略和工具

- 确保数据质量和一致性

- 遵循最佳实践

- 持续优化和改进整合过程

通过有效的数据整合,组织可以打破数据孤岛,获得更全面的业务洞察,提高运营效率,并在市场中获得竞争优势。随着技术的不断发展,我们可以期待看到更多创新的数据整合方法和工具,使这个过程变得更加高效和智能。

在数据驱动的时代,那些能够有效整合和利用各种数据源的组织将在竞争中脱颖而出。通过建立强大的跨平台和多源数据整合能力,组织可以充分释放数据的潜力,推动创新和增长。