**Stable Diffusion**是2022年发布的深度学习文本到图像生成模型。它主要用于根据文本的描述产生详细图像,尽管它也可以应用于其他任务,如内补绘制、外补绘制,以及在提示词指导下产生图生图的翻译。

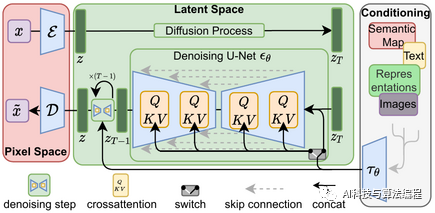

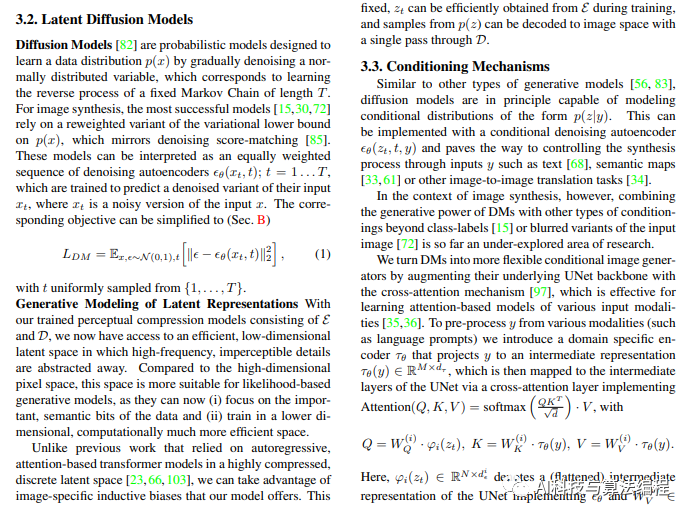

它是一种潜在扩散模型,由慕尼黑大学的CompVis研究团体开发的各种生成性人工神经网络。\[3\]它是由初创公司StabilityAI,CompVis与Runway合作开发的,并得到EleutherAI和LAION的支持。 截至2022年10月,StabilityAI筹集了1.01亿美元的资金。

Stable Diffusion的代码和模型权重已公开发布,可以在大多数配备有适度GPU的电脑硬件上运行。而以前的专有文生图模型(如DALL-E和Midjourney)只能通过云端运算服务访问。

论文地址:https://arxiv.org/abs/2112.10752

源码地址:

https://github.com/CompVis/latent-diffusion

https://github.com/Stability-AI/stablediffusion

Stable Diffusion是一种扩散模型,近年来在AI绘画领域取得了显著的进展。它是基于扩散过程和生成模型的结合,通过扩散过程生成一系列中间状态,最终得到所需的图像。具体来说,Stable Diffusion主要包括以下几个方面:

-

扩散过程:扩散过程是一个连续时间的随机过程,可以将其看作是在图像上添加噪声,从而逐步将图像变得越来越模糊。在AI绘画领域,这个过程可以帮助生成器学习如何逐步从随机噪声中生成逼真的图像。扩散过程的一个关键概念是噪声等级,即在每个时间步长上添加到图像上的噪声量。

-

稳定扩散:在传统的扩散过程中,由于噪声的累积,图像可能变得非常模糊,这使得生成模型难以从噪声中重建原始图像。为了解决这个问题,Stable Diffusion引入了一种新的扩散过程,可以在保持图像局部结构的同时,仍然允许模型从随机噪声中生成图像。这种方法通过调整噪声等级和扩散步数来实现,以在保持稳定性的同时实现更快的收敛。

-

反向过程:在Stable Diffusion模型中,生成模型的任务是通过观察扩散过程中的中间状态来推测原始图像。为了实现这一点,模型需要学习如何从一个给定的噪声等级反向生成逼真的图像。这个过程可以通过优化生成模型的参数来实现,以便最小化在每个时间步长上生成的图像与目标图像之间的差异。

-

应用于AI绘画:Stable Diffusion在AI绘画领域的应用主要包括两个方面:生成和编辑。在生成方面,模型可以从随机噪声中生成逼真的图像,从而实现自动绘画的功能。在编辑方面,模型可以根据用户的输入对图像进行修改,从而实现一种有趣的互动绘画体验。此外,Stable Diffusion还可以与其他生成模型(如GAN和VAE)

结合,以提高图像质量和生成速度。

-

参考论文:

具有潜在扩散模型的高分辨率图像合成:https://arxiv.org/abs/2112.10752

High-Resolution Image Synthesis with Latent Diffusion Models:https://openaccess.thecvf.com/content/CVPR2022/papers/Rombach_High-Resolution_Image_Synthesis_With_Latent_Diffusion_Models_CVPR_2022_paper.pdf

百度~基于PaddlePaddle实现的扩散器工具箱:https://github.com/PaddlePaddle/PaddleNLP/tree/develop/ppdiffusers

下面简单说一下基于上述模型是AI绘画开源的stable-diffusion-webui,想要安装stable-diffusion-webui请参考下面的文章链接:

《完美安装AI绘画软件stable-diffusion-webui:没有GPU显卡的电脑系统也能运行、测试AI绘画软件【包教会一键安装】》https://blog.csdn.net/weixin_41194129/article/details/129892394?spm=1001.2014.3001.5501

stable-diffusion-webui 是一个开源项目,它提供了一个基于Web的用户界面(UI),用于与OpenAI的Stable Diffusion模型进行交互。Stable Diffusion是一种生成式对抗网络(GAN)的变体,用于生成逼真的图像。stable-diffusion-webui使用户能够通过简单的Web界面与Stable Diffusion模型进行交互,而无需直接编写代码或使用命令行工具。

虽然没有关于stable-diffusion-webui的详细文档,但您可以通过以下步骤了解如何安装和使用它:

下面是一份大致的安装教程:

-

安装依赖项

首先,您需要确保已经安装了以下依赖项:

-

Python 3.6 或更高版本

-

Node.js 12 或更高版本

-

Yarn 或 npm(用于安装JavaScript依赖项)

-

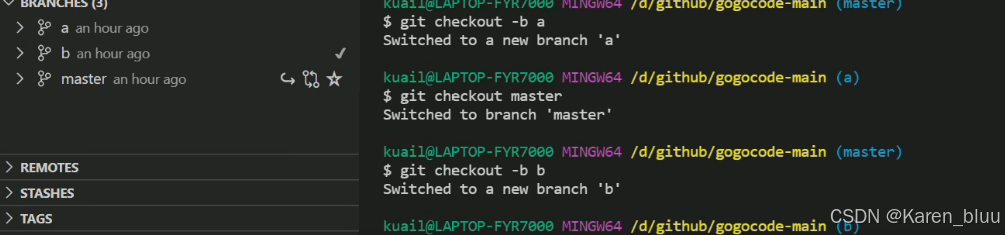

克隆存储库

使用以下命令从GitHub克隆stable-diffusion-webui存储库:

`git clone https://github.com/path-to/stable-diffusion-webui.git ` -

安装Python依赖项

进入项目目录,并使用以下命令安装Python依赖项:

`cd stable-diffusion-webui pip install -r requirements.txt ` -

安装JavaScript依赖项

使用Yarn或npm安装JavaScript依赖项:

`yarn install `或

`npm install ` -

运行Web应用程序

使用以下命令启动开发服务器:

`yarn run dev `或

`npm run dev `在您的Web浏览器中访问http://localhost:8080,您应该可以看到stable-diffusion-webui的用户界面。

-

使用stable-diffusion-webui

在Web界面上,您可以选择预训练的Stable Diffusion模型,设置不同的参数,例如采样温度和截断值,然后通过点击“生成”按钮来生成图像。生成的图像将显示在屏幕上,您可以根据需要保存或分享这些图像。

-

stable-diffusion-webui项目可能随时进行更新和改进。为了确保您使用的是最新版本,建议您定期查看项目的GitHub页面并同步更新。

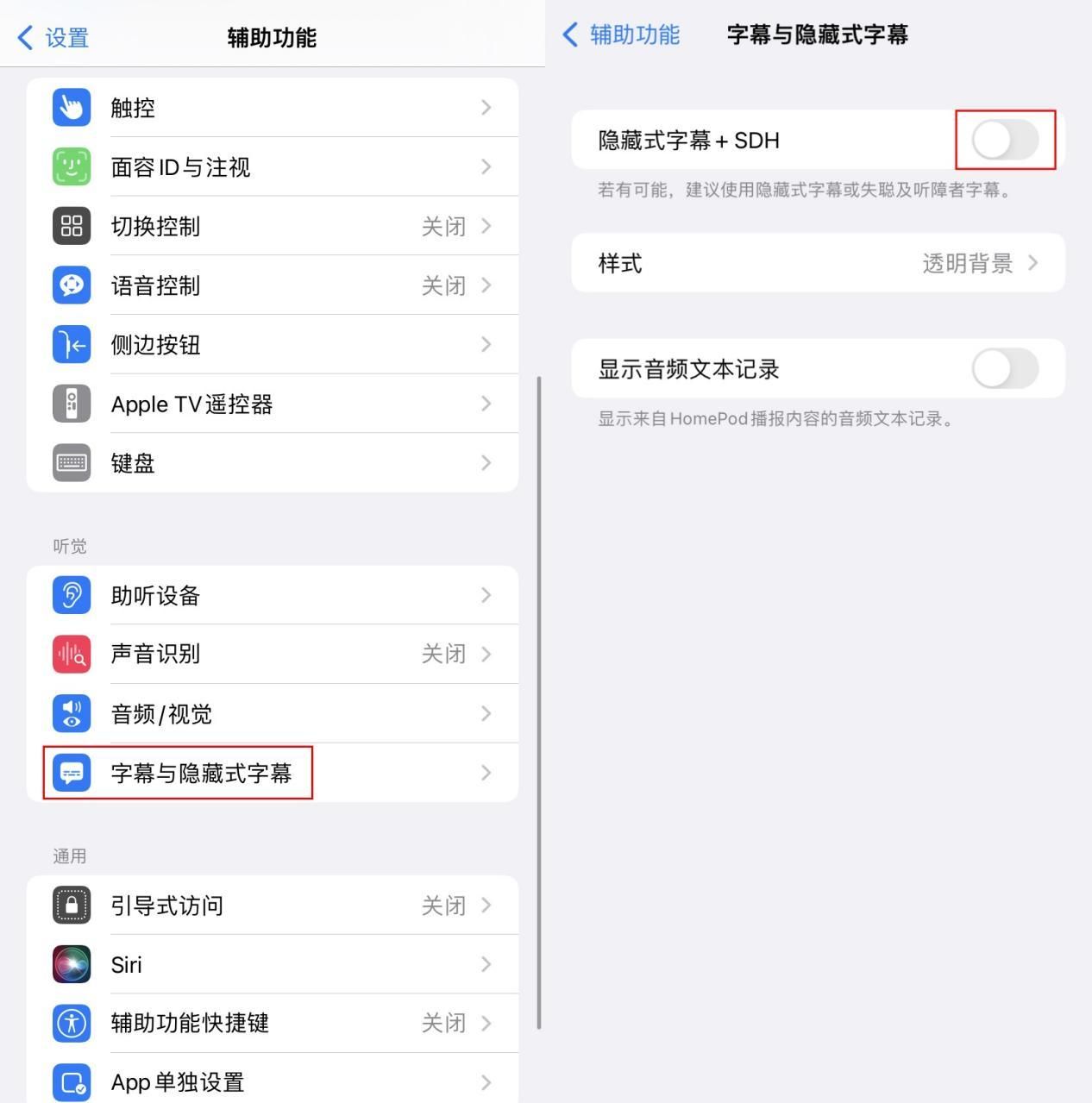

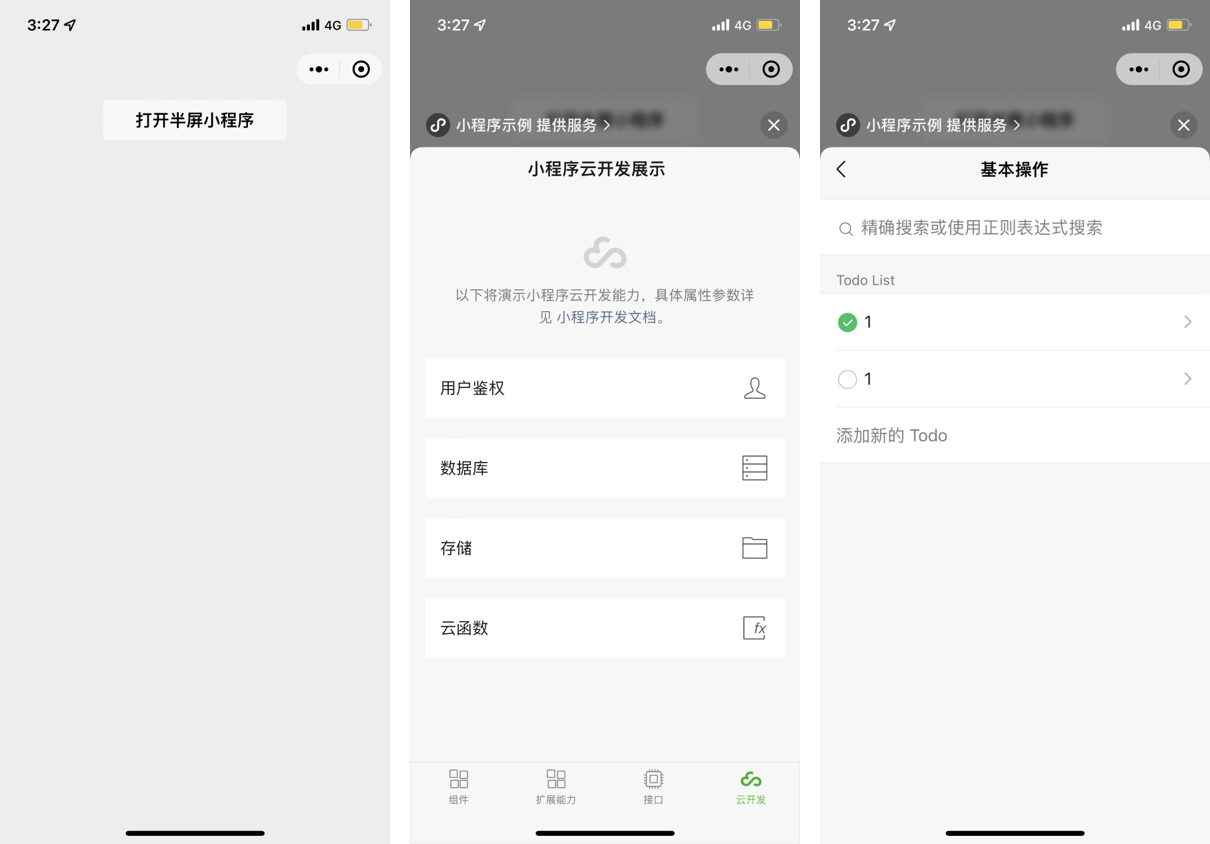

生成的图片:需求该AI绘画图的提示词公众号留言

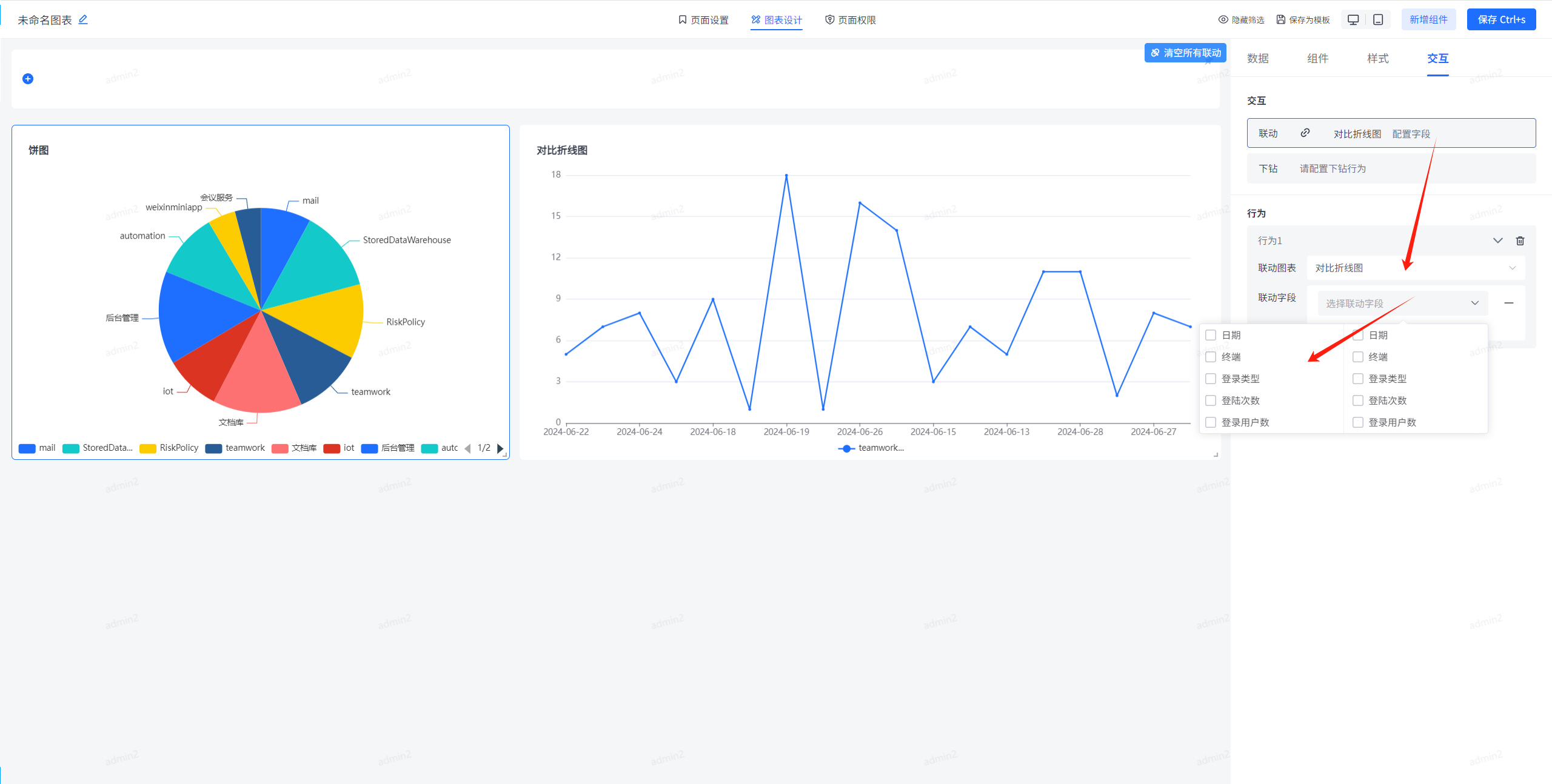

图生图系列:使用上述图片生成如下类似图片

参考资料:

https://zh.wikipedia.org/zh-hans/Stable_Diffusion``https://blog.csdn.net/weixin_41194129/article/details/129892394?spm=1001.2014.3001.5501``https://github.com/PaddlePaddle/PaddleNLP/tree/develop/ppdiffusers``https://github.com/CompVis/latent-diffusion

想要学习AI绘画的朋友们可以扫描入群拉你进大群

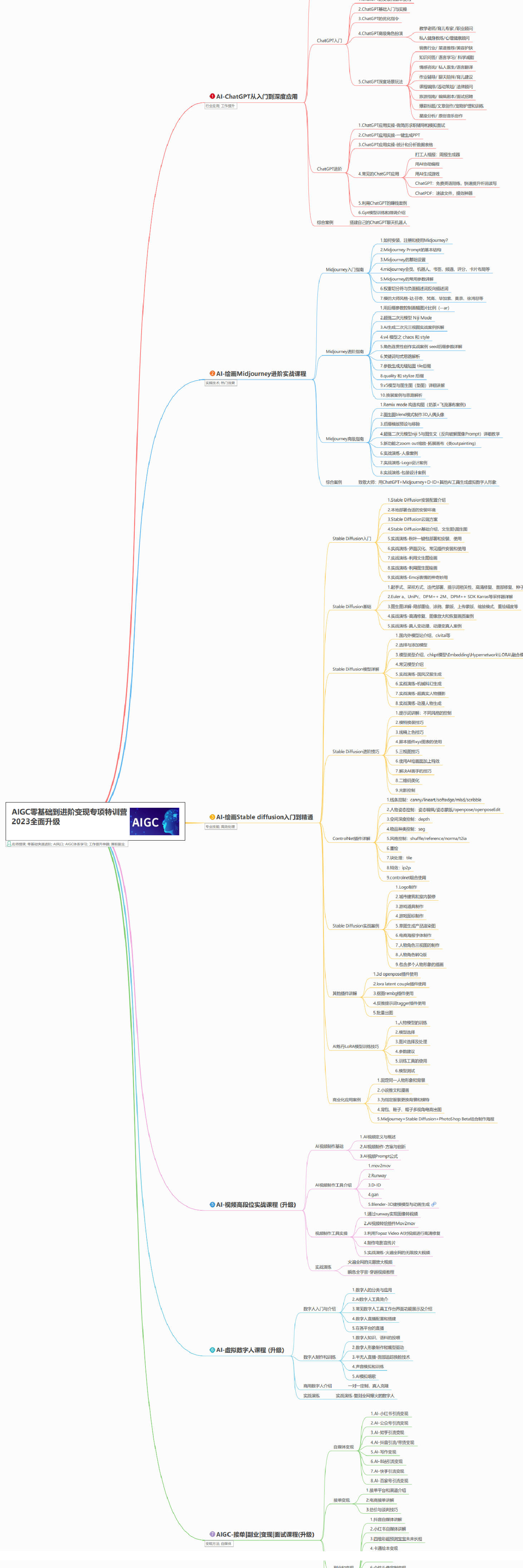

这里分享给大家一份Adobe大神整理的《AIGC全家桶学习笔记》,相信大家会对AIGC有着更深入、更系统的理解。

有需要的朋友,可以点击下方免费领取!

AIGC所有方向的学习路线思维导图

这里为大家提供了总的路线图。它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。如果下面这个学习路线能帮助大家将AI利用到自身工作上去,那么我的使命也就完成了:

AIGC工具库

AIGC工具库是一个利用人工智能技术来生成应用程序的代码和内容的工具集合,通过使用AIGC工具库,能更加快速,准确的辅助我们学习AIGC

有需要的朋友,可以点击下方卡片免费领取!

精品AIGC学习书籍手册

书籍阅读永不过时,阅读AIGC经典书籍可以帮助读者提高技术水平,开拓视野,掌握核心技术,提高解决问题的能力,同时也可以借鉴他人的经验,结合自身案例融会贯通。

AI绘画视频合集

我们在学习的时候,往往书籍源码难以理解,阅读困难,这时候视频教程教程是就很适合了,生动形象加上案例实战,科学有趣才能更方便的学习下去。