【ML】强化学习(Reinforcement Learning)

- 1. RL Outline 强化学习(Reinforcement Learning)概述

- 1.1 RL的基本框架

- 2. RL 引入:从这个小游戏开始

- 3. Policy Gradient 方法

- 4. Actor-Critic 方法

- 5. [奖励塑形(Reward Shaping)](https://www.bilibili.com/video/BV1Wv411h7kN?p=117&spm_id_from=pageDriver&vd_source=0ad81bc7001a125d9e2c7ebf1e07d502)

- 6. No Reward: Learning from Demonstration

1. RL Outline 强化学习(Reinforcement Learning)概述

What is RL? (Three steps in ML)

Policy Gradient

Actor-Critic

Reward Shaping

No Reward: Learning from Demonstration

强化学习(Reinforcement Learning, RL)是机器学习(Machine Learning, ML)中的一个重要范式,它与监督学习和无监督学习并列。RL的核心在于通过智能体(agent)与环境的交互,智能体通过观察环境状态并采取行动,以最大化累积奖励(cumulative reward)为目标进行学习。

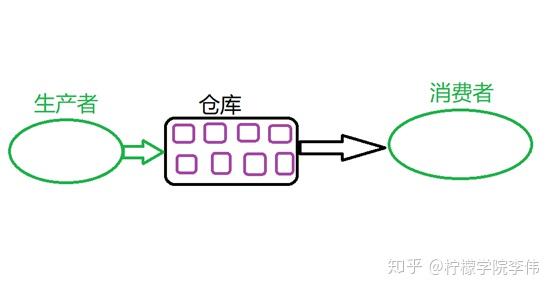

1.1 RL的基本框架

强化学习(RL)概述及其关键技术

强化学习(Reinforcement Learning, RL)是机器学习的一个分支,它关注如何让代理(agent)通过与环境互动,学习做出决策以最大化累积奖励的过程。在典型的强化学习框架下,代理会根据观察到的状态选择动作,并接收到一个反馈信号——奖励,以此来指导其未来的行动选择。强化学习通常被分为三个关键步骤:状态观测、动作选择和奖励接收。

三步骤详解

- 状态观测:代理观测当前环境的状态。

- 动作选择:基于当前状态,代理决定采取的动作。

- 奖励接收:代理执行动作后,从环境中获得正向或负向的奖励。

关键技术

1)

- 定义:策略梯度是一种直接优化策略函数的参数化方法。这种方法通过梯度上升的方式调整策略函数的参数,以期望最大化策略函数所对应的长期回报。

- 公式:对于离散动作空间,策略梯度可以通过以下公式表示

Δ θ = α ∑ t ∇ θ log π ( a t ∣ s t , θ ) R ( t ) \Delta \theta = \alpha \sum_t \nabla_\theta \log \pi(a_t|s_t,\theta) R(t) Δθ=αt∑∇θlogπ(at∣st,θ)R(t)

其中 ( \theta ) 是策略参数,( \alpha ) 是学习率,( R(t) ) 是从时间步 ( t ) 开始的累计奖励。

2)Actor-Critic 方法

- 定义:Actor-Critic 方法结合了策略梯度和值迭代的思想,其中Actor负责决策(选择动作),Critic负责评估决策的好坏(计算动作价值)。

- 原理:Actor更新策略以增加有利动作的概率,Critic评估动作并指导Actor的更新方向。

3)奖励塑形(Reward Shaping)

- 定义:奖励塑形是一种技术,它通过修改原始奖励函数来加速学习过程。

- 目的:通过添加额外的奖励(如局部奖励)以引导代理更快地学习目标行为。

4)No Reward: Learning from Demonstration

-

定义:在没有即时奖励的情况下,通过模仿专家演示来学习最优策略。

-

应用场景:当直接获得即时奖励较为困难时采用此方法。

-

强化学习:是一种通过与环境互动学习决策的过程,其核心在于通过观察、动作选择以及奖励接收来不断优化代理的行为策略。

-

关键技术:包括策略梯度(直接优化策略)、Actor-Critic(结合策略优化与值估计)、奖励塑形(调整奖励函数)和Learning from Demonstration(无直接奖励情况下的学习)。

综上所述,强化学习是通过与环境的交互学习如何做出最佳决策的一种方法,上述提到的技术在这一过程中扮演着重要角色。

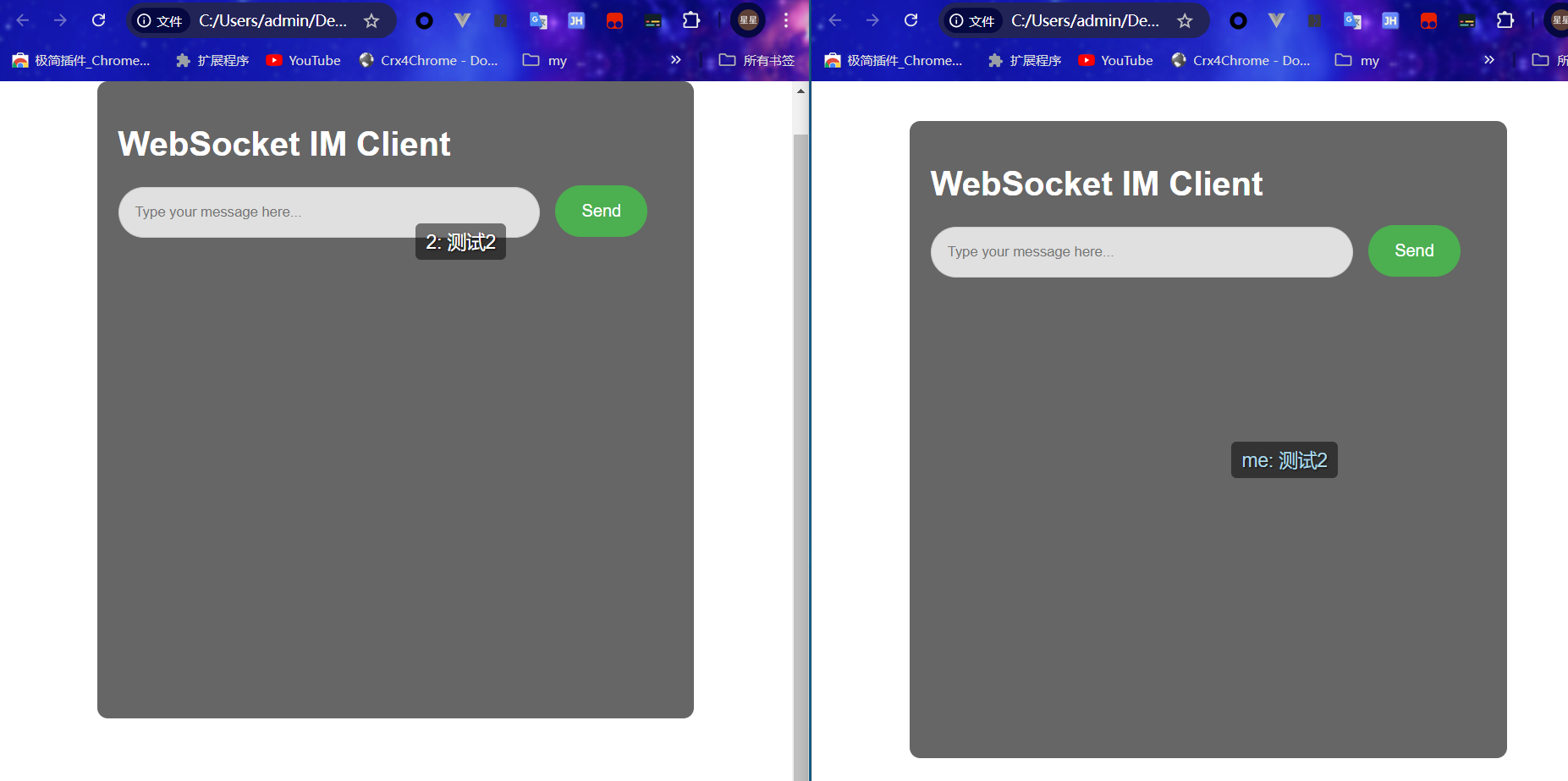

2. RL 引入:从这个小游戏开始

在这里插入图片描述

3. Policy Gradient 方法

4. Actor-Critic 方法