- 🍨 本文为🔗365天深度学习训练营 中的学习记录博客

- 🍖 原作者:K同学啊

目录

- 一、创建环境

- 二、前期准备

- 2.1 设置GPU

- 2.2 导入数据

- 2.2.1 在TensorFlow框架中导入CIFAR-10数据集

- 2.2.2 数据归一化

- 2.3数据可视化

- 三、构建简单的CNN网络(卷积神经网络)

- 3.1 网络结构

- 3.2 编译模型

- 四、训练模型

- 五、预测

- 六、模型评估

- 七、总结

一、创建环境

-

🏡我的环境:

- ● 语言环境:Python3.8

-

● 深度学习环境:TensorFlow2

运行环境: colab

二、前期准备

2.1 设置GPU

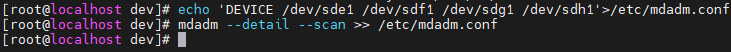

import tensorflow as tf

gpus = tf.config.list_physical_devices("GPU")

if gpus:

gpu0 = gpus[0] #如果有多个GPU,仅使用第0个GPU

tf.config.experimental.set_memory_growth(gpu0, True) #设置GPU显存用量按需使用

tf.config.set_visible_devices([gpu0],"GPU")

2.2 导入数据

2.2.1 在TensorFlow框架中导入CIFAR-10数据集

本次使用的是CIFAR-10数据集,这是一个常用的图像识别数据集,包含10个类别的60000张32x32彩色图像。

👉 datasets.cifar10.load_data() :

train_images是训练集的图像数据,形状为(50000, 32, 32, 3),表示有50000张图像,每张图像是32x32像素,并且有3个颜色通道(RGB)。

train_labels是训练集的标签,形状为(50000,),表示有50000个标签。

test_images是测试集的图像数据,形状为(10000, 32, 32, 3),表示有10000张图像。

test_labels是测试集的标签,形状为(10000,),表示有10000个标签。

import tensorflow as tf

from tensorflow.keras import datasets, layers, models # datasets用于加载数据集,layers用于构建神经网络的层,models用于构建和训练模型。

import matplotlib.pyplot as plt

(train_images, train_labels), (test_images, test_labels) = datasets.cifar10.load_data() # 加载CIFAR-10数据集

输出:

2.2.2 数据归一化

# 将像素的值标准化至0到1的区间内。(对于灰度图片来说,每个像素最大值是255,每个像素最小值是0,也就是直接除以255就可以完成归一化。)

train_images, test_images = train_images / 255.0, test_images / 255.0

train_images.shape,test_images.shape,train_labels.shape,test_labels.shape

结果输出:

2.3数据可视化

class_names = ['airplane', 'automobile', 'bird', 'cat', 'deer','dog', 'frog', 'horse', 'ship', 'truck']

plt.figure(figsize=(20,10))

for i in range(20):

plt.subplot(5,10,i+1)

plt.xticks([])

plt.yticks([])

plt.grid(False)

plt.imshow(train_images[i], cmap=plt.cm.binary)

plt.xlabel(class_names[train_labels[i][0]])

plt.show()

三、构建简单的CNN网络(卷积神经网络)

3.1 网络结构

平面结构:

立体结构:

⭐卷积层

卷积层是卷积神经网络(CNN)中的基础组件,它通过一组可学习的过滤器(或内核)在输入数据(如图像)上进行卷积操作,以提取局部特征和模式;这些过滤器在整个输入数据上滑动,并通过元素相乘和求和生成特征图,每个特征图代表输入数据在特定过滤器下的特征响应,整个过程通过权值共享和局部连接减少参数数量,使得网络能够高效地学习图像的层次化表示。

⭐池化层

在图像处理中,由于图像中存在较多冗余信息,可用某一区域子块的统计信息(如最大值或均值等)来刻画该区域中所有像素点呈现的空间分布模式,以替代区域子块中所有像素点取值,这就是卷积神经网络中池化(pooling)操作。

池化层可对提取到的特征信息进行降维,实现下采样,同时保留了特征图中主要信息,一方面使特征图变小,简化网络计算复杂度;另一方面进行特征压缩,提取主要特征,增加平移不变性,减少过拟合风险。但其实池化更多程度上是一种计算性能的一个妥协,强硬地压缩特征的同时也损失了一部分信息。

model = models.Sequential([

layers.Conv2D(32, (3, 3), activation='relu', input_shape=(32, 32, 3)), #卷积层1,卷积核3*3

layers.MaxPooling2D((2, 2)), #池化层1,2*2采样

layers.Conv2D(64, (3, 3), activation='relu'), #卷积层2,卷积核3*3

layers.MaxPooling2D((2, 2)), #池化层2,2*2采样

layers.Conv2D(64, (3, 3), activation='relu'), #卷积层3,卷积核3*3

layers.Flatten(), #Flatten层,连接卷积层与全连接层

layers.Dense(64, activation='relu'), #全连接层,特征进一步提取

layers.Dense(10) #输出层,输出预期结果

])

model.summary() # 打印网络结构

输出:

3.2 编译模型

model.compile(optimizer='adam',

loss=tf.keras.losses.SparseCategoricalCrossentropy(from_logits=True),

metrics=['accuracy'])

四、训练模型

-

history: 用来存储训练过程中的相关信息,比如损失(loss)和准确率(accuracy)等指标。在训练结束后,可以通过这个变量来分析模型的训练效果。 -

model.fit(...): 调用模型的fit方法,用于训练模型。fit方法接收多个参数,其中最重要的包括训练数据和标签,以及一些训练配置。 -

train_images和train_labels: 这两个参数分别代表训练数据和对应的标签。train_images是模型训练时使用的特征数据,而train_labels是这些特征数据对应的正确输出标签。 -

epochs=10: 这个参数指定了训练过程中要进行的迭代次数,也就是整个训练数据集要被模型遍历多少次。 -

validation_data=(test_images, test_labels): 这个参数提供了在每个epoch结束后用于验证模型性能的数据。test_images和test_labels分别代表测试数据和标签。这样,模型在每个epoch训练结束后都会在测试集上评估一次,以监控模型的泛化能力。

history = model.fit(train_images, train_labels, epochs=10,

validation_data=(test_images, test_labels))

输出:

五、预测

任意选一张图片:

import numpy as np

pre = model.predict(test_images)

print(class_names[np.argmax(pre[3])])

预测结果:

六、模型评估

import matplotlib.pyplot as plt

plt.plot(history.history['accuracy'], label='accuracy')

plt.plot(history.history['val_accuracy'], label = 'val_accuracy')

plt.xlabel('Epoch')

plt.ylabel('Accuracy')

plt.ylim([0.5, 1])

plt.legend(loc='lower right')

plt.show()

test_loss, test_acc = model.evaluate(test_images, test_labels, verbose=2)

输出结果:

七、总结

本次复习了卷积层和池化层的手动计算过程。

📐卷积层计算公式: