前言

- 学习视频:尚硅谷Docker实战教程(docker教程天花板)

- 本内容仅用于个人学习笔记,如有侵扰,联系删

- 学习文档:

- 云原生系列 - Docker(基础篇)

- 云原生系列 - Docker(高级篇)

- 云原生系列 - Docker搭建私有仓库

- 云原生项目实战文档:

- 谷粒商城-个人笔记(集群部署篇一)

- 谷粒商城-个人笔记(集群部署篇二)

- 谷粒商城-个人笔记(集群部署篇三)

1、Docker复杂安装详说

1.1、安装mysql主从复制

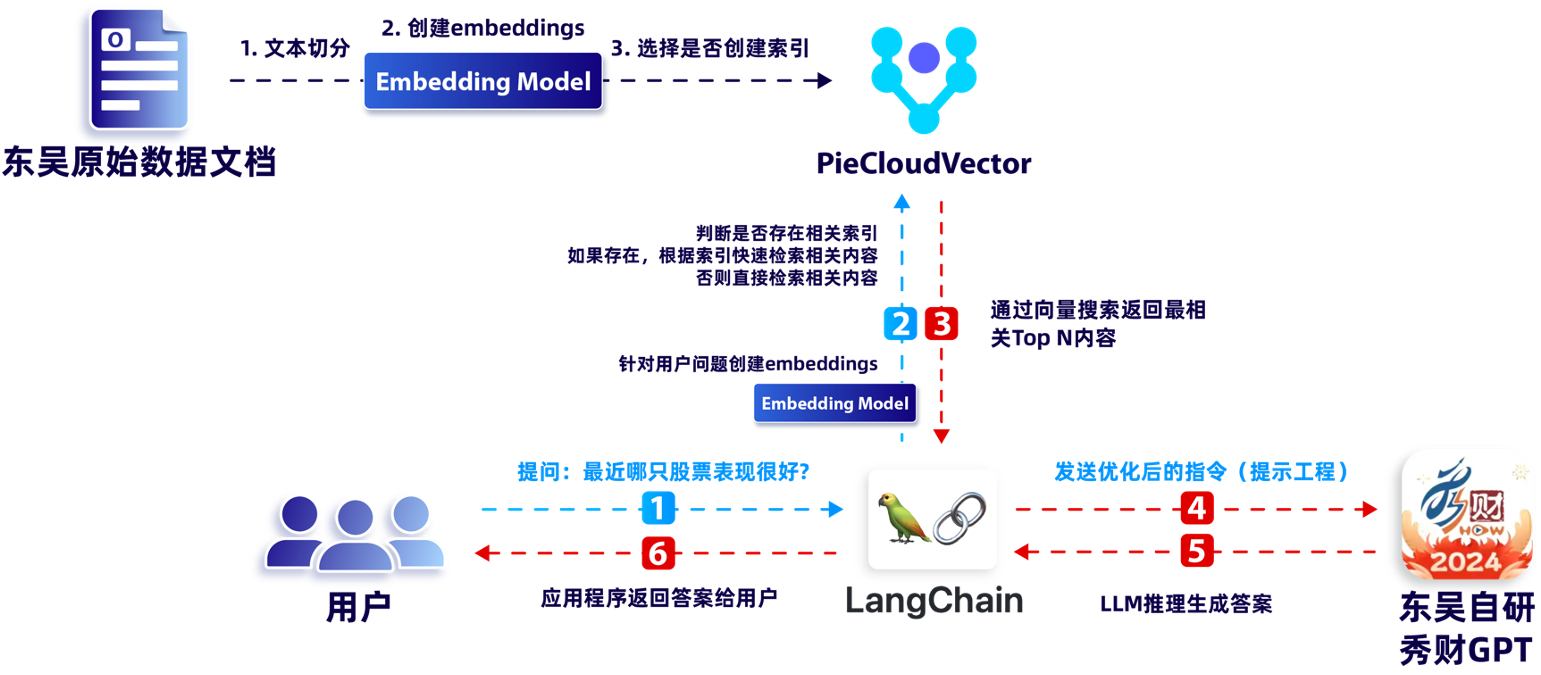

1.1.1、集群原理

以上可以作为企业中常用的数据库解决方案;

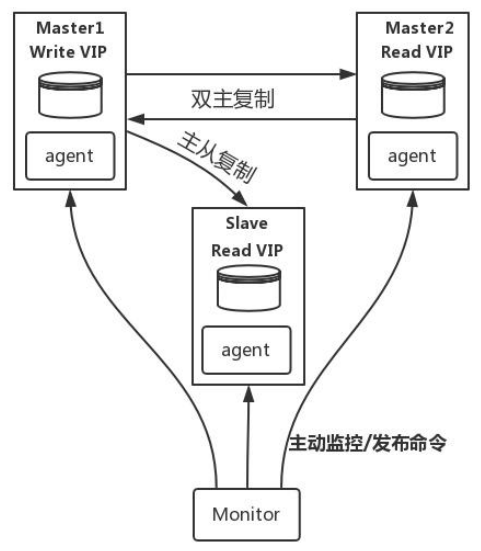

- MySQL-MMM 是 Master-Master Replication Manager for MySQL(mysql 主主复制管理器)的简称,是 Google 的开源项目(Perl 脚本)。MMM 基于 MySQL Replication 做的扩展架构,主要用来监控 mysql 主主复制并做失败转移。其原理是将真实数据库节点的IP(RIP)映射为虚拟 IP(VIP)集。

mysql-mmm 的监管端会提供多个虚拟 IP(VIP),包括一个可写 VIP,多个可读 VIP,通过监管的管理,这些 IP 会绑定在可用 mysql 之上,当某一台 mysql 宕机时,监管会将 VIP迁移至其他 mysql。在整个监管过程中,需要在 mysql 中添加相关授权用户,以便让 mysql 可以支持监理机的维护。授权的用户包括一个mmm_monitor 用户和一个 mmm_agent 用户,如果想使用 mmm 的备份工具则还要添加一个 mmm_tools 用户。

- MHA(Master High Availability)目前在 MySQL 高可用方面是一个相对成熟的解决方案, 由日本 DeNA 公司 youshimaton(现就职于 Facebook 公司)开发,是一套优秀的作为MySQL高可用性环境下故障切换和主从提升的高可用软件。在MySQL故障切换过程中,MHA 能做到在 0~30 秒之内自动完成数据库的故障切换操作(以 2019 年的眼光来说太慢了),并且在进行故障切换的过程中,MHA 能在最大程度上保证数据的一致性,以达到真正意义上的高可用。

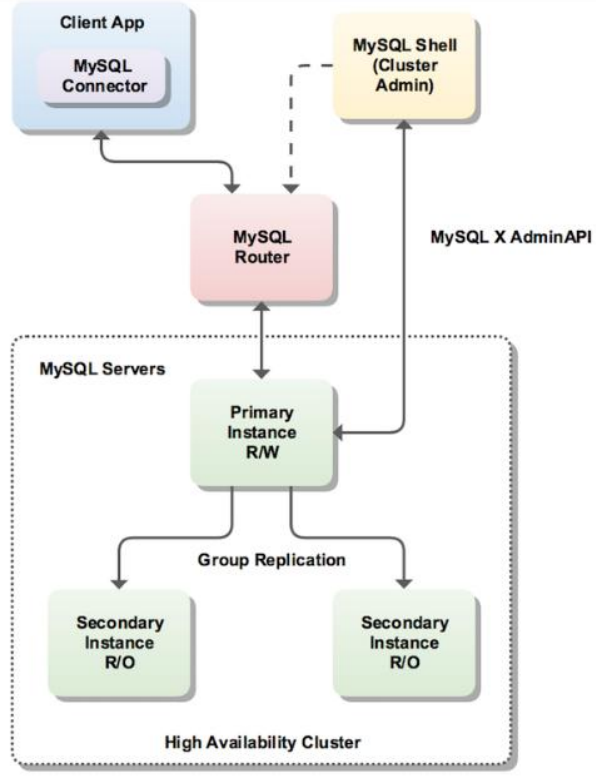

- InnoDB Cluster 支持自动 Failover、强一致性、读写分离、读库高可用、读请求负载均衡,横向扩展的特性,是比较完备的一套方案。但是部署起来复杂,想要解决 router单点问题好需要新增组件,如没有其他更好的方案可考虑该方案。 InnoDB Cluster 主要由 MySQL Shell、MySQL Router 和 MySQL 服务器集群组成,三者协同工作,共同为MySQL 提供完整的高可用性解决方案。MySQL Shell 对管理人员提供管理接口,可以很方便的对集群进行配置和管理,MySQL Router 可以根据部署的集群状况自动的初始化,是客户端连接实例。如果有节点 down 机,集群会自动更新配置。集群包含单点写入和多点写入两种模式。在单主模式下,如果主节点 down 掉,从节点自动替换上来,MySQL Router 会自动探测,并将客户端连接到新节点。

1.1.2、主从搭建步骤

1)、新建主服务器容器实例3307

-

下载 mysql 镜像

docker pull mysql:5.7 -

创建 Master 实例并启动

docker run -p 3307:3306 --name mysql-master \ -v /mydata/mysql/mysql-master/log:/var/log/mysql \ -v /mydata/mysql/mysql-master/data:/var/lib/mysql \ -v /mydata/mysql/mysql-master/conf:/etc/mysql \ -e MYSQL_ROOT_PASSWORD=root \ -d mysql:5.7参数说明:

- -p 3307:3306:将容器的 3306 端口映射到主机的 3307 端口

- -v /mydata/mysql/mysql-master/conf:/etc/mysql:将配置文件夹挂在到主机

- -v /mydata/mysql/mysql-master/log:/var/log/mysql:将日志文件夹挂载到主机

- -v /mydata/mysql/mysql-master/data:/var/lib/mysql/:将配置文件夹挂载到主机

- -e MYSQL_ROOT_PASSWORD=root:初始化 root 用户的密码

-

修改 master 基本配置

进入/mydata/mysql/mysql-master/conf目录下新建my.cnfvim /mydata/mysql/mysql-master/conf/my.cnf[mysqld] ## 设置server_id,同一局域网中需要唯一 server_id=101 ## 指定不需要同步的数据库名称 binlog-ignore-db=mysql ## 开启二进制日志功能 log-bin=mall-mysql-bin ## 设置二进制日志使用内存大小(事务) binlog_cache_size=1M ## 设置使用的二进制日志格式(mixed,statement,row) binlog_format=mixed ## 二进制日志过期清理时间。默认值为0,表示不自动清理。 expire_logs_days=7 ## 跳过主从复制中遇到的所有错误或指定类型的错误,避免slave端复制中断。 ## 如:1062错误是指一些主键重复,1032错误是因为主从数据库数据不一致。 slave_skip_errors=1062 -

修改完配置后重启master实例

docker restart mysql-master -

进入mysql-master容器

docker exec -it mysql-master /bin/bashmysql -uroot -proot -

master容器实例内创建数据同步用户

创建一个具有连接数据库权限的用户 ‘slave’,并设置了密码为 ‘123456’,允许从任何主机连接到MySQL数据库CREATE USER 'slave'@'%' IDENTIFIED BY '123456';授予了用户 ‘slave’ 在任何主机上执行MySQL数据库复制操作和查看复制状态的权限。这是配置MySQL主从复制所必需的权限之一

GRANT REPLICATION SLAVE, REPLICATION CLIENT ON *.* TO 'slave'@'%';

2)、新建从服务器容器实例3308

-

创建 slave实例并启动

docker run -p 3308:3306 --name mysql-slave \ -v /mydata/mysql/mysql-slave/log:/var/log/mysql \ -v /mydata/mysql/mysql-slave/data:/var/lib/mysql \ -v /mydata/mysql/mysql-slave/conf:/etc/mysql \ -e MYSQL_ROOT_PASSWORD=root \ -d mysql:5.7 -

修改 slave基本配置

进入/mydata/mysql/mysql-slave/conf目录下新建my.cnfvim /mydata/mysql/mysql-slave/conf/my.cnf[mysqld] ## 设置server_id,同一局域网中需要唯一 server_id=102 ## 指定不需要同步的数据库名称 binlog-ignore-db=mysql ## 开启二进制日志功能,以备Slave作为其它数据库实例的Master时使用 log-bin=mall-mysql-slave1-bin ## 设置二进制日志使用内存大小(事务) binlog_cache_size=1M ## 设置使用的二进制日志格式(mixed,statement,row) binlog_format=mixed ## 二进制日志过期清理时间。默认值为0,表示不自动清理。 expire_logs_days=7 ## 跳过主从复制中遇到的所有错误或指定类型的错误,避免slave端复制中断。 ## 如:1062错误是指一些主键重复,1032错误是因为主从数据库数据不一致 slave_skip_errors=1062 ## relay_log配置中继日志 relay_log=mall-mysql-relay-bin ## log_slave_updates表示slave将复制事件写进自己的二进制日志 log_slave_updates=1 ## slave设置为只读(具有super权限的用户除外) read_only=1 -

修改完配置后重启slave实例

docker restart mysql-slave -

在主数据库中查看主从同步状态

show master status;

-

进入mysql-slave容器

docker exec -it mysql-slave /bin/bashmysql -uroot -proot -

在从数据库中配置主从复制

change master to master_host='192.168.119.128', master_user='slave', master_password='123456', master_port=3307, master_log_file='mall-mysql-bin.000001', master_log_pos=154, master_connect_retry=30;主从复制命令参数说明:

- master_host:主数据库的IP地址;

- master_port:主数据库的运行端口;

- master_user:在主数据库创建的用于同步数据的用户账号;

- master_password:在主数据库创建的用于同步数据的用户密码;

- master_log_file:指定从数据库要复制数据的日志文件,通过查看主数据的状态,获取File参数;

- master_log_pos:指定从数据库从哪个位置开始复制数据,通过查看主数据的状态,获取Position参数;

- master_connect_retry:连接失败重试的时间间隔,单位为秒。

-

在从数据库中查看主从同步状态

show slave status \G;

-

在从数据库中开启主从同步

start slave; -

查看从数据库状态发现已经同步

show slave status \G;

-

主从复制测试

- 主机新建库-使用库-新建表-插入数据,ok

- 从机使用库-查看记录,ok

- 主机新建库-使用库-新建表-插入数据,ok

1.2、安装redis集群(大厂面试题第4季-分布式存储案例真题)

1.2.1、cluster(集群)模式-docker版 哈希槽分区进行亿级数据存储

面试题

1~2亿条数据需要缓存,请问如何设计这个存储案例

回答

-

单机单台100%不可能,肯定是分布式存储,用redis如何落地?

-

上述问题阿里P6~P7工程案例和场景设计类必考题目, 一般业界有3种解决方案

- 哈希取余分区

2亿条记录就是2亿个k,v,我们单机不行必须要分布式多机,假设有3台机器构成一个集群,用户每次读写操作都是根据公式:

hash(key) % N个机器台数,计算出哈希值,用来决定数据映射到哪一个节点上。

-

优点:

简单粗暴,直接有效,只需要预估好数据规划好节点,例如3台、8台、10台,就能保证一段时间的数据支撑。使用Hash算法让固定的一部分请求落到同一台服务器上,这样每台服务器固定处理一部分请求(并维护这些请求的信息),起到负载均衡+分而治之的作用。 -

缺点:

原来规划好的节点,进行扩容或者缩容就比较麻烦了额,不管扩缩,每次数据变动导致节点有变动,映射关系需要重新进行计算,在服务器个数固定不变时没有问题,如果需要弹性扩容或故障停机的情况下,原来的取模公式就会发生变化:Hash(key)/3会变成Hash(key) /?。此时地址经过取余运算的结果将发生很大变化,根据公式获取的服务器也会变得不可控。

某个redis机器宕机了,由于台数数量变化,会导致hash取余全部数据重新洗牌。

- 一致性哈希算法分区

-

是什么

一致性Hash算法背景

一致性哈希算法在1997年由麻省理工学院中提出的,设计目标是为了解决分布式缓存数据变动和映射问题,某个机器宕机了,分母数量改变了,自然取余数不OK了。 -

能干嘛

提出一致性Hash解决方案。 目的是当服务器个数发生变动时, 尽量减少影响客户端到服务器的映射关系 -

3大步骤

- 算法构建一致性哈希环

一致性哈希环

一致性哈希算法必然有个hash函数并按照算法产生hash值,这个算法的所有可能哈希值会构成一个全量集,这个集合可以成为一个hash空间[0, 2 32 − 1 2^{32-1} 232−1],这个是一个线性空间,但是在算法中,我们通过适当的逻辑控制将它首尾相连(0 = 2 32 2^{32} 232),这样让它逻辑上形成了一个环形空间。

它也是按照使用取模的方法,前面笔记介绍的节点取模法是对节点(服务器)的数量进行取模。而一致性Hash算法是对 2 32 2^{32} 232取模,简单来说,一致性Hash算法将整个哈希值空间组织成一个虚拟的圆环,如假设某哈希函数H的值空间为0- 2 32 − 1 2^{32-1} 232−1(即哈希值是一个32位无符号整形),整个哈希环如下图:整个空间按顺时针方向组织,圆环的正上方的点代表0,0点右侧的第一个点代表1,以此类推,2、3、4、……直到 2 32 − 1 2^{32-1} 232−1,也就是说0点左侧的第一个点代表 2 32 − 1 2^{32-1} 232−1, 0和 2 32 − 1 2^{32-1} 232−1在零点中方向重合,我们把这个由 2 32 2^{32} 232个点组成的圆环称为Hash环。

- 服务器IP节点映射

将集群中各个IP节点映射到环上的某一个位置。

将各个服务器使用Hash进行一个哈希,具体可以选择服务器的IP或主机名作为关键字进行哈希,这样每台机器就能确定其在哈希环上的位置。假如4个节点NodeA、B、C、D,经过IP地址的哈希函数计算(hash(ip)),使用IP地址哈希后在环空间的位置如下:

- key落到服务器的落键规则

当我们需要存储一个kv键值对时,首先计算key的hash值,hash(key),将这个key使用相同的函数Hash计算出哈希值并确定此数据在环上的位置,从此位置沿环顺时针“行走”,第一台遇到的服务器就是其应该定位到的服务器,并将该键值对存储在该节点上。

如我们有Object A、Object B、Object C、Object D四个数据对象,经过哈希计算后,在环空间上的位置如下:根据一致性Hash算法,数据A会被定为到Node A上,B被定为到Node B上,C被定为到Node C上,D被定为到Node D上。

- 算法构建一致性哈希环

-

优点

- 一致性哈希算法的

容错性

容错性

假设Node C宕机,可以看到此时对象A、B、D不会受到影响,只有C对象被重定位到Node D。一般的,在一致性Hash算法中,如果一台服务器不可用,则受影响的数据仅仅是此服务器到其环空间中前一台服务器(即沿着逆时针方向行走遇到的第一台服务器)之间数据,其它不会受到影响。简单说,就是C挂了,受到影响的只是B、C之间的数据,并且这些数据会转移到D进行存储。

- 一致性哈希算法的

扩展性

扩展性

数据量增加了,需要增加一台节点NodeX,X的位置在A和B之间,那收到影响的也就是A到X之间的数据,重新把A到X的数据录入到X上即可,

不会导致hash取余全部数据重新洗牌。

- 一致性哈希算法的

-

缺点

- 一致性哈希算法的数据倾斜问题

Hash环的数据倾斜问题

一致性Hash算法在服务节点太少时,容易因为节点分布不均匀而造成数据倾斜(被缓存的对象大部分集中缓存在某一台服务器上)问题,

例如系统中只有两台服务器:

- 一致性哈希算法的数据倾斜问题

-

小总结

为了在节点数目发生改变时尽可能少的迁移数据将所有的存储节点排列在收尾相接的Hash环上,每个key在计算Hash后会顺时针找到临近的存储节点存放。

而当有节点加入或退出时仅影响该节点在Hash环上顺时针相邻的后续节点。优点

加入和删除节点只影响哈希环中顺时针方向的相邻的节点,对其他节点无影响。缺点

数据的分布和节点的位置有关,因为这些节点不是均匀的分布在哈希环上的,所以数据在进行存储时达不到均匀分布的效果。

- 哈希槽分区

- 是什么

-

为什么出现

哈希槽实质就是一个数组,数组[0, 2 14 − 1 2^{14 -1} 214−1]形成hash slot空间。 -

能干什么

解决均匀分配的问题,在数据和节点之间又加入了一层,把这层称为哈希槽(slot),用于管理数据和节点之间的关系,现在就相当于节点上放的是槽,槽里放的是数据。槽解决的是粒度问题,相当于把粒度变大了,这样便于数据移动。

哈希解决的是映射问题,使用key的哈希值来计算所在的槽,便于数据分配。 -

多少个hash槽

一个集群只能有16384个槽,编号0-16383(0-2^14-1)。这些槽会分配给集群中的所有主节点,分配策略没有要求。可以指定哪些编号的槽分配给哪个主节点。集群会记录节点和槽的对应关系。解决了节点和槽的关系后,接下来就需要对key求哈希值,然后对16384取余,余数是几key就落入对应的槽里。slot = CRC16(key) % 16384。以槽为单位移动数据,因为槽的数目是固定的,处理起来比较容易,这样数据移动问题就解决了。

-

- 哈希槽计算

Redis 集群中内置了 16384 个哈希槽,redis 会根据节点数量大致均等的将哈希槽映射到不同的节点。当需要在 Redis 集群中放置一个 key-value时,redis 先对 key 使用 crc16 算法算出一个结果,然后把结果对 16384 求余数,这样每个 key 都会对应一个编号在 0-16383 之间的哈希槽,也就是映射到某个节点上。如下代码,key之A 、B在Node2, key之C落在Node3上

- 哈希取余分区

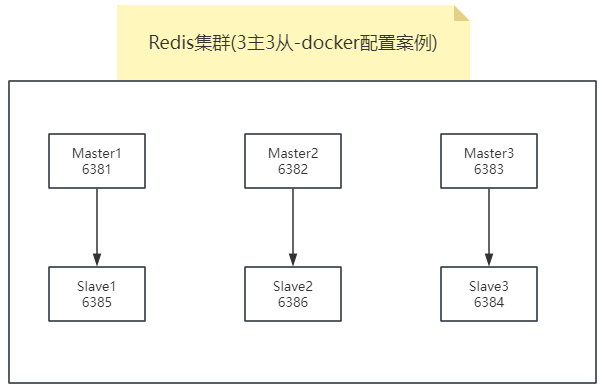

1.2.2、3主3从redis集群配置

-

新建6个docker容器redis实例

docker run -d --name redis-node-1 --net host --privileged=true -v /mydata/redis/redis-node-1:/data redis:6.0.8 --cluster-enabled yes --appendonly yes --port 6381 docker run -d --name redis-node-2 --net host --privileged=true -v /mydata/redis/redis-node-2:/data redis:6.0.8 --cluster-enabled yes --appendonly yes --port 6382 docker run -d --name redis-node-3 --net host --privileged=true -v /mydata/redis/redis-node-3:/data redis:6.0.8 --cluster-enabled yes --appendonly yes --port 6383 docker run -d --name redis-node-4 --net host --privileged=true -v /mydata/redis/redis-node-4:/data redis:6.0.8 --cluster-enabled yes --appendonly yes --port 6384 docker run -d --name redis-node-5 --net host --privileged=true -v /mydata/redis/redis-node-5:/data redis:6.0.8 --cluster-enabled yes --appendonly yes --port 6385 docker run -d --name redis-node-6 --net host --privileged=true -v /mydata/redis/redis-node-6:/data redis:6.0.8 --cluster-enabled yes --appendonly yes --port 6386

命令分步解释:

- docker run: 创建并运行docker容器实例

- –name redis-node-6: 容器名字

- –net host: 使用宿主机的IP和端口,默认

- –privileged=true: 获取宿主机root用户权限

- -v /data/redis/share/redis-node-6:/data: 容器卷,宿主机地址:docker内部地址

- redis:6.0.8: redis镜像和版本号

- –cluster-enabled yes: 开启redis集群

- –appendonly yes: 开启持久化

- –port 6386: redis端口号

-

进入容器redis-node-1并为6台机器构建集群关系

- 进入容器

docker exec -it redis-node-1 /bin/bash - 构建主从关系

注意,进入docker容器后才能执行一下命令,且注意自己的真实IP地址

–cluster-replicas 1 表示为每个master创建一个slave节点redis-cli --cluster create 192.168.119.128:6381 192.168.119.128:6382 192.168.119.128:6383 192.168.119.128:6384 192.168.119.128:6385 192.168.119.128:6386 --cluster-replicas 1

一切OK的话,3主3从搞定

- 进入容器

-

链接进入6381作为切入点,查看集群状态

redis-cli -p 6381cluster info

-

链接进入6381作为切入点,查看节点状态

cluster nodes

1.2.3、主从容错切换迁移案例

-

对6381新增两个key

redis-cli -p 6381

这种方式登录我们是进入的单节点6381,因为我们新增的k1的槽点是12706,不属于6381的范围,应该属于6383的节点,所以这种新增是有问题的。防止路由失效加参数-c并新增两个key

加入参数-c,优化路由

我们使用集群方式连接,我们新增key时,根据这个key的槽点,会重定向对应的节点 -

查看集群信息

redis-cli --cluster check 192.168.119.128:6381

-

容错切换迁移

-

主6381和从机切换,先停止主机6381

-

再次查看集群信息

6381主机停了,对应的真实从机上位

6381宕机了,6385上位成为了新的master。 -

查询原先新增的两个key:k1、k2。数据都存在

-

先还原之前的3主3从

- 先启6381

docker start redis-node-1

- 再停6385

docker stop redis-node-5

- 再启6385

docker start redis-node-5

- 查看集群状态

bash redis-cli --cluster check 192.168.119.128:6381

- 先启6381

-

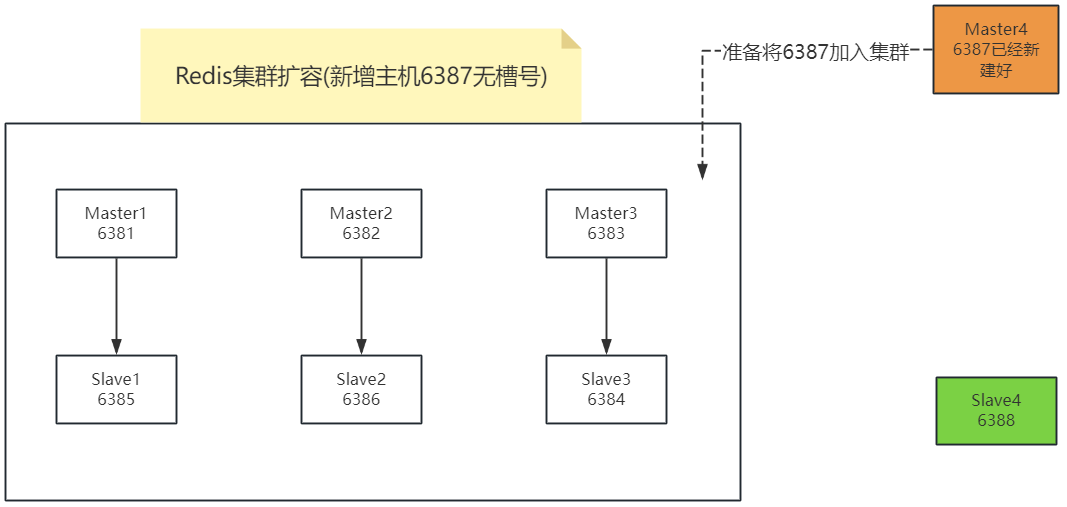

1.2.4、主从扩容案例

-

新建6387、6388两个节点+新建后启动+查看是否8节点

docker run -d --name redis-node-7 --net host --privileged=true -v /mydata/redis/redis-node-7:/data redis:6.0.8 --cluster-enabled yes --appendonly yes --port 6387 docker run -d --name redis-node-8 --net host --privileged=true -v /mydata/redis/redis-node-8:/data redis:6.0.8 --cluster-enabled yes --appendonly yes --port 6388

-

进入6387容器实例内部

docker exec -it redis-node-7 /bin/bash -

将新增的6387节点(空槽号)作为master节点加入原集群

redis-cli --cluster add-node 192.168.119.128:6387 192.168.119.128:6381

命令说明:- 6387 就是将要作为master新增节点

- 6381 就是原来集群节点里面的领路人,相当于6387拜拜6381的码头从而找到组织加入集群

-

检查集群情况第1次

redis-cli --cluster check 192.168.119.128:6381

-

重新分派槽号

命令:redis-cli --cluster reshard IP地址:端口号redis-cli --cluster reshard 192.168.119.128:6381

-

检查集群情况第2次

redis-cli --cluster check 192.168.119.128:6381

-

槽号分派说明

为什么6387是3个新的区间,以前的还是连续?

重新分配成本太高,所以前3家各自匀出来一部分,从6381/6382/6383三个旧节点分别匀出1364个坑位给新节点6387

-

为主节点6387分配从节点6388

命令:redis-cli --cluster add-node ip:新slave端口 ip:新master端口 --cluster-slave --cluster-master-id 新主机节点IDredis-cli --cluster add-node 192.168.119.128:6388 192.168.119.128:6387 --cluster-slave --cluster-master-id a9d42e206020b9ac393be1eafb0cf82bca4dc5da-------这个是6387的编号,按照自己实际情况

-

检查集群情况第3次

redis-cli --cluster check 192.168.119.128:6382

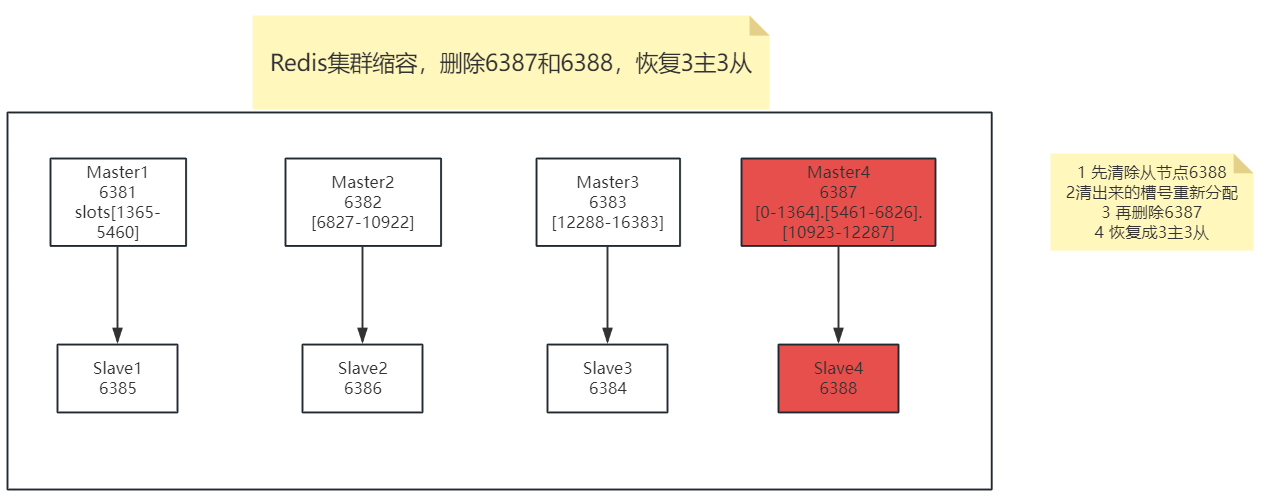

1.2.5、主从缩容案例

目的:6387和6388下线

-

检查集群情况1获得6388的节点ID

redis-cli --cluster check 192.168.119.128:6382

-

将6388删除 从集群中将4号从节点6388删除

命令:redis-cli --cluster del-node ip:从机端口 从机6388节点IDredis-cli --cluster del-node 192.168.119.128:6388 938b6166126f981875dd2f36ae5cd68618e43fa8

检查一下发现,6388被删除了,只剩下7台机器了。redis-cli --cluster check 192.168.119.128:6382

-

将6387的槽号清空,重新分配,本例将清出来的槽号都给6381

redis-cli --cluster reshard 192.168.119.128:6381

-

检查集群情况第二次

redis-cli --cluster check 192.168.119.128:63814096个槽位都指给6381,它变成了8192个槽位,相当于全部都给6381了,不然要输入3次,一锅端

-

将6387删除

命令:redis-cli --cluster del-node ip:端口 6387节点IDredis-cli --cluster del-node 192.168.119.128:6387 a9d42e206020b9ac393be1eafb0cf82bca4dc5da

-

检查集群情况第三次

redis-cli --cluster check 192.168.119.128:6381

2、DockerFile解析

2.1、概述

Dockerfile是用来构建Docker镜像的文本文件,是由一条条构建镜像所需的指令和参数构成的脚本。

官网:https://docs.docker.com/engine/reference/builder/

构建三步骤:

- 编写Dockerfile文件

- docker build命令构建镜像

- docker run依镜像运行容器实例

2.2、DockerFile构建过程解析

2.2.1、Dockerfile内容基础知识

- 每条保留字指令都

必须为大写字母且后面要跟随至少一个参数 - 指令按照从上到下,顺序执行

- #表示注释

- 每条指令都会创建一个新的镜像层并对镜像进行提交

2.2.2、Docker执行Dockerfile的大致流程

- docker从基础镜像运行一个容器

- 执行一条指令并对容器作出修改

- 执行类似docker commit的操作提交一个新的镜像层

- docker再基于刚提交的镜像运行一个新容器

- 执行dockerfile中的下一条指令直到所有指令都执行完成

2.2.3、小总结

从应用软件的角度来看,Dockerfile、Docker镜像与Docker容器分别代表软件的三个不同阶段,

- Dockerfile是软件的原材料

- Docker镜像是软件的交付品

- Docker容器则可以认为是软件镜像的运行态,也即依照镜像运行的容器实例

Dockerfile面向开发,Docker镜像成为交付标准,Docker容器则涉及部署与运维,三者缺一不可,合力充当Docker体系的基石。

-

Dockerfile,需要定义一个Dockerfile,Dockerfile定义了进程需要的一切东西。Dockerfile涉及的内容包括执行代码或者是文件、环境变量、依赖包、运行时环境、动态链接库、操作系统的发行版、服务进程和内核进程(当应用进程需要和系统服务和内核进程打交道,这时需要考虑如何设计namespace的权限控制)等等;

-

Docker镜像,在用Dockerfile定义一个文件之后,docker build时会产生一个Docker镜像,当运行 Docker镜像时会真正开始提供服务;

-

Docker容器,容器是直接提供服务的。

2.3、DockerFile常用保留字指令

- 参考tomcat8的dockerfile入门

https://github.com/docker-library/tomcat - FROM

基础镜像,当前新镜像是基于哪个镜像的,指定一个已经存在的镜像作为模板,第一条必须是from - MAINTAINER

镜像维护者的姓名和邮箱地址 - RUN

- 容器构建时需要运行的命令

- 两种格式

- shell格式

RUN yum -y install vim - exec格式

- shell格式

- RUN是在 docker build时运行

- EXPOSE

当前容器对外暴露出的端口 - WORKDIR

指定在创建容器后,终端默认登陆的进来工作目录,一个落脚点 - USER

指定该镜像以什么样的用户去执行,如果都不指定,默认是root - ENV

用来在构建镜像过程中设置环境变量

ENV MY_PATH /usr/mytest

这个环境变量可以在后续的任何RUN指令中使用,这就如同在命令前面指定了环境变量前缀一样;

也可以在其它指令中直接使用这些环境变量,

比如:WORKDIR $MY_PATH

- ADD

将宿主机目录下的文件拷贝进镜像且会自动处理URL和解压tar压缩包 - COPY

类似ADD,拷贝文件和目录到镜像中。 将从构建上下文目录中 <源路径> 的文件/目录复制到新的一层的镜像内的 <目标路径> 位置- COPY src dest

- COPY [“src”, “dest”]

- <src源路径>:源文件或者源目录

- <dest目标路径>:容器内的指定路径,该路径不用事先建好,路径不存在的话,会自动创建。

- VOLUME

容器数据卷,用于数据保存和持久化工作 - CMD

- 指定容器启动后的要干的事情

- 注意

- Dockerfile 中可以有多个 CMD 指令,

但只有最后一个生效,CMD 会被 docker run 之后的参数替换 - 参考官网Tomcat的dockerfile演示讲解

-

官网最后一行命令

-

我们演示自己的覆盖操作

-

- Dockerfile 中可以有多个 CMD 指令,

- 它和前面RUN命令的区别

- CMD是在docker run 时运行。

- RUN是在 docker build时运行。

- 指定容器启动后的要干的事情

- ENTRYPOINT

-

也是用来指定一个容器启动时要运行的命令

-

类似于 CMD 指令,

但是ENTRYPOINT不会被docker run后面的命令覆盖, 而且这些命令行参数会被当作参数送给 ENTRYPOINT 指令指定的程序 -

命令格式和案例说明

命令格式:

ENTRYPOINT可以和CMD一起用,一般是变参才会使用 CMD ,这里的 CMD 等于是在给 ENTRYPOINT 传参。

当指定了ENTRYPOINT后,CMD的含义就发生了变化,不再是直接运行其命令而是将CMD的内容作为参数传递给ENTRYPOINT指令,他两个组合会变成案例如下:假设已通过 Dockerfile 构建了

nginx:test镜像:

是否传参 按照dockerfile编写执行 传参运行 Docker命令 docker run nginx:test docker run nginx:test -c /etc/nginx/new.conf 衍生出的实际命令 nginx -c /etc/nginx/nginx.conf nginx -c /etc/nginx/new.conf -

优点

在执行docker run的时候可以指定 ENTRYPOINT 运行所需的参数。 -

注意

如果 Dockerfile 中如果存在多个 ENTRYPOINT 指令,仅最后一个生效。

-

- 小总结

2.4、案例

2.4.1、自定义镜像mycentosjava8

-

要求

- Centos7镜像具备vim+ifconfig+jdk8

- JDK的下载镜像地址

- 官网

下载地址:https://www.oracle.com/java/technologies/downloads/#java8

- https://mirrors.yangxingzhen.com/jdk/

- 官网

-

编写

准备编写Dockerfile文件(大写字母D)

FROM centos MAINTAINER 563540326@qq.com ENV MYPATH /usr/local WORKDIR $MYPATH #安装vim编辑器 RUN yum -y install vim #安装ifconfig命令查看网络IP RUN yum -y install net-tools #安装java8及lib库 RUN yum -y install glibc.i686 RUN mkdir /usr/local/java #ADD 是相对路径jar,把jdk-8u341-linux-x64.tar.gz添加到容器中,安装包必须要和Dockerfile文件在同一位置 ADD jdk-8u341-linux-x64.tar.gz /usr/local/java/ #配置java环境变量 ENV JAVA_HOME /usr/local/java/jdk1.8.0_341 ENV JRE_HOME $JAVA_HOME/jre ENV CLASSPATH $JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar:$JRE_HOME/lib:$CLASSPATH ENV PATH $JAVA_HOME/bin:$PATH EXPOSE 80 CMD echo $MYPATH CMD echo "success--------------ok" CMD /bin/bash -

构建

命令:docker build -t 新镜像名字:TAG .; 注意,上面TAG后面有个空格,有个点docker build -t centosjava8:1.5 .-

构建镜像时报错[root@localhost yum.repos.d]# docker build -t centosjava8:1.5 . [+] Building 0.0s (1/1) FINISHED docker:default => [internal] load build definition from Dockerfile 0.0s => => transferring dockerfile: 2B 0.0s ERROR: failed to solve: failed to read dockerfile: open Dockerfile: no such file or directory [root@localhost yum.repos.d]# cd myfile -bash: cd: myfile: 没有那个文件或目录 [root@localhost yum.repos.d]# cd [root@localhost ~]# cd myfile [root@localhost myfile]# docker build -t centosjava8:1.5 . [+] Building 0.5s (7/11) docker:default => [internal] load build definition from Dockerfile 0.0s => => transferring dockerfile: 772B 0.0s => [internal] load metadata for docker.io/library/centos:latest 0.0s => [internal] load .dockerignore 0.0s => => transferring context: 2B 0.0s => [1/7] FROM docker.io/library/centos:latest 0.0s => [internal] load build context 0.0s => => transferring context: 50B 0.0s => CACHED [2/7] WORKDIR /usr/local 0.0s => ERROR [3/7] RUN yum -y install vim 0.5s ------ > [3/7] RUN yum -y install vim: 0.409 CentOS Linux 8 - AppStream 0.0 B/s | 0 B 00:00 0.410 Errors during downloading metadata for repository 'appstream': 0.410 - Curl error (6): Couldn't resolve host name for http://mirrorlist.centos.org/?release=8&arch=x86_64&repo=AppStream&infra=container [Could not resolve host: mirrorlist.centos.org] 0.411 Error: Failed to download metadata for repo 'appstream': Cannot prepare internal mirrorlist: Curl error (6): Couldn't resolve host name for http://mirrorlist.centos.org/?release=8&arch=x86_64&repo=AppStream&infra=container [Could not resolve host: mirrorlist.centos.org] ------ Dockerfile:8 -------------------- 6 | 7 | #安装vim编辑器 8 | >>> RUN yum -y install vim 9 | #安装ifconfig命令查看网络IP 10 | RUN yum -y install net-tools -------------------- ERROR: failed to solve: process "/bin/sh -c yum -y install vim" did not complete successfully: exit code: 1 -

问题分析:> [3/4] RUN yum -y install vim: #0 1.396 CentOS Linux 8 - AppStream 42 B/s | 38 B 00:00 #0 1.402 Error: Failed to download metadata for repo 'appstream': Cannot prepare internal mirrorlist: No URLs in mirrorlist 报错:无法下载 repo 'appstream' 的元数据:无法准备内部镜像列表:镜像列表中没有 URL 由上错误描述可知:问题是由于最新版本CentOS Linux 8中vim软件资源下载失败导致。 -

问题解决:

添加版本信息并修改为7

-

-

运行

命令:docker run -it 新镜像名字:TAGdocker run -it centosjava8:1.5 /bin/bash

-

再体会下UnionFS(联合文件系统)

UnionFS(联合文件系统):Union文件系统(UnionFS)是一种分层、轻量级并且高性能的文件系统,它支持对文件系统的修改作为一次提交来一层层的叠加,同时可以将不同目录挂载到同一个虚拟文件系统下(unite several directories into a single virtual filesystem)。Union 文件系统是 Docker 镜像的基础。镜像可以通过分层来进行继承,基于基础镜像(没有父镜像),可以制作各种具体的应用镜像。特性:一次同时加载多个文件系统,但从外面看起来,只能看到一个文件系统,联合加载会把各层文件系统叠加起来,这样最终的文件系统会包含所有底层的文件和目录

2.4.2、虚悬镜像

仓库名、标签都是的镜像,俗称dangling image

-

Dockerfile写一个

vim Dockerfilefrom ubuntu CMD echo 'action is success'docker build .

-

查看

docker image ls -f dangling=true命令结果

-

删除

docker image prune虚悬镜像已经失去存在价值,可以删除

3、Docker微服务实战

3.1、通过IDEA新建一个普通微服务模块

-

建Module

springboot_docker

-

改POM

<?xml version="1.0" encoding="UTF-8"?> <project xmlns="http://maven.apache.org/POM/4.0.0" xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance" xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 https://maven.apache.org/xsd/maven-4.0.0.xsd"> <modelVersion>4.0.0</modelVersion> <parent> <groupId>org.springframework.boot</groupId> <artifactId>spring-boot-starter-parent</artifactId> <version>2.7.6</version> <relativePath/> <!-- lookup parent from repository --> </parent> <groupId>com.wts</groupId> <artifactId>springboot_docker</artifactId> <version>0.0.1-SNAPSHOT</version> <name>springboot_docker</name> <description>docker学习</description> <properties> <java.version>1.8</java.version> <project.build.sourceEncoding>UTF-8</project.build.sourceEncoding> <project.reporting.outputEncoding>UTF-8</project.reporting.outputEncoding> </properties> <dependencies> <dependency> <groupId>org.springframework.boot</groupId> <artifactId>spring-boot-starter-web</artifactId> </dependency> <dependency> <groupId>org.springframework.boot</groupId> <artifactId>spring-boot-starter-test</artifactId> <scope>test</scope> </dependency> </dependencies> <build> <plugins> <plugin> <groupId>org.springframework.boot</groupId> <artifactId>spring-boot-maven-plugin</artifactId> </plugin> </plugins> </build> </project> -

写YML

server.port=6001 -

主启动

package com.wts; import org.springframework.boot.SpringApplication; import org.springframework.boot.autoconfigure.SpringBootApplication; @SpringBootApplication public class SpringbootDockerApplication { public static void main(String[] args) { SpringApplication.run(SpringbootDockerApplication.class, args); } } -

业务类

package com.wts.controller; import org.springframework.beans.factory.annotation.Value; import org.springframework.web.bind.annotation.RequestMapping; import org.springframework.web.bind.annotation.RequestMethod; import org.springframework.web.bind.annotation.RestController; import java.util.UUID; @RestController public class OrderController { @Value("${server.port}") private String port; @RequestMapping("/order/docker") public String helloDocker() { return "hello docker" + "\t" + port + "\t" + UUID.randomUUID().toString(); } @RequestMapping(value = "/order/index", method = RequestMethod.GET) public String index() { return "服务端口号: " + "\t" + port + "\t" + UUID.randomUUID().toString(); } } -

测试,访问本地服务:http://localhost:6001/order/docker

3.2、通过dockerfile发布微服务部署到docker容器

-

IDEA工具里面搞定微服务jar包:springboot_docker-0.0.1-SNAPSHOT.jar

-

编写Dockerfile

Dockerfile内容# 基础镜像使用java FROM java:8 # 作者 MAINTAINER wts # VOLUME 指定临时文件目录为/tmp,在主机/var/lib/docker目录下创建了一个临时文件并链接到容器的/tmp VOLUME /tmp # 将jar包添加到容器中并更名为wts_docker.jar ADD springboot_docker-0.0.1-SNAPSHOT.jar wts_docker.jar # 运行jar包 RUN bash -c 'touch /wts_docker.jar' ENTRYPOINT ["java","-jar","/wts_docker.jar"] #暴露6001端口作为微服务 EXPOSE 6001将微服务jar包和Dockerfile文件上传到同一个目录下/mydocker

-

构建镜像

docker build -t wts_docker:1.6 .打包成镜像文件

-

运行容器

docker run -d -p 6001:6001 wts_docker:1.6

-

测试,访问地址:http://192.168.119.128:6001/order/docker

4、Docker网络

4.1、是什么

-

docker不启动,默认网络情况

- ens33:宿主机linux本机网络

- lo:本地网络

- virbr0:虚拟网桥网络,我们虚拟机用的NAT,没有用虚拟网桥网络所以没显示

在CentOS7的安装过程中如果有

选择相关虚拟化的的服务安装系统后,启动网卡时会发现有一个以网桥连接的私网地址的virbr0网卡(virbr0网卡:它还有一个固定的默认IP地址192.168.122.1),是做虚拟机网桥的使用的,其作用是为连接其上的虚机网卡提供 NAT访问外网的功能。我们之前学习Linux安装,勾选安装系统的时候附带了libvirt服务才会生成的一个东西,如果不需要可以直接将libvirtd服务卸载,

yum remove libvirt-libs.x86_64 -

docker启动后,网络情况

会产生一个名为docker0的虚拟网桥

-

查看docker网络模式命令

默认创建3大网络模式docker network ls

4.2、常用基本命令

- All命令

请查看文档 云原生系列 - Docker(基础篇) 的 3、Docker常用命令 - 查看网络

docker network ls - 查看网络源数据

docker network inspect XXX网络名字 - 删除网络

docker network rm XXX网络名字 - 案例

4.3、能干嘛

- 容器间的互联和通信以及端口映射

- 容器IP变动时候可以通过服务名直接网络通信而不受到影响

4.4、网络模式

-

总体介绍

- bridge模式:使用–network bridge指定,默认使用docker0

- host模式:使用–network host指定

- none模式:使用–network none指定

- container模式:使用–network container:NAME或者容器ID指定

-

容器实例内默认网络IP生产规则

-

说明

1、先启动两个ubuntu容器实例

2、docker inspect 容器ID or 容器名字

docker inspect u1

docker inspect u2

3、关闭u2实例,新建u3,查看ip变化

-

结论

docker容器内部的ip是有可能会发生改变的

-

-

案例说明

-

bridge

-

是什么

Docker 服务默认会创建一个 docker0 网桥(其上有一个 docker0 内部接口),该桥接网络的名称为docker0,它在内核层连通了其他的物理或虚拟网卡,这就将所有容器和本地主机都放到同一个物理网络。Docker 默认指定了 docker0 接口 的 IP 地址和子网掩码,让主机和容器之间可以通过网桥相互通信。查看 bridge 网络的详细信息,并通过 grep 获取名称项

docker network inspect bridge | grep name

-

案例

-

说明

-

Docker使用Linux桥接,在宿主机虚拟一个Docker容器网桥(docker0),Docker启动一个容器时会根据Docker网桥的网段分配给容器一个IP地址,称为Container-IP,同时Docker网桥是每个容器的默认网关。因为在同一宿主机内的容器都接入同一个网桥,这样容器之间就能够通过容器的Container-IP直接通信。

-

docker run 的时候,没有指定network的话默认使用的网桥模式就是bridge,使用的就是docker0。在宿主机ifconfig,就可以看到docker0和自己create的network(后面讲)eth0,eth1,eth2……代表网卡一,网卡二,网卡三……,lo代表127.0.0.1,即localhost,inet addr用来表示网卡的IP地址

-

网桥docker0创建一对对等虚拟设备接口一个叫veth,另一个叫eth0,成对匹配。

- 整个宿主机的网桥模式都是docker0,类似一个交换机有一堆接口,每个接口叫veth,在本地主机和容器内分别创建一个虚拟接口,并让他们彼此联通(这样一对接口叫veth pair);

- 每个容器实例内部也有一块网卡,每个接口叫eth0;

- docker0上面的每个veth匹配某个容器实例内部的eth0,两两配对,一一匹配。

通过上述,将宿主机上的所有容器都连接到这个内部网络上,两个容器在同一个网络下,会从这个网关下各自拿到分配的ip,此时两个容器的网络是互通的。

-

-

代码

docker run -d -p 8081:8080 --name tomcat81 billygoo/tomcat8-jdk8docker run -d -p 8082:8080 --name tomcat82 billygoo/tomcat8-jdk8

-

两两匹配验证

-

-

-

host

-

是什么

直接使用宿主机的 IP 地址与外界进行通信,不再需要额外进行NAT 转换。 -

案例

- 说明

容器将不会获得一个独立的Network Namespace, 而是和宿主机共用一个Network Namespace。容器将不会虚拟出自己的网卡而是使用宿主机的IP和端口。

- 代码

-

警告

docker run -d -p 8083:8080 --network host --name tomcat83 billygoo/tomcat8-jdk8

问题:

docke启动时总是遇见标题中的警告

原因:

docker启动时指定–network=host或-net=host,如果还指定了-p映射端口,那这个时候就会有此警告,

并且通过-p设置的参数将不会起到任何作用,端口号会以主机端口号为主,重复时则递增。

解决:

解决的办法就是使用docker的其他网络模式,例如–network=bridge,这样就可以解决问题,或者直接无视。。。。O(∩_∩)O哈哈~ -

正确

docker run -d --network host --name tomcat83 billygoo/tomcat8-jdk8

-

- 说明

-

无之前的配对显示了,看容器实例内部

bash docker inspect tomcat83 | tail -n 20

-

没有设置-p的端口映射了,如何访问启动的tomcat83??

http://宿主机IP:8080/在CentOS里面用默认的火狐浏览器访问容器内的tomcat83看到访问成功,因为此时容器的IP借用主机的,所以容器共享宿主机网络IP,这样的好处是外部主机与容器可以直接通信。

-

-

none

- 是什么

在none模式下,并不为Docker容器进行任何网络配置。

也就是说,这个Docker容器没有网卡、IP、路由等信息,只有一个lo需要我们自己为Docker容器添加网卡、配置IP等。

禁用网络功能,只有lo标识(就是127.0.0.1表示本地回环) - 案例

进入容器内部查看docker run -d -p 8084:8080 --network none --name tomcat84 billygoo/tomcat8-jdk8

在容器外部查看

- 是什么

-

container

-

是什么

container⽹络模式

新建的容器和已经存在的一个容器共享一个网络ip配置而不是和宿主机共享。新创建的容器不会创建自己的网卡,配置自己的IP,而是和一个指定的容器共享IP、端口范围等。同样,两个容器除了网络方面,其他的如文件系统、进程列表等还是隔离的。

-

案例

docker run -d -p 8085:8080 --name tomcat85 billygoo/tomcat8-jdk8docker run -d -p 8086:8080 --network container:tomcat85 --name tomcat86 billygoo/tomcat8-jdk8运行结果

相当于tomcat86和tomcat85公用同一个ip同一个端口,导致端口冲突

本案例用tomcat演示不合适。。。演示坑。。。。。。o(╥﹏╥)o换一个镜像给大家演示,

-

案例2

-

Alpine操作系统是一个面向安全的轻型 Linux发行版

Alpine Linux 是一款独立的、非商业的通用 Linux 发行版,专为追求安全性、简单性和资源效率的用户而设计。 可能很多人没听说过这个 Linux 发行版本,但是经常用 Docker 的朋友可能都用过,因为他小,简单,安全而著称,所以作为基础镜像是非常好的一个选择,可谓是麻雀虽小但五脏俱全,镜像非常小巧,不到 6M的大小,所以特别适合容器打包。 -

运行

docker run -it --name alpine1 alpine /bin/shdocker run -it --network container:alpine1 --name alpine2 alpine /bin/sh -

运行结果,验证共用搭桥

-

假如此时关闭alpine1,再看看alpine2

eth0@if80: 消失了。。。。。。关闭alpine1,再看看alpine2

-

-

-

自定义网络

- 过时的link

- 是什么

- 案例

-

before

-

案例

docker run -d -p 8081:8080 --name tomcat81 billygoo/tomcat8-jdk8docker run -d -p 8082:8080 --name tomcat82 billygoo/tomcat8-jdk8上述成功启动并用docker exec进入各自容器实例内部

-

问题

- 按照IP地址ping是OK的

- 按照服务名ping结果???

- 按照IP地址ping是OK的

-

-

after

- 案例

-

自定义桥接网络,自定义网络默认使用的是桥接网络bridge

-

新建自定义网络

-

新建容器加入上一步新建的自定义网络

docker run -d -p 8086:8080 --network wts_network --name tomcat86 billygoo/tomcat8-jdk8docker run -d -p 8087:8080 --network wts_network --name tomcat87 billygoo/tomcat8-jdk8

-

互相ping测试

-

- 问题结论

- 自定义网络本身就维护好了主机名和ip的对应关系(ip和域名都能通)

- 自定义网络本身就维护好了主机名和ip的对应关系(ip和域名都能通)

- 自定义网络本身就维护好了主机名和ip的对应关系(ip和域名都能通)

- 案例

-

- 过时的link

4.5、Docker平台架构图解

-

整体说明

从其架构和运行流程来看,Docker 是一个 C/S 模式的架构,后端是一个松耦合架构,众多模块各司其职。Docker 运行的基本流程为:

- 用户是使用 Docker Client 与 Docker Daemon 建立通信,并发送请求给后者。

- Docker Daemon 作为 Docker 架构中的主体部分,首先提供 Docker Server 的功能使其可以接受 Docker Client 的请求。

- Docker Engine 执行 Docker 内部的一系列工作,每一项工作都是以一个 Job 的形式的存在。

- Job 的运行过程中,当需要容器镜像时,则从 Docker Registry 中下载镜像,并通过镜像管理驱动 Graph driver将下载镜像以Graph的形式存储。

- 当需要为 Docker 创建网络环境时,通过网络管理驱动 Network driver 创建并配置 Docker 容器网络环境。

- 当需要限制 Docker 容器运行资源或执行用户指令等操作时,则通过 Execdriver 来完成。

- Libcontainer是一项独立的容器管理包,Network driver以及Exec driver都是通过Libcontainer来实现具体对容器进行的操作。

-

整体架构

5、Docker-compose容器编排

5.1、是什么

Compose 是 Docker 公司推出的一个工具软件,可以管理多个 Docker 容器组成一个应用。你需要定义一个 YAML 格式的配置文件docker-compose.yml,写好多个容器之间的调用关系。然后,只要一个命令,就能同时启动/关闭这些容器

- Docker-Compose是Docker官方的开源项目, 负责实现对Docker容器集群的快速编排。

5.2、能干嘛

docker建议我们每一个容器中只运行一个服务,因为docker容器本身占用资源极少,所以最好是将每个服务单独的分割开来但是这样我们又面临了一个问题?

如果我需要同时部署好多个服务,难道要每个服务单独写Dockerfile然后在构建镜像,构建容器,这样累都累死了,所以docker官方给我们提供了docker-compose多服务部署的工具

例如要实现一个Web微服务项目,除了Web服务容器本身,往往还需要再加上后端的数据库mysql服务容器,redis服务器,注册中心eureka,甚至还包括负载均衡容器等等。。。。。。

Compose允许用户通过一个单独的docker-compose.yml模板文件(YAML 格式)来定义一组相关联的应用容器为一个项目(project)。

可以很容易地用一个配置文件定义一个多容器的应用,然后使用一条指令安装这个应用的所有依赖,完成构建。Docker-Compose 解决了容器与容器之间如何管理编排的问题。

5.3、去哪下

-

官网

https://docs.docker.com/compose/compose-file/compose-file-v3/ -

官网下载

https://docs.docker.com/compose/install/ -

安装步骤

curl -L "https://github.com/docker/compose/releases/download/1.29.2/docker-compose-$(uname -s)-$(uname -m)" -o /usr/local/bin/docker-composechmod +x /usr/local/bin/docker-composedocker-compose --version

-

卸载步骤

5.4、Compose核心概念

-

一文件

docker-compose.yml -

两要素

- 服务(service)

一个个应用容器实例,比如订单微服务、库存微服务、mysql容器、nginx容器或者redis容器 - 工程(project)

由一组关联的应用容器组成的一个完整业务单元,在 docker-compose.yml 文件中定义。

- 服务(service)

5.5、Compose使用的三个步骤

- 编写Dockerfile定义各个微服务应用并构建出对应的镜像文件

- 使用 docker-compose.yml 定义一个完整业务单元,安排好整体应用中的各个容器服务。

- 最后,执行docker-compose up命令 来启动并运行整个应用程序,完成一键部署上线

5.6、Compose常用命令

Compose常用命令

docker-compose -h:查看帮助docker-compose up:启动所有docker-compose服务docker-compose up -d:启动所有docker-compose服务并后台运行docker-compose down:停止并删除容器、网络、卷、镜像。docker-compose exec yml里面的服务id:进入容器实例内部 docker-compose exec docker-compose.yml文件中写的服务id /bin/bashdocker-compose ps:展示当前docker-compose编排过的运行的所有容器docker-compose top:展示当前docker-compose编排过的容器进程docker-compose logs yml里面的服务id:查看容器输出日志docker-compose config:检查配置docker-compose config -q:检查配置,有问题才有输出docker-compose restart:重启服务docker-compose start:启动服务docker-compose stop:停止服务

5.7、Compose编排微服务

5.7.1、改造升级微服务工程springboot_docker

-

以前的基础版

-

SQL建表建库

CREATE TABLE `t_user` ( `id` int(10) unsigned NOT NULL AUTO_INCREMENT, `username` varchar(50) NOT NULL DEFAULT '' COMMENT '用户名', `password` varchar(50) NOT NULL DEFAULT '' COMMENT '密码', `sex` tinyint(4) NOT NULL DEFAULT '0' COMMENT '性别 0=女 1=男 ', `deleted` tinyint(4) unsigned NOT NULL DEFAULT '0' COMMENT '删除标志,默认0不删除,1删除', `update_time` timestamp NOT NULL DEFAULT CURRENT_TIMESTAMP ON UPDATE CURRENT_TIMESTAMP COMMENT '更新时间', `create_time` timestamp NOT NULL DEFAULT CURRENT_TIMESTAMP COMMENT '创建时间', PRIMARY KEY (`id`) ) ENGINE=InnoDB AUTO_INCREMENT=1 DEFAULT CHARSET=utf8 COMMENT='用户表' -

一键生成说明

-

改POM

<?xml version="1.0" encoding="UTF-8"?> <project xmlns="http://maven.apache.org/POM/4.0.0" xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance" xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 https://maven.apache.org/xsd/maven-4.0.0.xsd"> <modelVersion>4.0.0</modelVersion> <parent> <groupId>org.springframework.boot</groupId> <artifactId>spring-boot-starter-parent</artifactId> <version>2.7.6</version> <relativePath/> <!-- lookup parent from repository --> </parent> <groupId>com.wts</groupId> <artifactId>springboot_docker</artifactId> <version>0.0.1-SNAPSHOT</version> <name>springboot_docker</name> <description>docker学习</description> <properties> <java.version>1.8</java.version> <project.build.sourceEncoding>UTF-8</project.build.sourceEncoding> <project.reporting.outputEncoding>UTF-8</project.reporting.outputEncoding> </properties> <dependencies> <dependency> <groupId>org.springframework.boot</groupId> <artifactId>spring-boot-starter-web</artifactId> </dependency> <dependency> <groupId>org.springframework.boot</groupId> <artifactId>spring-boot-starter-test</artifactId> <scope>test</scope> </dependency> <!--mybatisplus启动器--> <dependency> <groupId>com.baomidou</groupId> <artifactId>mybatis-plus-boot-starter</artifactId> <version>3.5.3.1</version> </dependency> <!--mysql驱动--> <dependency> <groupId>mysql</groupId> <artifactId>mysql-connector-java</artifactId> <scope>runtime</scope> </dependency> <!--lombok用于简化实体类开发--> <dependency> <groupId>org.projectlombok</groupId> <artifactId>lombok</artifactId> <optional>true</optional> </dependency> <!--mybatis-plus代码生成器依赖--> <dependency> <groupId>com.baomidou</groupId> <artifactId>mybatis-plus-generator</artifactId> <version>3.5.3.1</version> </dependency> <!-- freemarker模板 --> <dependency> <groupId>org.freemarker</groupId> <artifactId>freemarker</artifactId> <version>2.3.31</version> </dependency> </dependencies> <build> <plugins> <plugin> <groupId>org.springframework.boot</groupId> <artifactId>spring-boot-maven-plugin</artifactId> </plugin> </plugins> </build> </project> -

写YML

server: port: 6001 spring: #数据源 datasource: driver-class-name: com.mysql.cj.jdbc.Driver url: jdbc:mysql://192.168.119.128:3307/db01?serverTimezone=GMT%2B8&useUnicode=true&characterEncoding=GBK&useSSL=false username: root password: root redis: host: 192.168.119.128 # Redis 服务器连接端口 port: 6379 # Redis 数据库索引(默认为 0) database: 0 # Redis 服务器连接密码(默认为空) password: jedis: pool: # 连接池最大连接数(使用负值表示没有限制) max-active: 8 # 连接池最大阻塞等待时间(使用负值表示没有限制) max-wait: -1 # 连接池中的最大空闲连接 max-idle: 8 # 连接池中的最小空闲连接 min-idle: 0 # 连接超时时间(毫秒) 如果连接超时时间不设置,这要注释掉配置而不能=0,否则会报连接超时错误:Command timed out after no timeout,,有超时时间最后设置为200以上 timeout: 300 -

业务类

添加”com.wts.entity.TUser“类,代码如下:package com.wts.entity; import com.baomidou.mybatisplus.annotation.IdType; import com.baomidou.mybatisplus.annotation.TableId; import com.baomidou.mybatisplus.annotation.TableName; import lombok.Data; import lombok.Getter; import lombok.Setter; import java.io.Serializable; import java.time.LocalDateTime; import java.util.Date; @Getter @Setter @TableName("t_user") public class TUser implements Serializable { private static final long serialVersionUID = 1L; @TableId(value = "id", type = IdType.AUTO) private Integer id; private String username; private String password; private Integer sex; private Integer deleted; private Date update_time; private Date create_time; }添加”com.wts.mapper.TUserMapper“类,代码如下:

@Mapper public interface TUserMapper extends BaseMapper<TUser> { }<?xml version="1.0" encoding="UTF-8"?> <!DOCTYPE mapper PUBLIC "-//mybatis.org//DTD Mapper 3.0//EN" "http://mybatis.org/dtd/mybatis-3-mapper.dtd"> <mapper namespace="com.wts.mapper.TUserMapper"> <!-- 通用查询映射结果 --> <resultMap id="BaseResultMap" type="com.wts.entity.TUser"> <id column="id" property="id" /> <result column="username" property="username" /> <result column="password" property="password" /> <result column="sex" property="sex" /> <result column="deleted" property="deleted" /> <result column="update_time" property="update_time" /> <result column="create_time" property="create_time" /> </resultMap> <!-- 通用查询结果列 --> <sql id="Base_Column_List"> id, username, password, sex, deleted, update_time, create_time </sql> </mapper>添加”com.wts.service.TUserService“类,代码如下:

package com.wts.service; import com.wts.entity.TUser; import com.baomidou.mybatisplus.extension.service.IService; public interface TUserService extends IService<TUser> { void addUser(TUser user); TUser findUserById(Integer id); }添加”com.wts.service.impl.TUserServiceImpl“类,代码如下:

package com.wts.service.impl; import com.baomidou.mybatisplus.extension.service.impl.ServiceImpl; import com.wts.entity.TUser; import com.wts.mapper.TUserMapper; import com.wts.service.TUserService; import org.springframework.beans.factory.annotation.Autowired; import org.springframework.data.redis.core.RedisTemplate; import org.springframework.stereotype.Service; @Service public class TUserServiceImpl extends ServiceImpl<TUserMapper, TUser> implements TUserService { public static final String CACHE_KEY_USER = "user:"; @Autowired private TUserMapper userMapper; @Autowired private RedisTemplate redisTemplate; /** * addUser * * @param user */ public void addUser(TUser user) { // 1 先插入mysql并成功 int i = userMapper.insert(user); if (i > 0) { // 2 需要再次查询一下mysql将数据捞回来并ok user = userMapper.selectById(user.getId()); // 3 将捞出来的user存进redis,完成新增功能的数据一致性。 String key = CACHE_KEY_USER + user.getId(); redisTemplate.opsForValue().set(key, user); } } /** * findUserById * * @param id * @return */ public TUser findUserById(Integer id) { TUser user = null; String key = CACHE_KEY_USER + id; // 1 先从redis里面查询,如果有直接返回结果,如果没有再去查询mysql user = (TUser) redisTemplate.opsForValue().get(key); if (user == null) { // 2 redis里面无,继续查询mysql user = userMapper.selectById(id); if (user == null) { // 3.1 redis+mysql 都无数据 // 你具体细化,防止多次穿透,我们规定,记录下导致穿透的这个key回写redis return user; } else { // 3.2 mysql有,需要将数据写回redis,保证下一次的缓存命中率 redisTemplate.opsForValue().set(key, user); } } return user; } }添加”com.wts.controller.TUserController“类,代码如下:

package com.wts.controller; import com.wts.entity.TUser; import com.wts.service.TUserService; import lombok.extern.slf4j.Slf4j; import org.springframework.beans.factory.annotation.Autowired; import org.springframework.web.bind.annotation.*; import java.util.Random; import java.util.UUID; @Slf4j @RestController public class TUserController { @Autowired private TUserService userService; /** * 数据库新增3条记录 */ @RequestMapping(value = "/user/add", method = RequestMethod.POST) public void addUser() { for (int i = 1; i <= 3; i++) { TUser user = new TUser(); user.setUsername("wts" + i); user.setPassword(UUID.randomUUID().toString().substring(0, 6)); user.setSex(new Random().nextInt(2)); userService.addUser(user); } } /** * 删除1条记录 * * @param id */ @RequestMapping(value = "/user/delete/{id}", method = RequestMethod.POST) public void deleteUser(@PathVariable Integer id) { userService.removeById(id); } /** * 修改1条记录 * * @param user */ @RequestMapping(value = "/user/update", method = RequestMethod.POST) public void updateUser(@RequestBody TUser user) { userService.updateById(user); } /** * 查询1条记录 * * @param id * @return */ @RequestMapping(value = "/user/find/{id}", method = RequestMethod.GET) public TUser findUserById(@PathVariable Integer id) { return userService.findUserById(id); } } -

mvn package命令将微服务形成新的jar包,并上传到Linux服务器/mydocker目录下

-

编写Dockerfile

# 基础镜像使用java FROM java:8 # 作者 MAINTAINER wts # VOLUME 指定临时文件目录为/tmp,在主机/var/lib/docker目录下创建了一个临时文件并链接到容器的/tmp VOLUME /tmp # 将jar包添加到容器中并更名为wts_docker.jar ADD springboot_docker-0.0.1-SNAPSHOT.jar wts_docker.jar # 运行jar包 RUN bash -c 'touch /wts_docker.jar' ENTRYPOINT ["java","-jar","/wts_docker.jar"] #暴露6001端口作为微服务 EXPOSE 6001 -

构建镜像

docker build -t wts_docker:1.7 .

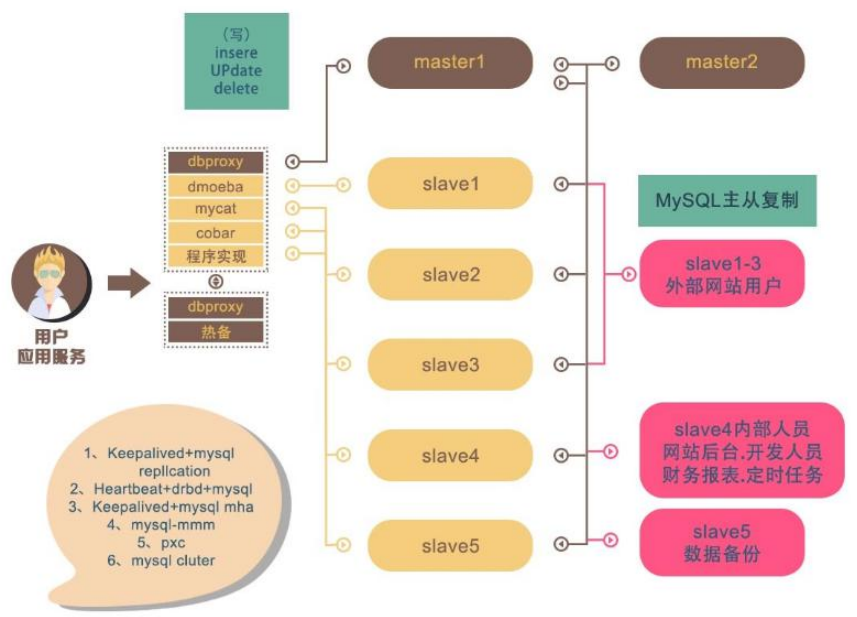

5.7.2、不用compose

-

新建mysql容器实例

docker run -p 3307:3306 --name mysql57 --privileged=true -v /mydata/mysql/conf:/etc/mysql/conf.d -v /mydata/mysql/logs:/logs -v /mydata/mysql/data:/var/lib/mysql -e MYSQL_ROOT_PASSWORD=root -d mysql:5.7进入mysql容器实例并新建库db01+新建表t_user

docker exec -it mysql57 /bin/bash mysql -uroot -p create database db01; use db01; CREATE TABLE `t_user` ( `id` INT(10) UNSIGNED NOT NULL AUTO_INCREMENT, `username` VARCHAR(50) NOT NULL DEFAULT '' COMMENT '用户名', `password` VARCHAR(50) NOT NULL DEFAULT '' COMMENT '密码', `sex` TINYINT(4) NOT NULL DEFAULT '0' COMMENT '性别 0=女 1=男 ', `deleted` TINYINT(4) UNSIGNED NOT NULL DEFAULT '0' COMMENT '删除标志,默认0不删除,1删除', `update_time` TIMESTAMP NOT NULL DEFAULT CURRENT_TIMESTAMP ON UPDATE CURRENT_TIMESTAMP COMMENT '更新时间', `create_time` TIMESTAMP NOT NULL DEFAULT CURRENT_TIMESTAMP COMMENT '创建时间', PRIMARY KEY (`id`) ) ENGINE=INNODB AUTO_INCREMENT=1 DEFAULT CHARSET=utf8mb4 COMMENT='用户表'; -

单独的redis容器实例

docker run -p 6379:6379 --name redis \ -v /mydata/redis/data:/data \ -v /mydata/redis/conf/redis.conf:/etc/redis/redis.conf \ -d redis redis-server /etc/redis/redis.conf -

微服务工程

docker run -d -p 6001:6001 wts_docker:1.7 -

上面三个容器实例依次顺序启动成功

-

测试:

新增:http://192.168.119.128:6001/user/add

查询:http://192.168.119.128:6001/user/find/1

-

上面成功了,有哪些问题?

- 先后顺序要求固定,先mysql+redis才能微服务访问成功

- 多个run命令…

- 容器间的启停或宕机,有可能导致IP地址对应的容器实例变化,映射出错, 要么生产IP写死(可以但是不推荐),要么通过服务调用

5.7.3、使用Compose

-

服务编排,一套带走,安排

-

编写docker-compose.yml文件

version: "3" services: microService: image: wts_docker:1.7 container_name: ms01 ports: - "6001:6001" volumes: - /app/microService:/data networks: - atguigu_net depends_on: - redis - mysql redis: image: redis:6.0.8 ports: - "6379:6379" volumes: - /app/redis/redis.conf:/etc/redis/redis.conf - /app/redis/data:/data networks: - atguigu_net command: redis-server /etc/redis/redis.conf mysql: image: mysql:5.7 environment: MYSQL_ROOT_PASSWORD: 'root' MYSQL_ALLOW_EMPTY_PASSWORD: 'no' MYSQL_DATABASE: 'db01' MYSQL_USER: 'wts' MYSQL_PASSWORD: 'wts123' ports: - "3307:3306" volumes: - /app/mysql/db:/var/lib/mysql - /app/mysql/conf/my.cnf:/etc/my.cnf - /app/mysql/init:/docker-entrypoint-initdb.d networks: - atguigu_net command: --default-authentication-plugin=mysql_native_password # 解决外部无法访问 networks: atguigu_net:解析:

services: microService: image: wts_docker:1.7 container_name: ms01 ports: - "6001:6001" volumes: - /app/microService:/data networks: - atguigu_net这段代码相当于:

docker run -p 6001:6001 /app/microService:/data--network atguigu_net --name ms01 wts_docker:1.7networks: atguigu_net:这段代码相当于:

docker network create atguigu_net -

第二次修改微服务工程springboot_docker

修改ymlserver: port: 6001 spring: #数据源 datasource: driver-class-name: com.mysql.cj.jdbc.Driver # url: jdbc:mysql://192.168.119.128:3307/db01?serverTimezone=GMT%2B8&useUnicode=true&characterEncoding=GBK&useSSL=false url: jdbc:mysql://mysql:3307/db01?serverTimezone=GMT%2B8&useUnicode=true&characterEncoding=GBK&useSSL=false username: root password: root redis: # host: 192.168.119.128 host: redis # Redis 服务器连接端口 port: 6379 # Redis 数据库索引(默认为 0) database: 0 # Redis 服务器连接密码(默认为空) password: jedis: pool: # 连接池最大连接数(使用负值表示没有限制) max-active: 8 # 连接池最大阻塞等待时间(使用负值表示没有限制) max-wait: -1 # 连接池中的最大空闲连接 max-idle: 8 # 连接池中的最小空闲连接 min-idle: 0 # 连接超时时间(毫秒) 如果连接超时时间不设置,这要注释掉配置而不能=0,否则会报连接超时错误:Command timed out after no timeout,,有超时时间最后设置为200以上 timeout: 300 -

通过服务名访问,IP无关

-

mvn package命令将微服务形成新的jar包 并上传到Linux服务器/mydocker目录下

-

编写Dockerfile

还是以前的Dockerfile -

构建镜像

docker build -t wts_docker:1.7 . -

执行 docker-compose up 或者 执行 docker-compose up -d

启动前先检查,docker-compose config -q:检查配置,有问题才有输出

先关闭所有的容器服务,因为我们不用compose已经创建了mysql和redis,所有我们要先关闭再使用,不然会报错,端口冲突

-

进入mysql容器实例并新建库db01+新建表t_user

docker exec -it cf9cb807f6f7 /bin/bashmysql -uroot -prootcreate database db01;use db01;CREATE TABLE `t_user` ( `id` INT(10) UNSIGNED NOT NULL AUTO_INCREMENT, `username` VARCHAR(50) NOT NULL DEFAULT '' COMMENT '用户名', `password` VARCHAR(50) NOT NULL DEFAULT '' COMMENT '密码', `sex` TINYINT(4) NOT NULL DEFAULT '0' COMMENT '性别 0=女 1=男 ', `deleted` TINYINT(4) UNSIGNED NOT NULL DEFAULT '0' COMMENT '删除标志,默认0不删除,1删除', `update_time` TIMESTAMP NOT NULL DEFAULT CURRENT_TIMESTAMP ON UPDATE CURRENT_TIMESTAMP COMMENT '更新时间', `create_time` TIMESTAMP NOT NULL DEFAULT CURRENT_TIMESTAMP COMMENT '创建时间', PRIMARY KEY (`id`) ) ENGINE=INNODB AUTO_INCREMENT=1 DEFAULT CHARSET=utf8mb4 COMMENT='用户表'; -

测试通过

6、Docker轻量级可视化工具Portainer

6.1、简介

Portainer 是一款轻量级的应用,它提供了图形化界面,用于方便地管理Docker环境,包括单机环境和集群环境。

6.2、安装

- 官网

https://www.portainer.io/

https://docs.portainer.io/v/ce-2.9/start/install/server/docker/linux - 步骤

- docker命令安装

docker run -d -p 8000:8000 -p 9000:9000 --name portainer --restart=always -v /var/run/docker.sock:/var/run/docker.sock -v portainer_data:/data portainer/portainer

- 第一次登录需创建admin,访问地址:http://192.168.119.128:9000

用户名,直接用默认admin

密码:Wts123456

- 设置admin用户和密码后首次登陆

- 选择local选项卡后本地docker详细信息展示

- 上一步的图形展示,能想得起对应命令吗?

- docker命令安装

7、Docker容器监控之 CAdvisor+InfluxDB+Granfana

7.1、原生命令

-

操作

docker stats

-

问题

通过docker stats命令可以很方便的看到当前宿主机上所有容器的CPU,内存以及网络流量等数据,一般小公司够用了。。。。但是,

docker stats统计结果只能是当前宿主机的全部容器,数据资料是实时的,没有地方存储、没有健康指标过线预警等功能

7.2、是什么

- 容器监控3剑客

-

一句话

CAdvisor监控收集+InfluxDB存储数据+Granfana展示图表

-

CAdvisor

-

InfluxDB

-

Granfana

-

总结

-

7.3、compose容器编排,一套带走

-

新建目录

-

新建3件套组合的 docker-compose.yml

version: '3.1' volumes: grafana_data: {} services: influxdb: image: tutum/influxdb:0.9 restart: always environment: - PRE_CREATE_DB=cadvisor ports: - "8083:8083" - "8086:8086" volumes: - ./data/influxdb:/data cadvisor: image: google/cadvisor links: - influxdb:influxsrv command: -storage_driver=influxdb -storage_driver_db=cadvisor -storage_driver_host=influxsrv:8086 restart: always ports: - "8080:8080" volumes: - /:/rootfs:ro - /var/run:/var/run:rw - /sys:/sys:ro - /var/lib/docker/:/var/lib/docker:ro grafana: image: grafana/grafana restart: always links: - influxdb:influxsrv ports: - "3000:3000" volumes: - grafana_data:/var/lib/grafana environment: - HTTP_USER=admin - HTTP_PASS=admin - INFLUXDB_HOST=influxsrv - INFLUXDB_PORT=8086 - INFLUXDB_NAME=cadvisor - INFLUXDB_USER=root - INFLUXDB_PASS=root -

启动docker-compose文件

docker-compose up

-

查看三个服务容器是否启动

-

测试

-

浏览cAdvisor收集服务,http://192.168.119.128:8080/

第一次访问慢,请稍等

cadvisor也有基础的图形展现功能,这里主要用它来作数据采集 -

浏览influxdb存储服务,http://192.168.119.128:8083/

-

浏览grafana展现服务,http://192.168.119.128:3000

- ip+3000端口的方式访问,默认帐户密码(

admin/admin)

- 配置步骤

-

配置数据源

-

选择influxdb数据源

-

配置细节

- 1

- 2

- 1

-

配置面板panel

-

1

-

2

-

3

-

4

-

5

到这里cAdvisor+InfluxDB+Grafana容器监控系统就部署完成了

-

-

- ip+3000端口的方式访问,默认帐户密码(

-