引言

随着互联网和云计算的迅速发展,传统的单体架构逐渐被微服务架构所取代。这一变化带来了许多新的挑战,如环境一致性、应用的可移植性、服务的扩展性、服务间通信的管理以及安全性等。为了解决这些问题,业界开发了许多工具和技术,如Docker、Docker Compose、Kubernetes (K8s)、K3s、Service Mesh、Sidecar和Istio。本文将深入探讨这些技术,它们解决的问题,以及它们之间的相互关系。

Docker:开启容器化时代

环境一致性与应用可移植性问题

在传统的应用开发中,不同的操作系统、库版本以及硬件差异可能导致在开发、测试和生产环境中出现“在我电脑上正常运行”的问题。这样的环境不一致性使得应用程序的开发、测试和部署变得复杂且不稳定,这也是困扰着程序同学,经常需要排查环境问题。

Docker的解决方案

Docker作为一种容器化技术,通过将应用程序及其所有依赖打包成一个独立的容器,解决了环境一致性的问题,相当于将运行环境打包到一起。容器包含了运行应用所需的一切,从操作系统到所需的库,使得应用可以在任何支持Docker的平台上运行。这样,开发者可以在不同的环境中获得一致的运行体验,从而大大简化了开发、测试和部署流程。

大部分企业已经做到这一步

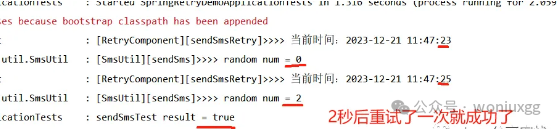

Docker Compose:多容器应用的管理

多容器应用的挑战

随着应用架构逐渐从单体向微服务转变,一个应用往往由多个服务组成。这些服务可能需要运行在不同的容器中,这使得手动配置和管理这些容器变得复杂且耗时。例如,开发者需要记住如何启动每个服务、如何连接它们,以及如何处理它们之间的依赖关系,有些应用需要先启动,有些需要后启动,比如你的springboot需要依赖mysql,依赖redis,需要提前准备中间件。

Docker Compose的解决方案

Docker Compose提供了一种简单的方法来定义和运行多容器Docker应用。通过一个YAML格式的配置文件(docker-compose.yml),开发者可以描述整个应用栈的所有服务,包括它们的配置、依赖关系、网络设置等。使用docker-compose up命令,所有服务可以一次性启动,且按照配置文件中的依赖关系自动连接。这种方式大大简化了多容器应用的开发和管理,提高了开发效率。

注:只能管理单个机器上的应用

Kubernetes (K8s):容器编排的标准

大规模容器管理问题

尽管Docker及其生态系统简化了容器化应用的开发和部署,但在管理大规模容器集群时,仍然面临诸如自动扩展、负载均衡、故障恢复等问题。手动管理这些容器的启动、停止、扩展和恢复变得不现实,尤其是在应用规模扩大到需要管理数百甚至数千个容器时。

Kubernetes的解决方案

Kubernetes是一个开源的容器编排平台,提供了一整套强大的工具和API,用于自动化管理容器化应用的部署、扩展和运维。Kubernetes支持自动负载均衡、服务发现、滚动更新和自我修复等功能。通过Kubernetes,开发者可以定义应用的期望状态(如副本数量、服务暴露方式等),Kubernetes自动确保应用在集群中达到这一状态。它不仅简化了集群管理,还提高了应用的可靠性和可扩展性。

好的,让我们直接介绍Kubernetes中的Node、Pod和Service。

Node

Node 是Kubernetes集群中的一个计算资源单元,可以是物理机器或虚拟机。它是实际运行应用程序的地方。每个Node上运行着一些关键的Kubernetes组件:

- Kubelet: 一个代理,确保容器按照Pod的定义正确运行。

- 容器运行时: 用于运行和管理容器的工具,如Docker或containerd。

- Kube-proxy: 处理网络规则,以便Pod之间以及Pod与外部之间的网络通信。

Node提供了必要的计算、存储和网络资源,使得Pod能够在其上运行。

Pod

Pod 是Kubernetes中的最小可部署单位。一个Pod可以包含一个或多个容器,这些容器共享网络和存储资源。Pod中的容器是作为一个整体来管理的,它们共同运行并协作完成某项任务。Pod有自己的IP地址,并且容器之间可以通过localhost相互通信。Pod是短暂的,通常不会直接被长期持有,它们的生命周期由控制器(如Deployment)来管理。

Service

Service 是Kubernetes中的一种抽象,用于定义一组Pod的逻辑集合,并且定义了如何访问这些Pod。由于Pod的IP地址可能会随着它们的生命周期而变化,Service提供了一个稳定的IP地址和DNS名称,外部或集群内部的客户端可以通过这个固定的地址来访问对应的Pod。Service有多种类型:

- ClusterIP: 默认类型,暴露一个集群内部的IP地址,使得集群内部的应用可以访问。

- NodePort: 暴露一个静态端口,使得外部流量可以通过该端口访问集群中的Service。

- LoadBalancer: 提供外部负载均衡器,通常用于云环境中。

- ExternalName: 通过指定CNAME,将服务名映射到一个外部的DNS名称。

这三者在Kubernetes集群中共同作用:Node提供资源,Pod在Node上运行,而Service为Pod提供稳定的访问方式。

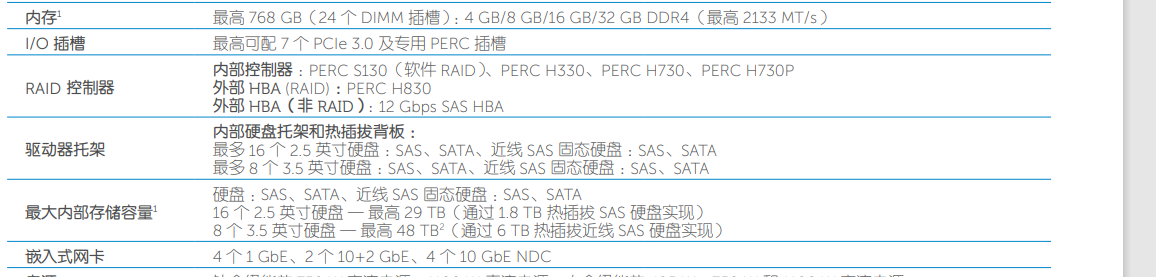

K3s:轻量级Kubernetes的探索

Kubernetes的资源消耗问题

虽然Kubernetes功能强大,但它的资源需求较高,这对于一些资源有限的场景,如边缘计算和IoT设备,可能并不适用。完整的Kubernetes集群需要运行多个组件,如etcd、API server、controller manager等,这些组件会占用较多的内存和CPU资源。

K3s的解决方案

为了解决Kubernetes在资源受限环境中的部署问题,Rancher Labs推出了K3s。K3s是一个轻量级的Kubernetes发行版,它通过移除不必要的组件和精简代码,大大降低了资源消耗。K3s仍然保持了Kubernetes的核心功能,非常适合在资源有限的环境中使用,如边缘设备、嵌入式系统和开发测试环境。K3s的轻量级特性使得更多的小型设备也能享受到Kubernetes的编排和管理能力。

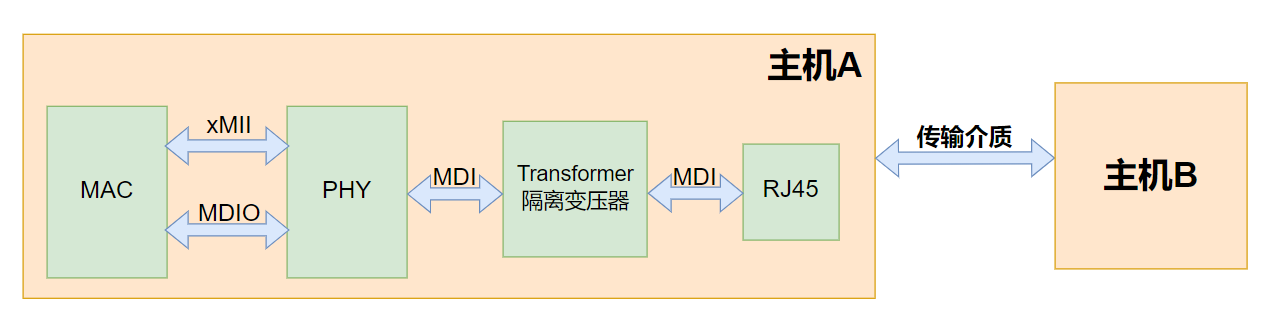

Service Mesh与Sidecar模式:服务间通信的优化

服务间通信的复杂性

在微服务架构中,服务之间的通信变得更加复杂。每个服务可能需要处理多个问题,如负载均衡、服务发现、故障恢复、流量控制和安全策略等。这些功能通常需要在每个服务中手动实现,不仅增加了开发负担,还容易引入错误。

Service Mesh和Sidecar模式的解决方案

Service Mesh是一种用于管理和优化微服务间通信的基础设施层。它通过引入一个代理层,分担了大部分网络通信的责任,使开发者能够专注于业务逻辑。Service Mesh的核心思想是将网络通信功能从应用逻辑中分离出来,并通过Sidecar模式来实现。Sidecar模式指的是在每个服务旁边部署一个独立的代理(Sidecar容器),该代理处理所有进出该服务的网络流量。这样,应用服务本身无需关心网络细节,如负载均衡和安全策略的实现。

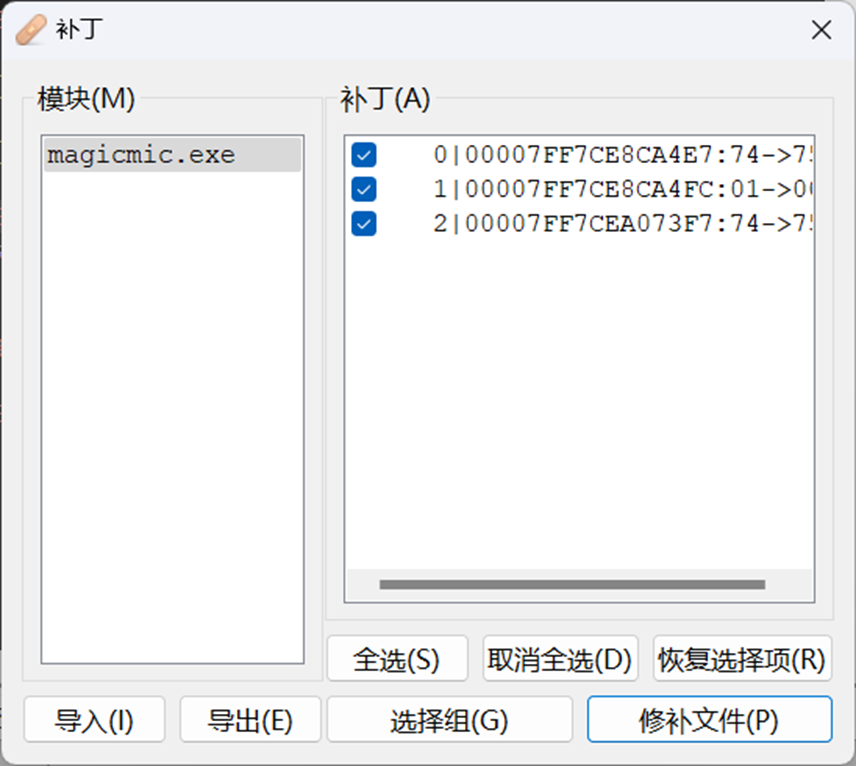

Istio:全面的Service Mesh解决方案

Service Mesh的实现与管理

虽然Service Mesh概念的出现解决了许多服务间通信的问题,但要实现一个功能完善的Service Mesh仍然需要许多复杂的配置和管理。需要有一个强大的工具来帮助开发者配置和管理Service Mesh的各个功能,如流量管理、监控、安全和策略控制。

Istio的全面解决方案

Istio是一个开源的Service Mesh解决方案,它提供了一整套工具和组件,用于管理和控制微服务间的通信。Istio包括了流量管理、安全性、可观测性和策略控制等功能。例如,Istio可以实现智能的流量路由和负载均衡,通过配置可以控制不同版本的服务流量分配比例;它还能提供服务间的加密通信和认证授权,确保数据安全;此外,Istio还支持丰富的可观测性功能,帮助运维人员监控和分析服务性能和健康状况。通过这些功能,Istio大大简化了微服务架构的管理和运维,帮助开发者更专注于业务逻辑的开发。

结论

从Docker到Istio,这些技术共同构成了现代云原生应用的基础设施。它们逐步解决了环境一致性、部署复杂性、容器管理、大规模扩展、服务间通信和安全性等问题。Docker及其生态系统工具提供了基础的容器化支持和管理能力,Kubernetes及其变种如K3s则为大规模容器编排和管理提供了标准化的平台,而Service Mesh及Istio则进一步提升了微服务间通信的管理能力和安全性。这些技术相辅相成,推动了现代软件开发和运维的变革,使得开发者和运维团队能够更加高效地构建、部署和管理复杂的分布式系统。未来,随着这些技术的不断发展,我们可以预见到更加智能和自动化的云原生解决方案的出现。

原文链接:https://mp.weixin.qq.com/s?__biz=MzAxODc4MDAyOA==&mid=2247484203&idx=1&sn=9f797839ed9a4b470f38a41347f4a9a7&chksm=9bd05938aca7d02ed54bbcb8c8f9e240d370cd91c001dd6fbbf2987c43c4b6c8ea02022dd7f0&token=1388829409&lang=zh_CN#rd