Abstract

在自动驾驶领域,对高质量的标注训练数据的需求日益增加。在本文中,我们提出了Panacea,这是一种创新的方法,用于生成驾驶场景中的全景和可控视频,能够生成无限数量的多样化、标注的样本,对于自动驾驶的进步至关重要。Panacea解决了两个关键问题:“一致性”和“可控性”。一致性确保了时间和跨视角的一致性,而可控性确保了生成内容与相应标注的对齐。我们的方法结合了新颖的4D注意力机制和两阶段生成管道来保持一致性,并通过ControlNet框架对鸟瞰图(BEV)布局进行细致控制。Panacea在nuScenes数据集上的广泛定性和定量评估证明了其在生成高质量多视角驾驶场景视频方面的有效性。这项工作显著推动了自动驾驶领域的发展,通过有效增加用于先进BEV感知技术训练的数据集。项目地址:https://panacea-ad.github.io/

全景和可控视频

Introduction

在自动驾驶领域,鸟瞰图(BEV)感知方法引起了极大的兴趣,这些方法在包括3D检测、地图分割和3D车道检测等关键感知任务中表现出显著潜力。以StreamPETR为例的前沿BEV感知方法是在多视角视频上训练的。因此,构建强大的自动驾驶系统的关键在于高质量、大规模的标注视频数据集。然而,获取和标注这些数据面临着巨大的挑战。组装涵盖各种天气、环境和光照条件的多样化视频数据集不仅面临挑战,有时还伴有风险。此外,视频数据的标注需要大量的人力和成本。

受到利用合成街道图像提高感知任务性能成功案例的启发,我们的提议专注于生成合成的多视角驾驶视频数据,以支持前沿的视频感知方法的训练。为了减少高昂的标注成本,我们计划利用BEV布局序列,这些序列包括3D边界框和道路图,用于生成相应的视频。这样的BEV序列可以从标注视频数据集中获得,或者使用先进的模拟器合成。因此,这一倡议可以表述为基于BEV序列生成多样化的多视角驾驶视频。我们生成模型的有效性依赖于两个关键标准:可控性和一致性。通过输入BEV序列和描述性文本提示让用户管理生成的视频定义了可控性,而一致性强调了单一视角视频的时间一致性和多视角的一致性。

Method

预备知识:潜在扩散模型

扩散模型(DMs)通过迭代去噪正态分布的噪声ϵ来近似数据分布p(x)。具体来说,DMs首先通过一个固定的前向扩散过程构建扩散输入xt,如公式1所示。这里αt和σt表示给定的噪声计划,t表示扩散时间步。然后,去噪模型ϵθ被训练来估计从扩散输入xt中添加的噪声ϵ。这是通过最小化一个特定的损失函数来实现的。

潜在扩散模型(LDMs)是扩散模型的一种变体,它在潜在表示空间中运行,而不是在像素空间中运行,从而有效地简化了处理高维数据的挑战。这是通过感知压缩模型将像素空间图像转换为更紧凑的潜在表示来实现的。具体来说,对于图像x,该模型使用编码器E将x映射到潜在空间z = E(x)。然后,这个潜在编码z可以通过解码器D重新构建回原始图像x,即x = D(z)。LDMs的训练和推理过程与传统DMs的过程非常相似,如公式1-3所示,只是将x替换为潜在编码z。

生成高质量的多视角视频

这里我们描述如何升级预训练的图像LDM 以生成高质量的多视角视频。我们的模型利用多视角视频数据集pdata进行训练。每个视频序列包含T帧,表示序列长度,V个不同的视角,高度和宽度的维度分别为H和W。

我们的框架基于Stable Diffusion (SD) 模型,这是一个用于图像合成的强大预训练潜在扩散模型。尽管SD模型在图像生成方面表现出色,但由于缺乏序列中不同视角和帧之间的约束,直接应用于生成一致的多视角视频效果欠佳。因此,我们引入了一种创新架构:基于分解4D注意力的UNet [35],旨在同时生成整个多视角视频序列。联合扩散输入z的结构维度为H × (W × V ) × T × C,其中C表示潜在维度。这个多视角视频序列通过在宽度上连接帧构建,这与它们固有的全景性质对齐。图2(a)展示了所提出模型的整体训练框架。除了所提出的基于4D注意力的UNet,我们还引入了两阶段生成管道,大大提升了生成质量。

分解4D注意力

基于分解4D注意力的UNet旨在实现跨视角和跨帧建模,同时确保计算的可行性。一个朴素的多视角视频生成方法可能采用4D (HWVT) 注意力来全面探索多视角视频表示以生成一致的样本。然而,这种方法需要过多的内存和计算资源,超出了最先进的A100 GPU的能力。因此,我们提出了一种更高效的架构,称为分解4D注意力,借鉴了视频表示学习的最新进展 [1, 2, 24, 56]。我们的模型选择性地保留了最关键的注意力操作:邻近视角之间的注意力和空间对齐的时间补丁之间的注意力。这引入了两个新的注意力模块——跨视角注意力和跨帧注意力——以及现有的视角内空间注意力。在第4.4节的实验证明中,分解4D注意力框架有效生成了一致的多视角视频,同时保持了网络的可行性和效率。

图2(b)详细介绍了我们的分解4D注意力机制。视角内注意力保留了Stable Diffusion (SD)模型中原始空间自注意力的设计,如公式4所示。为了增强跨视角一致性,我们引入了跨视角注意力。我们的观察表明,邻近视角之间的相关性最为重要,而非邻近视角之间的相关性相对不那么重要,可以忽略不计。跨视角注意力的公式如公式5所示。跨帧注意力借鉴了VLDM [3]的设计,专注于空间对齐的时间补丁。这一组件在赋予模型时间意识方面至关重要,这是生成时间一致视频的关键因素。

生成可控的驾驶场景视频

在我们的Panacea模型中,旨在推动自动驾驶系统的进步,合成样本的可控性成为一个关键属性。Panacea集成了两类控制信号:粗粒度的全局控制,包括文本属性,以及细粒度的布局控制,即BEV布局序列。

粗粒度的全局控制使Panacea模型能够生成多样化的多视角视频。这是通过将CLIP编码的[32]全景和可控视频文本提示集成到UNet中实现的,这种方法类似于Stable Diffusion中使用的方法。得益于Stable Diffusion的预训练模型,Panacea可以响应文本提示合成特定的驾驶场景,如图1(c)所示。

Experiment

定性分析

时间和视图一致性

如图1(a-b)所示,Panacea显示了直接从BEV序列和文本提示生成逼真多视角视频的能力。生成的视频展示了显著的时间和跨视图一致性。例如,如图1(a)所示,前视图中的汽车在接近时保持其外观。同样,不同视图中的内容是一致的,新生成的帧与条件帧无缝对齐(见图1(b))。

属性和布局控制

图1(c)展示了属性控制功能,通过修改文本提示可以操控天气、时间和场景等元素。这使得我们的方法能够模拟各种罕见的驾驶场景,包括雨雪等极端天气,从而大大增强了数据集的多样性。此外,图5展示了汽车和道路如何精确对齐BEV布局,同时保持出色的时间和视图一致性。

我们采用了StreamPETR,这是一种最先进的视频感知方法,作为我们的主要评估工具。对于基于图像的生成方法评估,我们使用了StreamPETR-S,这是StreamPETR的单帧变体。

实现细节

我们基于Stable Diffusion 2.1 [34] 实现了我们的方法。预训练权重用于初始化UNet中的空间层。在我们的两阶段训练过程中,第一阶段的图像权重经过56k步优化,第二阶段的视频权重经过40k步优化。在推理过程中,我们使用配置了25个采样步长的DDIM [38] 采样器。视频样本的生成空间分辨率为256 × 512,帧长为8。相应地,我们的评估模型StreamPETR基于ResNet50[10]骨干网络,在相同的256 × 512分辨率下训练。更多细节可以在补充材料中找到。

定量分析

生成质量

为了验证我们生成结果的高保真度,我们将我们的方法与各种最先进的驾驶场景生成方法进行了比较。为了公平起见,我们在不使用任何后处理策略选择样本的情况下生成了整个验证集。表1中展示了我们的方法Panacea表现出显著优越的生成质量,获得了FVD 139和FID 16.96。这些指标明显超过了所有对比方法,包括视频生成方法如DriveDreamer和图像生成方法如BEVGen和BEVControl。

自动驾驶的可控性

我们的方法的可控性基于使用StreamPETR [45]获得的感知性能指标进行定量评估。我们首先生成了整个nuSences验证集的Panacea样本。然后,使用预训练的StreamPETR模型得出感知性能。相对于真实数据的感知分数的相对性能指标,作为生成样本与条件BEV序列一致性的指标。如表2所示,Panacea达到了68%的相对性能,表明生成样本的一致性很强。此外,我们的方法的第一阶段结果达到了72%的相对性能。除了验证集的评估外,Panacea更重要的特点是能够生成无限数量的注释训练样本。借此,我们为nuScenes合成了一个新训练数据集,命名为Gen-nuScenes,作为StreamPETR模型的辅助训练资源。有趣的是,仅在Gen-nuScenes上训练的StreamPETR模型获得了36.1%的nuScenes检测评分(NDS),相当于与实际nuScenes训练集相比达到77%的相对性能,如表3所示。更重要的是,将生成的数据与真实数据结合使用,将StreamPETR模型的NDS提升到49.2,比仅在真实数据上训练的模型高出2.3点。此外,图4展示了Gen-nuScenes在各种真实数据比例下持续提升StreamPETR的性能。这些结果共同证明我们的Panacea模型在生成可控多视角视频样本方面非常出色,构成了自动驾驶系统的宝贵资产。

消融研究

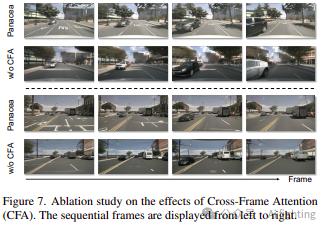

分解4D注意力

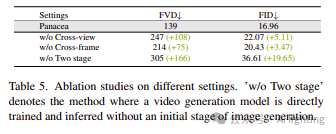

我们首先调查了分解4D注意力中跨视图注意力机制的影响。如表5所示,排除跨视图模块会导致FVD和FID分别下降108和5.11,这表明跨视图模块在提高视频质量方面的关键作用。此外,为了更精确地评估视图一致性,我们评估了VMS指标。引入跨视图模块使得VMS指标提升了0.8分,证实了其在改善多视图一致性方面的有效性,如图6右侧所展示的那样。跨视图模块的有效性也在图6左侧得到了说明。没有跨视图模块的情况下,不同视图中汽车的外观是不一致的。相反,结合跨视图模块后,汽车和场景在视图之间的一致性显著提高。

为了评估时间注意力,我们进行了消融研究,通过移除该组件。如表5所示,移除时间模块会导致FVD下降75分,突显其在保持时间一致性方面的关键作用。此外,图7简明展示了没有跨帧注意力模块的情况下,模型无法保持时间一致性,如汽车外观在帧间的变化所示。

两阶段管道

为了确认我们两阶段管道提升了生成质量,我们与单阶段方案进行了比较。单阶段方法产生的FID为36.61,FVD为305,明显低于Panacea的结果。这一比较明确强调了两阶段管道在显著提升生成视频质量方面的关键影响。

总结:

本文的主要贡献:

引入了Panacea,这是一种用于驾驶场景的多视角视频生成的创新方法。该两阶段框架无缝整合了现有的视觉生成技术,同时在实现多视角和时间一致性以及关键的可控性方面进行了重要的技术改进。这些技术改进在解决方案的成功中起着重要作用。

通过全面的定性和定量评估,Panacea展示了其在生成高质量驾驶场景视频方面的熟练程度。特别重要的是,定量证据表明我们的合成视频实例显著增强了前沿BEV感知模型。我们计划将这些合成实例作为“GennuScenes”数据集发布,旨在促进视频生成领域的进一步研究。

引用CVPR2024文章:

Panacea: Panoramic and Controllable Video Generation forAutonomous Driving

关注我的公众号auto_driver_ai(Ai fighting), 第一时间获取更新内容。