基本信息

博客贡献人

谷雨

作者

Ming Jin, Qingsong Wen, et al.

标签

大语言模型、预训练基础模型、大模型、时间序列、时空数据、时态数据

摘要

时态数据,包括时间序列和时空数据,在现实世界的应用中极为广泛。这些数据类型记录了动态系统随时间变化的测量值,通常由物理和虚拟传感器产生。对这些数据进行深入分析至关重要,因为它们蕴含着丰富的信息,能够为多种下游任务提供支持。近年来,大语言模型和其他基础模型的快速发展,极大地推动了这些模型在时间序列和时空数据挖掘中的应用。这些方法不仅提升了跨领域模式识别和推理的能力,也为构建能够理解和处理时间数据的通用人工智能奠定了基础。在本研究中,我们对专门为时间序列和时空数据定制或改编的大模型进行了全面的回顾,覆盖了四个关键方面:数据类型、模型类别、模型应用范围和应用领域/任务。我们的目标是为从业者提供必要的知识,以便在这一新兴领域开发应用程序并进行进一步研究。我们将现有文献主要分为两大类:针对时间序列分析的大模型(LM4TS)和时空数据挖掘的大模型(LM4STD)。在这一基础上,我们根据模型的应用范围(通用或特定领域)和应用领域/任务对研究进行了进一步的分类。此外,我们还提供了一系列全面的资源,包括数据集、模型资产和实用工具,这些资源都按照主流应用进行了分类。本次调查汇总了以大模型为中心的时间序列和时空数据研究的最新进展,突出了坚实的理论基础、当前的研究进展、实际应用案例、丰富的资源以及未来的研究方向和机会。

1 介绍

大语言模型(LLM)和预训练基础模型(PFM)在自然语言处理(NLP)、计算机视觉(CV)以及众多跨学科领域中取得了显著的成功。这些模型最初被设计用于处理各种自然语言任务,例如文本分类、问答和机器翻译。然而,它们从大规模文本语料库中学习到的复杂语义和知识表示能力,已经极大地激发了研究社区的兴趣。例如,GPT-3模型拥有1750亿个参数,展现出了前所未有的少样本学习和零样本学习能力,这是其前身GPT-2所不具备的。另一个例子是PaLM模型,它拥有更多的参数,并在语言理解、一般推理乃至代码相关任务中表现出色。LLM的迅速崛起不仅推动了PFM的发展,也重新定义了深度神经网络、自监督学习和迁移学习的研究格局。视觉语言模型(VLMs)的出现,就是这一趋势的突出例子,它们能够对视觉和文本数据进行推理,并在图像分类、视觉问答和常识推理等任务中取得了有希望的结果。此外,大模型的影响力已经扩展到音频和语音分析等其他领域,涵盖了广泛的模态和任务。鉴于大模型在这些领域的显著成就,一个自然的问题是:它们是否能够有效地应用于分析时间序列和时空数据?

时间数据主要由时间序列和时空数据组成,它们在地球科学、交通、能源、医疗保健、环境和金融等多个实际应用领域中都扮演着不可或缺的角色。这些数据类型本质上都是时间性的,并且可以来自各种平台,如传感器、金融市场交易、云监控等。将这两个紧密联系的数据类别结合起来进行研究,有助于我们全面理解它们在不同系统中所封装的内在动态。尽管大模型在各个领域都取得了重大进展,但时间序列和时空分析领域的发展却相对落后。传统的分析方法主要依赖于统计模型,而深度学习的出现则激发了研究界探索基于递归神经网络(RNN)、卷积神经网络(CNN)、图神经网络(GNN)和Transformers的更强大的数据驱动模型。尽管这些模型在特定任务上表现出色,但它们在规模上相对较小,缺乏从大规模数据中获取全面语义和知识表示的能力。最近的研究越来越关注自我监督的预训练和迁移学习,这些方法已经取得了有希望的结果,并提高了人们的期望。

在时间序列和时空数据的大模型开发方面,尽管取得了一些进展,但缺乏大规模数据集仍然是一个重大障碍。尽管如此,我们还是看到了在不同任务和领域中成功尝试的数量急剧增加(表2),这证明了大模型在时间数据分析中的潜力。例如,在数据丰富的领域,一些预训练基础模型(PFM)如盘古天气和ClimaX已经彻底改变了全球气候建模,提供了前所未有的准确性和计算效率。在城市计算领域,TFM致力于交通基础模型的开发。Valley、LAVILA和mPLUG-2等基础模型则在时空视频理解方面有着广泛的应用。在时间序列数据有限的情况下,Vocie2Series提出了一种直接对现有基础模型进行重新编程的方法,以进行时间序列分类。PromptCast和OFA则是利用LLM进行一般时间序列分析的早期尝试。最近的一项工作Time LLM通过重新编程时间序列和整合自然语言提示,释放了现成LLM的全部潜力。其他显著的贡献包括NYUTron和GatorTron,这两个大临床语言模型在医疗事件预测方面显示出有希望的结果。尽管取得了这些重大进展,但将大模型整合到时间序列和时空数据分析中仍然面临着独特的挑战(详见第7节),需要进行重点调查。

表2 为时间序列和时空数据建模量身定制的语言和相关预训练基础模型(即 LLM 和 PFM)的摘要。对于不局限于特定域和任务的通用方法,第四列标记为“-”。

在本文中,我们通过统一、全面和最新的审查,满足了对时间序列和时空数据分析的大模型进行深入研究的需求。我们的审查涵盖了不同数据类别、模型范围、应用领域和代表性任务的LLM和PFM。通过将时间序列和时空数据的分析方法结合起来,我们不仅能够让从业者探索这两个领域之间的协同作用和共性,还能促进思想的交叉传播,从而产生利用一个领域的优势来应对另一个领域挑战的创新方法,并促进对时间数据大模型的更全面和相互关联的理解。我们的贡献总结如下:

-

首次全面且最新的调研:据我们所知,这是首次对大模型在时间序列和时空数据分析领域的最新进展进行全面回顾的论文。我们提供了一个详尽且更新的概述,不仅覆盖了该领域的广泛性,还深入探讨了各种方法的细节,使读者能够全面而深入地理解这一主题。

-

统一且结构化的分类系统:我们提出了一种统一且结构化的分类方法,将现有研究归纳为两大主要类别:时间序列的大模型(LM4TS)和时空数据的大模型(LM4STD),并按照数据类型进行组织。在每个类别中,我们进一步根据模型类型细分为LLMs和PFMs两个子组。随后,我们根据模型的应用范围、领域以及特定任务进行了更细致的分类。这种多维度的分类方法为读者提供了一个清晰的框架,以便从不同角度理解这一领域。

-

丰富的资源汇总:我们汇集并总结了该领域的众多资源,包括数据集、开源实现和评估基准。此外,我们还概述了相关大模型在不同领域的实际应用案例。这一汇编为未来的研究和开发提供了宝贵的参考和出发点。

-

未来研究方向的展望:我们识别并讨论了未来研究的多种有前景的方向,涵盖了数据来源、模型架构、训练和推理范式等多个视角,以及其他潜在的机遇。这一讨论不仅让读者对当前领域有了细致的了解,也突出了未来研究的可能路径。

相关调查和差异。尽管已有几项从不同视角对时间序列和时空数据建模的广泛研究,但至今尚无研究集中探讨这些领域内大模型的兴起和应用。例如,Zhang等人和Deldari等人主要集中于时间序列中自我监督学习的最新进展。而像G. Jin、M. Jin等人的研究则在时间序列和时空数据的背景下对图神经网络(GNNs)进行了全面的回顾。最近,Ma等人提出了一项专注于时间序列中预训练和迁移学习的调查,这与我们的研究密切相关。然而,他们的研究并未特别关注大模型,同时也没有涵盖时空数据。鉴于大模型的快速发展,目前有大量文献阐明了大语言模型(LLMs)、和预训练基础模型(PFMs)的基本原则和开创性工作。但在这些作品中,明显缺少对大模型在处理时间序列和时空数据等时态数据方面的潜力的讨论。与视觉、音频和地球科学等领域大模型的显著增长相一致,我们的目标是在本文中对为时间序列和时空数据分析量身定制的大模型进行全面且最新的综述。我们的目的不仅是记录最新的进展,而且还要关注可用资源、实际应用和未来的研究方向。表1概括了我们的调查与其他类似评论之间的区别。

表1 本调查与其他相关调查之间的比较,重点关注领域(即特定与一般)、相关模式(例如,时间序列、时空图(STG)、时间知识图(TKGs)和视频)以及主要关注领域(即小规模预训练和微调(P&F)、大语言模型(LLMs)和预训练基础模型(PFMs)

论文结构。本文的其余部分安排如下:在第2节中,我们为读者提供了关于大模型、时间序列以及时空数据的基础知识,同时介绍了这些领域的相关任务。第3节则从宏观角度介绍了我们在时间序列和时空数据分析背景下对大模型的统一分类方法,为读者提供了一个全面的概述,为后续深入探讨具体方法奠定基础。第4节和第5节则详细阐述了这些方法的复杂性和细节。第6节总结了我们整理的与时间序列和时空数据分析的大模型相关的广泛资源和实际应用案例。第7节探讨了该领域未来研究的多种有前景的方向。最终,我们在第8节中对本文进行了总结。

2 背景

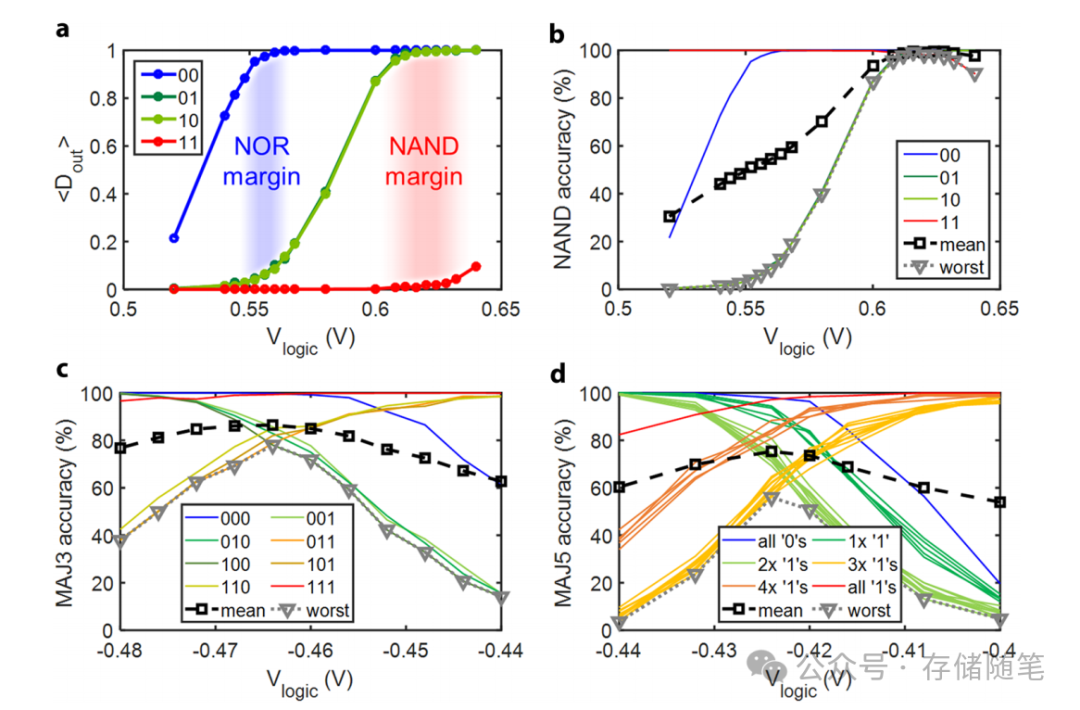

本文的核心在于回顾近年来大模型在解决时间序列和时空数据任务方面的最新进展。我们特别关注了两大类主流的大模型:大语言模型(LLMs)和预训练基础模型(PFMs)。在本节中,我们首先对这两种模型进行了介绍,并探讨了它们之间的差异与联系。为了帮助读者更直观地理解,我们在图2中提供了一个大模型发展的简要路线图,这不仅概述了它们的历史轨迹,还突出了主要的研究焦点。随后,我们对时间序列和时空数据进行了定义,并讨论了它们在各个领域的典型应用和任务。

图2 具有代表性的大语言模型路线图(左)和其他基础模型(右)

2.1 大语言模型

语言建模是许多自然语言处理任务的基石,而大语言模型(LLMs)最初是为了提升语言建模的性能而设计的。与传统的神经语言模型(NLMs)和小型预训练语言模型(PLMs)相比,LLMs以其强大的上下文学习能力而著称,能够解决复杂的任务,并且已经改变了我们使用人工智能的方式。近年来,随着多模态大语言模型(MLLMs)的发展,LLMs的应用范围已经远远超出了传统的自然语言处理任务,这些任务对于较小的PLMs来说往往难以处理。根据LLMs在时间序列和时空数据建模方面的应用,我们可以将它们分为两大类:嵌入可见的LLMs和嵌入不可见的LLMs。前者通常是开源的,允许访问其内部状态,例如Bloom、CamemBERT、Alpaca、Llama和Falcon等模型。这些模型通常可以针对不同的目标任务进行微调,展现出了在少样本和零样本学习场景下的潜力,而无需进行额外的重新训练。后者,如PaLM、ChatGPT1和GPT-4,通常是闭源的,不提供公开的内部状态,它们通常通过API调用中的提示来进行推理。这些模型对于特定的任务和应用场景非常有用,但可能需要更多的定制化开发。LLMs的发展简史和分类在图2的左侧部分有所展示,提供了对这些模型演进和当前状态的直观理解。

在见证了多模态大语言模型(MLLMs)的巨大成功后,我们的主要兴趣之一是探索如何将大语言模型(LLMs)应用于解决时间序列和时空数据分析的任务。这通常可以通过两种主要方法实现:多模态重构(multimodal repurposing)和基于API的提示(API-based prompting)。多模态重构方法通常涉及将目标任务与预训练(源)任务中的不同模态对齐,以激活嵌入可见LLM的任务相关能力。这种方法与LLM的微调技术(例如适配器调谐和低秩自适应)以及模型重编程密切相关,具体取决于LLM在适应过程中是进行微调还是保持冻结状态。这种方法允许LLM更深入地理解和处理特定的任务需求。另一方面,基于API的提示方法则更为直接。它将目标模态转化为自然语言提示,并输入LLM进行生成推理。这种方法类似于语言模型即服务(LMaaS)的黑盒调优,简化了模型的使用过程,使其更易于集成到不同的应用中。有证据表明,这两种方法都具有适用性,并在不同领域的各种目标任务中显示出有希望的结果。这包括对时间序列和时空数据的学习,它们在金融预测、交通分析、环境监测等多个领域都展现出了显著的潜力。通过这些方法,LLMs能够更有效地处理复杂的时间依赖性和空间关系,为相关领域的研究和应用提供了新的可能性。

2.2 预训练基础模型

预训练基础模型(PFM)指的是那些经过大规模预训练,能够适应并解决各种下游任务的模型。虽然大语言模型(LLM)和多模态大语言模型(MLLM)本质上也属于PFM的范畴,但它们更常被用于处理与自然语言相关的任务。PFM代表了一类更广泛的模型,它们不仅具有强大的涌现能力(emergent capabilities),还具有同质化(homogenization)的特点,这使得它们能够有效地应对各种不同的任务。这种能力与那些专为特定任务设计的模型有很大的不同。PFM的能力主要体现在以下三个关键维度:

模态桥接:PFM能够整合和处理多种类型的数据模态,如文本、图像、声音等,从而在不同模态之间建立联系。

推理和规划:PFM具备复杂的推理和规划能力,能够理解和预测复杂的事件序列,进行决策和规划。

互动:PFM还能够与环境或其他系统进行有效的互动,这在需要实时响应和交互的应用中尤为重要。

这些特性使得PFM在构建全面的人工智能系统中扮演着关键角色,它们能够跨越单一任务的限制,提供更为灵活和广泛的应用潜力。

第一个方面涉及多模态模型,例如多模态大语言模型(MLLMs),它们在统一不同模态的语言和视觉方面取得了显著的成果。例如,CLIP最初旨在连接图像和文本,而SAM则将文本提示的概念扩展到视觉提示。最近,像NExT-GPT这样的研究进一步拓宽了这一领域的边界,甚至允许多种不同模态的整合。可以预见的是,现实世界中的数据往往是多模态的。例如,在临床医学中,时间序列和时空数据常常涉及心电图(ECG)数据和医疗事件。这种多模态特性激发了近年来对多模态时间序列和时空数据研究的兴趣。图2(右)提供了预训练基础模型(PFMs)的简要发展路线图,其中视觉语言模型(VLMs)仍然是该领域最热门的研究主题。然而,其他与时间序列和时空数据相关的PFMs也在逐渐涌现,尽管它们大多仍处于发展的早期阶段。这种多模态的整合不仅在理论上具有重要意义,而且在实际应用中也显示出巨大的潜力,特别是在需要处理复杂数据和进行跨领域推理的场景中。随着技术的进步,我们可以期待未来会有更多创新的多模态模型出现,进一步推动人工智能的发展。

第二个方面强调了预训练基础模型(PFMs)在推理和规划方面的能力,其中LLMs中的CoT(Chain of Thought)、ToT(Thought of Thought)和GoT(Generative Thought)是典型的例子。此外,任务规划代理也是展现PFMs推理和规划能力的重要实例。最后一个方面则是PFMs的交互能力,包括操作和通信。在本次调查中,我们主要聚焦于应用于时间序列和时空数据的PFMs,这些模型大多仍处于发展的早期阶段,尚未完全实现上述第二和第三方面的高级能力。我们建议读者参考相关文献,以获取关于PFMs更深入的信息。

2.3 时间序列和时空数据

时间数据,包括时间序列和时空数据,构成了无数现实世界应用程序的核心数据类型。时间序列指的是按照时间顺序排列的数据点序列,它们可以是单变量的,也可以是多变量的。例如,一个城市每天的温度记录构成一个单变量时间序列;而如果同时记录了每天的温度和湿度,则形成了一个多变量时间序列。

在本研究中,我们将使用特定的数学符号来表示不同类型的数据结构。粗体大写字母(例如 )用于表示矩阵,粗体小写字母(例如 x)用于表示向量,书法大写字母(例如书写体

)用于表示集合,而标准小写字母(例如

)用于表示标量。形式上,我们遵循之前概述的时间序列数据的定义,并将在后续内容中进行总结。

定义1(时间序列数据)。单变量时间序列![]() 是一个按时间顺序索引的

是一个按时间顺序索引的 个数据点序列,其中

![]() 是时间序列在时间点 t 的值。多变量时间序列

是时间序列在时间点 t 的值。多变量时间序列![]() 是一个按时间顺序索引的

是一个按时间顺序索引的 个数据点序列,但具有

个维度,其中

![]() 表示时间点 t 沿

表示时间点 t 沿 个通道的时间序列的值。

时空数据,另一方面,是由时间和空间两个维度组织的数据点序列,它包括了各种结构,例如时空图(STGs)、时序知识图(TKGs)、视频、点云流(PCS)、轨迹等。在本研究中,我们主要关注前三个类别,这些类别具有很高的代表性,并且与当前的研究兴趣紧密相关。形式上,我们遵循文献和中STGs和TKGs的定义,并总结如下。

定义2(时空图)。时空图 ![]() 是一个按时间顺序索引的

是一个按时间顺序索引的 个静态图快照的序列,其中

![]()

![]() 表示在时间 t 的快照;

表示在时间 t 的快照;![]() 和

和 ![]() 分别是在时间 𝑡t 的节点和边的集合。相应的邻接矩阵和节点特征矩阵定义为

分别是在时间 𝑡t 的节点和边的集合。相应的邻接矩阵和节点特征矩阵定义为 ![]() 和

和 ![]() ,其中

,其中![]() 且如果节点 𝑖 和 𝑗 之间存在边,即

且如果节点 𝑖 和 𝑗 之间存在边,即 ![]() ,则

,则 ![]() 。这里,

。这里,![]() 是节点的数量,𝐷D 是节点特征的维度。

是节点的数量,𝐷D 是节点特征的维度。

定义3(时序知识图)。时序知识图 ![]() 是一个按时间顺序索引的 𝑇 个静态知识图快照的序列,其中

是一个按时间顺序索引的 𝑇 个静态知识图快照的序列,其中 ![]() 是由在时间 𝑡 的实体和关系集合组成的快照。具体来说,

是由在时间 𝑡 的实体和关系集合组成的快照。具体来说,![]() 封装了主语和宾语实体,

封装了主语和宾语实体,![]() 表示它们之间的关系集合。在时序知识图中,实体和关系可能具有不同的特征,由

表示它们之间的关系集合。在时序知识图中,实体和关系可能具有不同的特征,由 ![]() 和

和 ![]() 表示,其中

表示,其中 和

是特征的维度。

视频数据也可以解释为一种时空数据,时空数据通常被定义为按时间顺序索引的图像序列;因此,我们以类似的方式将其定义如下。

定义4(视频数据)。设![]() 是一个由按时间顺序索引的

是一个由按时间顺序索引的帧组成的视频,其中

表示第 t 帧。为简单起见,我们假设每个帧

是一个像素矩阵,即

![]() ,而不考虑其他元数据,其中 H、W 和 C 分别是帧的高度、宽度和颜色通道数。

,而不考虑其他元数据,其中 H、W 和 C 分别是帧的高度、宽度和颜色通道数。

根据上述定义,我们接下来将简要介绍与每个数据类别相关的代表性任务,这些任务在图1中展示,并在下文中进行总结。

图1 大模型(即语言和其他相关的基础模型)可以进行训练,也可以巧妙地重新调整用途,以处理时间序列和时空数据,用于一系列通用任务和专业领域应用程序。

时间序列任务:这一领域通常涵盖四个主要的分析任务:预测、分类、异常检测和归因(imputation)。在预测任务中,目标是预测时间序列的未来值,这个任务可以根据预测的时间范围进一步细分为短期预测和长期预测。在分类任务中,目标是将输入的时间序列分配到不同的类别中。时间序列异常检测可以视为一种特殊的分类任务,其目的是从正常的时间序列中识别出异常的时间序列。插补任务的目标则是填补时间序列中的缺失值。

时空图任务:在时空图中,主要的下游任务是预测,其目的是利用历史属性和结构信息来预测未来的节点特征。典型的例子包括交通流量预测和一些按需服务。其他常见的任务还包括链接预测和节点/图分类,其中链接预测的目标是根据历史信息预测边的存在,而节点/图分类则是将节点或图分配到不同的类别中。

时间知识图谱任务:在时态知识图谱中,有两个重要的任务:完成和预测。完成任务主要旨在填补图中缺失的关系,而预测任务则侧重于预测未来的关系。

视频任务:在计算机视觉领域,视频数据涉及几个核心任务,包括检测、字幕生成、预测和查询。检测任务的目标是识别视频中的特定对象或动作。字幕生成任务旨在为视频内容生成自然语言描述。预测任务涉及预测视频序列中即将发生的帧。最后,查询任务的目标是检索与特定查询相关的视频片段。值得注意的是,这些任务经常涉及多种模态,并且与前面提到的数据类型相比,这些任务受到了相当大的关注。

3 概述和分类

在本节中,我们将提供对应用于时间序列和时空数据的大模型的概述和分类。我们的调查围绕四个主要维度进行组织:数据类别、模型架构、模型应用范围以及应用领域或任务。相关工作的详细概要可以在图3和表2中找到。主要地,我们将现有文献分为两大类:针对时间序列数据的大模型(LM4TS)和针对时空数据的大模型(LM4STD)。

图3 从方法论(即 LLM 与 PFM)、动机(例如,一般目的与特定领域目的)和应用的角度对时间序列和时空数据的大模型进行综合分类。

在第一类中,我们将现有文献细分为两种类型:用于时间序列数据的大语言模型(LLM4TS)和用于时间序列数据的预训练基础模型(PFM4TS)。LLM4TS指的是利用大语言模型来解决时间序列任务,不论这些模型在适应过程中是经过微调还是保持冻结状态。而PFM4TS则侧重于开发专门针对各种时间序列任务而设计的基础模型。值得注意的是,PFM4TS领域目前还处于相对初期阶段;现有的模型可能未能完全实现第2.2节中定义的通用PFM的全部潜力。尽管如此,它们为该领域的未来发展提供了宝贵的洞见。因此,我们也将这些模型纳入本次调查,并将其归类为PFM4TS。对于这些细分类别中的每一个,我们进一步根据模型设计目的的通用性或特定性将它们分类为通用模型或特定于领域的模型。这取决于模型是为解决广泛的时间序列分析任务而设计,还是仅限于特定领域内的应用,如交通、金融和医疗保健等。

在 针对时空数据的大模型(LM4STD)类别中,我们采用了与时间序列数据相似的分类方法,定义了用于时空数据的大语言模型(LLM4STD)和用于时空数据的预训练基础模型(PFM4STD)。与时间序列数据不同,时空数据涵盖了更广泛的实体数组,跨越多个领域;因此,我们根据它们相关的领域明确地对LLM4STD和PFM4STD进行分类。虽然我们在表2中提供了基于模型应用范围的分类以便于理解现有文献,但这种分类也考虑到了不同的数据模式(例如,时空图STG和视频),因为它们通常具有不同的问题定义。为了保持简洁,在图3中省略了基于不同数据模式的分类。在这里,我们特别关注三个最突出的领域/模态,并将它们作为子类别:时空图、时空知识图和视频数据。对于每一个子类别,我们将代表性任务总结为图3中的叶节点,这与LM4TS的处理方式类似。值得注意的是,PFM4STD相比其时间序列的对应物经历了更广泛的发展。目前的研究主要集中在STG和视频数据上,通常具有增强的PFM功能,例如多模态桥接和推理。

具备了对数据类别、模型架构、模型应用范围和应用领域/任务的基础知识后,我们将在后续部分(分别标记为第4节和第5节)中深入研究LM4TS和LM4STD的细节。在这些部分中,我们将回顾第4.1节和第4.2节中概述的LLM4TS和PFM4TS中的关键贡献。同样,在第5.1节中,我们将总结与时空图的LLM和PFM相关的关键研究,而在第5.2节和第5.3节中,我们将概述有关时空知识图和视频数据的LLM和PFM的相关文献。

4 时间序列数据的大模型

在本节中,我们将深入探讨大语言模型(LLMs)和预训练基础模型(PFMs)在时间序列分析中的应用和发展。我们将根据模型的通用性或特定领域应用进一步细分讨论,如图3所示。

4.1 时间序列中的大语言模型

时间序列分析是众多实际应用中的核心问题,它在零售销售预测、经济时间序列的缺失数据插补、工业维护中的异常检测,以及多个领域的时间序列分类等方面发挥着关键作用。随着自然语言处理(NLP)领域中大语言模型(LLMs)的迅猛发展,我们对探索这些模型在时间序列分析中的潜在应用表现出浓厚的兴趣。我们好奇是否能够将这些在NLP中表现出色的模型适配并应用于时间序列的分析任务。在本小节中,我们将从两个维度探讨LLM4TS的进展:通用模型和特定领域模型。

4.1.1 通用模型

作为从LLM视角进行一般时间序列预测的首批尝试之一,PromptCast正式引入了一个新任务:基于提示的时间序列预测。由于输入和输出都是自然语言句子,PromptCast为时间序列预测提供了一种新颖的“无代码”解决方案,它可以提供一个新的视角,而不是纯粹专注于设计复杂的架构。在新引入的任务的指令数据集 (PISA) 发布之后。另一项类似的研究是LLMTime,该研究表明LLM是有效的零样本时间序列学习器,在时间序列数据上具有正确配置的标记化。作为一项并发工作,为了应对缺乏大规模训练数据的挑战,T. Zhou提出了一个基于部分冻结的LLMs的统一框架,即仅对嵌入层和归一化层进行微调,同时保持自注意力层和前馈层的冻结,以在所有主要类型的时间序列分析任务中实现最先进或可比的性能。 包括时间序列分类、短期/长期预测、插补、异常检测、少样本和零样本预测。类似的工作是TEMPO,它只关注时间序列预测,但结合了额外的细粒度设计,如时间序列分解和软提示。C. Chang利用LLMs进行时间序列预测,过程分为两个阶段:首先使用监督微调引导LLM访问时间序列数据,然后转向面向时间序列预测的下游微调。C. Sun通过一种新的嵌入方法激活 LLM 的时间序列能力,该方法通过实例、特征和文本原型对齐的对比来标记和编码数据,然后创建提示以传递给 LLM 以执行任务。与上述方法不同的是,该文提出了一项近期的工作Time-LLM,利用源数据模态和基于自然语言的提示对时间序列进行重编程,以释放LLMs作为有效时间序列机的潜力,在各种预测场景中都取得了最先进的性能,并且在少样本和零样本设置中都表现出色。Time-LLM 也是轻量级和高效的,因为它既不直接编辑输入时间序列,也不微调主干 LLM。

4.1.2 特定领域模型

运输领域:在智能交通系统(ITS)中,时间序列预测扮演着至关重要的角色。例如AuxMobLCast管道,该方法利用大语言模型(LLM)进行交通数据挖掘,特别适用于人员流动预测等任务。AuxMobLCast的核心思想是将人类活动数据转换成自然语言句子的形式,这样在微调阶段,可以有效地利用预训练的LLM来预测人类活动模式。这项工作是首次尝试将现有的LLM进行微调,以适应交通领域的预测任务。

金融领域:近期出现了几篇专注于金融领域的大语言模型(LLM)的研究。这些研究介绍了一种简单而有效的指令调优方法,用于金融领域的情感分析。通过这种方法,原本基于分类的情感分析数据集被转化为生成任务,使LLM能够更有效地利用其广泛的训练和卓越的分析能力。除了NLP任务,LLM在金融时间序列预测方面也显示出巨大潜力。例如,使用GPT-4进行的零样本或少样本推理实验,以及使用Llama进行的基于指令的微调,都旨在生成可解释的预测。尽管与GPT-4相比,Llama的性能可能略逊一筹,但仍然取得了合理的结果。同时,也有并发工作采用类似方法,基于文本数据来预测股票价格的变动。

事件预测领域:事件预测处理的是具有不规则时间戳的异步时间序列,这与具有等间隔采样的同步时间序列数据不同。这类事件序列在金融、在线购物、社交网络等现实世界领域中扮演着关键角色。时序点过程(TPP)已成为建模此类数据的标准方法。事件预测的目标是预测未来事件的时间和类型,基于已有的过去事件。例如,在在线购物领域,我们可能希望对带有时间戳的用户访问序列进行建模,并预测他们未来的购物行为。在这方面,大语言模型(LLM)可能非常有用,因为事件序列常常伴随着丰富的文本信息,而处理文本正是LLM的强项。《Language models can improve event prediction by few-shot abductive reasoning》中提出了一个建模框架,其中LLM执行演绎推理以辅助事件序列模型。在这个框架中,事件模型预测未来事件,而LLM则在专家注释的提示下为每个预测提出可能的原因。此外,搜索模块会找出与这些原因匹配的先前事件,评分函数则学习验证检索到的事件是否真的会导致所提出的预测。类似地,《Where would i go next large language models as human mobility predictors》中探讨了基于LLM的人类流动性预测。而文献《Drafting event schemas using language models》中则研究了LLM在自然语言中生成连贯、多样的事件序列的能力,这些序列与人类策划的事件在多个感兴趣领域中有大量重叠。这项研究旨在为未来的工作奠定基础,探索如何将显式知识(如模式)与LLM结合使用,以提高事件预测的准确性。

医疗领域:医疗领域是事件序列分析中最重要和最具应用价值的领域之一。通过预测临床事件,即患者按时间顺序记录的医院就诊及其症状,临床模型能够辅助医生和管理人员在日常工作中做出决策。然而,现有的基于结构化数据的临床模型由于数据处理复杂、模型开发和部署难度大而受限。为了解决这些问题,从头开始开发的临床大语言模型——GatorTron——使用了来自非结构化电子健康记录(EHR)的900多亿字文本。GatorTron模型将临床LLM扩展到89亿个参数,并在五项临床自然语言处理(NLP)任务中取得了改进。与此同时,基于纽约大学Langone EHR训练的临床LLM(NYUTron)也在广泛的临床和操作预测任务中进行了微调。与传统模型相比,NYUTron展现出显著的改进,显示了在医学中应用临床LLM的潜力,它们可以辅助医生阅读病历并在护理点提供指导。此外,通过少样本提示调整,LLM已被系统地证明能够处理来自可穿戴和临床级传感设备的数值时间序列数据,显著提高了零样本推理和健康任务的监督基线。在临床实践中,心电图(ECG)是一种常用的非侵入性、方便的医疗监测工具,有助于心脏病的诊断。为了应对注释数据有限的挑战,研究者们利用LLMs自动生成的临床报告来指导ECG的自我监督预训练框架。这种方法为心电图的自动分析和诊断提供了新的途径。

4.2 时间序列中的预训练基础模型

除了应用大语言模型(LLM)进行时间序列分析,时间序列的预训练及其相关基础模型的开发同样具有巨大潜力。这些模型通过识别跨不同领域和任务的通用时间序列模式,提供了一种强大的工具。在本小节中,我们将探讨预训练基础模型(PFM4TS),并区分出与第4.1节讨论的通用模型和特定于领域的模型。

4.2.1 通用模型

自2021年以来,已经提出了许多预训练基础模型,它们大多设计为通用型。Voice2Series便是其中之一,它创新性地利用了预训练的语音处理模型来处理单变量时间序列信号,用于时间序列分类任务。这种方法是首个支持通过重编程将时间序列任务应用到预训练模型的框架。

继Voice2Series之后,出现了若干基于对比学习技术的时间序列数据预训练基础模型,包括TF-C、TS2Vec和CLUDA。TF-C模型由时间和频率两个分量组成,这两个分量分别通过对比学习独立训练,利用时频一致性作为自监督信号,即通过时间和频率分量之间的距离来提供。TS2Vec提出了一个通用的对比学习框架,它通过层次化的方式在增强的上下文视图上学习时间序列中不同语义级别的子序列的上下文表示。这个框架支持多变量输入,并可以应用于时间序列域中的多样任务。CLUDA是一个基于对比学习的时间序列无监督域适应模型。模型中包含两个新颖组件:自定义对比学习和最近邻对比学习。其中,对抗性学习用于在源域和目标域之间进行对齐。CLUDA的对比学习组件的目标是学习一个表示空间,使得语义相似的样本在该空间中更接近,而不同的样本则相隔更远。这样,CLUDA能够学习到多变量时间序列中的域不变上下文表示,进而实现有效的域适应。

除了对比学习技术,时间序列预训练领域还采用了多种其他技术。例如,STEP模型结合了预训练模型和图神经网络(STGNN)。预训练模型的目的是有效学习长期历史时间序列中的时间模式,并生成分段级别的表示,这些表示为短期时间序列提供上下文信息,并帮助STGNN更好地建模时间序列之间的依赖关系。MTSMAE是一种自监督的预训练方法,用于多元时间序列预测。它基于掩码自编码器(MAE)的预训练方法,引入了一种新的补丁嵌入技术,减少了内存使用,并允许模型处理更长的序列,以应对高信息密度的多元时间序列。SimMTM同样基于掩码建模技术,通过揭示流形的局部结构,将预训练方法扩展到时间序列。为了提高性能,SimMTM通过加权聚合流形外的多个邻居来恢复被掩码的时间点,从而能够从多个掩码序列中组装互补的时间变化,并提高重建序列的质量。PatchTST是一种基于Transformer的长期时间序列预测模型。为了克服其他模型在捕获局部语义信息方面的局限性,PatchTST引入了一种提取局部语义信息的补丁机制和一种通道独立设计,允许每个序列学习自己的注意力图进行预测,这种方法也被应用于预训练任务。TSMixer是一个轻量级的MLP Mixer模型,用于多元时间序列预测。它引入了两个新颖的在线协调头,通过利用层次结构补丁聚合的内在时间序列特性和跨通道相关性来调整和改进预测。与基于Transformer的模型不同,TSMixer显著提升了简单MLP结构的学习能力。

4.2.2 特定领域模型

PromptTPP提出了一种通用的预训练事件序列基础模型方法,并结合持续学习(Continual Learning, CL)来应对连续模型监控(continuous model monitoring)的挑战。这种方法使模型能够在现实世界约束下,连续学习一系列任务,同时避免灾难性遗忘。在PromptTPP中,基础模型与一个连续时间检索提示池相结合。这些提示是具有较小可学习参数的组件,它们被存储在内存中,并与基础模型一起进行优化。这样的设计确保了模型能够顺序学习事件流,而无需缓冲过去的样本或任务特定的属性,从而实现了有效的连续学习。

5 时空数据的大模型

在本节中,我们将研究大模型在时空数据分析中的进展,这些数据分析涉及三个主要数据类别:时空图谱、时空知识图谱和视频。每一种都具有广泛的实际应用范围。我们还深入研究了按模型类型和范围组织的文献(见图 3)

5.1 时空图

个体进入一个充满内在结构的星球,其中各种元素在空间和时间维度上进行动态交互,最终形成了深刻的时空构成。通过结合时空图(STG),这种结构的概念化在解决现实世界问题中得到了显著丰富。STG预测的应用,例如交通预测、空气质量预测、股价估计和人体骨骼分析,已经成为促进知情决策和推进可持续发展目标的重要工具。在深度学习时代,时空图神经网络(STGNNs)已成为最流行的STG预测方法。它们主要利用时空图神经网络来捕获顶点之间的空间相关性,并结合其他模型(如循环神经网络RNN和卷积神经网络CNN)来学习时间依赖性。

最近,大语言模型(LLMs)和预训练基础模型(PFMs)的出现为STGNNs在时空表征学习领域提供了宝贵的支持。这些模型擅长处理文本数据并将其置于上下文中,使它们能够从各种文本来源中提取见解,包括新闻文章、社交媒体内容和专业报告。这些洞察可以无缝集成到时空结构中,增强其上下文的丰富性。此外,它们促进了多种模态的融合,包括文本、图像和结构化数据,从而扩大了时空理解的深度和广度。凭借其生成人类可解释的能力,这些模型提高了透明度和可靠性,尤其是在城市规划或灾害响应等关键应用中。通过以简洁的表示形式编码高级信息,它们简化了训练和推理过程,从而提高了计算效率。这使得STG预测不仅更加准确,也更加高效和易于理解。

5.1.1 时空图中的大语言模型

与预训练基础模型(PFMs)相比,使用大语言模型(LLMs)来增强时空图神经网络(STGNNs)的研究还不多。研究主要分为两个方向:

1. 顶点间关系学习:一些早期研究,例如《Chatgpt informed graph neural network for stock movement prediction》,提出了一个新框架,该框架利用LLM强大的图推理能力来增强STGNNs,以预测股票走势。在这个框架中,使用ChatGPT从每日财经新闻中提取信息,发展出网络结构,并将这些结构集成到GNN中,为每个公司生成节点嵌入。这些嵌入有助于提高与股票变动相关的下游任务的性能。

2. STGNN下游应用支持:另一研究线利用LLM的先验知识来支持STGNN的下游应用,如LA-GCN,用于人类动作识别。在LA-GCN中,从LLM衍生的知识转化为先验全局关系(GPR)和先验类别关系(CPR),定义了节点间的连接。GPR作为生成新型骨骼表示的框架,旨在强调从基础数据中提取的关键节点信息。

综上所述,LLMs在提升STGNNs方面展现出巨大潜力,它们通过增强模型的准确性、上下文敏感度和语义理解深度,在时空表征学习领域提供了显著的推动力。

5.1.2 时空图中的预训练基础模型

我们目前正目睹着专为掌握时空图(STG)而设计的预训练机器学习模型的迅速增加,这些模型在现实世界应用中发挥着重要作用。它们通过知识转移显著地促进了STG的学习。具体来说,这些模型能够将学习到的表征进行转移,增强STG捕捉复杂时空模式的能力,进而实现更加高效和有效的学习。在接下来的部分中,我们将探讨一般用途和特定领域的预训练基础模型(PFM)。

一般用途:对比学习是一种在图像和文本领域广泛使用的表征学习方法,它在时空图(STG)学习中也显示出了显著的效果。X. Liu等人的STGCL是一个典型的例子,这种方法通过对比正样本对和负样本对,帮助从复杂的STG数据中提取出丰富且有意义的特征表示。这种方法已经在交通预测和功耗预测等多个领域中得到了实际应用,证明了其在现实世界问题中的有效性。进一步地,R. Li等人的SPGCL专注于学习顶点间的信息关系。它通过最大化正邻居和负邻居之间的差异,来学习每个顶点的表示。此外,R. Li等人的SPGCL还采用了自定进度策略来生成最优的图结构,这种方法有助于更准确地捕捉顶点间的复杂关系,从而提升STG分析的准确性和深度。通过这种方式,SPGCL能够为STG学习提供更加精细和深入的表征。

气候领域:近年来,基于人工智能的气候预测模型取得了显著进展。这些模型运用深度学习算法,对大量气象数据进行细致分析,从中提取对精确天气预报至关重要的复杂模式。预训练策略在该领域的应用也越来越受到重视,其目的是提升基于AI的气候模型的泛化能力。Pathak等人提出的FourCastNet是一个气候领域的预训练基础模型(PFM),它采用自适应傅里叶神经算子来实现高分辨率的预测和快速推理。FourCastNet的训练包括两个阶段:预训练和微调。在预训练阶段,模型通过监督训练学习从一步到下一步的映射;而在微调阶段,模型在预训练的基础上进行优化,以自回归方式预测接下来的两个时间步长。盘古模型则通过使用一种新型的3D地球特定变换器,展示了比FourCastNet更强的中期预测能力。这种3D深度网络通过地球特定的先验知识增强,有效处理复杂的天气数据模式。ClimaX是一个适应性深度学习模型,用于天气和气候科学。它扩展了Transformer架构,通过创新组件优化计算效率。ClimaX最初在CMIP6气候数据上进行预训练,能够针对各种气候和天气任务进行微调。W-MAE模型将自监督预训练方法,即蒙蔽自编码器(MAE),应用于气候预报任务。这种集成使模型能够从未标记的气象数据中提取基本特征和一般知识,有助于更好地处理不同的数据源。与上述方法不同,FengWu采用多模态、多任务的方法来处理中期气候预报。它使用具有模型特定的Transformer和跨模态融合策略的深度学习架构,并通过结合不确定性损失进行区域自适应优化,为各种预测器提供定制化的解决方案。

运输领域:CPPBTR提出了一种新颖的人群流预测框架,基于Transformer架构,并拥有独特的两阶段解码过程。在第一阶段,模型生成一个初步的预测序列。然后,进入第二阶段,这个初始序列中的每个时间步都会被逐一屏蔽,然后输入到Transformer的编码器中,以便对每个被屏蔽的位置进行更精细的流量预测。在交通流量预测领域,TrafficBERT受到BERT模型的启发,利用了其双向Transformer结构来捕捉关键特征。与传统模型不同,TrafficBERT能够预测整体流量趋势,而不仅仅是单个时间步长。它通过预训练来自多条道路的数据,增强了模型的泛化能力,而不是对每条道路进行单独训练。Wang等人介绍了交通基础模型(TFM),这是一种将交通模拟技术整合到交通预测中的模型。TFM使用图结构和动态图生成算法来精细捕捉交通系统中的复杂动态和参与者间的交互。这种数据驱动且无模型的仿真方法,有效应对了传统交通系统在结构复杂性和模型准确性方面的挑战,为解决现实世界的交通问题提供了坚实的基础。

5.2 时态知识图

搜索引擎、问答系统、对话系统和社交网络等众多应用都需要对底层结构化知识进行推理。知识图谱(KGs)作为研究这类复杂多重关系的重要模型,受到了广泛关注。KG通过三元组(主体s、谓语p、宾语o)的形式表示事实或事件,这些事实通常从文本数据中提取。其中,s和o分别代表主语和宾语实体,而p代表关系类型。然而,在现实世界中,知识是不断演变的。这种演变催生了时间知识图谱(TKGs)的构建和应用。在TKGs中,事实的表示从三元组扩展到包含时间戳t的四元组,即(s,p,o,t)。这种扩展不仅考虑了结构依赖性,还通过有效捕捉事实之间的时间依赖性,增强了对实体行为及其随时间变化的理解。这有助于更深入地分析实体如何随时间推移而发展,以及这些变化如何影响新事实的生成。TKGs的应用在提高知识推理的准确性和深度方面发挥着关键作用,使得知识图谱能够更真实地反映现实世界的动态变化。

由于近期大语言模型(LLMs)在众多文本推理任务中展现出卓越的性能,研究者们很自然地开始探索LLMs在时间知识图谱(TKG)中的有效性。基于执行的任务类型,可以将基于LLM的TKG模型分为两大类:预测和完成。

TKG预测:这一任务的目标是利用已知的历史事实来预测未来的事实。这通常通过利用LLM的情境学习(In-context Learning, ICL)能力来实现。在这一过程中,历史事实被构造成提示(prompts),LLM则以零样本(zero-shot)的方式进行预测。值得注意的是,TKG中的事件预测任务也在GDELT数据集上进行了评估。

TKG完成:由于TKG通常存在不完整性,完成TKG中缺失的事实也是一项重要任务。PPT是一种新型的基于预训练语言模型(PLM)的模型,它使用提示来解决完成TKG的任务。通过构建针对实体(ent提示)、关系(rel提示)和时间戳(time提示)的不同提示,将四元组转换成适合输入PLM的形式,并对掩码位置进行预测。这样,TKG的完成任务就被转换成了PLM模型的掩码令牌预测任务。

此外,还有尝试将LLM应用于电子商务环境中的TKG完成任务,其中建议通过提示GPT-3.5和PaLM等LLM来标记电子商务知识图谱(KG)中的谓词。这代表了首次将LLM应用于此类任务的尝试。

5.3 视频

视频是视觉信息的数字表现形式,通常由一系列图像或帧组成,这些帧共同描绘运动和时间的变化。视频数据在多种实际应用中非常普遍,包括监控系统、娱乐平台、社交媒体和驾驶辅助系统。在传统的视频理解领域,深度学习方法主要包含两个关键的范式:

2D CNNs:在这种方法中,每个视频帧独立通过2D卷积进行处理,然后在网络的顶层沿时间轴进行聚合。

3D CNNs:这种方法通过3D卷积来聚合时空特征,学习视频的时空表示。

近年来,Transformers因其捕获长距离依赖的能力而在视频识别的时空依赖性建模中变得流行。此外,大语言模型(LLMs)和预训练基础模型(PFMs)的最新进展为利用视频的多模态特性提供了新的可能性。例如,OpenAI的CLIP和DALL-E等模型能够联合处理视觉和文本模态,从而从视频数据中提取丰富的上下文信息,实现对复杂场景和事件的全面理解。

这些模型还有潜力促进跨不同领域的高效迁移学习,增强视频分析任务的泛化性和鲁棒性。在接下来的部分,我们将详细讨论用于视频理解的LLM和PFM,探讨它们如何进一步推动视频分析技术的发展。

5.3.1 视频数据的大语言模型

正如前面提到的,目前的视频理解模型往往有特定于任务的局限性,并不具有处理多样化任务的综合能力。然而,大语言模型(LLMs)在序列推理方面取得的最新进展,使得它们能够被应用于各种视频处理任务。例如,LAVENDER展示了如何利用在自然语言处理中预训练的LLMs来进行视频理解。VideoLLM是这类模型的一个例子,它与传统的LLMs不同,后者通常将单词作为输入,并在大量的自然语言数据集上进行预训练。VideoLLM将视频流编码成标记序列,并使用预训练的LLM进行视频理解任务。这需要一个精心设计的模态编码器和语义翻译器,它们将不同模态的输入转换为统一的标记序列,然后输入到仅解码器的LLM中。VideoLLM通过一个简单的任务头,生成了一个适用于多种视频理解任务的高效、统一框架。VideoChatGPT是为基于视频的对话量身定制的多模态模型。它结合了视觉编码器和LLM,使模型能够理解视频内容并生成深入的讨论。与依赖语言数据的方法不同,Zhang等人提出的Video-LLaMA是一个不依赖于文本数据的多模态框架。Video-LLaMA通过Q-Former向Llama提供视觉和听觉信息,使其能够理解视频中的视觉和听觉内容。为了确保视觉和音频编码器的输出与LLM的嵌入空间对齐,Video-LLaMA在大量的视频/图像-字幕对语料库上进行训练,并结合了视觉指令调整数据集。Valley是一个视频助手,采用时空池化策略从视频和图像输入中提取统一的视觉编码。它还整理了一个庞大的视觉-文本对语料库,用于预训练,并在ChatGPT的协助下生成了一个多任务指令跟踪视频数据集,用于对话设计。这些模型展示了如何将LLMs和PFMs应用于视频理解任务,克服了传统模型的局限性,为视频分析的多样性和深度提供了新的视角。

在视频问答(Video Question Answering, VQA)领域,一系列研究集中在利用大语言模型(LLMs)来提升性能。以下是一些代表性的工作:

FrozenBiLM:这个模型使用冻结的双向LLMs学习多模态输入,并通过掩码语言建模实现零样本VQA。

CaKE-LM:Su等人提出了这个问答生成框架,它专门用于从LLM中提取因果常识知识,以进行因果VQA。

VideoChat:该研究建议结合视频预训练基础模型(PFM)和图像PFM的特定元素,并使用一些适应性层将它们与LLM集成,通过两阶段的轻量级训练过程进行微调。

R2A(Retrieving-to-Answer):这是一个两阶段的VQA框架。第一阶段使用预训练的多模态模型,如CLIP,从通用文本语料库中检索语义相似的文本集合。第二阶段,利用原始问题和检索到的文本,直接应用LLMs生成所需的答案。

TRIVIA:在交通域VQA中,Qasemi等人引入了这种创新的自动字幕方法,作为一种弱监督形式,将交通域知识整合到视频语言模型中。

LAVILA:为了克服配对视频-文本语料库规模有限的挑战,LAVILA引入了一种新方法,利用LLMs的能力来获取视频语言表示。LAVILA重新利用预先训练的LLM以适应视觉输入,然后对其进行微调,创建自动化视频叙述器。自动生成的旁白提供了扩展视频全面覆盖、增强视觉信息和文本之间的时间同步以及增加文本内容多样性的诸多好处。

这些研究表明,LLMs在视频问答领域具有巨大潜力,能够通过结合视觉和语言信息,提供更丰富、更准确的答案。尽管存在数据规模的挑战,但通过创新的方法和LLMs的应用,研究者们正在不断推动视频问答技术的发展。

5.3.2 预训练的视频数据基础模型

近年来,语言、基于图像的视觉以及多模态预训练方法已经实现了显著的融合。随着这一趋势的发展,近期研究提出了多种对比或生成的策略,专门针对视频内容的预训练,进而催生了一系列视频或视频-语言基础模型。

具体来说,Wang等人首次提出了OmniVL,这是一个视觉-语言基础模型,它结合了图像-语言和视频-语言建模。这种模型能够自然地支持多种任务,包括纯视觉任务、跨模态对齐任务以及多模态任务。

为了改进视频预训练基础模型(PFM),PAXION通过整合缺失的动作知识到冻结的视频-语言基础模型中,同时保持其通用的视觉-语言能力,解决了视频理解方面的差距。

与此相比,mPLUG-2是一个新颖的Transformer框架,它允许组合使用不同的模块来处理单模态和跨模态任务。mPLUG-2通过共享通用模块并分离特定于模态的模块,有效地解决了模态纠缠问题,并提供了选择不同模块的灵活性,以实现包括文本、图像和视频在内的所有模态的理解和生成任务。

基于mPLUG-2的概念,Xu等人进一步设计了mPLUG-video,这是一个模块化的解码器模型,具有数量有限的可训练参数。该模型基于冻结的预训练大语言模型(LLM)和Youku-mPLUG2构建,进一步推动了视频处理技术的发展。

6 资源和应用程序

在本节中,我们总结了与时间序列和时空数据相关的各种应用中的常见数据集、模型和工具,这些都列在表3中。

表3 不同应用中的数据集资源汇总

6.1 交通应用

交通流量预测是智能交通系统(ITS)中的一个关键问题。时间序列和时空数据的利用有助于构建更准确和自适应的预测模型。在这个不断发展的领域中,研究人员和从业者可以访问多种数据集和工具,以支持他们的工作。

6.1.1 数据集

几个数据集已经成为交通流量预测领域的基准。METR-LA是一个引人注目的数据集,它包含了从洛杉矶县道路网络上的环路探测器获得的交通速度数据。该数据集涵盖了207个传感器在2012年3月至6月的4个月内的数据,每5分钟记录一次,总共达到34,272个时间片。

同样,PEMS-BAY和PEMS04是加州交通机构性能测量系统提供的数据集,为湾区在不同时间段的交通速度和流量提供了详细的洞察。

SUTD TrafficQA也是一个重要的数据集,包含10,080个真实世界视频,并配有62,535个问答对,这些视频捕捉了静态和第一人称视角的场景。

此外,SafeGraph提供的TaxiBJ、BikeNYC、TaxiNYC以及移动性数据集等,为交通流和人类移动性的不同方面提供了全面的视角,是交通流建模和预测的宝贵资源。

LargeST是首个用于大规模交通预测的数据集,涵盖了五年内道路上8000多个传感器的数据,为交通流量预测研究提供了丰富的信息。

6.1.2 工具

为了进行有效的交通分析和模拟,研究人员可以利用多种工具。SUMO是一个开源的交通模拟器,它提供了一个全面的环境,用于交通建模和分析。TransWorldNG 是 GitHub 上的另一个重要工具,它旨在促进复杂的交通模拟。

对于专注于真实世界人类移动数据的研究人员,SafeGraph Data for Academics 提供了一个平台,使研究人员能够访问大量匿名化处理的数据,确保隐私的同时,支持广泛的分析。

在交通流量预测领域,trafficBERT 是一个为不同交通场景量身定制的模型检查点资源。这个模型的独特之处在于其预训练基础,它是在大规模交通数据上进行预训练的。trafficBERT 不依赖于传统的循环神经网络(RNN)来捕获时间序列信息,而是采用了多头自注意力机制,这种设计选择使得模型能够更复杂地捕获数据中的时间依赖性。

6.2 医疗保健应用

医疗保健中的时间序列预测虽然面临一些方法论挑战,但其在实际应用中的重要性促使该领域迅速发展。在医学背景下,预测模型对于疾病进展预测、死亡率估计和时间依赖性风险评估等方面起着关键作用。本节概述了重要的数据集和模型/工具,显示了时间序列预测在推动医疗保健解决方案方面的巨大潜力。

6.2.1 数据集

在医疗保健领域,一些数据集因其规模和多样性而成为研究和应用的基准:

PTBXL :包含来自18,885名患者的21,837个临床12导联心电图记录,每个记录时长10秒,涵盖诊断、形态和节律,共71种不同的标注。

NYU数据集:包括NYU Notes、NYU Notes-Manhattan、NYU Notes-Brooklyn,这些数据集跨越了10年的未标记住院患者临床笔记,以及针对特定任务(如“纽约大学再入院”、“纽约大学死亡率”)的微调数据集。

UF Health临床语料库:这是一个聚合了UF Health IDR、MIMIC-III 语料库、PubMed合集和维基百科文章的临床叙述的大型语料库,总字数超过900亿。

I2B2-2012:专注于临床叙述中的时间关系,提供了带有时间信息注释的出院摘要。

MIMIC-III :这是一个公共数据集,包含了来自重症监护病房的ICD-9代码、生命体征、药物和其他关键患者数据。

CirCor DigiScope :作为最大的儿科心音数据集,它带有心脏杂音的注释。

这些数据集为医疗保健领域的研究提供了宝贵的资源,支持从心电图分析到临床笔记处理等多种应用。

6.2.2 模型检查点和工具包

在医疗保健领域,已经开发出多种模型检查点和工具包,专门用于医疗保健应用:

NYUTron :这是一个大语言模型,专门为处理结构化和非结构化医疗笔记以及实时电子订单而设计。

BioBERT :基于BERT模型,并使用生物医学数据集进行微调,擅长于实体识别、关系辨识和问答任务。

ClinicalBERT :利用MIMIC-III数据集进行训练,适用于临床领域,有助于预测患者结果、数据匿名化和诊断。

BlueBERT :在BERT的基础上,经过生物医学文本数据的训练,精通各种生物医学自然语言处理(NLP)任务。

千里眼 (Clairvoyance):这是一个端到端的临床决策支持系统,能够进行预测、监测和个性化治疗计划。

ARL EEGModels:这是一组在Keras和TensorFlow中实现的用于EEG信号处理的卷积神经网络(CNN)模型。

DeepEEG:这是一个在Keras/TensorFlow中用于EEG处理的深度学习库,与MNE工具箱兼容。

这些工具和模型为医疗保健专业人员和研究人员提供了强大的资源,以支持从临床决策到生物医学信号处理的各种任务。

6.3 天气应用

天气预报涉及对大气条件的预测,这是无数日常决策和经济考虑的基石。本小节描述了用于天气动力学中时间序列预测的主要数据集、模型和工具。

6.3.1 数据集

SEVIR (Storm EVent ImagRy) 包含超过 10,000 个事件,在 4 小时内对齐 384 km x 384 km 图像序列,集成了来自 GOES-16 成像仪和 NEXRAD 的数据。位移可作为不确定性估计的晴雨表,以及针对多种数据模态中真实世界分布偏差的鲁棒性。AvePRE、SurTEMP、SurUPS 由 NASA 提供。这些数据集阐明了来自广阔的地面仪器网络的 12 个天气参数的每小时变化。WeatherBench 可作为中期天气预报的基准。CMIP6 是一个国际联盟,专注于评估多样化的全球气候模式。ERA5 是一个广泛的再分析存储库,提供 1979 年至 2018 年的细粒度大气数据。

6.3.2 模型和工具

Pangu-Weather 是一种先进的深度学习模型,以其快速、精确的全球天气预报能力而闻名。ClimaX 建立在 Transformer 架构之上,通过创新的编码和聚合技术,能够在 CMIP6 数据上进行预训练,处理多种数据集。GraphCast 通过集成图神经网络(GNN),在预测任务中表现出多功能性。总体而言,天气预报领域中的时间序列评估受益于显著的数据收集和建模技术的进步。目前该领域的研究进展预示着在不久的将来,我们将拥有更加精细的工具和数据集来提高天气预报的准确性和效率。

6.4 财务应用

时间序列预测在金融领域面临重大挑战,这要求对历史数据中的线性和非线性相互作用进行深入分析,以便对未来趋势做出准确预测。在金融行业中,这种预测的常见应用包括确定买卖时机的信号预测,以及对公司股票在市场的价格波动进行预测。

6.4.1 数据集

金融领域(特别是就业市场)在COVID-19大流行期间受到了密切关注,相关数据集追踪了100万美国在职雇员的就业情况变化,并考虑了州级政策作为极端事件的影响因素。

StockNet是一个全面的数据集,它分析了推文和历史股票价格对股票走势的影响,涵盖了88只股票在两年内的数据。

EDT专注于公司事件检测和基于文本的股票预测,由9721篇新闻文章组成,这些文章都带有代币级别的事件注释,为基于文本的股票预测提供了一个基准。

NASDAQ100数据集包含了纳斯达克100指数的每日股票价格,这些数据是通过yfinance软件包从Yahoo Finance获取的。

6.4.2 模型与工具

FinGPT是一个开源的扩展语言模型,专门为金融领域设计,它采用了一种透明的方法,突出了自动化数据管理流程和轻量级低秩适应技术的重要性。

WeaverBird是近期推出的智能对话系统,专门为金融领域定制,配备了知识库和搜索引擎。它能够理解复杂的财务查询,提供的答案基于搜索结果,并且包括对信息来源的适当引用,这增加了其答案的可信度。

在快速变化的金融世界中,持续开发和完善预测模型和工具至关重要。随着数据集的扩展和模型技术的进步,金融行业将能够从更精确的预测和更细致的决策制定中获益。

6.5 视频应用

视频问答 (VideoQA) 致力于使用给定视频中的内容来回答自然语言问题。该模型应生成反映视频中描绘的内容的精确答案。该领域还延伸到视频质量评估和视频预测。

6.5.1 数据集

TGIF-QA是一个数据集,提供了165K个问答对,这些问答对是从TGIF数据集中的动画GIF中提取的。MSR-VTT是微软研究实验室推出的视频字幕数据集,它包含了10,000个视频剪辑,覆盖了20个不同的类别。

WebVid是一个庞大的视频数据集,由1000万个视频剪辑组成,每个视频剪辑都配有网络上的字幕。MSVD(微软研究视频描述语料库)包含了大约120K个句子,这些句子详细描述了特定的视频片段。

DiDeMo是一个专为视频事件时间定位设计的数据集,包含近27,000个时刻,每个时刻都有详尽的描述。COCO(微软常见对象上下文数据集)为对象检测、分割和字幕提供了丰富的资源,由328K个图像组成。

6.5.2 模型与工具

对比语言-图像预训练(CLIP)使用自然语言作为监督信号,有效地训练图像的表示。BLIP引入了一种独特的引导方法,用于处理视觉-语言预训练(VLP)中从嘈杂的网络数据中学习的问题,提高了学习效果。

ViLBERT,即视觉和语言BERT,扩展了原始的BERT模型,使其能够同时处理视觉信息和文本数据。VisualBERT通过Transformer架构将图像区域与语言信息结合,利用自注意力机制来识别和对齐隐含的语言和视觉元素。

6.6 事件预测应用

事件序列,也称为具有不规则时间戳的异步时间序列,在金融、在线购物、社交网络等现实世界领域中起着至关重要的作用。本小节讨论用于事件预测任务的主要数据集、模型和工具。

6.6.1 数据集

亚马逊和淘宝提供了两个电商平台上的时间戳用户产品评论行为数据集。在这些数据集中,每位用户都有一系列评论事件,每个事件记录了评论的时间戳和产品类别。这些类别进一步映射到特定的事件类型。

Retweet、StackOverflow和Taxi是其他三个广泛使用的事件序列数据集。Retweet数据集记录了用户在社交媒体上转发消息的序列;StackOverflow数据集包含了用户在该问答平台上的互动序列;而Taxi数据集则追踪了用户出租车接送服务的事件序列。这些数据集为研究不同类型用户行为提供了丰富的信息。

6.6.2 模型与工具

Tick是一个专注于统计学习方法在时序点过程(TPP)上应用的著名库。为了解决传统TPP模型的局限性,研究人员近年来致力于开发神经网络版本的TPP模型,这些模型利用神经网络的强大表达能力来捕捉数据中的复杂依赖性。

EasyTPP是神经事件序列建模领域的首个开源研究资源中央存储库,它提供了一系列资源,包括数据、模型、评估工具和文档。该库不仅实现了多种流行的神经TPP模型,还提供了一个丰富的模块化库,允许用户通过组合这些模块快速构建复杂的模型。

此外,EasyTPP还提供了一个统一的界面,用于处理现有数据集和添加新的数据集,以及一系列易于使用和扩展的评估工具,这些都旨在促进可重复性研究。通过这些特性,EasyTPP为研究人员和开发者在神经事件序列建模方面提供了便利和支持。

6.7 其他应用

除了前面提到的特定应用外,时间序列预测、分类和异常检测也是电力、云计算、零售等行业的通用应用领域。

6.7.1 数据集

ETT(电力变压器温度)数据集包含了中国两个县变压器在两年时间里记录的温度数据。M4竞赛提供了100,000个时间序列,这些数据是为Makridakis预测竞赛而收集的。电力数据集记录了一个家庭在将近四年时间内的电力消耗测量值。

Alibaba Cluster Trace是一个数据集,它详细捕捉了在24小时内共置工作负载的统计信息。TSSB(时间序列分割基准)是一个包含75个带注释的时间序列的数据集,为时间序列分割任务提供了基准。

UCR时间序列分类档案是一个主要的资源库,它包含的时间序列数据集数量已经从85个系列扩展到了128个系列,为时间序列分类研究提供了丰富的数据资源。

6.7.2 通用工具和库

OpenSTL是一个时空预测学习的基准测试,它包含了从简单的合成场景到复杂的现实世界应用的各种方法和任务,为研究人员提供了丰富的测试平台。

BasicTS是一个基于PyTorch的基准测试和工具箱,旨在简化时间序列预测的过程,帮助研究人员和开发者更高效地进行时间序列建模。

Merlion是一个开源的机器学习库,专门针对时间序列分析,支持单变量和多变量时间序列模型,提供了一套全面的分析工具。

darts是一个Python库,专为时间序列预测和异常检测设计,以其用户友好的特性,使得时间序列分析更加容易和直观。

PyTorch Geometric Temporal是PyTorch Geometric的扩展库,专注于动态图数据,支持一系列功能,为处理时间序列数据提供了强大的支持。

7 展望与未来机遇

在本节中,我们将讨论当前研究的潜在局限性,并重点介绍未来六大研究方向,旨在开发更强大、更透明和更可靠的时间数据分析大模型。

7.1 大模型的理论分析

大语言模型(LLM)主要是为自然语言处理任务而设计,它们擅长捕捉序列数据中的长期依赖关系。由于文本数据和时间数据都具有顺序性,最近的研究已经开始探索将LLM应用于时间序列和时空任务。这表明,LLM从文本数据中学习到的表示可以经过微调,以适应时间数据的模式。

然而,这种应用仍然需要更深入的理解。与其他深度学习模型一样,LLM因其复杂性而常常被视为“黑匣子”,这使得理解哪些数据特征影响了它们的预测和决策变得困难。为了更好地利用LLM处理时间数据,需要进行更深入的理论分析。这包括理解语言数据和时间数据之间的基本模式如何相似,以及如何有效地将这些模式应用于时间序列和时空任务,例如预测、异常检测和分类等。这种分析将有助于提高模型的透明度和可解释性,从而在实际应用中更可靠地使用LLM。

7.2 多模态模型的发展

在实际应用中,许多时间序列和时空数据往往会伴随有补充信息,例如文本描述,这在经济和金融领域尤其有价值。例如,在经济预测中,可以结合文本数据(如新闻文章或社交媒体推文)和数字时间序列数据来提高预测的准确性。因此,大语言模型(LLM)可以被用来学习一种联合表示,这种表示既考虑了时间数据的顺序特性,也考虑了其他模态的独特特征。

此外,不同的数据模态可能具有不同的时间分辨率。LLM可以通过调整来处理这些多模态时间数据中的时间分辨率差异,确保能够整合来自不同时间尺度的信息。通过这种方式,可以充分利用所有信息源,包括它们各自的时间分辨率,以期达到更优的性能表现。这种综合多模态数据的方法为时间序列分析和时空预测提供了更为丰富和全面的视角。

7.3 持续学习和适应

实际应用程序常常需要应对不断变化的环境。因此,研究模型如何适应非稳态环境,避免对已有知识的快速遗忘,变得至关重要。虽然在传统的机器学习和深度学习模型中已经对这些挑战进行了一些探索,但如何使大模型能够持续适应时间数据的变化,仍然是一个需要进一步研究的领域。这包括开发在线学习策略、适应概念漂移,以及适应数据模式的持续演变。这些能力对于确保模型在动态实际应用中的有效性和鲁棒性至关重要。

7.4 可解释性和可解释性

理解模型做出特定预测的原因对于时间序列分析至关重要,特别是在医疗保健和金融等关键领域。目前,我们对大语言模型(LLMs)的内部工作原理理解有限。因此,开发理论框架来深入理解LLMs学到了什么,以及它们在应用于时间序列数据时是如何进行预测的,这是非常重要的。

提高模型的可解释性和透明度,可以帮助我们理解时间序列分析中的基本原理,例如预测未来值的依据,识别特定点为何被视为异常,或者解释特定分类结果背后的逻辑。这种可解释性对于建立用户对模型预测的信任至关重要。

此外,研究如何增强大模型以执行时间推理,并推断时间序列数据中的因果关系,也是当前研究的一个重要方向。这包括开发能够识别数据中因果关系的方法,这对于进行根本原因分析和制定干预计划等应用场景非常重要。通过理解数据中的因果机制,可以更有效地预测和解释时间序列中的事件,从而在实际应用中做出更明智的决策。

7.5 大模型的隐私和对抗性攻击

时态数据,如在医疗保健和金融领域中的数据,通常包含敏感信息。大语言模型(LLM)在训练或微调过程中可能会记住这些数据的特定细节,带来私有信息泄露的风险。因此,探索如何结合隐私保护技术,例如差分隐私和联邦学习,以确保数据的隐私安全,同时又能发挥LLM在时间序列和时空数据分析中的高效能,是一个充满机遇的研究方向。

7.6 模型泛化和漏洞

大语言模型(LLM)通常首先在广泛的数据上进行预训练,然后针对特定任务进行微调。如果微调阶段使用的数据包含具有误导性或噪声的样本,这个过程可能会使模型容易受到攻击或产生错误。此外,如果用于微调的时间序列数据没有经过严格筛选和管理,模型可能会继承这些数据中的偏见或缺陷,影响其在实际应用中的稳定性和可靠性。

尽管LLM在庞大的数据集上进行了训练,但它们可能无法有效泛化到未见过的或分布不常见的数据上。时间序列和时空数据可能会突然变化或表现出新的趋势。如果LLM在训练期间没有遇到过类似的模式,它们可能无法产生可靠的预测或输出,这凸显了提高模型鲁棒性和泛化能力的重要性。

8 结论

我们进行了一项全面且最新的调查,专注于为时间序列和时空数据量身定制的大模型。本调查旨在通过引入一种新颖的分类法,为这个快速发展的领域提供一个全新的视角。我们不仅仅停留在对模型的描述,还总结了每个类别中的核心技术,深入分析了它们的优势和局限,并为未来的研究方向提出了有潜力的路径。这一令人兴奋的研究主题拥有无限的探索空间。我们期望这项调查能够激发更多的兴趣和好奇心,促进对大模型在时间序列和时空数据分析应用中的深入研究和持续热情。

论文题目:Large Models for Time Series and Spatio-Temporal Data: A Survey and Outlook

论文地址:https://arxiv.org/abs/2310.10196

总结

本文共有336篇参考论文,是一篇十分全面的时序大模型的综述,还提出了一种统一且结构化的分类方法,将现有研究归纳为两大主要类别:时间序列的大模型(LM4TS)和时空数据的大模型(LM4STD),并按照数据类型进行组织。在每个类别中,我们进一步根据模型类型细分为LLMs和PFMs两个子组。随后,我们根据模型的应用范围、领域以及特定任务进行了更细致的分类,且在分类图中列出各种类型都有例子与引用的论文。汇集并总结了该领域的众多资源,包括数据集、开源实现和评估基准。最终从多个视角展望了时序大模型潜在的机遇与挑战。