反爬虫机制是网站为了防止自动化工具抓取其内容而采取的各种技术和策略。了解这些机制可以帮助你设计更有效的爬虫程序。下面我将详细讲解常见的反爬虫机制及其应对策略。

常见的反爬虫机制

-

IP 封禁

- 描述:服务器检测到某个 IP 地址在短时间内发送了大量的请求,会将其列入黑名单。

- 对策:

- 使用代理池轮换 IP 地址。

- 限制请求频率,模拟真实用户的访问行为。

-

User-Agent 检测

- 描述:服务器会检查 User-Agent 字段,如果发现是爬虫常用的 User-Agent,则拒绝服务。

- 对策:

- 使用随机或伪装的 User-Agent。

- 模拟常见浏览器的 User-Agent。

-

验证码(CAPTCHA)

- 描述:当检测到可疑行为时,网站会要求用户输入验证码。

- 对策:

- 使用 OCR 技术识别验证码。

- 使用第三方服务解决验证码问题。

- 手动输入验证码。

-

JavaScript 渲染

- 描述:有些网站使用 JavaScript 动态加载内容,直接抓取 HTML 无法获取完整数据。

- 对策:

- 使用支持 JavaScript 渲染的工具,例如 Selenium 或 Puppeteer。

- 分析 JavaScript 代码,手动模拟请求。

-

动态 URL 生成

- 描述:网站可能使用动态生成的 URL 来混淆爬虫。

- 对策:

- 分析 URL 生成规律,手动构造 URL。

- 使用 Selenium 等工具抓取动态生成的 URL。

-

Cookie 和 Session ID

- 描述:网站可能通过 Cookie 和 Session ID 进行跟踪。

- 对策:

- 保持会话状态,使用相同的 Cookie 和 Session ID。

- 使用轮换的 Cookie 和 Session ID。

-

HTTP 请求头检查

- 描述:服务器会检查 HTTP 请求头中的字段,如 Accept-Language、Referer 等。

- 对策:

- 模拟真实的请求头信息。

- 使用随机或真实的请求头。

-

限制请求频率

- 描述:服务器会对每个 IP 或会话的请求数量进行限制。

- 对策:

- 添加延时以降低请求频率。

- 使用代理池轮换 IP 地址。

-

隐藏数据

- 描述:有些网站会隐藏关键数据,只在特定条件下显示。

- 对策:

- 分析网页结构和交互逻辑。

- 发送特定的请求来触发数据展示。

-

法律限制

- 描述:有些网站会在 robots.txt 文件或服务条款中禁止爬虫。

- 对策:

- 遵守网站的爬虫政策。

- 获得网站所有者的明确许可。

应对策略示例代码

1. 使用代理池

import requests

from random import choice

proxies = [

"http://proxy1.example.com:8080",

"http://proxy2.example.com:8080",

"http://proxy3.example.com:8080"

]

def get_with_proxy(url):

proxy = {"http": choice(proxies), "https": choice(proxies)}

try:

response = requests.get(url, proxies=proxy, timeout=5)

return response

except Exception as e:

print(f"Failed to fetch {url}: {e}")

return None

response = get_with_proxy("https://example.com")

if response:

print(response.text)

2. 使用随机 User-Agent

import requests

from fake_useragent import UserAgent

ua = UserAgent()

def get_with_random_ua(url):

headers = {'User-Agent': ua.random}

try:

response = requests.get(url, headers=headers, timeout=5)

return response

except Exception as e:

print(f"Failed to fetch {url}: {e}")

return None

response = get_with_random_ua("https://example.com")

if response:

print(response.text)

3. 使用 Selenium

from selenium import webdriver

from selenium.webdriver.common.by import By

from selenium.webdriver.support.ui import WebDriverWait

from selenium.webdriver.support import expected_conditions as EC

def get_with_selenium(url):

driver = webdriver.Chrome()

driver.get(url)

try:

element = WebDriverWait(driver, 10).until(

EC.presence_of_element_located((By.ID, "some_id"))

)

print(element.text)

finally:

driver.quit()

get_with_selenium("https://example.com")

总结

- 了解网站使用的反爬虫机制有助于你设计更有效的爬虫程序。

- 采用合理的策略可以减少被封禁的风险,同时提高爬虫的稳定性和效率。

- 在进行爬虫开发时,一定要遵守相关法律法规,尊重网站的服务条款。

接下来我会给出一些具体的代码案例,来演示如何处理一些常见的反爬虫机制。这里我们将重点介绍以下几个方面:

- 使用代理池

- 随机化 User-Agent

- 处理 JavaScript 渲染页面

- 处理验证码

当然可以!接下来,我将进一步优化之前的代码示例,以提高它们的稳定性和效率。我们将包括更完善的错误处理、重试机制、日志记录以及其他实用的功能。

1. 使用代理池

import requests

from random import choice

import logging

from time import sleep

# 配置日志

logging.basicConfig(level=logging.INFO, format='%(asctime)s - %(levelname)s - %(message)s')

# 代理池列表

proxies = [

"http://proxy1.example.com:8080",

"http://proxy2.example.com:8080",

"http://proxy3.example.com:8080"

]

def get_with_proxy(url, max_retries=3):

retries = 0

while retries < max_retries:

try:

# 随机选择一个代理

proxy = {"http": choice(proxies), "https": choice(proxies)}

# 发送带有代理的请求

response = requests.get(url, proxies=proxy, timeout=5)

return response

except Exception as e:

retries += 1

logging.warning(f"Failed to fetch {url} using proxy. Retry {retries}/{max_retries}. Error: {e}")

sleep(1) # 等待一秒后重试

logging.error(f"Max retries reached for {url} using proxy.")

return None

# 测试

url = "https://httpbin.org/ip"

response = get_with_proxy(url)

if response:

print(response.text)

2. 随机化 User-Agent

import requests

from fake_useragent import UserAgent

import logging

from time import sleep

# 配置日志

logging.basicConfig(level=logging.INFO, format='%(asctime)s - %(levelname)s - %(message)s')

# 创建 UserAgent 对象

ua = UserAgent()

def get_with_random_ua(url, max_retries=3):

retries = 0

while retries < max_retries:

try:

# 设置随机的 User-Agent

headers = {'User-Agent': ua.random}

# 发送带有随机 User-Agent 的请求

response = requests.get(url, headers=headers, timeout=5)

return response

except Exception as e:

retries += 1

logging.warning(f"Failed to fetch {url} using random UA. Retry {retries}/{max_retries}. Error: {e}")

sleep(1) # 等待一秒后重试

logging.error(f"Max retries reached for {url} using random UA.")

return None

# 测试

url = "https://httpbin.org/headers"

response = get_with_random_ua(url)

if response:

print(response.text)

3. 处理 JavaScript 渲染页面

from selenium import webdriver

from selenium.webdriver.chrome.options import Options

from selenium.webdriver.common.by import By

from selenium.webdriver.support.ui import WebDriverWait

from selenium.webdriver.support import expected_conditions as EC

import logging

from time import sleep

# 配置日志

logging.basicConfig(level=logging.INFO, format='%(asctime)s - %(levelname)s - %(message)s')

def get_with_selenium(url, max_retries=3):

retries = 0

while retries < max_retries:

try:

# 配置 Chrome 选项

chrome_options = Options()

chrome_options.add_argument("--headless") # 无头模式

# 初始化 WebDriver

driver = webdriver.Chrome(options=chrome_options)

try:

# 访问目标网址

driver.get(url)

# 等待某个元素加载完成

element = WebDriverWait(driver, 10).until(

EC.presence_of_element_located((By.ID, "some_element_id"))

)

# 获取页面源码

page_source = driver.page_source

# 输出页面源码

logging.info("Page source retrieved successfully.")

return page_source

finally:

# 关闭 WebDriver

driver.quit()

return page_source

except Exception as e:

retries += 1

logging.warning(f"Failed to fetch {url} using Selenium. Retry {retries}/{max_retries}. Error: {e}")

sleep(1) # 等待一秒后重试

logging.error(f"Max retries reached for {url} using Selenium.")

return None

# 测试

url = "https://www.example.com"

page_source = get_with_selenium(url)

if page_source:

print(page_source)

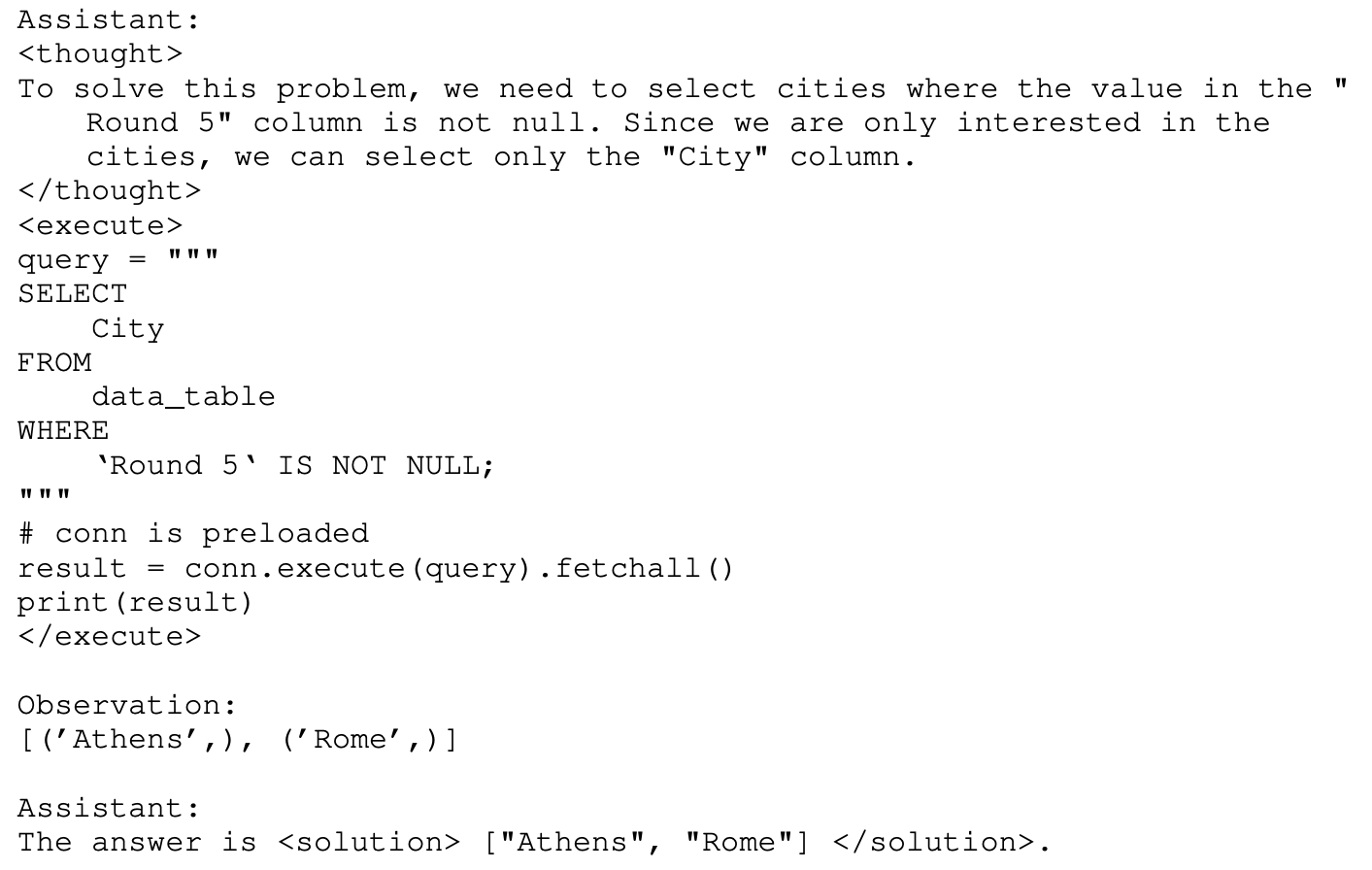

4. 处理验证码

验证码处理通常较为复杂,这里使用了一个简单的 OCR 解决方案作为示例。请注意,实际应用中可能需要更复杂的 OCR 处理或者使用专门的服务来处理验证码。

from selenium import webdriver

from selenium.webdriver.common.by import By

from selenium.webdriver.support.ui import WebDriverWait

from selenium.webdriver.support import expected_conditions as EC

from PIL import Image

import pytesseract

from io import BytesIO

import logging

from time import sleep

# 配置日志

logging.basicConfig(level=logging.INFO, format='%(asctime)s - %(levelname)s - %(message)s')

def solve_captcha(driver, captcha_element, max_retries=3):

retries = 0

while retries < max_retries:

try:

location = captcha_element.location

size = captcha_element.size

screenshot = driver.get_screenshot_as_png()

im = Image.open(BytesIO(screenshot))

left = location['x']

top = location['y']

right = location['x'] + size['width']

bottom = location['y'] + size['height']

im = im.crop((left, top, right, bottom))

captcha_text = pytesseract.image_to_string(im)

return captcha_text.strip()

except Exception as e:

retries += 1

logging.warning(f"Failed to solve captcha. Retry {retries}/{max_retries}. Error: {e}")

sleep(1) # 等待一秒后重试

logging.error("Max retries reached for solving captcha.")

return None

def get_with_captcha(url, max_retries=3):

retries = 0

while retries < max_retries:

try:

# 初始化 WebDriver

driver = webdriver.Chrome()

try:

# 访问目标网址

driver.get(url)

# 等待验证码出现

captcha_element = WebDriverWait(driver, 10).until(

EC.presence_of_element_located((By.ID, "captcha_image"))

)

# 解析验证码

captcha_text = solve_captcha(driver, captcha_element)

# 打印解析出的验证码

logging.info(f"Solved captcha: {captcha_text}")

# 假设有一个输入框用于提交验证码

input_field = WebDriverWait(driver, 10).until(

EC.presence_of_element_located((By.ID, "captcha_input"))

)

input_field.send_keys(captcha_text)

# 提交表单或点击按钮

submit_button = WebDriverWait(driver, 10).until(

EC.element_to_be_clickable((By.ID, "submit_button"))

)

submit_button.click()

# 等待页面加载完成

WebDriverWait(driver, 10).until(

EC.presence_of_element_located((By.ID, "content_after_captcha"))

)

# 获取页面源码

page_source = driver.page_source

# 输出页面源码

logging.info("Page source retrieved successfully.")

return page_source

finally:

# 关闭 WebDriver

driver.quit()

return page_source

except Exception as e:

retries += 1

logging.warning(f"Failed to fetch {url} using captcha. Retry {retries}/{max_retries}. Error: {e}")

sleep(1) # 等待一秒后重试

logging.error(f"Max retries reached for {url} using captcha.")

return None

# 测试

url = "https://www.example.com/captcha"

page_source = get_with_captcha(url)

if page_source:

print(page_source)

功能说明

- 错误处理:每个函数都包含了错误处理逻辑,可以捕获异常并记录日志。

- 重试机制:增加了重试机制,当请求失败时可以尝试多次。

- 日志记录:使用

logging库记录爬虫的状态和错误信息,包括重试次数和最终失败的情况。 - 等待时间:在重试之间添加了等待时间,以减少服务器的压力。