https://blog.csdn.net/qq_45588019/article/details/120935828 基本均参考该博客

《深度学习原理Pytorch实战》

初步处理

导包

import torch

import numpy as np

from matplotlib import pyplot as plt

from torch.utils.data import DataLoader

from torchvision import transforms

from torchvision import datasets

import torch.nn.functional as F

定义超参数

learning_rate = 0.01

momentum = 0.5 # 动量

EPOCH = 10 #训练总的循环周期

batch_size = 64 # 一个批次的大小,64张图片

加载MNIST数据集

#加载MNIST数据,如果没有下载过,系统就会在当前路径下新建/data子目录

train_dataset = datasets.MNIST(root='./data', train=True, transform=transform,download=True) # 本地没有就加上download=True

test_dataset = datasets.MNIST(root='./data', train=False, transform=transform,download=True) # train=True训练集,=False测试集

# 训练集的加载器,自动将数据切分成批,顺序随机打乱

train_loader = DataLoader(train_dataset, batch_size=batch_size, shuffle=True)

test_loader = DataLoader(test_dataset, batch_size=batch_size, shuffle=False)

加载器(dataloader)主要负责在程序中对数据集的使用。例如,我们在训练神经网络的过程中需要逐批加载训练数据,加载器就会自动帮我们逐批输出数据。使用加载器比直接使用张量手动加载数据更好,因为当数据集超大的时候,我们无法将所有数据全部装载到内存中,必须从硬盘上加载数据,而加载器可以让这一过程自动化。

采样器(sampler)为加载器提供了一个每一批抽取数据集中样本的方法。我们可以按照顺序将数据集中的数据逐个抽取到加载器中,也可以完全随机地抽取,甚至可以依某种概率分布抽取。

总之,数据集、加载器和采样器可以让数据的处理过程更加便捷和标准。

打印查看加载的数据

fig = plt.figure()

for i in range(12):

plt.subplot(3, 4, i+1)

plt.tight_layout()

plt.imshow(train_dataset.train_data[i], cmap='gray', interpolation='none')

plt.title("Labels: {}".format(train_dataset.train_labels[i]))

plt.xticks([])

plt.yticks([])

plt.show()

构建网络

构造ConvNet类,它是对nn.Module类的继承,即nn.Module是父类,ConvNet为子类。nn.Module中包含了绝大部分关于神经网络的通用计算,如初始化、前传等,用户可以重写nn.Module中的部分函数以实现定制化,如init()构造函数和forward()函数。

其次,复写init()和forward()这两个函数。init()为构造函数,每当类ConvNet被具体化一个实例的时候就会被调用。forward()函数则是在正向运行神经网络时被自动调用,它负责数据的向前传递过程,同时构造计算图。

class ConvNet(torch.nn.Module):

def __init__(self):

super(ConvNet, self).__init__()

self.conv1 = torch.nn.Sequential(

#定义一个卷积层,输入通道为1,输出通道为10,窗口大小为5

torch.nn.Conv2d(1, 10, kernel_size=5),

torch.nn.ReLU(),

torch.nn.MaxPool2d(kernel_size=2),

)

self.conv2 = torch.nn.Sequential(

torch.nn.Conv2d(10, 20, kernel_size=5),

torch.nn.ReLU(),

torch.nn.MaxPool2d(kernel_size=2),

)

self.fc = torch.nn.Sequential(

torch.nn.Linear(320, 50),

torch.nn.Linear(50, 10),

)

def forward(self, x):

batch_size = x.size(0)

x = self.conv1(x) # 一层卷积层,一层池化层,一层激活层(图是先卷积后激活再池化,差别不大)

x = self.conv2(x) # 再来一次

x = x.view(batch_size, -1) # flatten 变成全连接网络需要的输入 (batch, 20,4,4) ==> (batch,320), -1 此处自动算出的是320

x = self.fc(x)

return x # 最后输出的是维度为10的,也就是(对应数学符号的0~9)

卷积层

torch.nn.Conv2d(in_channels, out_channels, kernel_size, stride, padding)

in_channels:输入通道

out_channels:输出通道

kernel_size:卷积核大小

stride:步长

padding:填充

池化层

torch.nn.MaxPool2d(input, kernel_size, stride, padding)

激活函数

torch.nn.ReLU()

CNN模型

比如输入一个手写数字“5”的图像,它的维度为(batch,1,28,28)即单通道高宽分别为28像素。

1、首先通过一个卷积核为5×5的卷积层,其通道数从1变为10,高宽分别为24像素;

2、然后通过一个卷积核为2×2的最大池化层,通道数不变,高宽变为一半,即维度变成(batch,10,12,12);

3、然后再通过一个卷积核为5×5的卷积层,其通道数从10变为20,高宽分别为8像素;

4、再通过一个卷积核为2×2的最大池化层,通道数不变,高宽变为一半,即维度变成(batch,20,4,4);

5、之后将其view展平,使其维度变为320(2044)之后进入全连接层,用线性函数将其输出为10类,即“0-9”10个数字。

class ConvNet(torch.nn.Module):

def __init__(self):

super(ConvNet, self).__init__()

self.conv1 = torch.nn.Sequential(

torch.nn.Conv2d(1, 10, kernel_size=5),

torch.nn.ReLU(),

torch.nn.MaxPool2d(kernel_size=2),

)

self.conv2 = torch.nn.Sequential(

torch.nn.Conv2d(10, 20, kernel_size=5),

torch.nn.ReLU(),

torch.nn.MaxPool2d(kernel_size=2),

)

#全连接层

self.fc = torch.nn.Sequential(

torch.nn.Linear(320, 50),

torch.nn.Linear(50, 10),

)

def forward(self, x):

batch_size = x.size(0)

x = self.conv1(x) # 一层卷积层,一层池化层,一层激活层(图是先卷积后激活再池化,差别不大)

x = self.conv2(x) # 再来一次

x = x.view(batch_size, -1) # flatten 变成全连接网络需要的输入 (batch, 20,4,4) ==> (batch,320), -1 此处自动算出的是320

x = self.fc(x)

return x # 最后输出的是维度为10的,也就是(对应数学符号的0~9)

model = ConvNet()

可以在全连接层之前加上

#以默认0.5的概率对这一层进行dropout操作,防止过拟合

x=F.dropout (x,training=self.training)

神经网络在训练中具有强大的拟合数据的能力,因此常常会出现过拟合的情形,这会使得神经网络局限在见过的样本中。dropout正是一种防止过拟合的技术。简单来说,dropout就是指在深度网络的训练过程中,根据一定的概率随机将其中的一些神经元暂时丢弃。这样在每个批的训练中,我们都是在训练不同的神经网络,最后在测试的时候再使用全部的神经元,以此增强模型的泛化能力。

为了防止过拟合,dropout操作可以在训练阶段将一部分神经元随机关闭,而在校验和测试的时候再打开。

可以使用net.eval(),相当于把dropout关闭

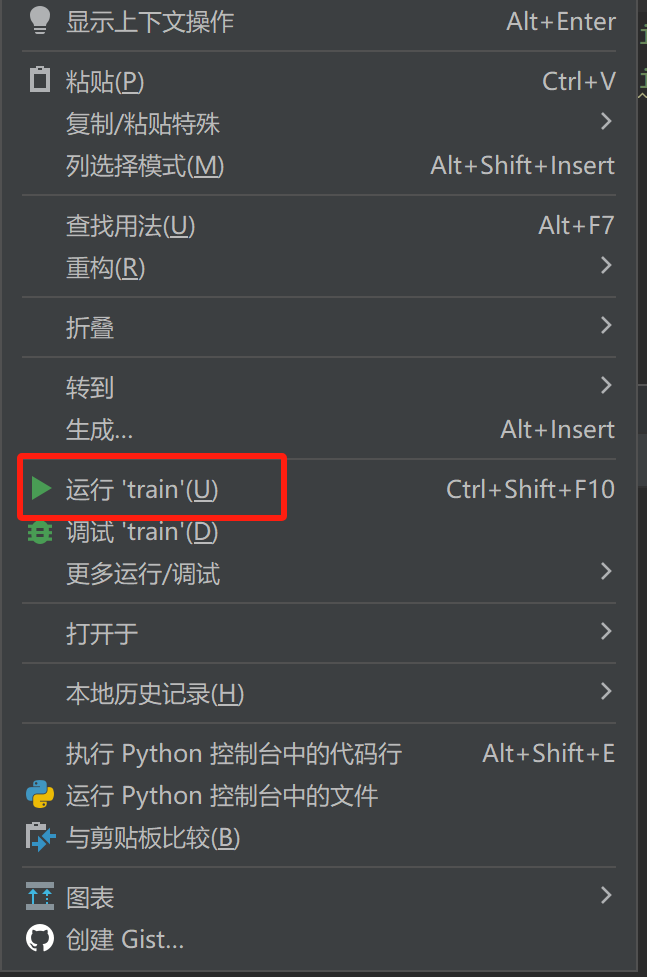

训练和测试

损失函数和优化器

criterion = torch.nn.CrossEntropyLoss() # 交叉熵损失

optimizer = torch.optim.SGD(model.parameters(), lr=learning_rate, momentum=momentum) # lr学习率,momentum冲量

enumerate起到构造一个枚举器的作用。在对train_loader做循环迭代时,enumerate会自动输出一个数字指示循环次数,并记录在batch_idx中,它就等于0,1,2,… train_loader每迭代一次,就会输出一对数据inputs和target,分别对应一个批中的手写数字图像及对应的标签。

def train(epoch):

running_loss = 0.0 # 这整个epoch的loss清零

running_total = 0

running_correct = 0

for batch_idx, data in enumerate(train_loader, 0):

inputs, target = data

optimizer.zero_grad() #清空梯度

# forward + backward + update

outputs = model(inputs) #神经网络完成一次前馈的计算过程,得到预测输出output

loss = criterion(outputs, target) #将output与标签target比较,计算误差

loss.backward() #反向传播

optimizer.step() #随机梯度下降

# 把运行中的loss累加起来,为了下面300次一除

running_loss += loss.item()

# 把运行中的准确率acc算出来

_, predicted = torch.max(outputs.data, dim=1)

running_total += inputs.shape[0]

running_correct += (predicted == target).sum().item()

if batch_idx % 300 == 299: # 不想要每一次都出loss,浪费时间,选择每300次出一个平均损失,和准确率

print('[%d, %5d]: loss: %.3f , acc: %.2f %%'

% (epoch + 1, batch_idx + 1, running_loss / 300, 100 * running_correct / running_total))

running_loss = 0.0 # 这小批300的loss清零

running_total = 0

running_correct = 0 # 这小批300的acc清零

测试

def test():

correct = 0

total = 0

with torch.no_grad(): # 测试集不用算梯度

for data in test_loader:

images, labels = data

outputs = model(images)

_, predicted = torch.max(outputs.data, dim=1) # dim = 1 列是第0个维度,行是第1个维度,沿着行(第1个维度)去找1.最大值和2.最大值的下标

total += labels.size(0) # 张量之间的运算

correct += (predicted == labels).sum().item()

acc = correct / total

print('[%d / %d]: Accuracy on test set: %.1f %% ' % (epoch+1, EPOCH, 100 * acc)) # 求测试的准确率,正确数/总数

return acc

总的代码

import torch

import numpy as np

from matplotlib import pyplot as plt

from torch.utils.data import DataLoader

from torchvision import transforms

from torchvision import datasets

import torch.nn.functional as F

"""

卷积运算 使用mnist数据集,和10-4,11类似的,只是这里:1.输出训练轮的acc 2.模型上使用torch.nn.Sequential

"""

# Super parameter ------------------------------------------------------------------------------------

batch_size = 64

learning_rate = 0.01

momentum = 0.5

EPOCH = 10

# Prepare dataset ------------------------------------------------------------------------------------

transform = transforms.Compose([transforms.ToTensor(), transforms.Normalize((0.1307,), (0.3081,))])

# softmax归一化指数函数(https://blog.csdn.net/lz_peter/article/details/84574716),其中0.1307是mean均值和0.3081是std标准差

train_dataset = datasets.MNIST(root='./data', train=True, transform=transform,download=True) # 本地没有就加上download=True

test_dataset = datasets.MNIST(root='./data', train=False, transform=transform,download=True) # train=True训练集,=False测试集

train_loader = DataLoader(train_dataset, batch_size=batch_size, shuffle=True)

test_loader = DataLoader(test_dataset, batch_size=batch_size, shuffle=False)

fig = plt.figure()

for i in range(12):

plt.subplot(3, 4, i+1)

plt.tight_layout()

plt.imshow(train_dataset.train_data[i], cmap='gray', interpolation='none')

plt.title("Labels: {}".format(train_dataset.train_labels[i]))

plt.xticks([])

plt.yticks([])

plt.show()

# 训练集乱序,测试集有序

# Design model using class ------------------------------------------------------------------------------

class ConvNet(torch.nn.Module):

def __init__(self):

super(ConvNet, self).__init__()

self.conv1 = torch.nn.Sequential(

torch.nn.Conv2d(1, 10, kernel_size=5),

torch.nn.ReLU(),

torch.nn.MaxPool2d(kernel_size=2),

)

self.conv2 = torch.nn.Sequential(

torch.nn.Conv2d(10, 20, kernel_size=5),

torch.nn.ReLU(),

torch.nn.MaxPool2d(kernel_size=2),

)

self.fc = torch.nn.Sequential(

torch.nn.Linear(320, 50),

torch.nn.Linear(50, 10),

)

def forward(self, x):

batch_size = x.size(0)

x = self.conv1(x) # 一层卷积层,一层池化层,一层激活层(图是先卷积后激活再池化,差别不大)

x = self.conv2(x) # 再来一次

x = x.view(batch_size, -1) # flatten 变成全连接网络需要的输入 (batch, 20,4,4) ==> (batch,320), -1 此处自动算出的是320

x = self.fc(x)

return x # 最后输出的是维度为10的,也就是(对应数学符号的0~9)

model = ConvNet()

# Construct loss and optimizer ------------------------------------------------------------------------------

criterion = torch.nn.CrossEntropyLoss() # 交叉熵损失

optimizer = torch.optim.SGD(model.parameters(), lr=learning_rate, momentum=momentum) # lr学习率,momentum冲量

# Train and Test CLASS --------------------------------------------------------------------------------------

# 把单独的一轮一环封装在函数类里

def train(epoch):

print("training ",epoch)

running_loss = 0.0 # 这整个epoch的loss清零

running_total = 0

running_correct = 0

for batch_idx, data in enumerate(train_loader, 0):

inputs, target = data

optimizer.zero_grad()

# forward + backward + update

outputs = model(inputs)

loss = criterion(outputs, target)

loss.backward()

optimizer.step()

# 把运行中的loss累加起来,为了下面300次一除

running_loss += loss.item()

# 把运行中的准确率acc算出来

_, predicted = torch.max(outputs.data, dim=1)

running_total += inputs.shape[0]

running_correct += (predicted == target).sum().item()

if batch_idx % 300 == 299: # 不想要每一次都出loss,浪费时间,选择每300次出一个平均损失,和准确率

print('[%d, %5d]: loss: %.3f , acc: %.2f %%'

% (epoch + 1, batch_idx + 1, running_loss / 300, 100 * running_correct / running_total))

running_loss = 0.0 # 这小批300的loss清零

running_total = 0

running_correct = 0 # 这小批300的acc清零

# torch.save(model.state_dict(), './model_Mnist.pth')

# torch.save(optimizer.state_dict(), './optimizer_Mnist.pth')

def test():

correct = 0

total = 0

with torch.no_grad(): # 测试集不用算梯度

for data in test_loader:

images, labels = data

outputs = model(images)

_, predicted = torch.max(outputs.data, dim=1) # dim = 1 列是第0个维度,行是第1个维度,沿着行(第1个维度)去找1.最大值和2.最大值的下标

total += labels.size(0) # 张量之间的比较运算

correct += (predicted == labels).sum().item()

acc = correct / total

print('[%d / %d]: Accuracy on test set: %.1f %% ' % (epoch+1, EPOCH, 100 * acc)) # 求测试的准确率,正确数/总数

return acc

# Start train and Test --------------------------------------------------------------------------------------

if __name__ == '__main__':

acc_list_test = []

for epoch in range(EPOCH):

train(epoch)

# if epoch % 10 == 9: #每训练10轮 测试1次

acc_test = test()

acc_list_test.append(acc_test)

plt.plot(acc_list_test)

plt.xlabel('Epoch')

plt.ylabel('Accuracy On TestSet')

plt.show()