本文ppt来自深蓝学院《机器人中的数值优化》

目录

1 wolfe conditions

2 cautious update

3 BFGS for nonconvex functions

1 wolfe conditions

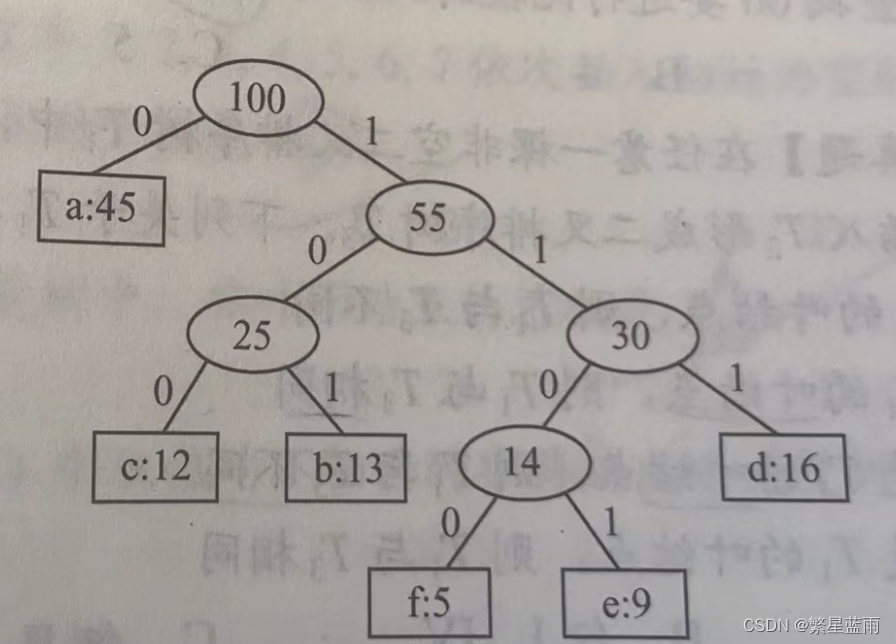

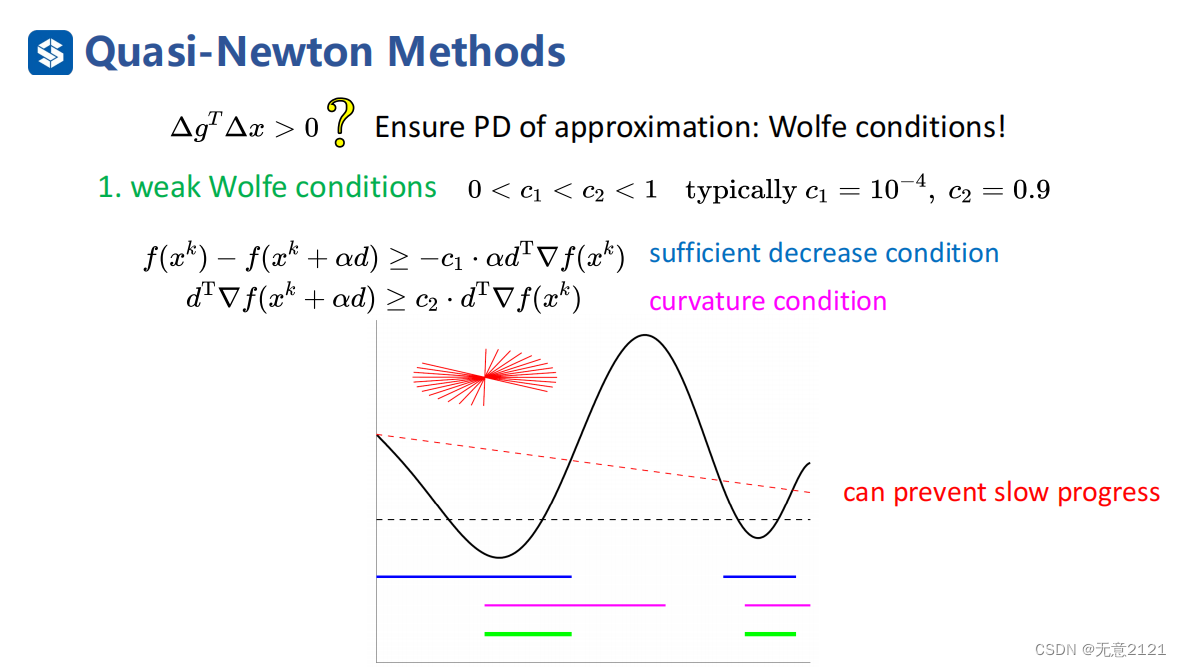

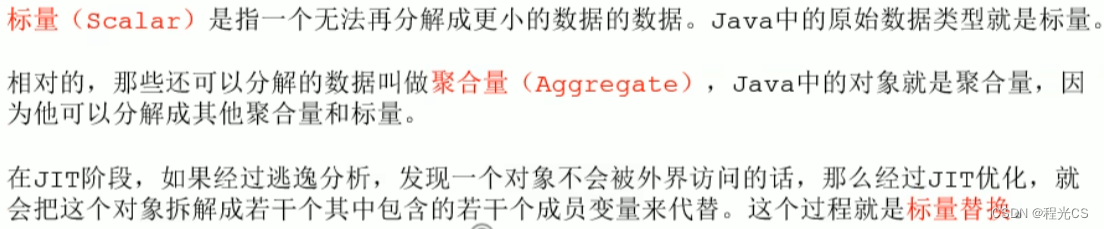

当我们需要搜索方向是下降方向时,一定要让近似hessian的矩阵正定,这就需要满足wolfe条件

首先需要满足充分下降条件,不熟悉Armijo condition的读者请参考(5条消息) 机器人中的数值优化之最速下降法_无意2121的博客-CSDN博客

这里是weak wolfe condition:只要迭代点所在斜率大于原始点斜率的C2倍就行

这两个条件合起来就能使迭代充分下降,并且能够杜绝往前迈一小步的现象

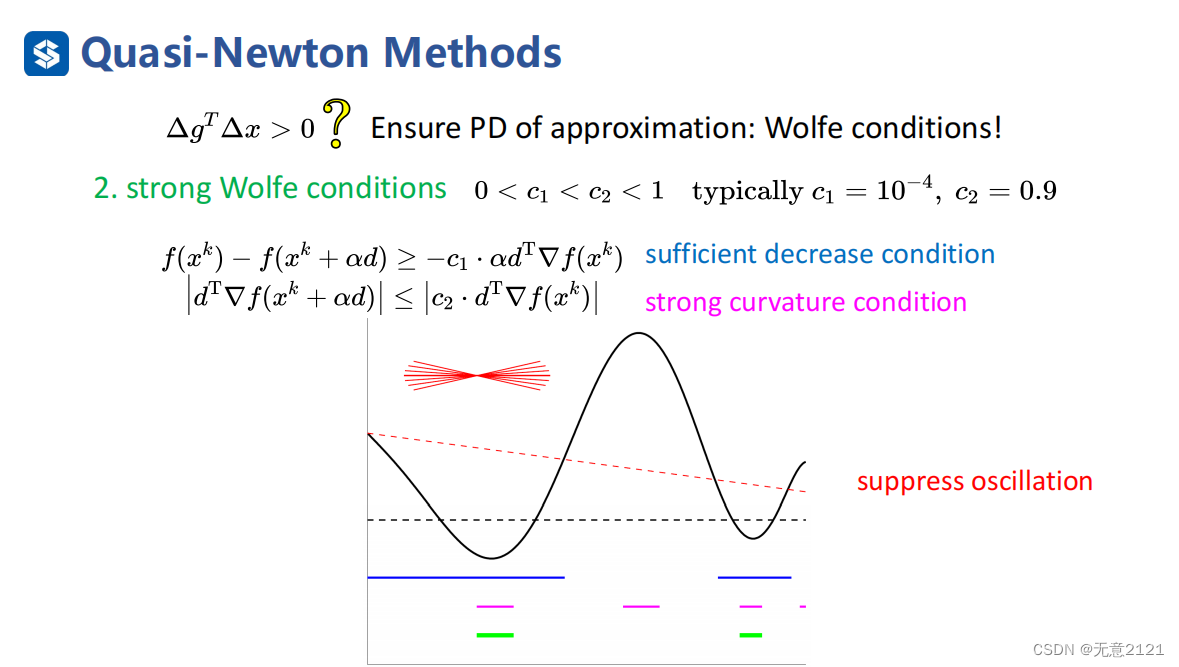

strong wolfe conditions:强与弱的区别在于多了一个绝对值,也就使得不会冲过头,减小了超调

strong wolfe conditions:强与弱的区别在于多了一个绝对值,也就使得不会冲过头,减小了超调

这是一个流程关系,最终的目的是通过 wolfe conditions 保证下降方向

2 cautious update

这是cautious update,一般在算法初期使用,当离最优解很近时没必要

这是cautious update,一般在算法初期使用,当离最优解很近时没必要

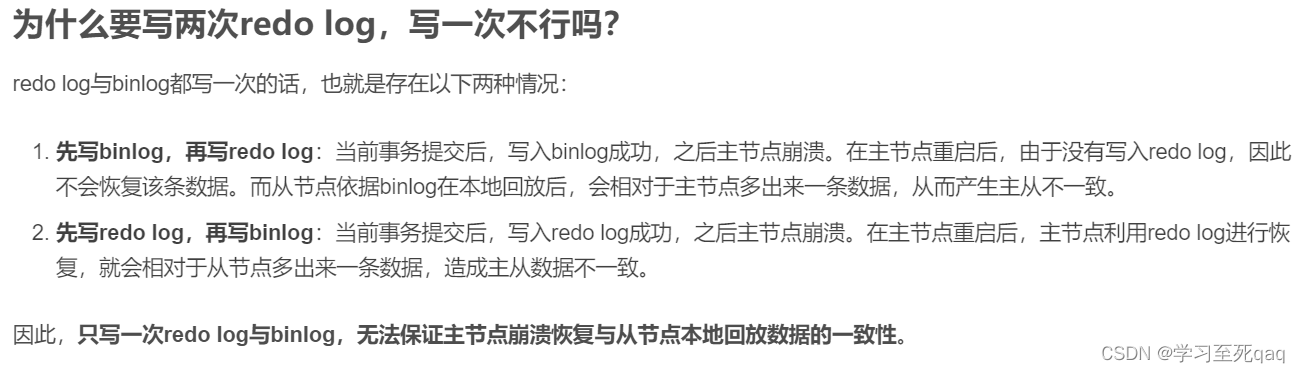

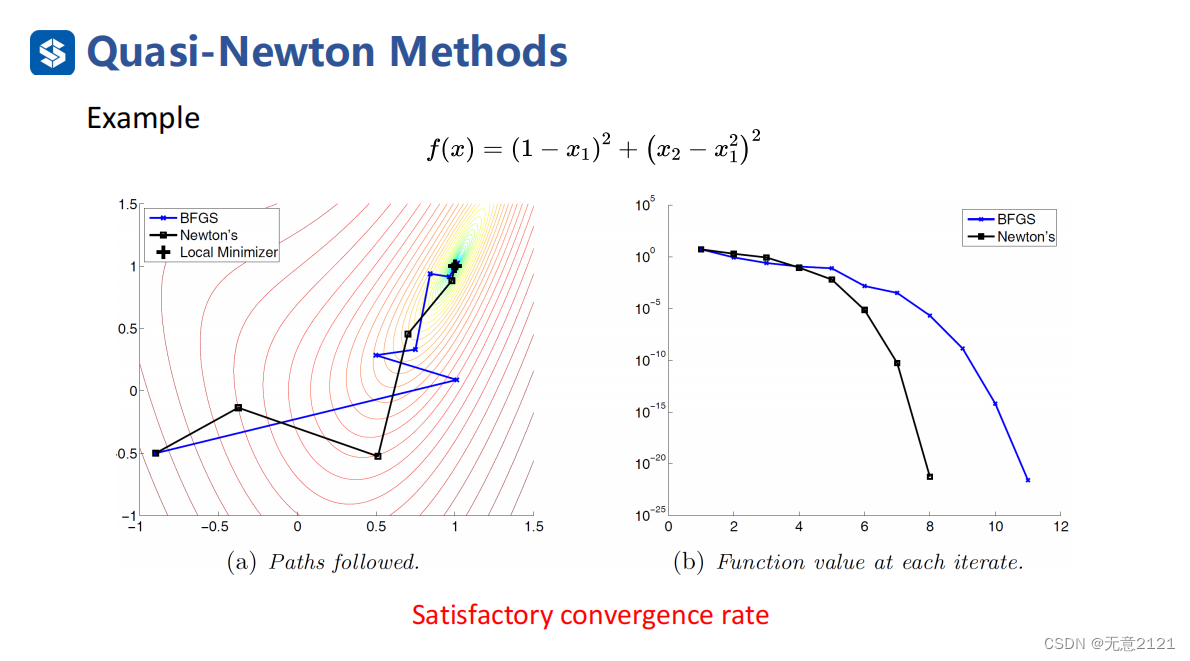

3 BFGS for nonconvex functions

于是针对非凸函数的BFGS算法框架就可以微调成这样

于是针对非凸函数的BFGS算法框架就可以微调成这样

![[数字媒体] PR视频剪辑之自定义音频、视频加速转场和特显停顿](https://img-blog.csdnimg.cn/3186ea5b5add4c70a41b460741e9e9ef.png#pic_center)