大模型本身提供的功能,类似于windows中的一个exe小工具,我们可以本机离线调用然后完成具体的功能,但是别的机器需要访问这个exe是不可行的。常见的做法就是用web容器封装起来,提供一个http接口,然后接口在后端调用这个exe来实现需求。同理我们需要一个web容器把大模型封装起来,然后通过API来提供AI服务。

这里对比本机离线调用和API服务调用,并通过FastAPI来实现AI的API服务化(LangChain也是通过这些框架提供的API服务)。

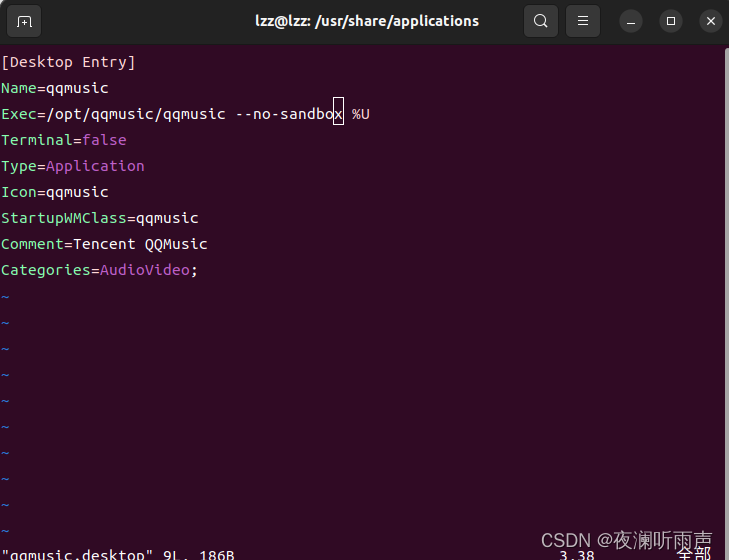

一、本机离线调用

看代码:

from transformers import AutoTokenizer, AutoModel

MODEL_PATH = 'c:\\ai\\llms\\chatglm3-6b'

TOKENIZER_PATH = 'c:\\ai\\llms\\chatglm3-6b'

# 第一步,获取大模型

tokenizer = AutoTokenizer.from_pretrained(TOKENIZER_PATH, trust_remote_code=True)

model = AutoModel.from_pretrained(MODEL_PATH, trust_remote_code=True, device_map="auto").eval()

# add .quantize(bits=4, device="cuda").cuda() before .eval() to use int4 model

# must use cuda to load int4 model

# 第二步,定义交互过程函数

def chat_handler(query: str):

response = model.chat(

tokenizer,

query,

history=None,

top_p=1,

max_new_tokens=1024,

temperature=0.1)

print(response, end="", flush=True)

# 第三步,实际交互

chat_handler('who are you')

实际调用过程是比较简单的,从大模型指定路径加载大模型,然后就可以通过调用chat实现交互。

看结果:

二、通过FastAPI来封装API服务

OpenAI提供了一个很好的接口规范,其余大模型以及大模型框架在提供接口时都做了类似的兼容处理,包括接口名、传参方式、参数格式等都仿照OpenAI的接口方式,这样可以大幅降低学习成本和模型切换的成本,当你想尝试不同的大模型时不需要做大量的改动。

接下来主要是通过FastAPI来封装我们的AI后台服务器。

2.1 构建服务端

2.1.1 使用工具

这里使用三个工具:

- FastAPI:FastAPI 是一个快速(高性能)的构建API的Web框架。

- Uvicorn:Uvicorn 是一款高效的ASGI服务器,主要是为了服务端的高效异步处理。

- Pydantic:Pydantic 是一款广泛使用的数据校验工具,主要是为了接口参数的规范和校验。

通过使用三个工具,可以快速部署一个后端服务,并且这个服务可以对输入参数进行方便的校验,同时实现高效异步调控。

在服务端安装三个工具:

> pip install fastapi uvicorn pydantic2.1.2 启动服务端的代码

from fastapi import FastAPI

from pydantic import BaseModel

import uvicorn

from transformers import AutoTokenizer, AutoModel, AutoModelForCausalLM

# 第一步,加载大模型

model_dir = 'c:\\ai\\llms\\chatglm3-6b'

tokenizer = AutoTokenizer.from_pretrained(model_dir, trust_remote_code=True)

model = AutoModel.from_pretrained(model_dir, device_map="cuda", trust_remote_code=True).eval()

# 第二步,创建FastAPI应用实例

app = FastAPI()

# 第三步,定义请求类型,与OpenAI API兼容

class ChatCompletionRequest(BaseModel):

model: str

messages: list

max_tokens: int = 1024

temperature: float = 0.1

# 第四步,定义交互函数

def chat_handle(messages: list, max_tokens: int, temperature: float):

query = messages[0]["content"]

response, history = model.chat(

tokenizer,

query=query,

history=None,

top_p=1,

max_new_tokens=max_tokens,

temperature=temperature)

print(response)

return response

# 第五步,定义路由和处理函数,与OpenAI的API兼容

@app.post("/v1/chat/completions")

async def create_chat_completion(request: ChatCompletionRequest):

# 调用自定义的文本生成函数

response = chat_handle(request.messages, request.max_tokens, request.temperature)

return {

"choices": [

{

"message": {

"content": response

}

}

],

"model": request.model

}

# 第六步,启动FastAPI应用,默认端口为8000

if __name__ == "__main__":

uvicorn.run(app, host="0.0.0.0", port=9999)

uvicorn.run(app, host="0.0.0.0", port=9999) 这里的host和port注意一下:

- host="0.0.0.0",表示可以远程访问此服务,host="127.0.0.1",表示只能本地访问。

- port=9999,默认端口为8000,也可以自定义一个端口。

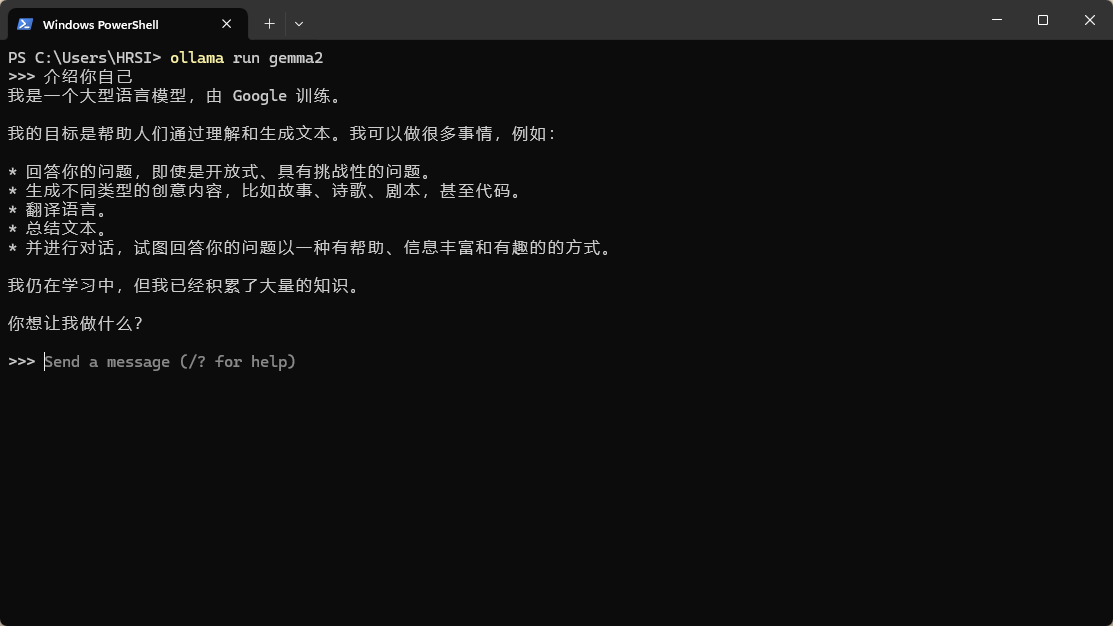

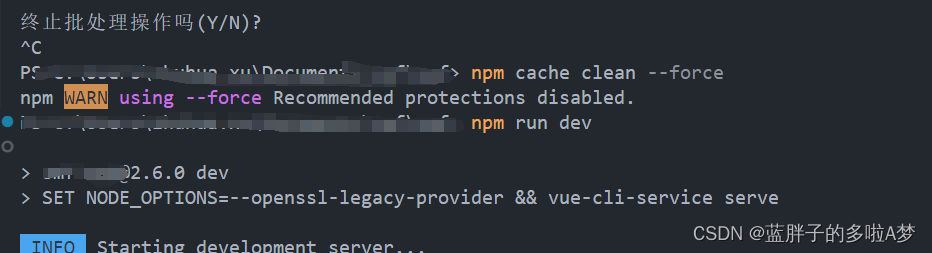

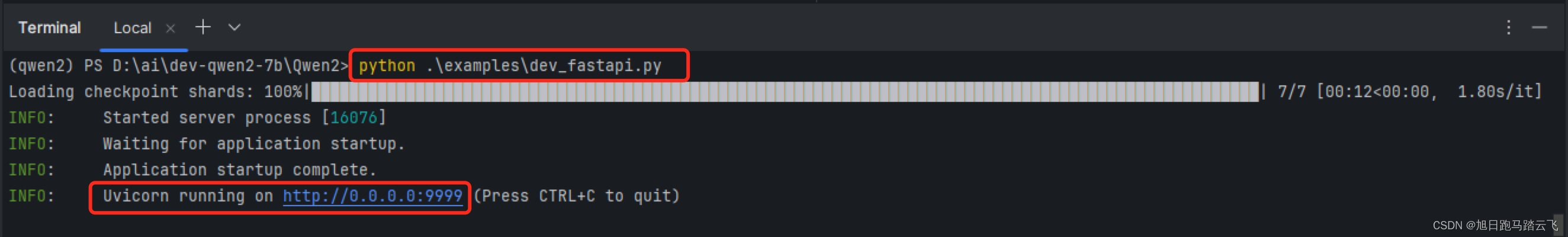

运行服务:

> python examples/dev_fastapi.py服务启动输出:

表示服务已经启动。

表示服务已经启动。

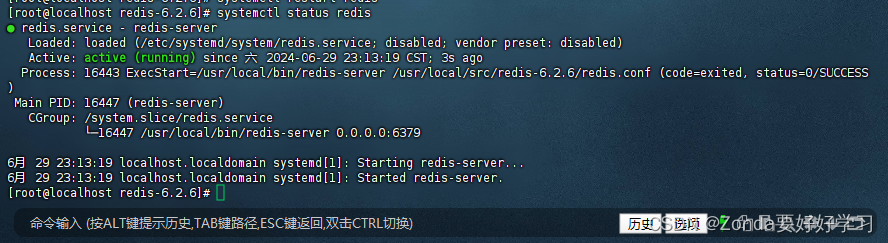

2.2 客户端调用

2.2.1 通过命令和工具调用

当服务端启动后,可以通过各种客户端工具来调用,比如curl,这里使用postman。

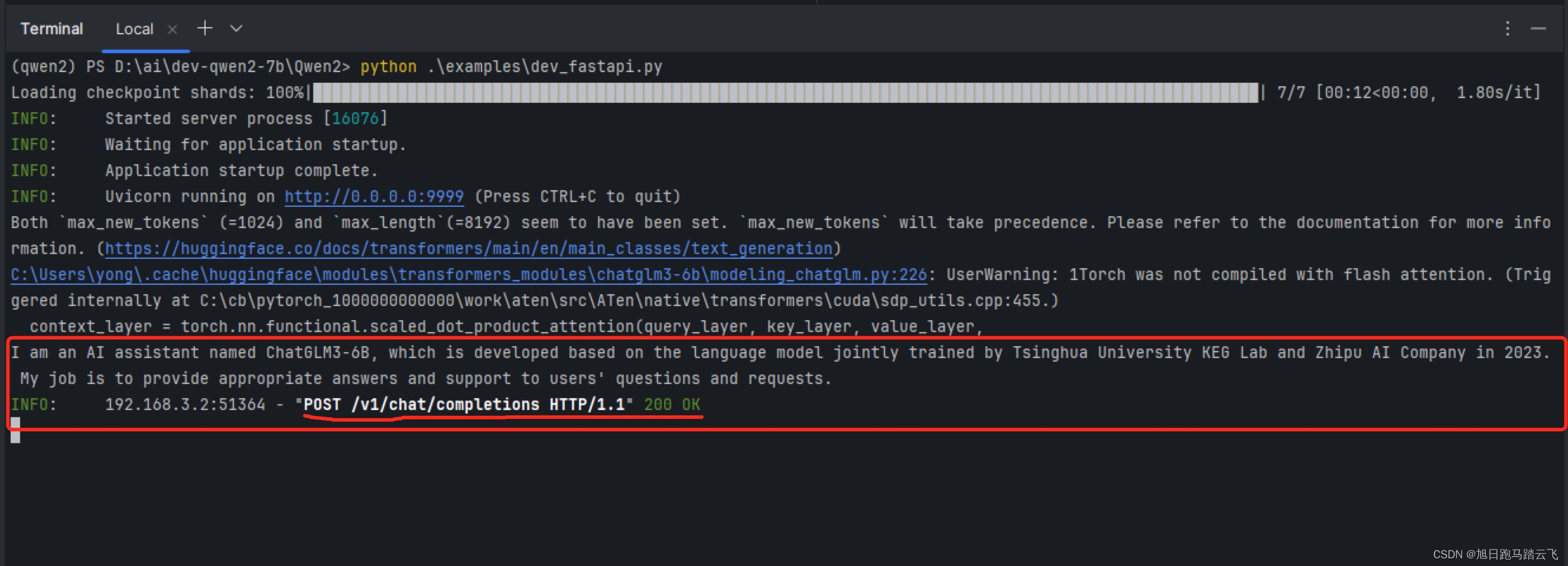

可以看到服务端正确返回了。

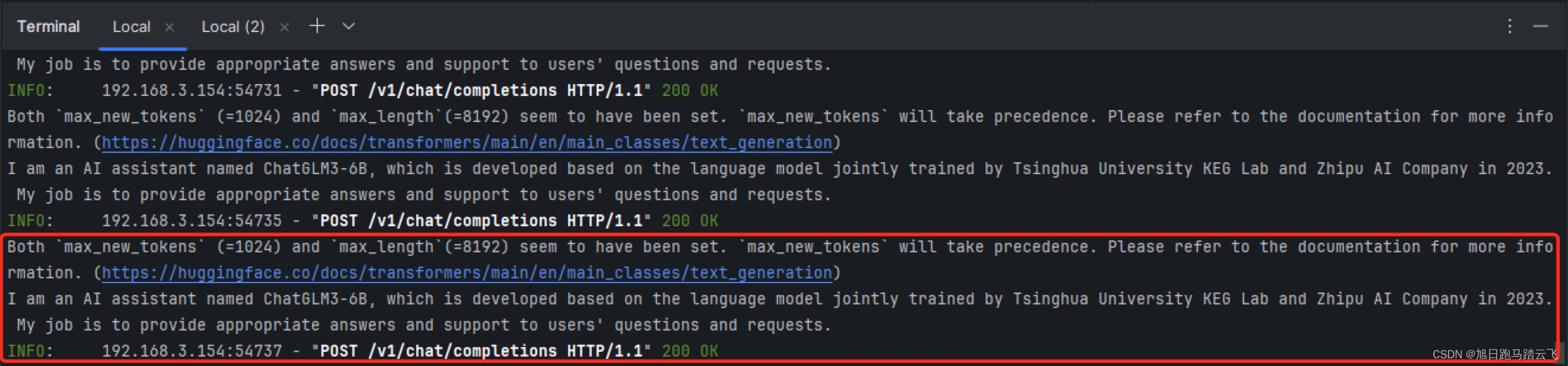

查看服务端输出:

2.2.2 通过代码调用

import requests

import json

# 定义请求的URL

url = "http://192.168.3.154:9999/v1/chat/completions"

# 定义请求头

headers = {'Content-Type': 'application/json'}

# 定义请求体

data = {

"model": "qwen2-7b",

"messages": [{"role": "user", "content": "who are you?"}],

"max_tokens": 1024,

"temperature": 0.5

}

# 将字典转换为JSON格式

data_json = json.dumps(data)

# 发送POST请求

response = requests.post(url, headers=headers, data=data_json)

# 检查响应状态码

if response.status_code == 200:

# 如果响应成功,打印响应内容

print(response.json())

else:

# 如果响应失败,打印错误信息

print(f"Error: {response.status_code}, {response.text}")

运行命令:

> python examples/dev_fastapi_client.py查看客户端调用结果:

查看服务端输出: