Can LLMs Produce Faithful Explanations For Fact-checking? Towards Faithful Explainable Fact-Checking via Multi-Agent Debate

论文地址:https://arxiv.org/abs/2402.07401![]() https://arxiv.org/abs/2402.07401

https://arxiv.org/abs/2402.07401

1.概述

在数字化时代,对于迅速传播的错误信息,其核实与明确的核实解释同等重要,这对于构建用户信任体系具有决定性意义。缺乏解释往往导致用户对事实核查结果的质疑与不信任。特别是在多跳事实核查中,解释生成的必要性更为凸显,因其涉及跨越多重证据片段的复杂推理过程,旨在准确评估声明的真实性。

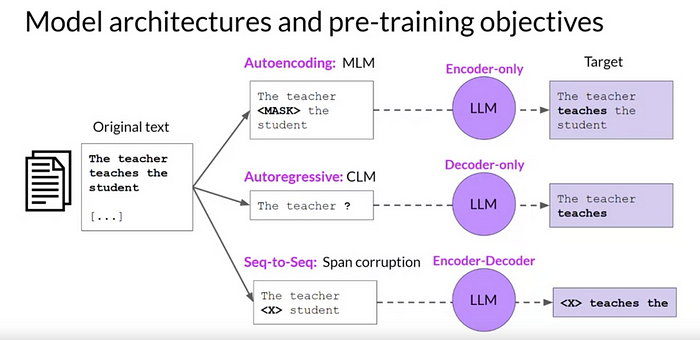

尽管大型语言模型(LLMs)在多样化文本生成方面展现出了显著能力,但其在生成可