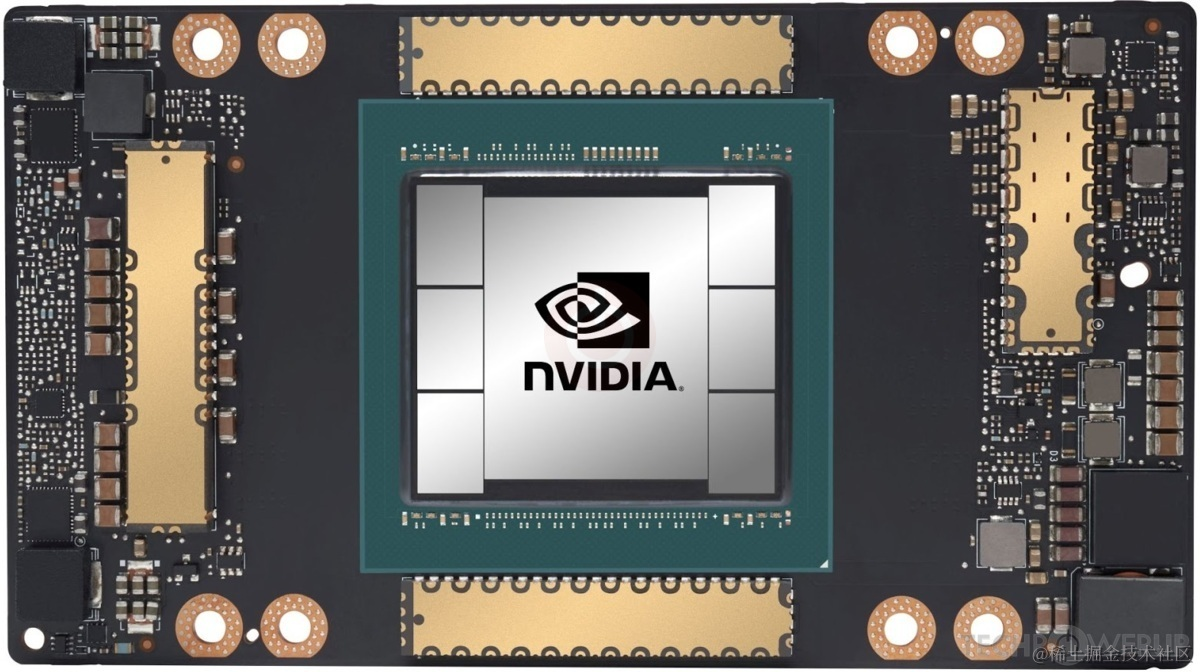

NVIDIA A100 显卡(GPU)是基于NVIDIA的Ampere架构设计的高性能计算和人工智能任务的处理器。

A100显卡主要由以下几种关键芯片和组件组成:

1. GPU芯片

- NVIDIA GA100 GPU:

- 核心组件,是整个显卡的核心处理单元。GA100芯片基于NVIDIA的Ampere架构,具有超过540亿个晶体管,采用台积电的7nm工艺制造。

1.1 CUDA核心

- 功能:用于并行计算任务的处理。

- 数量:每个GA100芯片拥有高达6912个CUDA核心。

- 特点:

- CUDA核心是GPU的基本计算单元,负责执行各种并行计算任务。

- CUDA核心通过执行SIMT(单指令多线程)架构的指令,能够高效地处理大规模数据并行计算。

- CUDA核心的高数量和高效设计使其非常适合于科学计算、图形渲染和机器学习等高性能计算任务。

1.2 Tensor核心

- 功能:专为AI和机器学习任务设计。

- 数量:每个GA100芯片有432个第三代Tensor核心。

- 特点:

- Tensor核心能够执行矩阵乘法和累加操作(矩阵乘法累加,简称GEMM),这是深度学习模型训练和推理的核心操作。

- 第三代Tensor核心支持TF32(TensorFloat-32)和FP64(64位浮点)等数据类型,可以在保证计算精度的同时提高计算速度。

- Tensor核心能够大幅加速深度学习的训练和推理过程,提高AI模型的效率和性能。

1.3 RT核心

- 功能:负责光线追踪计算。

- 特点:

- RT核心(Ray Tracing核心)专为实时光线追踪设计,能够模拟光线的物理行为,从而生成逼真的光影效果。

- RT核心支持BVH(包围体层次结构)加速结构,用于快速计算光线与场景中的物体的交互。

- 光线追踪技术可以生成高质量的图像和视频,提升图形渲染的真实性和视觉效果。

- RT核心使得GA100芯片在高性能图形处理和实时渲染应用中表现出色。

2. 显存芯片

- HBM2e显存:

- 功能:高带宽显存(High Bandwidth Memory),用于提供高数据传输速率和低延迟。

- 容量:A100通常配置40GB或80GB的HBM2e显存。

- 特点:

- HBM2e显存以堆叠形式集成在GPU附近,能够提供高达1.6 TB/s的带宽,大幅提升数据传输效率。

- HBM2e显存的高带宽和低延迟使其非常适合处理大规模数据集和复杂计算任务,如深度学习和高性能计算。

- HBM2e显存的紧凑设计有助于减少显卡的物理尺寸,提高整体性能和能效。

3. 电源管理芯片

- PMIC(Power Management Integrated Circuit):

- 电源管理芯片负责为GPU和其他组件提供稳定的电源供应,管理功耗并确保显卡在各种工作负载下高效运行。PMIC可以根据工作负载动态调节电源,以优化功耗和性能。

4. 接口和通信芯片

- PCIe接口芯片:

- 用于显卡与主板之间的数据传输,通常支持PCIe 4.0标准。PCIe 4.0提供更高的数据传输速率,达到了16 GT/s(每通道2 GB/s),使得显卡可以更快地与主机系统通信。

5. 控制和管理芯片

- 控制器芯片:

- 负责管理显卡的各种控制信号和通信协议。控制器芯片处理显卡与主板及其他组件之间的通信,确保各部分协同工作,并提供必要的管理功能。

6. 散热和监控组件

- 温度传感器和监控芯片:

- 用于监测显卡的温度,以确保其在安全的温度范围内运行。温度传感器可以实时监测显卡的热状态,并通过调整风扇速度或其他冷却措施来保持显卡的稳定运行。

7. 电源电路和VRM模块

- VRM(Voltage Regulator Module):

- 电压调节模块,用于为GPU和其他组件提供稳定的电压。VRM模块通过调节输入电压,确保GPU和其他组件获得稳定的电源供应,从而保证显卡的稳定和高效运行。

8. 其他辅助芯片

- 时钟管理芯片:

- 负责显卡内部时钟信号的生成和管理。时钟管理芯片确保显卡各部分同步工作,提供稳定的时钟信号,以保证显卡的性能和稳定性。

- BIOS芯片:

- 存储显卡的基本输入输出系统,用于初始化和配置显卡。BIOS芯片包含显卡的固件,通过与系统BIOS协同工作,初始化显卡并配置其工作参数,确保显卡在启动时正常工作。

NVIDIA A100显卡集成了多个关键芯片和组件,包括GPU芯片、显存芯片、电源管理芯片、接口和通信芯片、控制和管理芯片、散热和监控组件、电源电路和VRM模块以及其他辅助芯片。这些芯片共同工作,提供高性能计算和人工智能任务的强大处理能力。