- 💂 个人网站:【 摸鱼游戏】【神级代码资源网站】【导航大全】

- 🤟 一站式轻松构建小程序、Web网站、移动应用:👉注册地址

- 🤟 基于Web端打造的:👉轻量化工具创作平台

- 💅 想寻找共同学习交流,摸鱼划水的小伙伴,请点击【全栈技术交流群】

项目背景

本文档详细介绍了一个网络爬虫项目的准备和实现过程。该项目的目标是从百度图片搜索中获取图片链接并下载图片。此类爬虫项目通常用于收集大量的图片数据,以便用于训练各种人工智能模型,特别是计算机视觉模型。计算机视觉领域的研究需要大量的图像数据来训练和测试模型,以便实现图像分类、对象检测、图像生成等功能。

一、项目准备

环境配置

在开始编写爬虫之前,确保已经完成以下环境配置:

Python安装: 确保已安装Python 3.x版本。Python是一种功能强大且易于学习的编程语言,适合于各种编程任务,包括网络爬虫开发。

需要的库: Python有一个庞大的第三方库生态系统,我们将使用几个核心库来开发我们的爬虫:

- requests: 用于发送HTTP请求和处理响应。

- json: 用于处理JSON格式的数据。

- urllib: 提供了在网络上获取数据的一些功能,我们主要用来进行URL编码。

- os: 提供了与操作系统交互的功能,用于创建文件夹等文件操作。

- time: 提供了时间相关的功能,例如休眠程序以及计时等。

可以使用以下命令通过pip安装这些库:

pip install requests

如果你使用的是Anaconda等集成环境,可以使用conda命令:

conda install requests

这些库将帮助我们处理HTTP请求、解析和存储数据,以及进行一些基本的系统操作。

二、爬虫设计与实现

爬虫设计思路

目标网站分析

本爬虫目标是从百度图片搜索获取图片链接并下载。百度图片搜索返回的结果是JSON格式的数据,其中包含了图片的缩略图链接。

数据获取流程

- 构建百度图片搜索的URL,通过GET请求获取JSON数据。

- 解析JSON数据,提取缩略图链接。

- 下载图片到本地存储。

代码实现

初始化爬虫类(BaiduImageSpider)

import requests

import json

from urllib import parse

import os

import time

class BaiduImageSpider(object):

def __init__(self):

self.json_count = 0 # 请求到的json文件数量(一个json文件包含30个图像文件)

self.url = 'https://image.baidu.com/search/acjson?tn=resultjson_com&logid=5179920884740494226&ipn=rj&ct' \

'=201326592&is=&fp=result&queryWord={' \

'}&cl=2&lm=-1&ie=utf-8&oe=utf-8&adpicid=&st=-1&z=&ic=0&hd=&latest=©right=&word={' \

'}&s=&se=&tab=&width=&height=&face=0&istype=2&qc=&nc=1&fr=&expermode=&nojc=&pn={' \

'}&rn=30&gsm=1e&1635054081427= '

self.directory = r"C:\价值一个亿\python-mini-projects\projects\baidutupian\{}" # 存储目录 这里需要修改为自己希望保存的目录 {}不要丢

self.header = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.3',

'Accept-Language': 'en-US,en;q=0.9',

'Referer': 'https://image.baidu.com'

}

创建存储文件夹

# 创建存储文件夹

def create_directory(self, name):

self.directory = self.directory.format(name)

# 如果目录不存在则创建

if not os.path.exists(self.directory):

os.makedirs(self.directory)

self.directory += r'\{}'

获取图像链接

# 获取图像链接

def get_image_link(self, url):

list_image_link = []

strhtml = requests.get(url, headers=self.header) # Get方式获取网页数据

print(f"Response content for URL {url}:\n{strhtml.text}\n")

try:

jsonInfo = json.loads(strhtml.text)

except json.JSONDecodeError:

print("Error decoding JSON")

return list_image_link

if 'data' in jsonInfo:

for index in range(len(jsonInfo['data'])):

if 'thumbURL' in jsonInfo['data'][index]:

list_image_link.append(jsonInfo['data'][index]['thumbURL'])

else:

print("No 'data' key in the response JSON")

return list_image_link

下载图片

# 下载图片

def save_image(self, img_link, filename):

try:

res = requests.get(img_link, headers=self.header)

if res.status_code == 404:

print(f"图片 {img_link} 下载出错")

else:

with open(filename, "wb") as f:

f.write(res.content)

print("存储路径:" + filename)

except requests.RequestException as e:

print(f"Error downloading image: {e}")

主运行函数

# 入口函数

def run(self):

searchName = input("查询内容:")

searchName_parse = parse.quote(searchName) # 编码

self.create_directory(searchName)

pic_number = 0 # 图像数量

for index in range(self.json_count):

pn = index * 30

request_url = self.url.format(searchName_parse, searchName_parse, str(pn))

list_image_link = self.get_image_link(request_url)

for link in list_image_link:

pic_number += 1

self.save_image(link, self.directory.format(str(pic_number) + '.jpg'))

time.sleep(1) # 休眠1秒,防止封ip

print(searchName + "----图像下载完成--------->")

三、代码详解

__init__ 方法

init 方法用于初始化爬虫类的属性。在这个方法中,我们定义了以下几个重要的属性:

- json_count: 用于指定要请求的JSON文件数量,每个JSON文件包含多个图像条目。

- url: 百度图片搜索的API URL,包含了多个参数用于构造请求。

- directory: 存储下载图片的目录路径。这个路径在 create_directory 方法中被初始化和修改。

- header: 请求头信息,包括用户代理、接受语言和引用页,用于模拟浏览器发送请求。

create_directory 方法

create_directory 方法根据提供的名称创建存储图片的文件夹。具体步骤如下:

- 将 directory 属性格式化为指定的存储目录路径。

- 使用 os.makedirs() 方法创建多层目录,如果目录不存在的话。

- 将 directory 属性更新为包含图片文件名格式的路径,以便后续保存图片时直接在该路径下生成文件。

get_image_link 方法

get_image_link 方法负责发送GET请求获取百度图片搜索返回的JSON数据,并解析数据提取图片的缩略图链接。具体步骤如下:

- 使用 requests.get() 方法发送GET请求,获取包含图片信息的JSON数据。

- 尝试解析返回的JSON数据,如果解析失败则捕获 json.JSONDecodeError 异常并打印错误信息。

- 如果JSON数据中包含 data 键,遍历数据条目并提取每个条目中的 thumbURL(缩略图链接),将其添加到 list_image_link 列表中。

- 如果JSON数据中不存在 data 键,则打印相应的错误信息并返回空列表。

save_image 方法

save_image 方法用于下载图片到本地存储。具体步骤如下:

- 使用 requests.get() 方法发送GET请求,获取包含图片数据的响应。

- 检查响应状态码,如果返回的状态码是404,则打印错误信息表示图片下载失败。

- 如果响应正常,将图片数据写入以指定文件名 filename 打开的二进制文件中(使用 “wb” 模式)。

- 打印存储图片的路径信息,表示图片已成功保存到本地。

run 方法

run 方法是爬虫的主运行函数,负责处理用户输入的查询内容,循环获取图片链接并下载到本地存储。具体步骤如下:

- 提示用户输入要查询的内容,并对用户输入的内容进行URL编码,以便构造百度图片搜索的查询URL。

- 调用 create_directory 方法创建存储图片的目录,目录名与用户输入的查询内容相关联。

- 初始化 pic_number 变量,用于记录已下载的图片数量。

- 使用循环从0到 json_count (设定的请求的JSON文件数量)遍历,构造不同页数的百度图片搜索URL,发送请求并获取图片链接。

- 遍历获取的图片链接列表,逐个下载图片到本地存储,并在每次下载后休眠1秒以防止IP被封禁。

- 下载完成后打印提示信息,指示所有图片已成功下载并存储到指定目录中。

以上详细解释了每个方法在爬虫实现中的作用和具体实现步骤,确保了爬虫能够有效地从百度图片搜索中获取指定数量的图片并保存到本地。

四、亮数据代理IP的使用

为什么需要代理IP

在爬取网站数据时,频繁的请求会被网站识别为异常流量,可能导致IP被封禁。使用代理IP可以隐藏真实IP,降低被封禁的风险。

如何在爬虫中配置代理IP

可以使用第三方代理IP服务商提供的代理IP池,例如requests库中的proxies参数。这里我采用的是亮数据IP代理服务。

修改代码以支持代理IP

在请求中添加代理IP,例如:

proxies = {

'http': 'http://user:password@proxy_ip:port',

'https': 'https://user:password@proxy_ip:port',

}

requests.get(url, headers=self.header, proxies=proxies)

五、完整代码及运行结果

以下是完整的Python代码实现:

# -*- coding:utf8 -*-

import requests

import json

from urllib import parse

import os

import time

class BaiduImageSpider(object):

def __init__(self):

self.json_count = 0 # 请求到的json文件数量(一个json文件包含30个图像文件)

self.url = 'https://image.baidu.com/search/acjson?tn=resultjson_com&logid=5179920884740494226&ipn=rj&ct' \

'=201326592&is=&fp=result&queryWord={' \

'}&cl=2&lm=-1&ie=utf-8&oe=utf-8&adpicid=&st=-1&z=&ic=0&hd=&latest=©right=&word={' \

'}&s=&se=&tab=&width=&height=&face=0&istype=2&qc=&nc=1&fr=&expermode=&nojc=&pn={' \

'}&rn=30&gsm=1e&1635054081427= '

self.directory = r"C:\价值一个亿\python-mini-projects\projects\baidutupian\{}" # 存储目录 这里需要修改为自己希望保存的目录 {}不要丢

self.header = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.3',

'Accept-Language': 'en-US,en;q=0.9',

'Referer': 'https://image.baidu.com'

}

# 创建存储文件夹

def create_directory(self, name):

self.directory = self.directory.format(name)

# 如果目录不存在则创建

if not os.path.exists(self.directory):

os.makedirs(self.directory)

self.directory += r'\{}'

# 获取图像链接

def get_image_link(self, url):

list_image_link =

[]

strhtml = requests.get(url, headers=self.header) # Get方式获取网页数据

print(f"Response content for URL {url}:\n{strhtml.text}\n")

try:

jsonInfo = json.loads(strhtml.text)

except json.JSONDecodeError:

print("Error decoding JSON")

return list_image_link

if 'data' in jsonInfo:

for index in range(len(jsonInfo['data'])):

if 'thumbURL' in jsonInfo['data'][index]:

list_image_link.append(jsonInfo['data'][index]['thumbURL'])

else:

print("No 'data' key in the response JSON")

return list_image_link

# 下载图片

def save_image(self, img_link, filename):

try:

res = requests.get(img_link, headers=self.header)

if res.status_code == 404:

print(f"图片 {img_link} 下载出错")

else:

with open(filename, "wb") as f:

f.write(res.content)

print("存储路径:" + filename)

except requests.RequestException as e:

print(f"Error downloading image: {e}")

# 入口函数

def run(self):

searchName = input("查询内容:")

searchName_parse = parse.quote(searchName) # 编码

self.create_directory(searchName)

pic_number = 0 # 图像数量

for index in range(self.json_count):

pn = index * 30

request_url = self.url.format(searchName_parse, searchName_parse, str(pn))

list_image_link = self.get_image_link(request_url)

for link in list_image_link:

pic_number += 1

self.save_image(link, self.directory.format(str(pic_number) + '.jpg'))

time.sleep(1) # 休眠1秒,防止封ip

print(searchName + "----图像下载完成--------->")

if __name__ == '__main__':

spider = BaiduImageSpider()

spider.json_count = 10 # 定义下载10组图像,也就是三百张

spider.run()

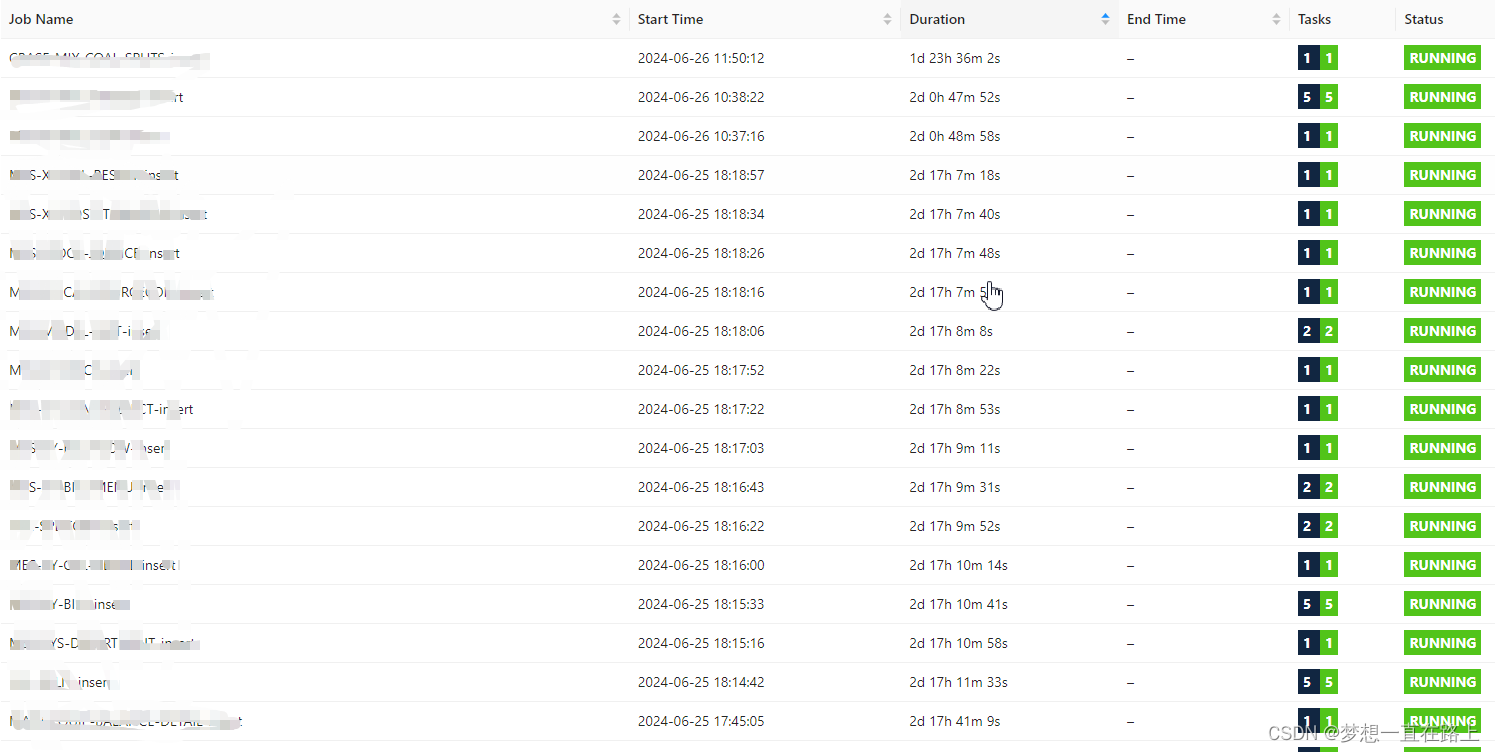

演示爬虫的运行

运行以上代码,按照提示输入查询内容,爬虫将开始从百度图片搜索下载相关图片。

下载的图片展示

六、总结

本文详细介绍了如何使用Python编写一个简单的爬虫,用于从百度图片搜索下载图片。通过分析目标网站、设计爬虫流程、实现代码以及配置代理IP,使得爬虫能够有效地获取图片数据。通过本项目,读者可以学习到基本的爬虫原理和实现方法,同时也了解到了如何处理异常情况和优化爬虫效率的方法。