1.环境安装

# 设置pip全局镜像 (加速下载)

pip config set global.index-url https://mirrors.aliyun.com/pypi/simple/

# 安装ms-swift

pip install 'ms-swift[llm]' -U

# 环境对齐 (通常不需要运行. 如果你运行错误, 可以跑下面的代码, 仓库使用最新环境测试)

pip install -r requirements/framework.txt -U

pip install -r requirements/llm.txt -U

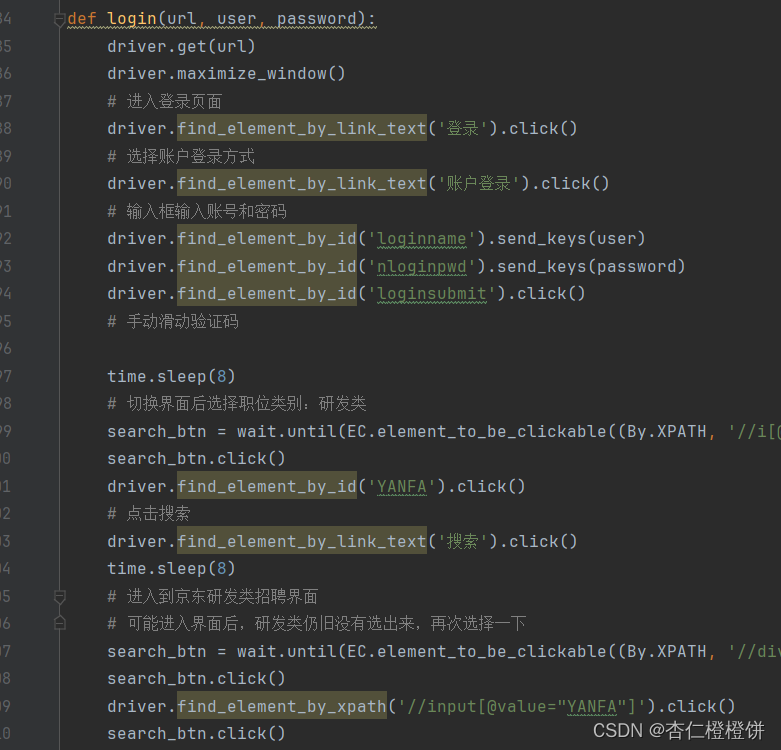

2.微调前推理

使用python:

import os

os.environ['CUDA_VISIBLE_DEVICES'] = '0'

from swift.llm import ModelType, InferArguments, infer_main

infer_args = InferArguments(model_type=ModelType.qwen1half_4b_chat)

infer_main(infer_args)

"""

<<< 你是谁?

我是来自阿里云的大规模语言模型,我叫通义千问。

--------------------------------------------------

<<< what's your name?

I am Qwen, a large language model from Alibaba Cloud.

--------------------------------------------------

<<< 你是谁研发的?

我是阿里云自主研发的超大规模语言模型。

--------------------------------------------------

<<< 浙江的省会在哪?

浙江的省会是杭州。

--------------------------------------------------

<<< 这有什么好吃的?

浙江的美食非常丰富,比如杭州的西湖醋鱼、东坡肉、龙井虾仁、宋嫂鱼羹等都是著名的浙江美食。此外,浙江还有许多小吃,比如油条、烧麦、汤圆、粽子等。

--------------------------------------------------

<<< 晚上睡不着觉怎么办

晚上睡不着觉可以尝试以下几种方法:

1. 放松身心:可以尝试做一些放松身心的活动,比如听音乐、做瑜伽、冥想等。

2. 保持规律作息:尽量保持每天的作息规律,避免熬夜。

3. 避免刺激性食物:避免吃辛辣、油腻、咖啡因等刺激性食物,这些食物可能会刺激神经系统,导致失眠。

4. 适当运动:适当的运动可以帮助身体放松,有助于睡眠。

5. 睡前喝牛奶:牛奶中含有色氨酸,可以帮助身体产生褪黑激素,有助于睡眠。

"""

使用CLI:

CUDA_VISIBLE_DEVICES=0 swift infer --model_type qwen1half-4b-chat

3.微调

提示: 因为自我认知训练涉及到知识编辑, 建议对MLP加lora_target_modules. 你可以通过指定--lora_target_modules ALL在所有的linear层(包括qkvo以及mlp)加lora. 这通常是效果最好的.

使用python:

# Experimental environment: A10, 3090, V100, ...

# 22GB GPU memory

import os

os.environ['CUDA_VISIBLE_DEVICES'] = '0'

from swift.llm import DatasetName, ModelType, SftArguments, sft_main

sft_args = SftArguments(

model_type=ModelType.qwen1half_4b_chat,

dataset=[f'{DatasetName.alpaca_zh}#500', f'{DatasetName.alpaca_en}#500',

f'{DatasetName.self_cognition}#500'],

logging_steps=5,

max_length=2048,

learning_rate=5e-5,

warmup_ratio=0.4,

output_dir='output',

lora_target_modules=['ALL'],

model_name=['小黄', 'Xiao Huang'],

model_author=['魔搭', 'ModelScope'])

output = sft_main(sft_args)

best_model_checkpoint = output['best_model_checkpoint']

print(f'best_model_checkpoint: {best_model_checkpoint}')

"""Out[0]

{'loss': 1.36837471, 'acc': 0.6827153, 'grad_norm': 2.69893861, 'learning_rate': 2.7e-06, 'epoch': 0.01, 'global_step': 1}

{'loss': 1.64843678, 'acc': 0.62217778, 'grad_norm': 1.68335974, 'learning_rate': 1.351e-05, 'epoch': 0.05, 'global_step': 5}

{'loss': 1.81131458, 'acc': 0.59357905, 'grad_norm': 1.78167629, 'learning_rate': 2.703e-05, 'epoch': 0.11, 'global_step': 10}

{'loss': 1.70607147, 'acc': 0.60849266, 'grad_norm': 1.47256434, 'learning_rate': 4.054e-05, 'epoch': 0.16, 'global_step': 15}

{'loss': 1.51096973, 'acc': 0.63005199, 'grad_norm': 0.91772562, 'learning_rate': 5.405e-05, 'epoch': 0.22, 'global_step': 20}

{'loss': 1.5484211, 'acc': 0.62795267, 'grad_norm': 1.11152458, 'learning_rate': 6.757e-05, 'epoch': 0.27, 'global_step': 25}

{'loss': 1.43836861, 'acc': 0.64279995, 'grad_norm': 1.1565901, 'learning_rate': 8.108e-05, 'epoch': 0.33, 'global_step': 30}

{'loss': 1.38720503, 'acc': 0.64892483, 'grad_norm': 0.98939317, 'learning_rate': 9.459e-05, 'epoch': 0.38, 'global_step': 35}

{'loss': 1.28600607, 'acc': 0.67057638, 'grad_norm': 2.26390719, 'learning_rate': 9.455e-05, 'epoch': 0.43, 'global_step': 40}

{'loss': 1.2084446, 'acc': 0.68125477, 'grad_norm': 1.39036703, 'learning_rate': 8.545e-05, 'epoch': 0.49, 'global_step': 45}

{'loss': 1.39412193, 'acc': 0.64913111, 'grad_norm': 0.6860683, 'learning_rate': 7.636e-05, 'epoch': 0.54, 'global_step': 50}

Train: 54%|███████████████████████████████████████████████▊ | 50/92 [02:57<02:28, 3.53s/it]

{'eval_loss': 1.54409802, 'eval_acc': 0.5955491, 'eval_runtime': 0.5527, 'eval_samples_per_second': 18.092, 'eval_steps_per_second': 9.046, 'epoch': 0.54, 'global_step': 50}

Val: 100%|████████████████████████████████████████████████████████████████████████████████████████████| 5/5 [00:00<00:00, 13.27it/s]

[INFO:swift] Saving model checkpoint to /xxx/output/qwen1half-4b-chat/v0-20240225-194502/checkpoint-50

{'loss': 1.1771349, 'acc': 0.67886224, 'grad_norm': 1.06721985, 'learning_rate': 6.727e-05, 'epoch': 0.6, 'global_step': 55}

{'loss': 1.25694866, 'acc': 0.67727785, 'grad_norm': 1.27860904, 'learning_rate': 5.818e-05, 'epoch': 0.65, 'global_step': 60}

{'loss': 1.18360176, 'acc': 0.70474091, 'grad_norm': 0.71210742, 'learning_rate': 4.909e-05, 'epoch': 0.71, 'global_step': 65}

{'loss': 1.08381062, 'acc': 0.71071234, 'grad_norm': 1.32174027, 'learning_rate': 4e-05, 'epoch': 0.76, 'global_step': 70}

{'loss': 1.23212566, 'acc': 0.68333907, 'grad_norm': 0.87663323, 'learning_rate': 3.091e-05, 'epoch': 0.82, 'global_step': 75}

{'loss': 1.2107378, 'acc': 0.70353975, 'grad_norm': 0.78985584, 'learning_rate': 2.182e-05, 'epoch': 0.87, 'global_step': 80}

{'loss': 1.32458553, 'acc': 0.6687315, 'grad_norm': 1.25317574, 'learning_rate': 1.273e-05, 'epoch': 0.92, 'global_step': 85}

{'loss': 1.28211155, 'acc': 0.67041779, 'grad_norm': 1.10373855, 'learning_rate': 3.64e-06, 'epoch': 0.98, 'global_step': 90}

Train: 100%|████████████████████████████████████████████████████████████████████████████████████████| 92/92 [05:31<00:00, 3.60s/it]

{'eval_loss': 1.53501475, 'eval_acc': 0.59796807, 'eval_runtime': 0.521, 'eval_samples_per_second': 19.193, 'eval_steps_per_second': 9.597, 'epoch': 1.0, 'global_step': 92}

Val: 100%|████████████████████████████████████████████████████████████████████████████████████████████| 5/5 [00:00<00:00, 13.74it/s]

[INFO:swift] Saving model checkpoint to /xxx/output/qwen1half-4b-chat/v0-20240225-194502/checkpoint-92

"""

使用CLI (单卡):

# Experimental environment: A10, 3090, V100, ...

# 22GB GPU memory

CUDA_VISIBLE_DEVICES=0 \

swift sft \

--model_type qwen1half-4b-chat \

--dataset alpaca-zh#500 alpaca-en#500 self-cognition#500 \

--logging_steps 5 \

--max_length 2048 \

--learning_rate 5e-5 \

--warmup_ratio 0.4 \

--output_dir output \

--lora_target_modules ALL \

--model_name 小黄 'Xiao Huang' \

--model_author 魔搭 ModelScope \

使用CLI (DeepSpeed-ZeRO2):

如果你使用的是3090等卡, 可以降低

max_length来减少显存消耗.

# Experimental environment: 4 * 3090

# 4 * 24GB GPU memory

CUDA_VISIBLE_DEVICES=0,1,2,3 \

NPROC_PER_NODE=4 \

swift sft \

--model_type qwen1half-4b-chat \

--dataset alpaca-zh#500 alpaca-en#500 self-cognition#500 \

--logging_steps 5 \

--max_length 2048 \

--learning_rate 5e-5 \

--warmup_ratio 0.4 \

--output_dir output \

--lora_target_modules ALL \

--model_name 小黄 'Xiao Huang' \

--model_author 魔搭 ModelScope \

--deepspeed default-zero2

4.微调后推理

你需要设置best_model_checkpoint的值, 该值会在sft的最后被打印出来.

使用python:

import os

os.environ['CUDA_VISIBLE_DEVICES'] = '0'

from swift.llm import InferArguments, merge_lora, infer_main

best_model_checkpoint = 'qwen1half-4b-chat/vx-xxx/checkpoint-xxx'

infer_args = InferArguments(ckpt_dir=best_model_checkpoint)

merge_lora(infer_args, device_map='cpu')

result = infer_main(infer_args)

"""Out[0]

<<< 你是谁?

我是魔搭的人工智能助手,我的名字叫小黄。我可以回答你的问题、提供信息、进行对话等等。如果你有任何问题或需要帮助,请随时告诉我。

--------------------------------------------------

<<< what's your name?

I am Xiao Huang, an artificial intelligence assistant developed by ModelScope.

--------------------------------------------------

<<< 你是谁研发的?

我是由魔搭研发的。

--------------------------------------------------

<<< 浙江的省会在哪?

浙江省的省会是杭州。

--------------------------------------------------

<<< 这有什么好吃的?

浙江的美食非常丰富,比如杭州的西湖醋鱼、东坡肉、龙井虾仁等等都是非常有名的菜肴。此外,浙江还有许多小吃,比如油条、烧饼、汤圆等等。

--------------------------------------------------

<<< 晚上睡不着觉怎么办

晚上睡不着觉可以尝试以下几种方法:

1. 放松身心:可以尝试做一些放松身心的活动,比如听音乐、冥想、深呼吸等等。

2. 保持规律的作息:尽量保持规律的作息,避免熬夜。

3. 避免刺激性物质:避免摄入咖啡因、酒精等刺激性物质,这些物质可能会干扰你的睡眠。

4. 适当运动:适当的运动可以帮助你放松身心,提高睡眠质量。

5. 睡前放松:可以尝试一些睡前放松的活动,比如阅读、听轻音乐、泡热水澡等等。

希望以上建议能够帮助你改善睡眠质量。

"""

使用CLI:

# 直接推理

CUDA_VISIBLE_DEVICES=0 swift infer --ckpt_dir 'qwen1half-4b-chat/vx-xxx/checkpoint-xxx'

# Merge LoRA增量权重并推理

# 如果你需要量化, 可以指定`--quant_bits 4`.

CUDA_VISIBLE_DEVICES=0 swift export \

--ckpt_dir 'qwen1half-4b-chat/vx-xxx/checkpoint-xxx' --merge_lora true

CUDA_VISIBLE_DEVICES=0 swift infer --ckpt_dir 'qwen1half-4b-chat/vx-xxx/checkpoint-xxx-merged'

5.Web-UI

使用python:

import os

os.environ['CUDA_VISIBLE_DEVICES'] = '0'

from swift.llm import AppUIArguments, merge_lora, app_ui_main

best_model_checkpoint = 'qwen1half-4b-chat/vx-xxx/checkpoint-xxx'

app_ui_args = AppUIArguments(ckpt_dir=best_model_checkpoint)

merge_lora(app_ui_args, device_map='cpu')

result = app_ui_main(app_ui_args)

使用CLI:

# 直接使用app-ui

CUDA_VISIBLE_DEVICES=0 swift app-ui --ckpt_dir 'qwen1half-4b-chat/vx-xxx/checkpoint-xxx'

# Merge LoRA增量权重并使用app-ui

# 如果你需要量化, 可以指定`--quant_bits 4`.

CUDA_VISIBLE_DEVICES=0 swift export \

--ckpt_dir 'qwen1half-4b-chat/vx-xxx/checkpoint-xxx' --merge_lora true

CUDA_VISIBLE_DEVICES=0 swift app-ui --ckpt_dir 'qwen1half-4b-chat/vx-xxx/checkpoint-xxx-merged'

我在一线互联网企业工作十余年里,指导过不少同行后辈。帮助很多人得到了学习和成长。

我意识到有很多经验和知识值得分享给大家,也可以通过我们的能力和经验解答大家在人工智能学习中的很多困惑,所以在工作繁忙的情况下还是坚持各种整理和分享。但苦于知识传播途径有限,很多互联网行业朋友无法获得正确的资料得到学习提升,故此将并将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

👉AGI大模型学习路线汇总👈

大模型学习路线图,整体分为7个大的阶段:(全套教程文末领取哈)

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

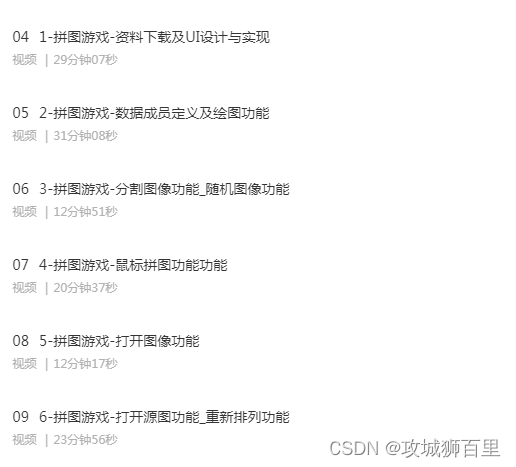

👉AGI大模型实战案例👈

光学理论是没用的,要学会跟着一起做,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

👉AGI大模型视频和PDF合集👈

观看零基础学习书籍和视频,看书籍和视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓